-

如何让 unittest 的报告中错误输出有日志输出?(关于 stdout 重定向) at 2020年11月25日

1、你这个东西可以看看 logger 的 handler ,这个机制就是用于日志多处打印且可能每一处都有不同要求的。但是估计要你自己写个自定义的 handler 实现,对接到你这个自定义的报告模块

2、错误信息加错误截图,可以把图片信息以 base64 形式 +html image 标签 存到你输出到 html 报告的日志里,这样 html 报告就能展示图片,且不用额外搞别的图床。缺点是 html 文件会因此变大,因为内嵌了图片,建议做下图片压缩。比较好奇你这个是啥报告框架,竟然要用到

io.StringIO来写入 -

fiddler 抓手机包出现这种情况为什么查看不了请求数据 at 2020年11月24日

手机上手动安装并信任 fildder 的 ssl 证书了么?

-

MTSC 参会感受 at 2020年11月23日

hmm,代码质量这个真的不好说,这个是内功了。

其实很多优秀的工具框架原版的代码质量都不算很好(时间一有压力自然会选择快而不一定好的方案),只是基本开源前都会去修补一番避免太丢人。以前还听说过某大厂开源框架在开源前一周全体补注释、单测和做重构的。

-

MTSC 参会感受 at 2020年11月22日

这些都是在开发层面的,那么测试开发中的测试怎么体现出来,仅仅是开发的工具应用于测试么?

没太理解这句话,能否分享下您比较期望通过大会了解到什么内容,而这次大会没有提供到?我们也很希望了解到大家这方面的反馈,看后续如何改进。

-

小白不懂就问:做接口测试产生的数据怎么清除 at 2020年11月22日

不知道你想要多自动化?如果是自动化,teardown 的时候自动删就行了。如果是人工测试用,那总归得人去触发的,系统不知道你啥时候用完数据。

不过测试环境其实没必要删,每次都用新数据那老数据删不删都无所谓的,想办法让数据尽量不容易撞车就行。

-

小白不懂就问:做接口测试产生的数据怎么清除 at 2020年11月21日

1、每次都跑完整流程,换订单号

2、跑完后调用删数据接口,或者直接操作数据库/缓存删数据 -

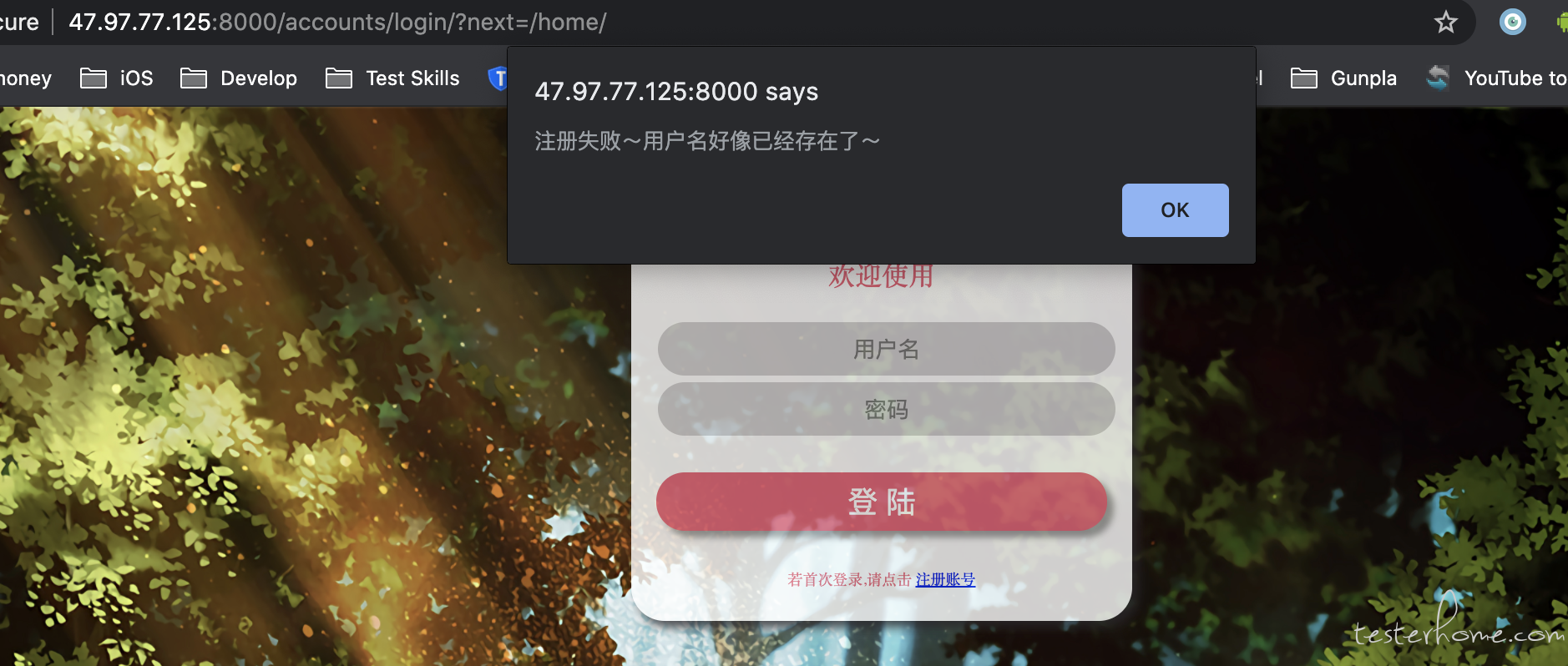

阿里云部署好了大家一起搞的练手接口测平台 at 2020年11月21日

注册功能用不了:

-

python 中封装日志 logging,为何打印行号固定在同一行? at 2020年11月21日

客气啦,有收获就好。

-

python 中封装日志 logging,为何打印行号固定在同一行? at 2020年11月20日

是的。。。还是老老实实 logger.info() 这么写吧。

-

python 中封装日志 logging,为何打印行号固定在同一行? at 2020年11月20日

要把 self.logger 省掉也是可以的:

class BaseCase(unittest.TestCase): @classmethod def setUpClass(cls) -> None: # 获取当前时间 now = timer.current_time("%Y_%m_%d") filename = dir_config.logs_dir + r"\{}.log".format(now) # 格式 # %(asctime)s 打印日志时间 %(filename)s: 打印当前执行程序名 # %(lineno)d: 打印日志的当前行号 %(levelname)s: 打印日志级别名称 %(message)s: 打印日志信息 fmt = "%(asctime)s %(filename)s %(funcName)s [line:%(lineno)d ] %(levelname)s %(message)s" date_fmt = "%a %d %b %Y %H:%M:%S" # 打印到控制台 stream_handler = logging.StreamHandler() stream_handler.setLevel(logging.ERROR) # 回滚文件输出 rotating_handler = RotatingFileHandler(filename, maxBytes=1024 * 1024 * 5, backupCount=10) # 设置logging的输入内容形式及输出渠道 logging.basicConfig(format=fmt, datefmt=date_fmt, level=logging.INFO, handlers=[stream_handler, rotating_handler]) cls.logger = logging.getLogger(cls.__name__) def log(str): self.logger.info()子类里面直接调用

log("我是日志")就可以打印日志了,基本简化到和你Logger("日志")差不多了,但看你有没有必要咯,别人看起来可能会比较奇怪。PS: 上面不建议搞静态(类)方法,静态和动态混在一起会比较乱,全动态方法(不带有 @classmethod 注解的方法)就好了,这样每个子类都是独立的,不会相互影响,也比较清晰。

-

阿里云部署好了大家一起搞的练手接口测平台 at 2020年11月20日

没找到账号密码?

-

想问一下如何测百度的查询速度 at 2020年11月20日

从技术角度,在百度上输入关键字 - 点击搜索,到界面见到搜索结果,大概有几个步骤:

1、前端把输入框的值封装到接口数据里,发起接口请求。

2、接口请求经过漫长的链路(各种网关、路由),到达百度的机房并到达搜索服务

3、搜索服务内部进行搜索处理(里面还有各种内部流程)

4、搜索服务返回结果

5、经过漫长的链路,浏览器收到搜索处理结果(纯数据格式)

6、前端把数据变为界面元素,展示到浏览器在公网,2、5 的耗时是不稳定的,而整体来说最大的耗时一般在 4、6 两步。那你这里的测试百度查询服务,是从 1-6 么?如果是,最好的是高速录像机录像 + 多次测试,从用户角度来看,更准确。

如果只需要 1-5,那直接 Jmeter 模拟请求即可。爬虫的方法不大建议,因为爬虫是在 6 的基础上再增加了一个步骤的,耗时会比 1-6 要高一些,稍微不那么准确

-

python 中封装日志 logging,为何打印行号固定在同一行? at 2020年11月20日

这就是继承了 logging.Logger 模块,是可以做到你说的 filter 、handler 赋初值。但这个我理解不改变 logger 的调用方式吧?

-

python 中封装日志 logging,为何打印行号固定在同一行? at 2020年11月20日

?没看明白。

-

接口测试的一些感悟 at 2020年11月20日

建议先解决你说的文档问题再做接口的测试,接口测试比较顺了再做自动化。规范接口文档需要的不是说 “我做自动化需要用到”,这样是推不动的,因为这是你的问题,不是开发或者领导的问题,自动化收益再高都没用。要改为说前后端没有接口文档出现过多少联调方面的问题导致返工,和进度相互卡住(前端等服务端)资源无法释放问题,这个才是开发或者你领导都要解决的问题——提高开发效率问题。然后要做文档方法不是加重开发负担额外多写,而是用 swagger 等工具做到基于代码自动生成,这样开发才喜欢和愿意配合。

接口文档混乱,你会因为没有文档导致自动化成本很高(只能通过抓包知道接口具体内容,问人知道各个字段含义和要求,也只能通过看代码知道大部分异常代码),导致你时间都花在确认文档上,而非真的发现接口问题上。准备工作成本比后面执行收益高,容易变成大家累但感觉没啥收益。

-

python 中封装日志 logging,为何打印行号固定在同一行? at 2020年11月20日

基类不是工具类,他是要被继承的。

通过继承,子类拥有父类已拥有的东西,子类不用重复编写或者引入这些东西。推荐你找个相对流行的 UI 测试框架,看看它自带的 demo 之类示例看看,你需要先扩展视野,要不你的感觉是不大准的。

曾经见过为了写法上节省个 new,然后全部类都搞成静态类,然后由于对象共用,导致用例间相互影响无法并行的,这就有点捡了芝麻掉了西瓜了。 -

python 中封装日志 logging,为何打印行号固定在同一行? at 2020年11月19日

我想要自己的这个类 Logger 替代 logger.info,直接 Logger(……) 就可以了,请问可以实现吗

你现在的就是这个方式的实现了,因为你这里是一个类的初始化方法,所以 logger 对象肯定是在你的初始化方法里初始化的,没法获取到你这个

Logger("xxx")被调用的位置用 @cheunghr 的方法就可以了。你想要不 new 直接调用方法,其实就是调用静态方法(python 里对应就是有

@classmethod注解的类方法),用这个思路就可以了,只是这种用法其实有点怪。日常接触,大部分用法是使用模板模式,搞个用例基类,里面已经初始化好 logger 对象,然后用例里面直接用

logger.info()就直接记录日志。这样也不浪费getLogger(__name__)可以让日志打印出所在类的特性。而且这种情况下,除了 logger 对象,还可以有很多通用的对象可以在基类里面初始化(比如 UI 自动化里初始化 driver ,或者接口测试里面初始化一些和数据库的连接),节省用例里面额外 new 的语句。看了不少代码后,个人感受大部分时候规范的写法比自己想出来的极简的写法综合起来更好,因为这些规范都是前人经过无数踩坑后总结的最佳实践,能满足最常用的场景且也有足够的灵活性,关键是这些使用姿势以后换公司换框架都能继续沿用,而不会被框架特有写法绑定死。至于这些规范写法或者优雅写法怎么写,建议可以看看 Python cookbook

-

思考 TPS 与 RT 之间的关系 at 2020年11月19日

也要看资源消耗情况。个人理解,一般并发高的时候,无法立即处理的请求会放在队列之类的地方等待,这个等待队列本身也有一些资源消耗的,从等待队列挪到处理进程也会比并发低时不用这个动作多一些处理成本。

tps 一般是在可用资源恒定的情况下会保持一个相对稳定的值,但如果资源已经减少(分配了一部分去做等待队列或者别的事情,不参与请求处理),那 tps 也会下降。

-

python 中封装日志 logging,为何打印行号固定在同一行? at 2020年11月19日

打印的行号是调用 logger 对象的所在行。你现在封装后 logger 对象永远只有你这个类在调用,别的类都没调用,所以行号都在你自己这个类里了。

PS:看你的用法,应该是想打印的日志里带有用例名称?这个原生 loggging 框架完全可以做到的,用

logging.getLogger(__name__)就可以了。 -

接口测试并不只是测试参数和返回值 at 2020年11月19日

其实一般返回值只需要内容正确就行,类型这个基本上服务端的解析框架都会先做一层类型强转,如果转不了就会直接异常,很容易发现。

比如 1 和 "1" ,对服务端来说没啥差别,只要服务端对应对象是 Integer ,都会转成数字 1 进入后面的处理逻辑。 -

自动化接口测试,怎样判断 Bug 是否存在 at 2020年11月19日

加时间是为了方便区分,要不看到一样的 summary 有 3 个已解决 1 个待解决会有点怪。不过如果可接受也可以不加时间。

message 太长的可以做个简单的截取算法哈,只截取最多多少个字符,并且从后往前截取(针对层层叠加的最外层很可能都是长一个样)。不过一般 message 都不会太长,除非是少数层层叠加的。

保存在 excel 文档后,也想通过代码去删选是否 bug 已存在

没明白代码删选具体是想怎么做,是无人工介入代码直接判断么?个人觉得你的方向可以朝着怎么降低自动化发现 bug 上报到缺陷管理里面的成本(比如搞个简单的 web 界面,人工做一次简单复核,人工复核确认是要上报的一键上报),但代码直接判断会比较复杂(要综合当时的其他数据判定,有一套严谨的规则,甚至考虑引入机器学习自迭代),有这个资源还不如投入到怎么自动生成自动化用例里面。

-

接口测试并不只是测试参数和返回值 at 2020年11月18日

后端接口测试侧重点是检查数据的交换、传递和控制管理过程

这个点赞同,或者说这个应该是后端测试而不仅仅是后端接口测试,只是后端测试大多通过调接口触发。不过好像正文讲着讲着就不是讲这个点了。数据的交换、传递和控制,个人理解应该是要看输出的。接口的输入不止 request,还有中间件数据、请求其他服务得到的数据;输出也不止 response ,还有日志、中间件调用、其他服务调用。

另外,要把这些都关注到位,其实工作量还是挺大的,实践中建议是结合 code review 的方式进行,这样才比较高效。比如

4.cookie:就是将header中的cookie修改或删除后看是否能返回相应的error code,这些逻辑非常通用,所以一般都是框架层负责的,业务层不负责。所以只要框架层之前这方面有确认过,就不用再测试了,出问题概率极低。 -

为啥论坛每天有这么多软广告呢~ at 2020年11月18日

如果觉得是软广,欢迎举报。

也欢迎大家献谋划策,给些怎么控制软广的意见建议

-

自动化接口测试,怎样判断 Bug 是否存在 at 2020年11月18日

你是中毒了?末尾这一串链接是啥。

-

[北京] 图森未来科技公司招募测试工程师 at 2020年11月18日

哥,你是中毒了?