-

基于百度脑图的用例增量保存 + diff 展示整体设计 at 2024年05月12日

只是提了 MR。官方对于这个 diff 处理最终采用的是基于实时数据更新的解决方案(类似飞书文档那种),所以最终没有合并进去。

-

请教下 UI 自动化测试提示 “TypeError: input_text() missing 1 required positional argument: 'text'” 是什么原因? at 2024年05月11日

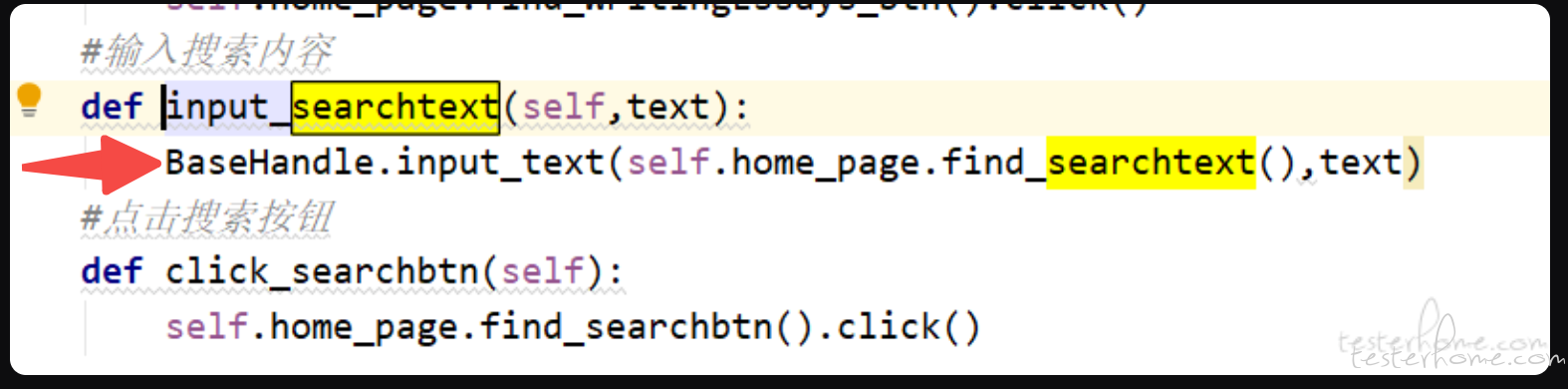

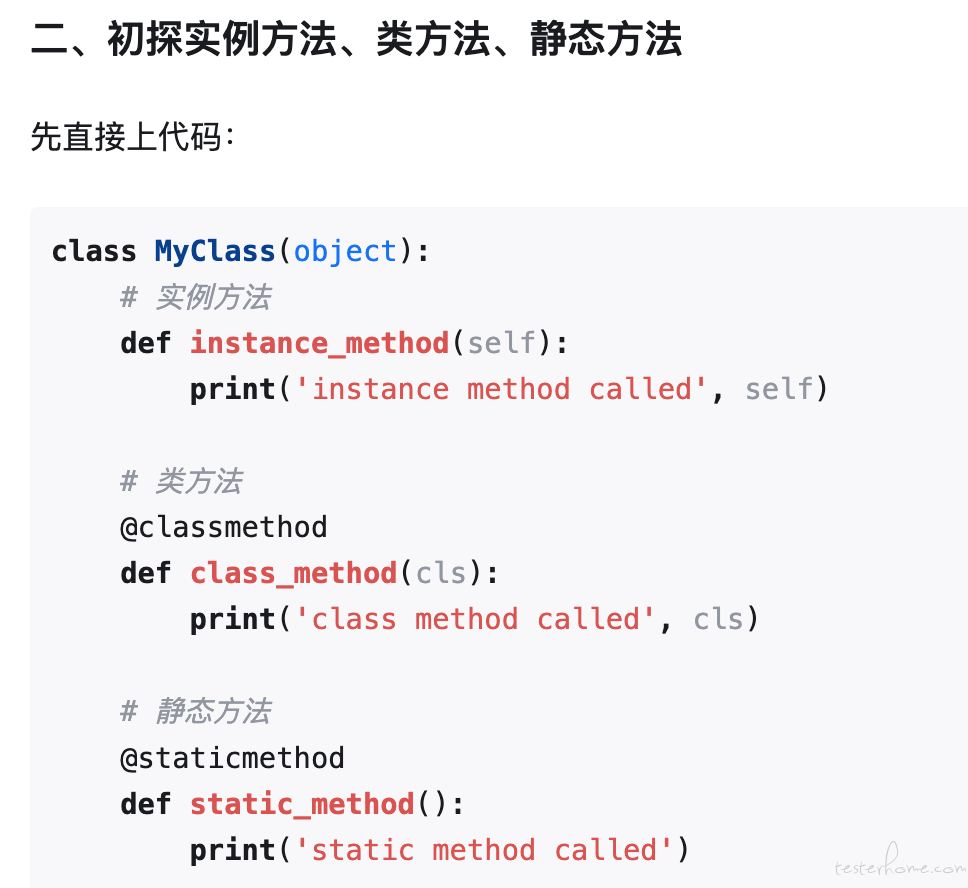

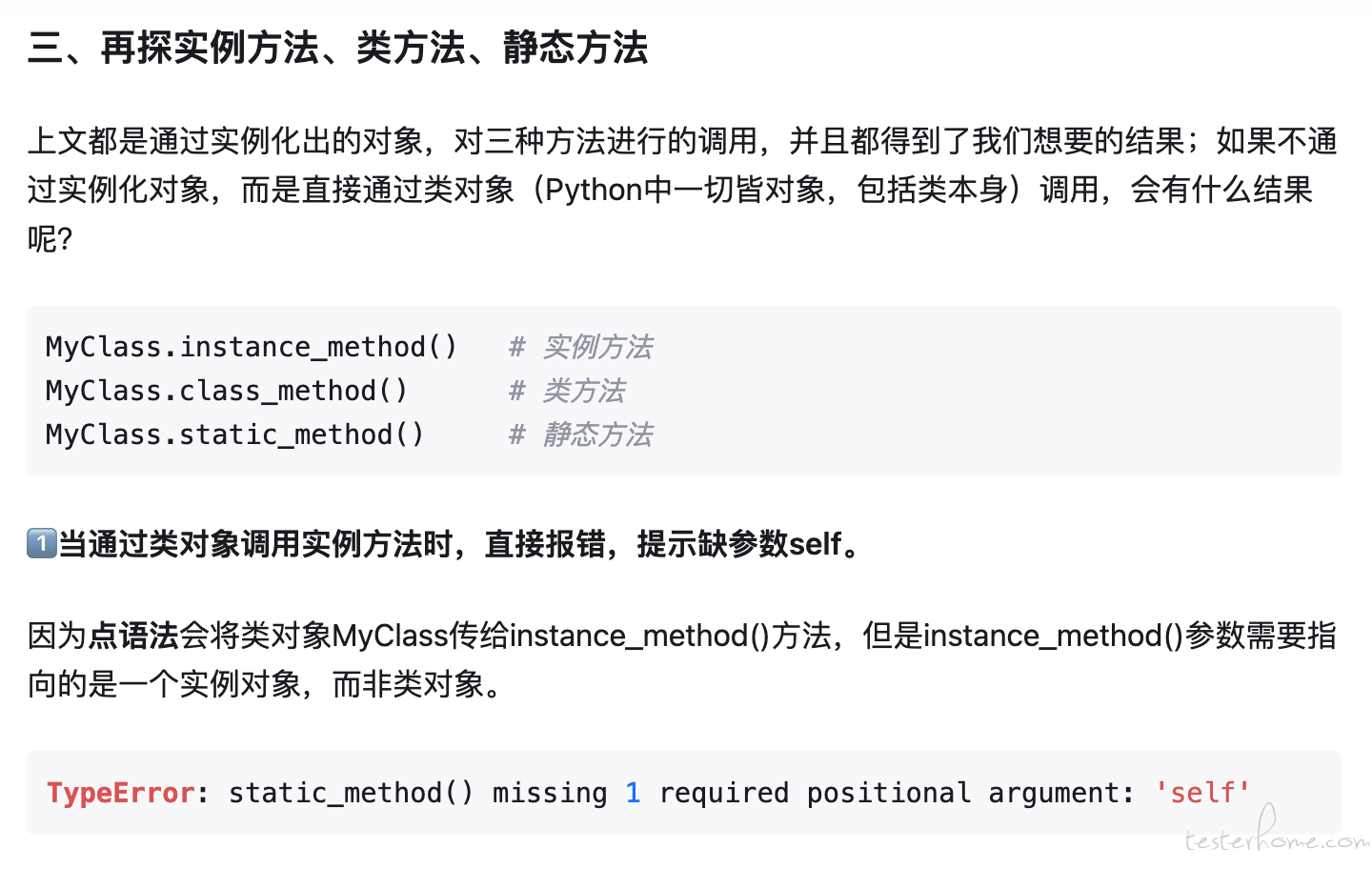

这里的 input_text 是实例方法,必须是在实例化后的对象才能调用。例如:

handler = BaseHandler() handler.input_text(element, text)只有类方法或静态方法,才能用

BaseHandler.input_text()这种写法。详细建议看看 https://zhuanlan.zhihu.com/p/40162669

-

我看你截图,两个截图里展示的内容都不大一样,第二个多了个弹窗。

从我历史经验,有 2 种可能:

1、sleep 时间不够长。session.page_source 语句的执行是比较耗时的(一般几秒左右,复杂页面时间更长),相当于再 sleep 了几秒。你看下加长 sleep,去掉 print,是否可以解决?

2、webview 内部元素要通过调用 page_source 强制遍历一遍,才会出现在控件树中(猜测)。可以试试不加 page_source 和加 page_source ,看加的话是不是稳定成功,不加的话是不是稳定失败。 -

26 岁如何选择测试工作和未来发展 at 2024年04月11日

现在这情况,不建议继续跳,要不简历更差,后面更难。

先干着吧,过程中熟悉一下公司情况,看后面是否有发展起来的机会,没有的话再骑驴找马地找。

-

2024 年测试求职手册 at 2024年04月07日

主要看能力,我这边业务有不少 35+ 的同事,目前招聘也没有强卡年限。

-

2024 年测试求职手册 at 2024年04月03日

去年换到字节了

-

2024 年测试求职手册 at 2024年04月01日

字节广州有兴趣么?我这也还在招。

-

测试工作经验十年,摆烂的十年 at 2024年03月07日

今年我也满 10 年了,握个爪

-

项目的层级太多了呀,testcase 怎么分层呢 at 2024年03月05日

不知道咋分的话,先别分是最佳选择。要不很容易过度设计,还不如不设计

-

盘点一写 OpenAI 工具和资源,特别是 GPT 系列 - 面向开发者 at 2024年02月26日

可以把质量保障领域相关的,也汇总一份么?

-

我有一个朋友 at 2024年02月26日

这个话很戳心,但很真实。

-

兄弟萌,这个名称怎么修改啊? at 2023年12月19日

我看了下后台账号信息,你的权限应该是 ok 的。

可以把你发帖时的一些错误提示贴上来吗?我们针对性排查下。

-

记录一次 Litmus pod-io-stress 使用中发现的问题 at 2023年11月25日

学习了。

-

appium 响应速度特别慢(大佬们都来指教一下) at 2023年11月14日

建议可以的话,缓存下 element。每次都去 find 的话,会导致每次都要遍历控件树,无法使用缓存。

app 端控件树遍历不像 web 端,得递归整个控件树才能生成。如果界面复杂,这个递归会比较耗时。

-

请问大家,在当前就业环境下,大家觉得测试要往哪方面发展才能走的更长呢 at 2023年11月14日

最基本的就是人工测试,设计用例 + 点点点

设计用例提效部分可以 ai 辅助,人工复查

点点点今年 gpt 发布会演示这个功能,未来可以关注试试 -

哪种情况会引发 App 崩溃 at 2023年11月14日

这篇总结得挺全的,可以参考下:

https://testerhome.com/topics/37479 -

请问大家,在当前就业环境下,大家觉得测试要往哪方面发展才能走的更长呢 at 2023年11月09日

赞同 1 楼的,我觉得 AI 自行研发 + 测试人工验证的合作模型会是更可行,或者说离我们更近的。

其实我们为啥一直要想着被取代呢,学习下把大模型技术用起来,成为自己的助手,让自己人效更高也帮助自己更熟悉大模型技术,不是更好吗?

-

开源一个 vue 版的脑图编辑器,数据上已兼容 agiletc 的测试结果格式 at 2023年11月07日

可以监听 minder 的事件来获取。

示例:

minder.on && minder.on('interactchange', function() { self.selectedNodeCount = minder.getSelectedNodes().length if (self.selectedNodeCount === 1) { self.selectedNodeText = minder.getSelectedNodes()[0].data.text } else { self.selectedNodeText = '' } });至于具体有哪些事件,可以源码里搜索下,我也有点不大记得了。

-

关于接口测试用例设计的一些讨论 at 2023年11月06日

这个我觉得你参考 8 楼的说明吧。

用例是否需要考虑,核心是看你们的项目对越权这块的容忍度。如果这个越权漏洞你能证明可以造成很大的问题(比如删掉某些实际这个用户没有权限删除的内容),我觉得可以把案例摆出来,大家一起决策是否需要修复,然后再进一步扩展到同类型问题,是否要处理。

-

关于接口测试用例设计的一些讨论 at 2023年11月03日

大部分情况下,服务端也是要做限制的,要不纯前端限制,绕过成本很低,会导致一些越权的安全风险。

不过这个还是看实际业务情况。如果是内部业务,外部不可能入侵,不做的风险倒还好。

-

多端测试,如何提高效率 at 2023年11月03日

建议和研发确认下,这个多端背后的技术方案是啥,看确实是每个端代码都完全独立,还是用类似 Electron 的技术,一套逻辑代码,打包成多平台应用。

如果是完全独立,只能老老实实去测试,因为代码之间相互独立。

如果是有相互复用的,可以看哪些部分复用,复用部分只需要过一下 P0 功能确认没问题就行,不用过太细。重点关注兼容性方面有没有问题(如唤起相机这类调用平台 api 实现的,以及不同屏幕大小下的适配) -

求教各位,安全测试里面,https 请求如何验证篡改请求 at 2023年10月24日

按我个人理解,https 请求的安全性,核心在证书。内容如果发生了篡改,在没有官方私钥的情况下,是必须改证书才重新加密请求内容。

如果客户端没有进行 https 证书强校验,仅按照系统默认配置来进行证书有效性验证,有可能会出现中间人让系统信任自己的自定义证书后,进行请求篡改的。

-

好像发帖的人没以前多了?都被裁了转行还是没被裁的工作量剧增? at 2023年10月11日

以前发帖多的人工作越来越忙,没那么多时间发帖了吧。

-

回顾学英语一周年 at 2023年10月11日

学习榜样呀。

我流利说也买了课程,从一周 5 次减少到一周 3 次,再最后没有合适的时间停止了。能坚持一件事 1 年,真的很强!

-

appium 问题求解答 at 2023年10月10日

手动执行这条命令,看有没有反应?

D:\gw\tool\android-sdk\platform-tools\adb.exe -P 5037 -s 8LSCZ9NJA6EQCI7T shell getprop ro.build.version.release这条命令是通过 adb 服务,获取手机系统版本用的,按道理应该不大会出问题,出问题大概率是手机问题,可以试试换台手机。