AI测试 不会写代码的测试,用 100% 的 AI 编程,写了个自动化测试平台(自动编写测试用例 + 自然语言执行 UI 自动化)

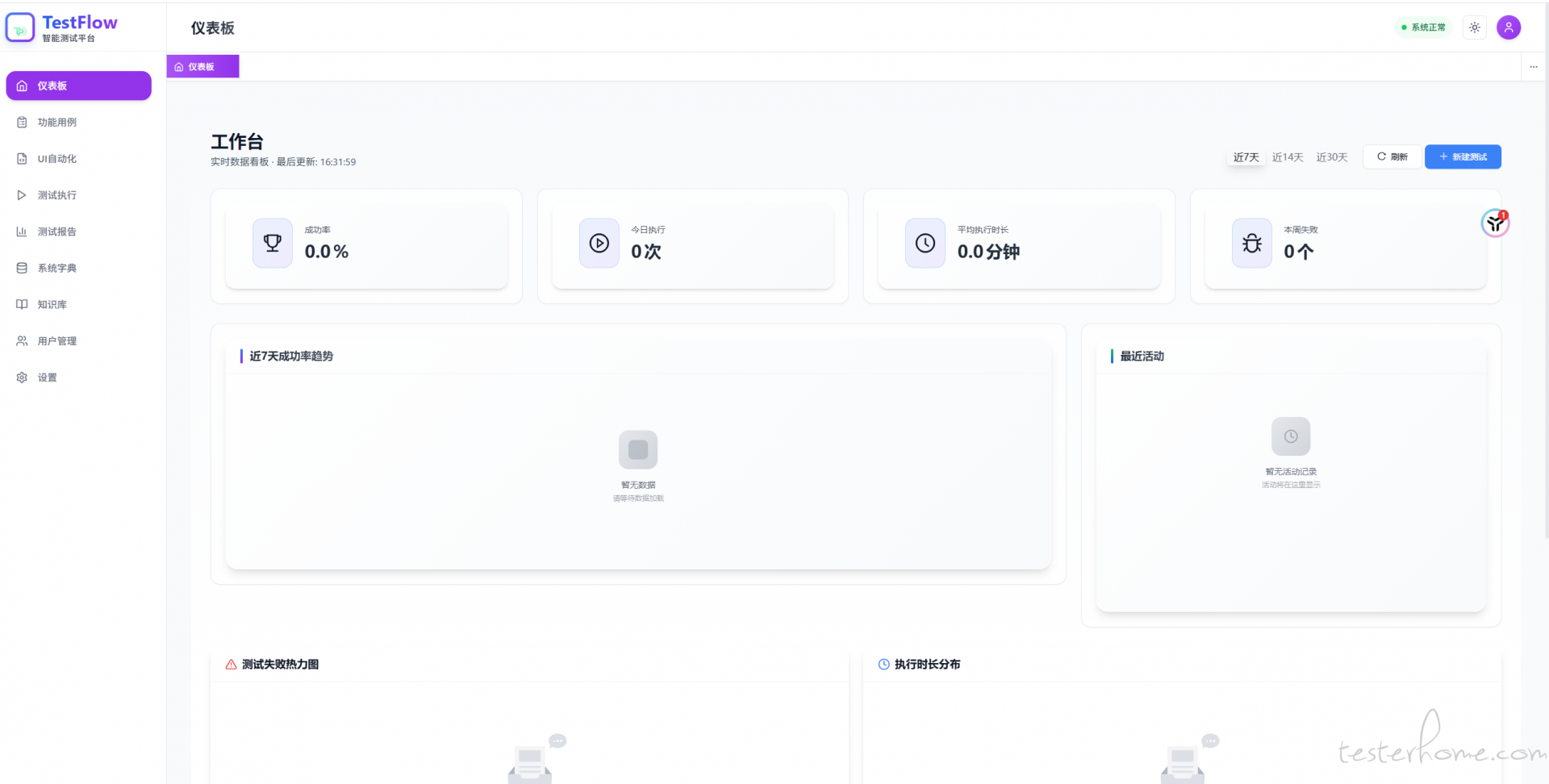

大家好,最近在做一个开源的 AI 测试平台,核心功能是AI 生成测试用例和UI 自动化执行。

目前已经在实际项目中使用,效果还不错,分享给大家,欢迎试用和反馈。

只是结合自己日常工作中需要用 excel 表格写用例以及 UI 自动化代码维护的困扰,写了一个比较能落地的自动化测试工具

欢迎试用

项目已开源,欢迎大家试用、反馈和 Star!

核心功能

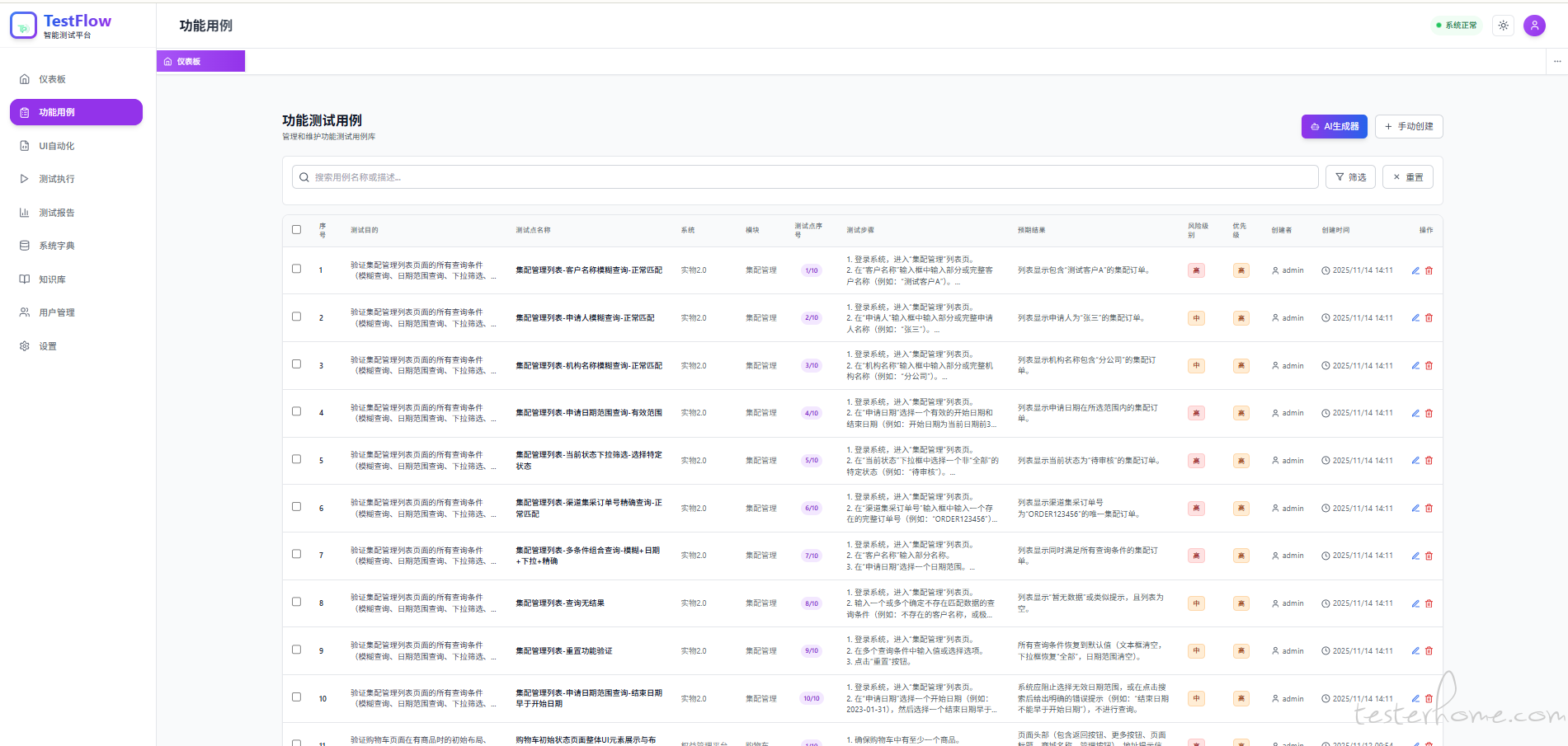

1. AI 测试用例生成

从原型工具导出的 HTML 格式文件通过系统自动生成测试用例,10 分钟完成 100 个用例。

与市面上工具的差异:

目前市面上的 Dify、Coze 等工具,都是通过固定 Prompt 直接生成用例,存在以下问题:

- 生成的用例格式不统一,无法直接用于自动化执行

- 缺少结构化的拆解过程,生成质量不稳定

- 没有人工审核环节,容易遗漏关键场景

- 生成的用例无法直接落地执行

我的解决方案:

采用分阶段、结构化的生成流程,每个阶段都有明确的产物和人工审核点:

采用**分阶段、结构化**的生成流程,每个阶段都有明确的产物和人工审核点:

上传 Axure 原型

↓

AI 生成文字需求文档(可人工审核)

↓

AI 预留测试模块(自动拆分)

↓

AI 生成每个模块的测试目的

↓

AI 根据每个测试目的生成具体测试用例(结合 RAG 向量数据库增强)

关键点:

- 每一步都由AI 自动生成,不需要手写

- 只在需求文档阶段需要人工审核(5-10 分钟)

- 最后阶段可启用RAG 向量数据库,自动检索四个维度的测试知识:

- 业务规则:每个模块一些的特殊业务规则

- 测试模式:成熟的测试设计模式

- 易错点:历史缺陷和容易遗漏的场景(如特殊字符处理)

- 风险场景:安全和性能相关的高风险测试

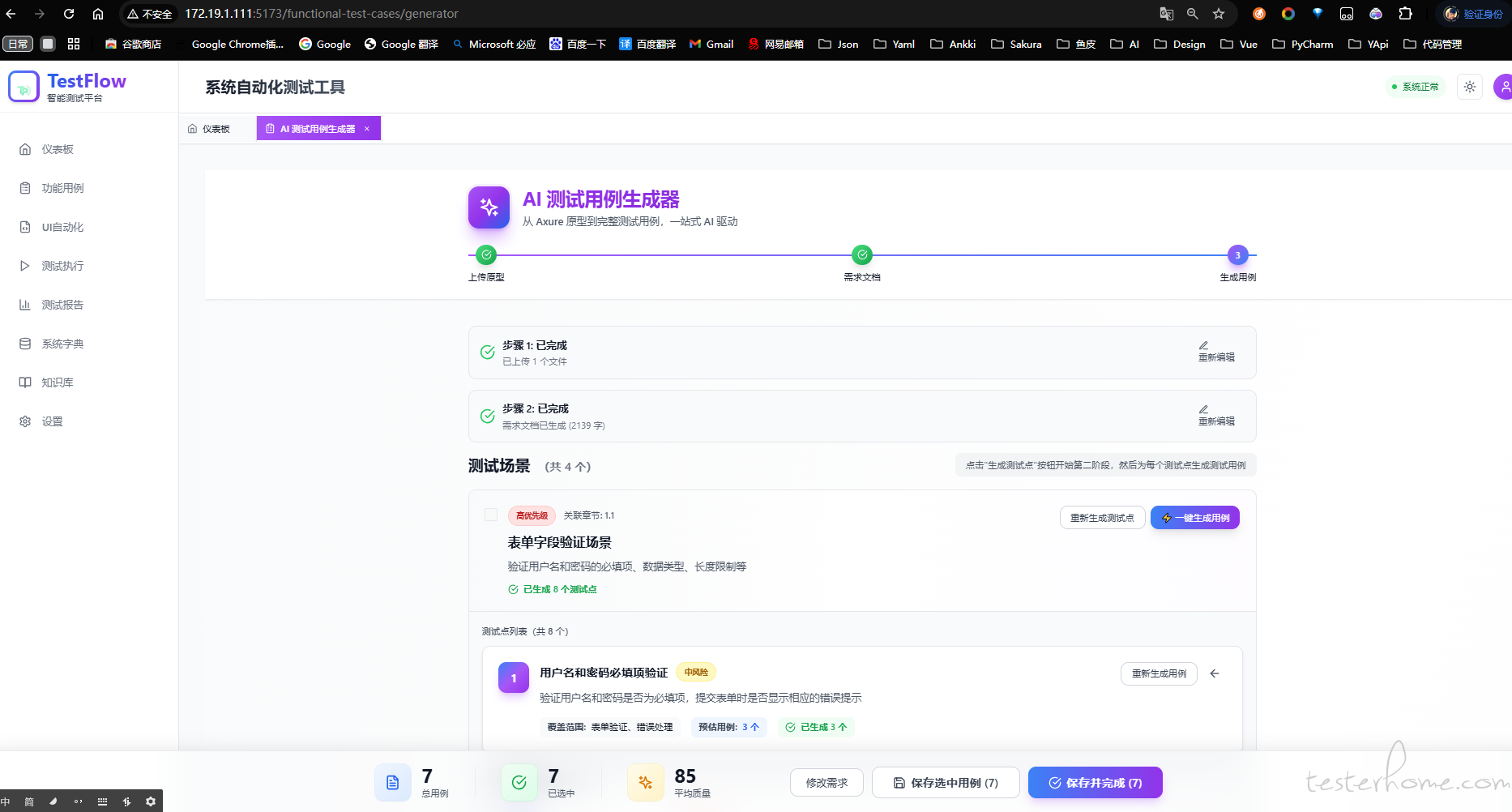

下面是实操:

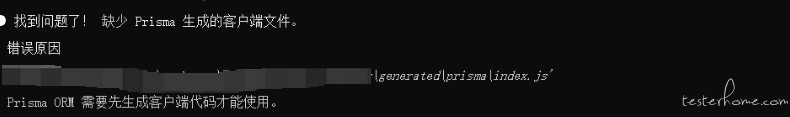

先上传原型工具导出的 HTML 文件

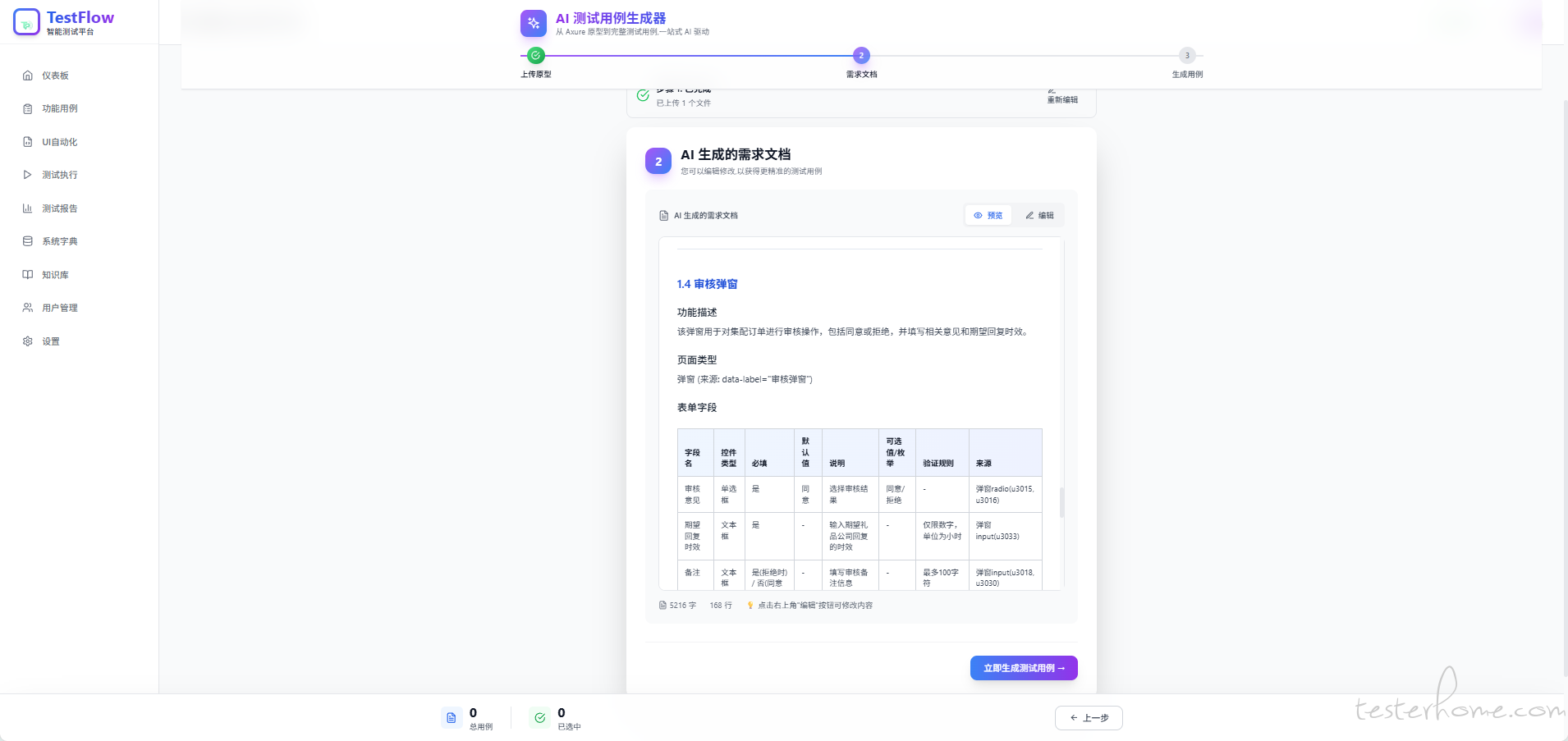

然后根据 AI 解析的文字版需求进行审核与修改,确认完毕点击下一步

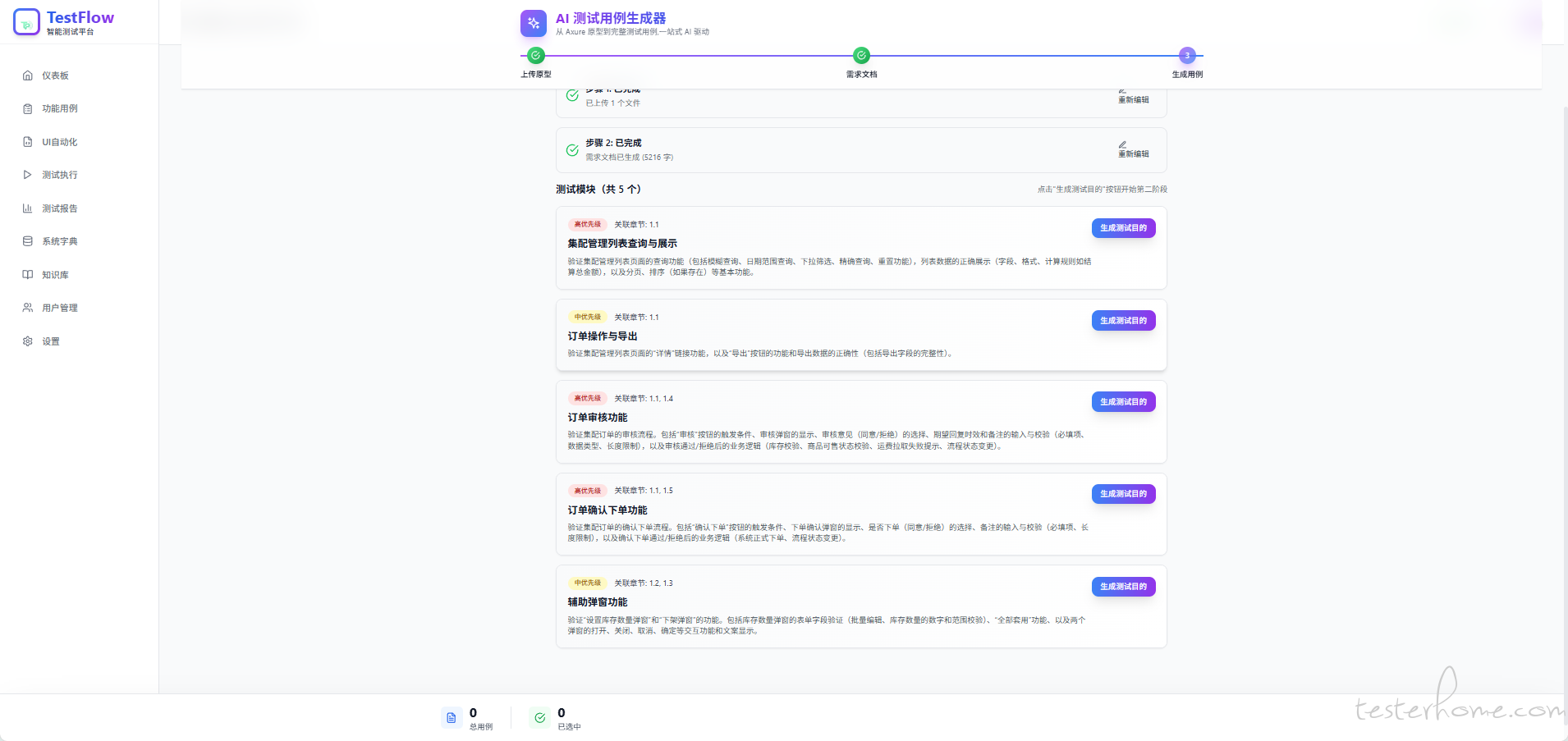

AI 会根据文字版需求文档 生成当前页面不同的测试模块,选择其中一个点击下一步

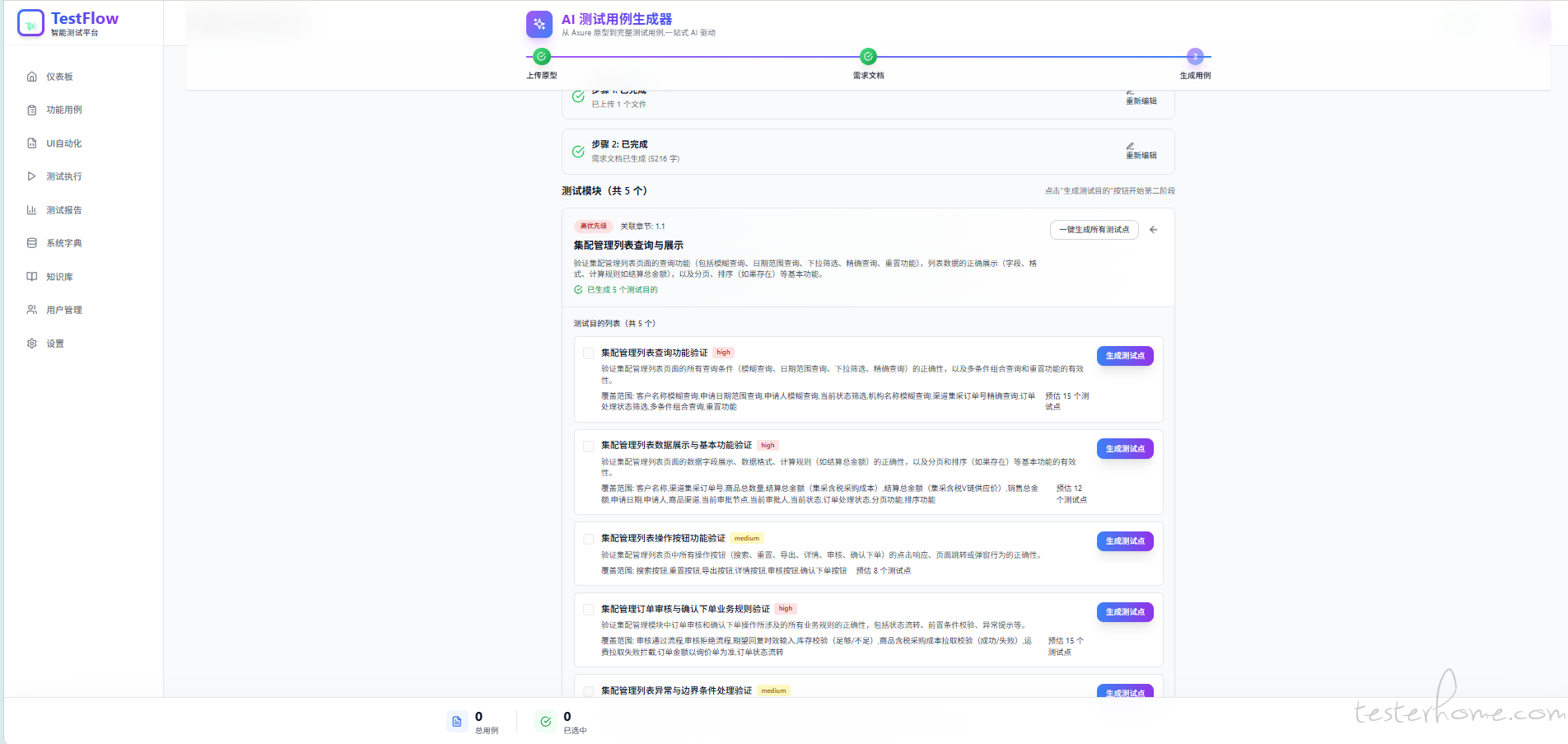

根据选择的测试模块生成不同的测试目的

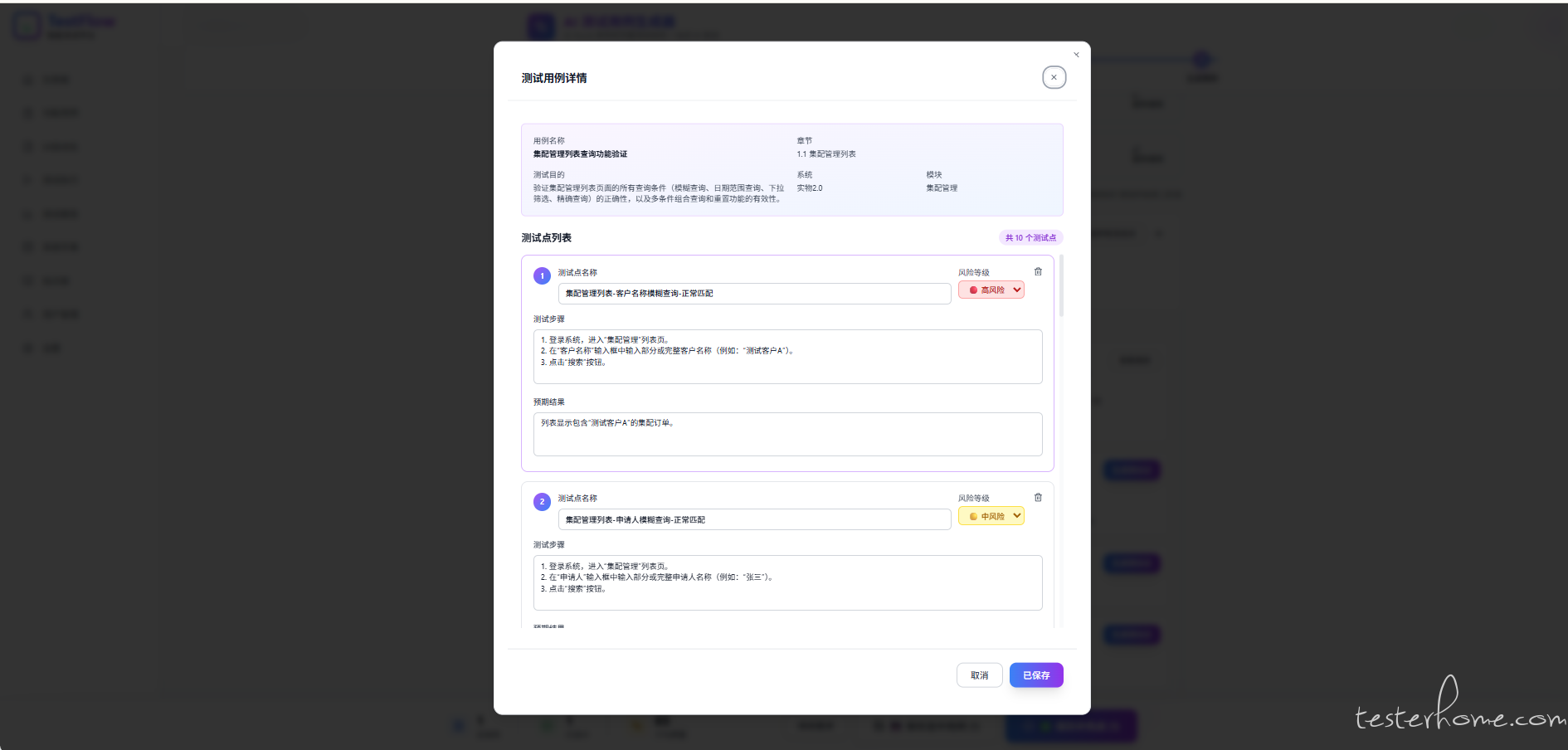

最后根据生成的测试目的,选择批量或者单个生成测试用例(生成测试用例会结合向量数据库数据作为参考)

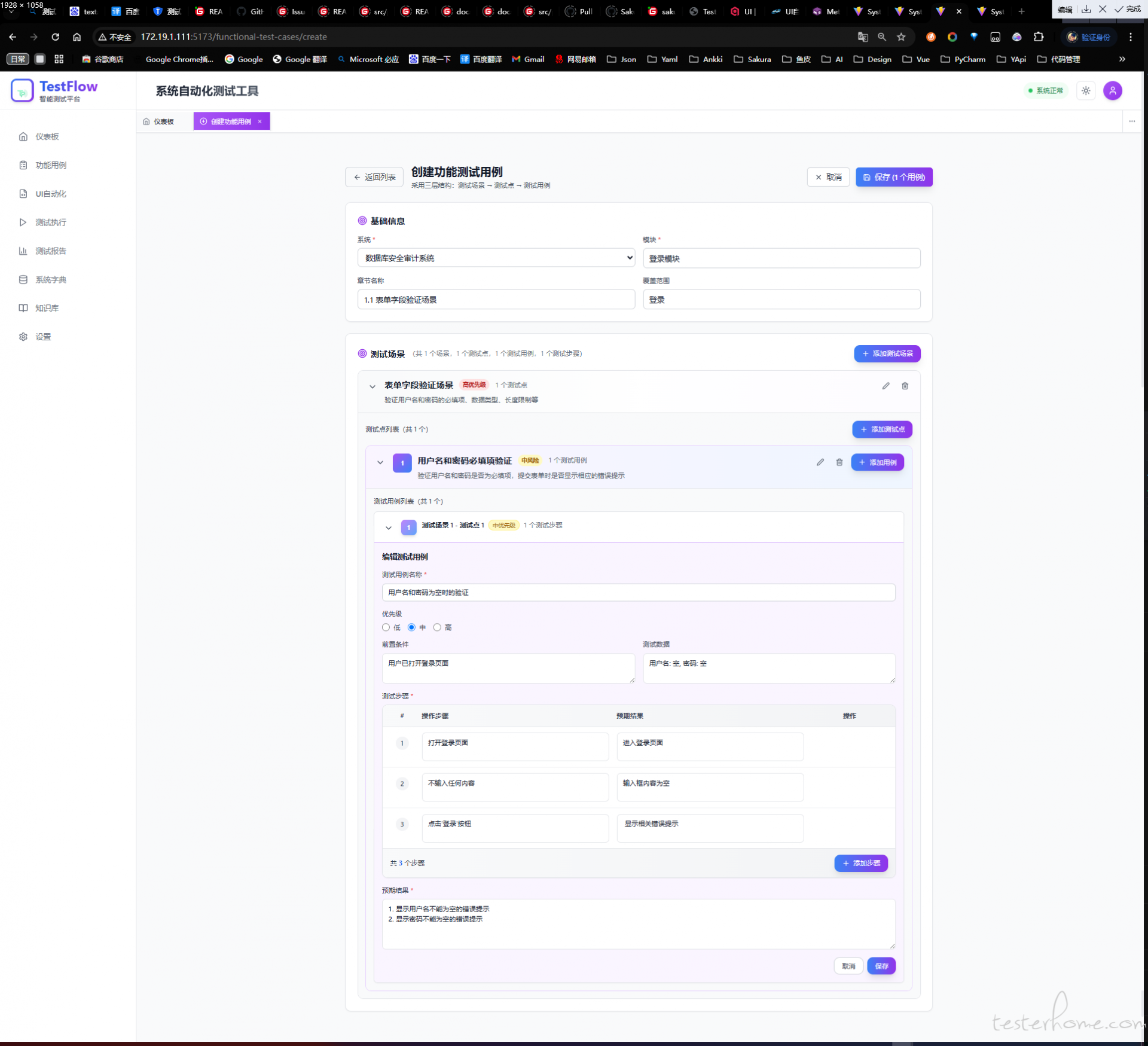

最后,通过复选框选择生成好的测试目的,将测试用例批量保存到列表

核心功能

2. 自然语言执 UI 自动化

AI 通过自然语言执行测试用例这个就比较简单了,跟大家方法一样也是通过大模型 +Playwright mcp

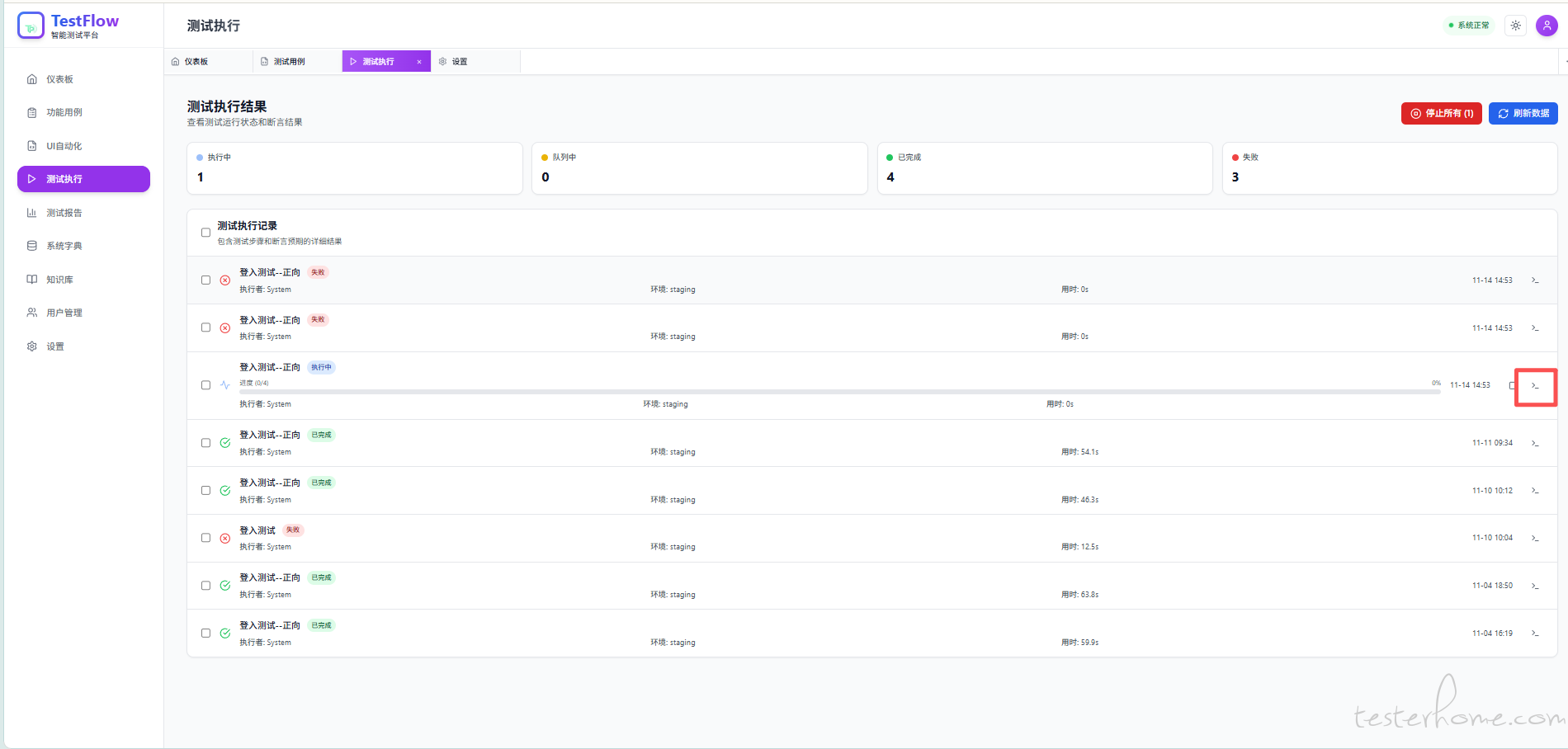

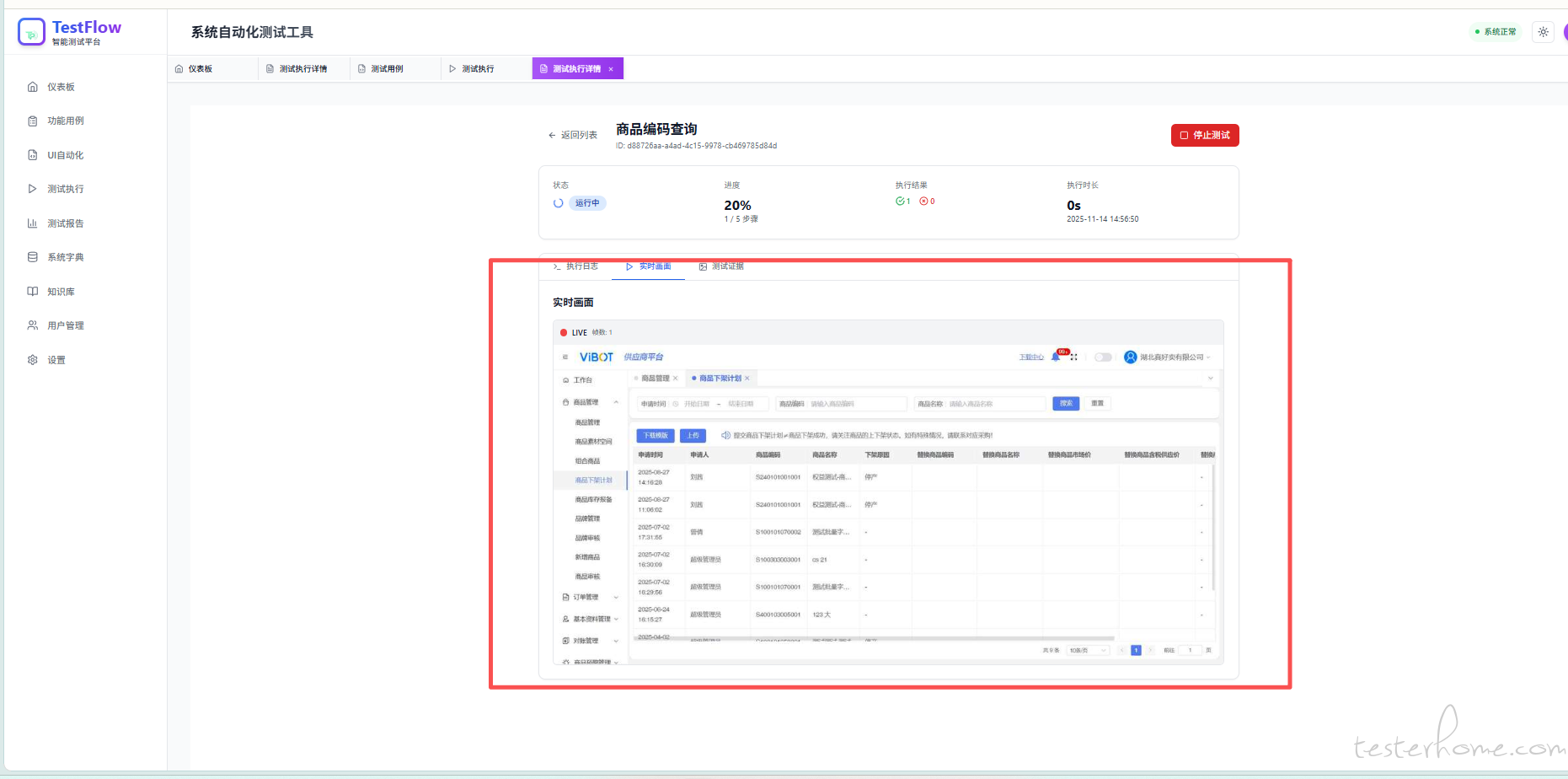

为了解决每次执行只能在服务器端打开浏览器 用户没办法看到画面问题,通过 WebSocket+Playwright 截图 做了个实时画面

直接上实操图

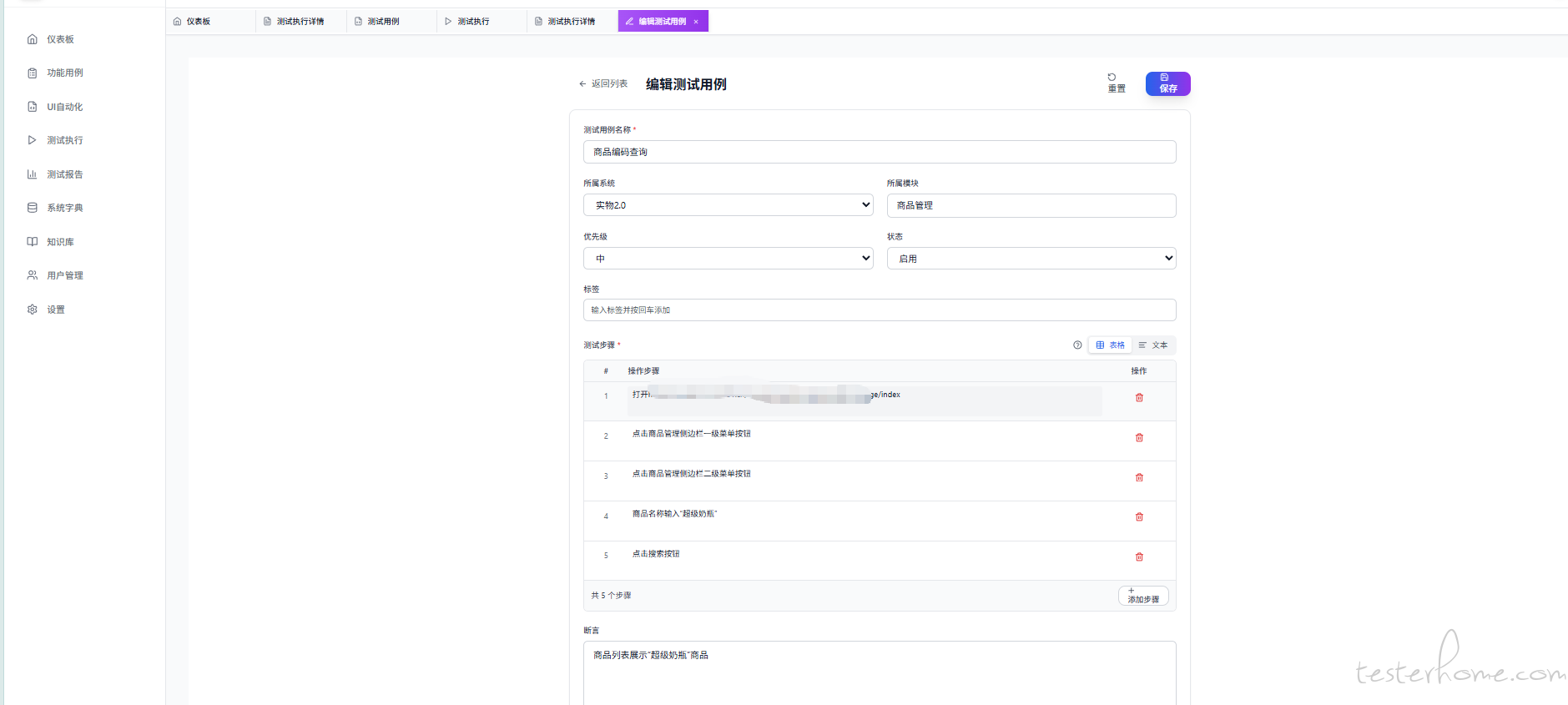

测试用例是一步只写一个操作

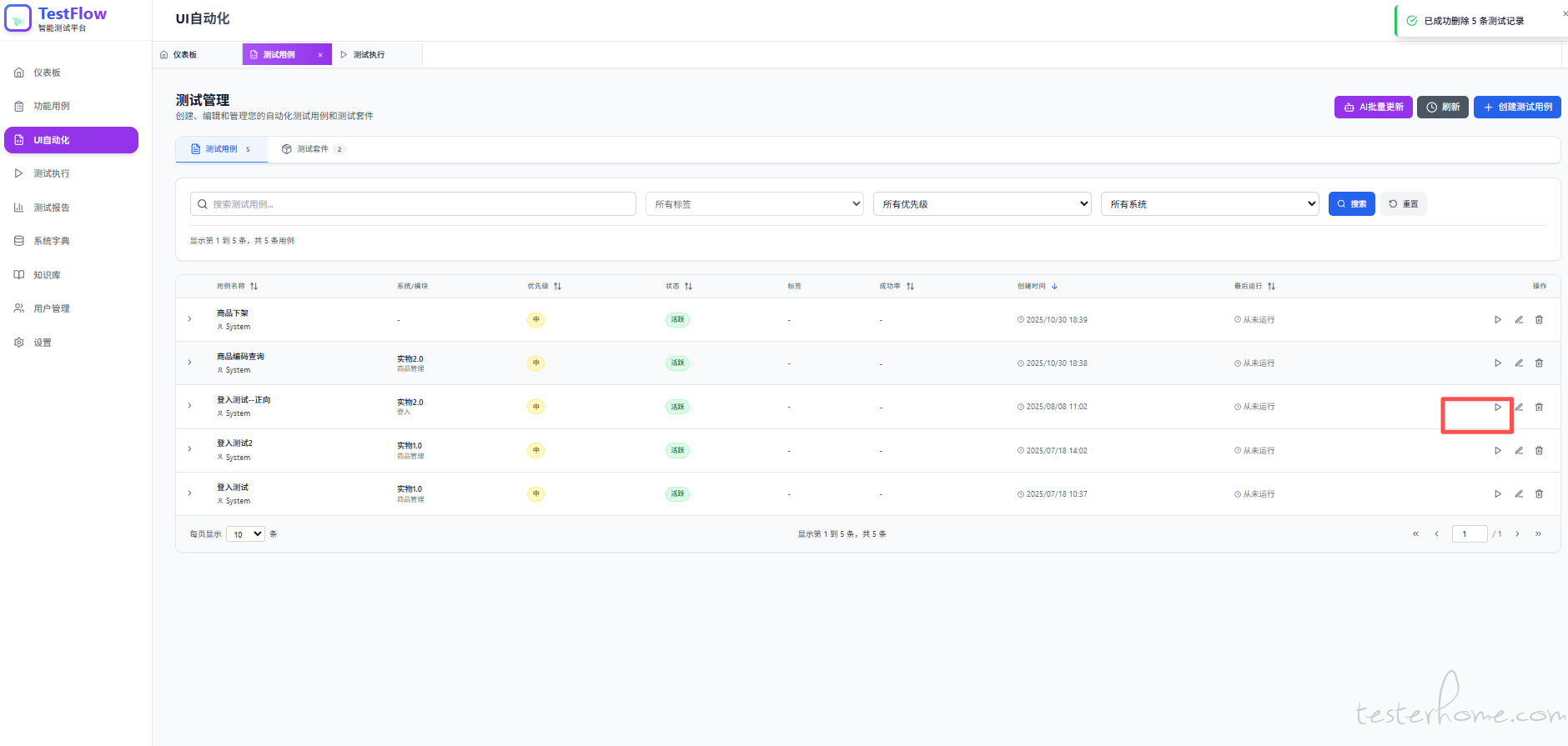

用例页面直接点击运行按钮

自动跳转到测试执行页面,点击日志按钮

就能看到浏览器实时画面

其他的的

你们公司的东西么?直接拿出来开源的么?

啥玩意?楼主不会代码, 自己用 AI 开发的这个玩意吗, 还是说这个工具是为不会代码的人使用的

这个项目前后端 react 和 nodejs 都是 ai 写的?

震惊!!! 就请教一个事 UI 是怎么搞的 自己设计还是找了别人去做的?还是 AI 自己拍脑袋的?

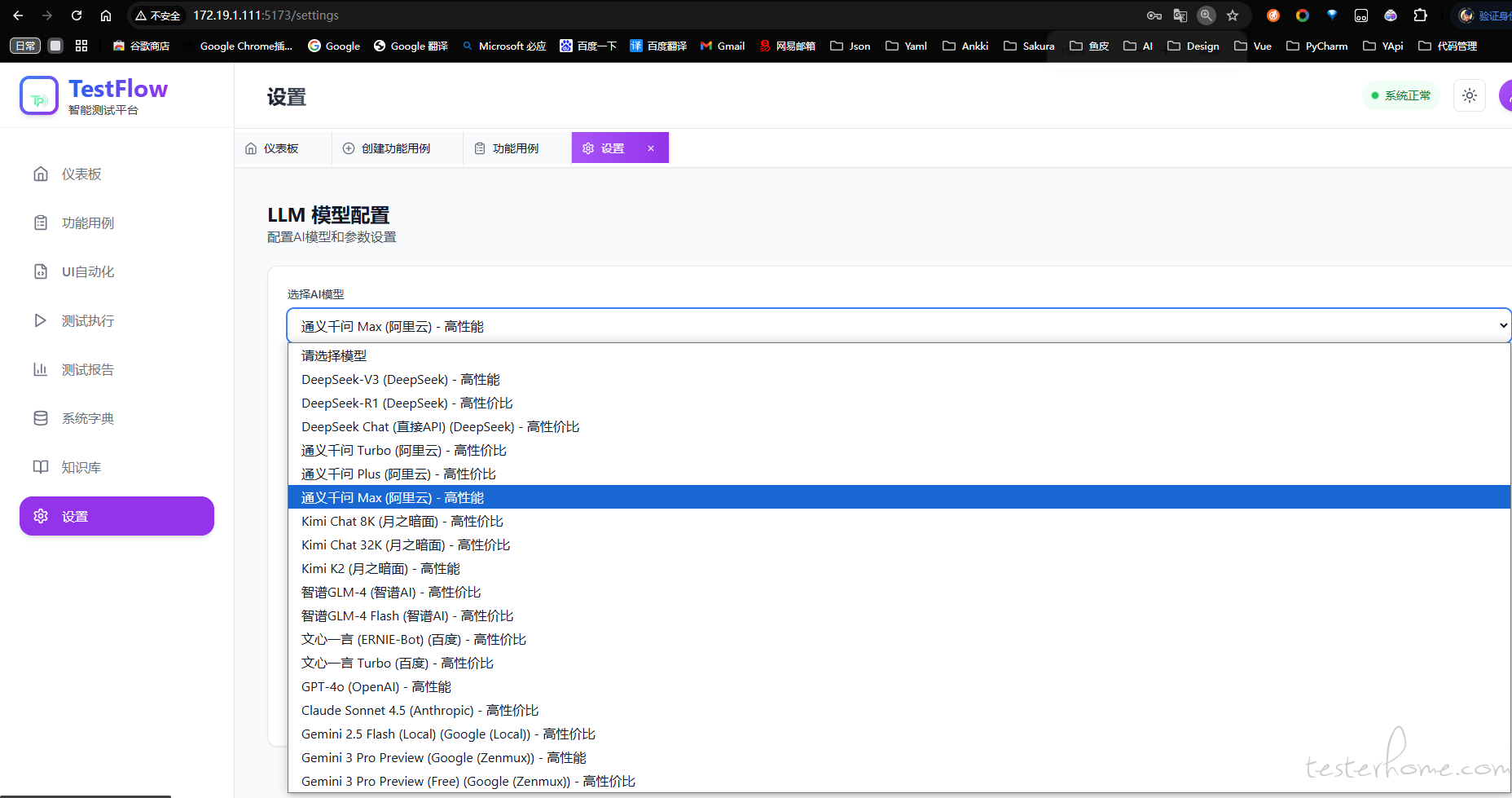

请教下,用的是哪个模型来识别原型图的呢?token 耗费咋样?

厉害厉害

为啥访问 404 呢

博主后缀是不是上传错了 emm

求大佬指点

可以转产品了。

好奇题主的沟通过程

之前 trae 出来的时候见过类似流程,自己先想好需求让 ai 生成需求文档,再把需求文档给到 ai 去开发整个工程,确实需要耐心调

安装了一天也没装起来,放弃了!

这是真的牛呀

有点厉害了

看了楼主项目中的实现,之前我也尝试过类似的方案,来进行 UI 自动化分析执行,但是始终会遇到一些问题,后面暂时搁置了,比如:

- 页面较大,上下文比较大,LLM 无法分析

- 页面存在多个相似的元素,LLM 提供的操作无法正常执行

- 元素相似度过高,导致 LLM 出现决策幻觉

不知道楼主有遇到过相似的问题,是怎么解决的呢

大佬,用的哪个 ai 工具开发的这个项目啊,cursor 吗

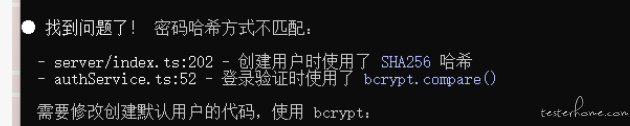

一顿懵逼的操作外加 ai 修复

牛啊,AI 写的测试用例重复了怎么处理?假设需求变更了要重新生成吗?同一个用例,第一次执行和第二次第三次执行的路径都不一样,怎么保证符合预期?

https://github.com/justlovemaki/AIClient-2-API.git 这个是开源的免费用 gemini 大模型的项目 gemini 每天 1000 次,可以结合这个使用

问下我想使用 ai 用自己的 claude code 模型,请问修改哪里呢,能在上传 html 文件后 ai 生成文档和用例呢? 请求 key 做 sk 开头限制是为了什么呢?我都 key 不是 sk 开头然后我在前端去除了这个限制,但是在.env 文件上配置 key 和 api 没有生效!!

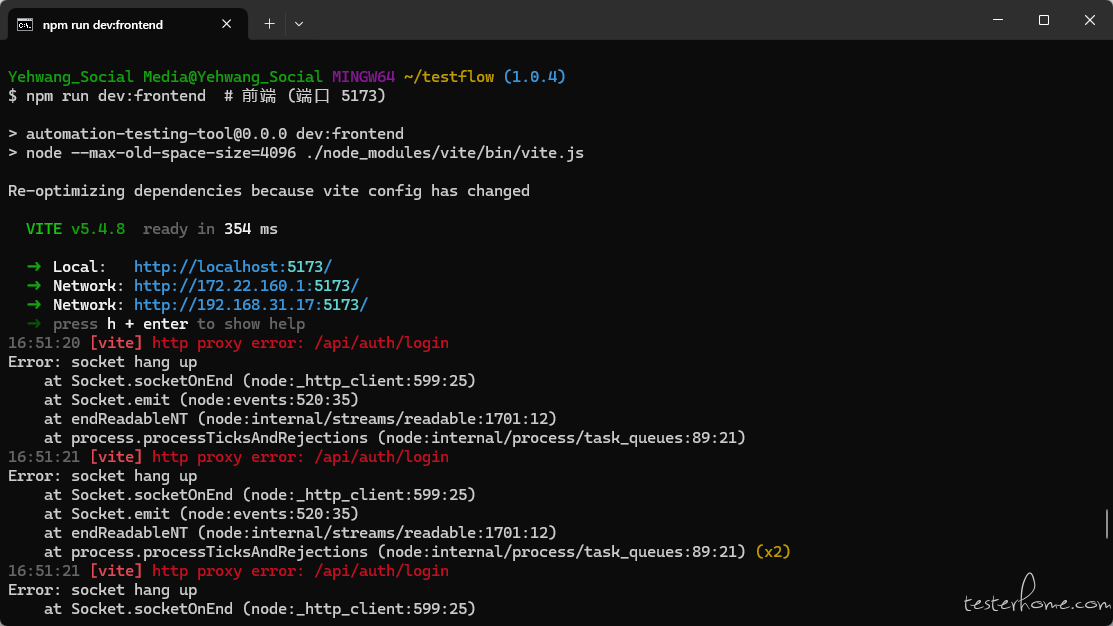

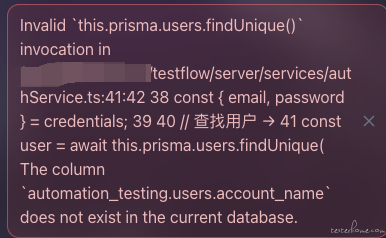

请问下,前端启动一直错误,这是啥问题

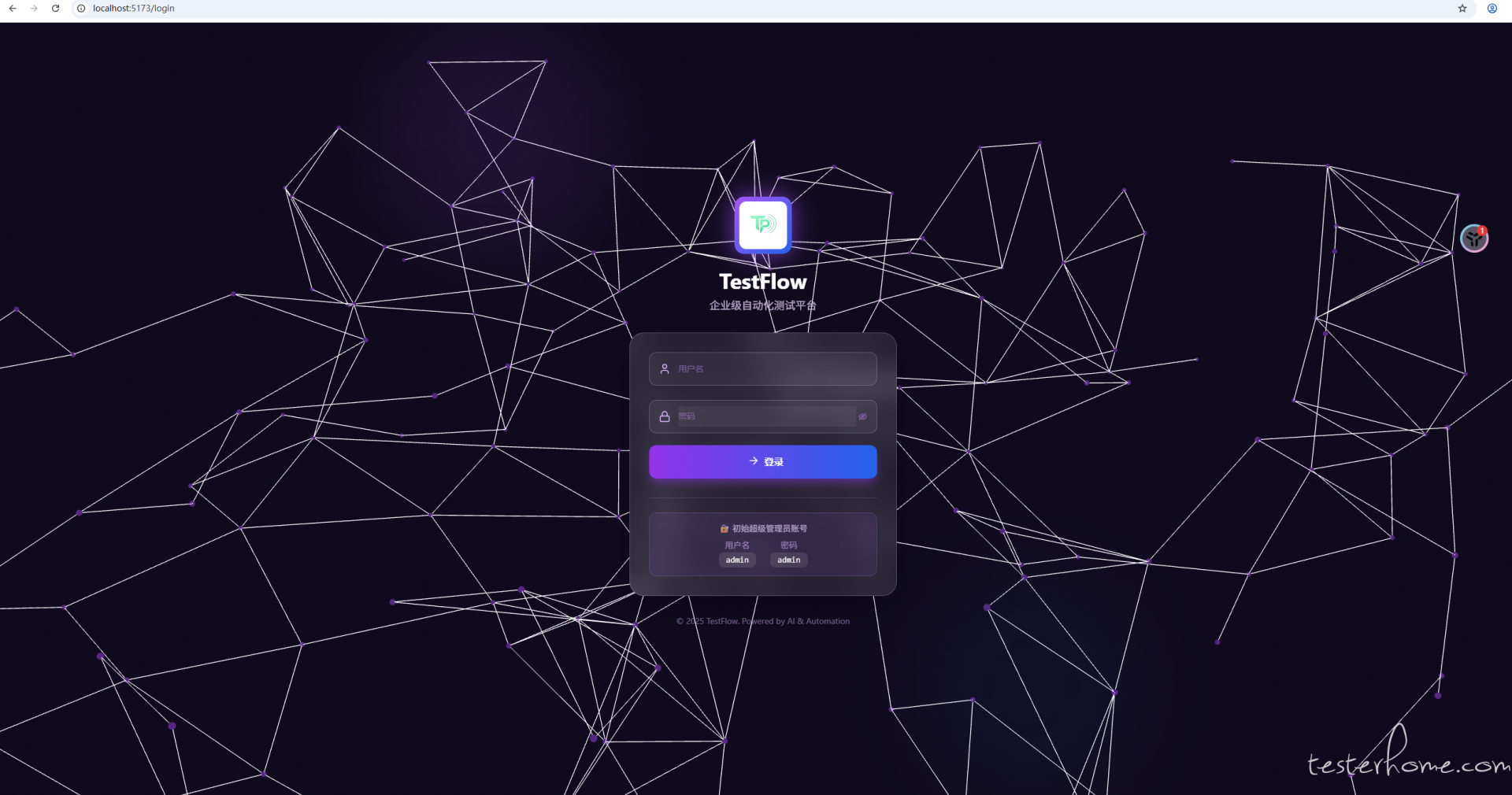

这个服务端访问不到 用 ai 自己解决一下 我也遇到了,看下.env 文件中配置数据库是否正确,然后配置完之后会出现登录密码错误,然后用 ai 解决一下 删除现有的账户再重新创建一个账户再登录进去,其实我觉得可以用 ai 写一个注册页面,这里登录好像写的有点问题

GitHub:https://github.com/SakuraTechy/sakura-ai/tree/dev

Gitee:https://gitee.com/SakuraTechy/sakura-ai/tree/dev/

基于楼主的框架,修复 N+ 问题,可以正常跑通了,新增了多种大模型,同时优化了很多功能,有需要的可以私信我,后续将持续进行优化,可以关注该项目

所以大家生成用例的手感咋样

哥,登录不了啊

项目启动,user 表一直缺字段怎么解决的

@Tttt 项目不开源了吗,我看都 Git 上都访问不了

报 404 了

地址有更新吗?访问不到?

@Tttt 这个系统设计的完整提示词有吗 up 主,以及数据库设计

UI 测试用例只能手写吗

为什么这里会这样