今年公司测试组得 KPI 重点就是这个了,哪位有落地得案例,可以联系我,有偿求教,谢谢!

WX 16603820057

DeepSeek(深度求索)作为专注于人工智能和大数据技术的机构,在软件测试领域可以通过引入 AI 技术与自动化能力,显著提升测试效率、覆盖范围和智能化水平,具体改进方向包括:

智能测试用例生成

自动生成测试场景:通过 LLM(大语言模型)解析需求文档、用户故事或代码结构,自动生成多样化测试用例,覆盖正向/逆向场景。

模糊测试增强:基于 AI 生成边缘案例(如异常输入、复杂参数组合),发现传统方法难以覆盖的潜在缺陷。

测试数据生成:自动创建符合业务规则的大规模仿真数据(例如信用卡号、日期格式),提升测试数据集多样性。缺陷预测与定位

风险驱动的测试:分析历史缺陷数据与代码变更,预测高风险模块并优先测试(如高圈复杂度的函数)。

根因分析:通过堆栈追踪和日志的语义理解,快速定位缺陷源头,缩短问题排查时间(例如区分环境问题与代码逻辑错误)。测试覆盖率优化

代码/分支覆盖分析:通过动态代码插桩技术 +AI 算法,识别未覆盖的逻辑分支,推荐补充用例(如未触发的异常处理代码)。

跨系统链路覆盖:在微服务架构下,追踪跨 API 调用的执行路径,确保端到端场景完整性。性能与负载测试智能化

异常模式识别:通过时序数据分析(如响应时间、内存泄漏曲线),自动发现性能瓶颈(如 GC 频繁触发、数据库锁竞争)。

自适应压测:动态调整虚拟用户行为,模拟真实用户流量波动(如秒杀场景的突发高峰)。自然语言处理(NLP)赋能

需求到用例的转换:将自然语言需求(如 “用户登录需二次认证”)自动转化为可执行的测试脚本。

用户反馈分析:聚类分析用户评论与错误报告,优先测试高频问题场景(如移动端兼容性问题)。自维护自动化测试

脚本自动修复:当 UI 元素 XPath 变化时,通过视觉识别或 DOM 结构分析自动更新定位表达式。

用例有效性验证:识别冗余测试(如多用例覆盖同一条件分支),优化测试集执行效率。持续测试与 CI/CD 集成

智能测试调度:在 Pipeline 中根据代码变更动态选择测试套件(如仅运行受影响的模块测试)。

实时质量门禁:结合代码质量、测试通过率与性能指标,AI 决策是否允许发布。测试资源优化

并行化策略:通过依赖关系分析,最大化并行执行独立测试任务(如将 1000 个 API 测试动态分组到 10 个容器执行)。

云资源弹性分配:根据测试负载自动扩展云计算资源,降低硬件成本。安全测试增强

漏洞模式学习:基于 OWASP Top 10 等知识库,自动检测 SQL 注入、XSS 等漏洞(如分析输入参数过滤逻辑)。

权限边界验证:通过模型推理用户权限矩阵,自动验证越权访问风险。跨平台/设备兼容性测试

设备矩阵优化:通过市场占有率数据分析,优先覆盖主流设备 + 操作系统组合(如 Android 13+ 骁龙 8 Gen2)。

跨浏览器渲染比对:利用图像对比算法自动检测 UI 差异,替代人工视觉验证。

挑战与注意事项

训练数据依赖:需要积累高质量的缺陷数据与测试日志用于模型训练。

误报率控制:需设计反馈机制持续优化 AI 模型的精确度(如人工标记误报案例)。

伦理与安全:生成的测试数据需符合隐私保护要求(如 GDPR 合规的假数据生成)。

通过上述方向,DeepSeek 可将软件测试从"人工密集型"转向"智能决策型",实现测试活动的事前预防(缺陷预测)、事中精准执行(智能调度)、事后闭环优化(根因分析)的全链路升级,典型收益包括:

测试设计效率提升 50%+(通过用例自动生成)

缺陷逃逸率降低 30%+(通过风险预测)

回归测试时间缩短 70%+(通过动态用例选择)

小红书 + 知乎找找看,落地方案够呛,估计都没有,但是可以自己找找方向,找个方向做。

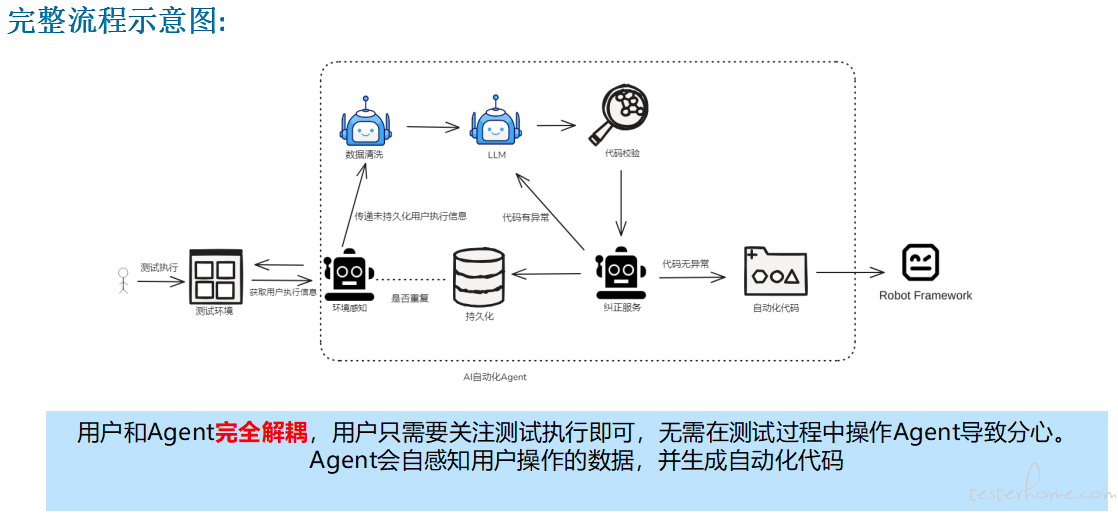

接口自动化 Agent:代理服务 +AI 模型 自动抓取测试过程中的测试数据,AI 同步生成自动化代码,手动测试完全,同步自动化代码就写完了,然后在人工整合修改就好

领导们如何使用 deepseek 提高员工的工资

你问问 deepseek 啊

CI/CD 接入 deepseek 进行单元测试?

同问接口自动化自动抓取数据

然后你搞出来了,也就下岗了,因为不需要你了

首先,如果你正在问结合 AI 的测试落地方案,那么这个问题就算有答案也不是一个人能回答你的,除非他们带领自己的效能团队直接进去你得公司,进行演练,联调,资料适配

以下是 DeepSeek+ 软件测试落地方案的完整框架,结合功能测试、性能测试、安全性测试等核心目标,提供可操作的实施路径:

一、测试范围与优先级

-

核心功能模块

- 搜索算法准确性(深度学习模型输出验证)

- 数据解析与索引能力

- 用户交互功能(如搜索框、过滤条件、结果排序)

- API 接口稳定性

- 搜索算法准确性(深度学习模型输出验证)

-

非功能需求

- 响应时间(如搜索结果返回 <1 秒)

- 并发用户支持(如 10,000+ 用户同时访问)

- 数据安全性(敏感信息加密、权限控制)

- 响应时间(如搜索结果返回 <1 秒)

-

优先级划分

-

P0:核心搜索功能、数据安全性

-

P1:性能瓶颈、高并发场景

-

P2:边缘场景、UI/UX 细节

-

P0:核心搜索功能、数据安全性

二、测试策略与工具

1. 功能测试

-

测试方法:

-

黑盒测试:验证用户端功能是否符合需求(如搜索关键词返回结果的相关性)。

-

白盒测试:针对算法逻辑和代码覆盖率(使用工具如 JaCoCo)。

-

黑盒测试:验证用户端功能是否符合需求(如搜索关键词返回结果的相关性)。

-

工具:

-

自动化测试:Selenium(Web UI)、Postman(API)、Appium(移动端)。

-

手动测试:覆盖复杂业务场景和用户体验验证。

-

自动化测试:Selenium(Web UI)、Postman(API)、Appium(移动端)。

2. 性能测试

-

场景设计:

-

基准测试:单用户正常操作下的性能基线。

-

压力测试:逐步增加并发用户至系统崩溃点,记录最大承载量。

-

稳定性测试:持续高负载(如 24 小时运行)检测内存泄漏和资源占用。

-

基准测试:单用户正常操作下的性能基线。

-

工具:

- JMeter(模拟高并发)、Gatling(分布式压测)、Prometheus(监控资源指标)。

- JMeter(模拟高并发)、Gatling(分布式压测)、Prometheus(监控资源指标)。

3. 安全性测试

-

重点项:

- SQL 注入、XSS 攻击防护

- 数据传输加密(TLS/SSL)

- 用户权限越权测试

- SQL 注入、XSS 攻击防护

-

工具:

- OWASP ZAP(渗透测试)、Nessus(漏洞扫描)、Burp Suite(接口安全)。

- OWASP ZAP(渗透测试)、Nessus(漏洞扫描)、Burp Suite(接口安全)。

4. 兼容性测试

-

覆盖范围:

-

浏览器:Chrome、Firefox、Safari、Edge。

-

操作系统:Windows、macOS、Linux、Android、iOS。

-

分辨率:适配主流屏幕尺寸(如 4K、2K、移动端竖屏/横屏)。

-

浏览器:Chrome、Firefox、Safari、Edge。

-

工具:

- BrowserStack(云端多平台测试)、Responsive Design Checker(响应式布局验证)。

- BrowserStack(云端多平台测试)、Responsive Design Checker(响应式布局验证)。

5. 用户体验测试

-

方法:

- A/B 测试:对比不同交互设计对用户留存率的影响。

- 用户访谈:收集真实用户对搜索效率和结果准确性的反馈。

- A/B 测试:对比不同交互设计对用户留存率的影响。

三、测试环境与数据管理

-

环境搭建

-

生产镜像环境:使用 Docker/Kubernetes 模拟生产环境配置。

-

测试数据:

- 真实数据脱敏(如用户搜索日志)。

- 合成数据生成(覆盖长尾关键词、特殊字符等边缘场景)。

- 真实数据脱敏(如用户搜索日志)。

-

生产镜像环境:使用 Docker/Kubernetes 模拟生产环境配置。

-

数据隔离

- 测试数据库与生产环境物理隔离,避免数据污染。

- 测试数据库与生产环境物理隔离,避免数据污染。

四、测试执行流程

-

阶段划分

-

单元测试:开发阶段完成,覆盖率 >80%。

-

集成测试:模块间接口联调,验证数据流一致性。

-

系统测试:全链路测试,包括功能、性能、安全。

-

验收测试:用户代表参与,签署测试报告。

-

单元测试:开发阶段完成,覆盖率 >80%。

-

自动化流水线

- 集成 CI/CD(如 Jenkins/GitLab CI),实现代码提交后自动触发测试套件。

- 集成 CI/CD(如 Jenkins/GitLab CI),实现代码提交后自动触发测试套件。

五、风险与应对措施

| 风险类型 | 应对方案 |

|---|---|

| 算法准确性不足 | 增加测试数据集多样性,引入对抗样本测试 |

| 高并发下响应延迟 | 优化数据库索引,引入缓存机制(Redis) |

| 安全漏洞 | 定期渗透测试,建立漏洞修复 SLA(如 24h) |

| 跨平台兼容性问题 | 使用云测试平台覆盖 95%+ 的设备和浏览器组合 |

六、交付物与验收标准

-

交付物

- 测试计划、用例文档、缺陷报告、性能测试报告、安全审计报告。

- 测试计划、用例文档、缺陷报告、性能测试报告、安全审计报告。

-

验收标准

- 关键缺陷清零(P0 级缺陷修复率 100%)。

- 性能指标达标(如 95% 请求响应时间 ≤1 秒)。

- 用户满意度 ≥90%(通过 NPS 评分或调研)。

- 关键缺陷清零(P0 级缺陷修复率 100%)。

七、团队协作与沟通

-

每日站会:同步测试进度和阻塞问题。

-

缺陷管理:使用 Jira/禅道跟踪问题闭环。

-

跨部门协作:开发、测试、运维共同参与生产环境问题复盘。

通过此方案,可系统化保障 DeepSeek+ 的软件质量,平衡测试效率与覆盖率,最终实现快速迭代和稳定交付。

以前就各种左右移,现在都是 AI

同求落地方案,有的兄弟踢一脚

同求 +1

先把百炼之类的训练平台用起来吧,市面上通用型产物满足不了业务需求的

DeepSeek(深度求索)作为专注于人工智能和大数据技术的机构,在软件测试领域可以通过引入 AI 技术与自动化能力,显著提升测试效率、覆盖范围和智能化水平,具体改进方向包括:

智能测试用例生成

自动生成测试场景:通过 LLM(大语言模型)解析需求文档、用户故事或代码结构,自动生成多样化测试用例,覆盖正向/逆向场景。

模糊测试增强:基于 AI 生成边缘案例(如异常输入、复杂参数组合),发现传统方法难以覆盖的潜在缺陷。

测试数据生成:自动创建符合业务规则的大规模仿真数据(例如信用卡号、日期格式),提升测试数据集多样性。缺陷预测与定位

风险驱动的测试:分析历史缺陷数据与代码变更,预测高风险模块并优先测试(如高圈复杂度的函数)。

根因分析:通过堆栈追踪和日志的语义理解,快速定位缺陷源头,缩短问题排查时间(例如区分环境问题与代码逻辑错误)。测试覆盖率优化

代码/分支覆盖分析:通过动态代码插桩技术 +AI 算法,识别未覆盖的逻辑分支,推荐补充用例(如未触发的异常处理代码)。

跨系统链路覆盖:在微服务架构下,追踪跨 API 调用的执行路径,确保端到端场景完整性。性能与负载测试智能化

异常模式识别:通过时序数据分析(如响应时间、内存泄漏曲线),自动发现性能瓶颈(如 GC 频繁触发、数据库锁竞争)。

自适应压测:动态调整虚拟用户行为,模拟真实用户流量波动(如秒杀场景的突发高峰)。自然语言处理(NLP)赋能

需求到用例的转换:将自然语言需求(如 “用户登录需二次认证”)自动转化为可执行的测试脚本。

用户反馈分析:聚类分析用户评论与错误报告,优先测试高频问题场景(如移动端兼容性问题)。自维护自动化测试

脚本自动修复:当 UI 元素 XPath 变化时,通过视觉识别或 DOM 结构分析自动更新定位表达式。

用例有效性验证:识别冗余测试(如多用例覆盖同一条件分支),优化测试集执行效率。持续测试与 CI/CD 集成

智能测试调度:在 Pipeline 中根据代码变更动态选择测试套件(如仅运行受影响的模块测试)。

实时质量门禁:结合代码质量、测试通过率与性能指标,AI 决策是否允许发布。测试资源优化

并行化策略:通过依赖关系分析,最大化并行执行独立测试任务(如将 1000 个 API 测试动态分组到 10 个容器执行)。

云资源弹性分配:根据测试负载自动扩展云计算资源,降低硬件成本。安全测试增强

漏洞模式学习:基于 OWASP Top 10 等知识库,自动检测 SQL 注入、XSS 等漏洞(如分析输入参数过滤逻辑)。

权限边界验证:通过模型推理用户权限矩阵,自动验证越权访问风险。跨平台/设备兼容性测试

设备矩阵优化:通过市场占有率数据分析,优先覆盖主流设备 + 操作系统组合(如 Android 13+ 骁龙 8 Gen2)。

跨浏览器渲染比对:利用图像对比算法自动检测 UI 差异,替代人工视觉验证。

挑战与注意事项

训练数据依赖:需要积累高质量的缺陷数据与测试日志用于模型训练。

误报率控制:需设计反馈机制持续优化 AI 模型的精确度(如人工标记误报案例)。

伦理与安全:生成的测试数据需符合隐私保护要求(如 GDPR 合规的假数据生成)。

通过上述方向,DeepSeek 可将软件测试从"人工密集型"转向"智能决策型",实现测试活动的事前预防(缺陷预测)、事中精准执行(智能调度)、事后闭环优化(根因分析)的全链路升级,典型收益包括:

测试设计效率提升 50%+(通过用例自动生成)

缺陷逃逸率降低 30%+(通过风险预测)

回归测试时间缩短 70%+(通过动态用例选择)

我对您这个方案十分感兴趣。想向您请教一下,在您的实践中,是通过怎样的方式将 BurpSuite 抓取到的信息提炼传递给 agent 的呢?