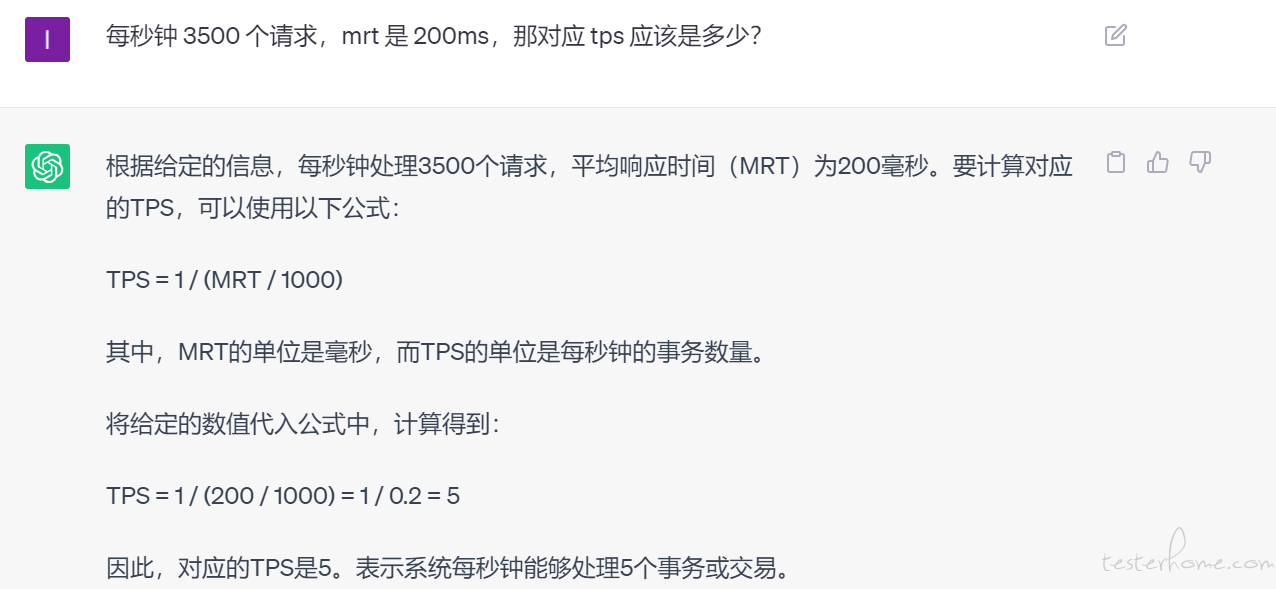

/ask 每秒钟 3500 个请求,mrt 是 200ms,那对应 tps 应该是多少?

要计算每秒处理的事务数(TPS),我们首先需要将每秒的请求数 (Requests per Second, RPS) 与平均响应时间 (Mean Response Time, MRT) 结合起来。我们需要将 MRT 转换为每秒的时间单位,然后使用 RPS 除以转换后的每秒 MRT。

给定的条件是:

RPS = 3500

MRT = 200ms(0.2 秒)

每秒响应时间 (MRT_Per_Second) = 1/MRT 秒

MRT_Per_Second = 1/0.2 = 5

最后,我们计算 TPS:

TPS = RPS x MRT_Per_Second

TPS = 3500 * 5

TPS = 17500

所以,在这个条件下,事务处理每秒(TPS)应为 17500。

大佬们,上述问题 GPT4.0 回答的对吗?

我怎么觉得是 3500*200/1000=700 呢