-

测试领域到底是横向发展还是垂直发展 at 2021年11月22日

记得:广度是深度的副产品,如果你觉得你自动化测试做得很好了,但是只会自动化测试等很容易被替代,说明你的深度根本不够,没找到解决问题的核心方法套路。

举个例子:做 GUI 的自动化测试,面临分布式、兼容性问题的时候你要解决的就会有测试实验室/云测服务的构建,市面上的现有解决方案无论多优秀,在你具体的场景落地的时候都会有这样那样的问题,你要解决下去就势必需要掌握这些周遭的技能,比如自己加特性、改 BUG,了解开源协议背后的知识,学习采购和设备管理,保不准还要掌握 docker、k8s、openstf 等等之类的技能,然后保不齐又要辐射出 dockerhub、helm 等等等等……所以你所说的广度这就已经很可观了,关键是:你真的做到了追求深度了吗? -

社区跳转链接的 bug at 2021年11月19日

懂了,核心问题是 url 拼接没有用 rootUrl,用了 current location

-

社区首页的 bug at 2021年11月19日

给艾总新书做的硬广而已,怎么就变成了 bug?

-

社区跳转链接的 bug at 2021年11月19日

你为什么认为你的『预期结果』是对的呢?

在我看来目前的跳转没啥问题,右侧的版主展示是框架性的内容,不会因为你在哪个节点而跳转目标不同 -

公司研发要求测试人员提供研发自测用例,合理吗? at 2021年11月18日

换个问法:开发能自测又能自己设计很科学的 case,关键是有问题随手就改好了,Geek……还要测试干吗呢?

显然开发的长处是写 bug 和改 bug,指望开发设计 case 就很容易陷入开发者典型的固定思维套路,造成大面积测试遗漏,你是测试大拿,你这时候还不上去体现自己价值更待何时……还问~ -

开源一个 vue 版的脑图编辑器,数据上已兼容 agiletc 的测试结果格式 at 2021年11月16日

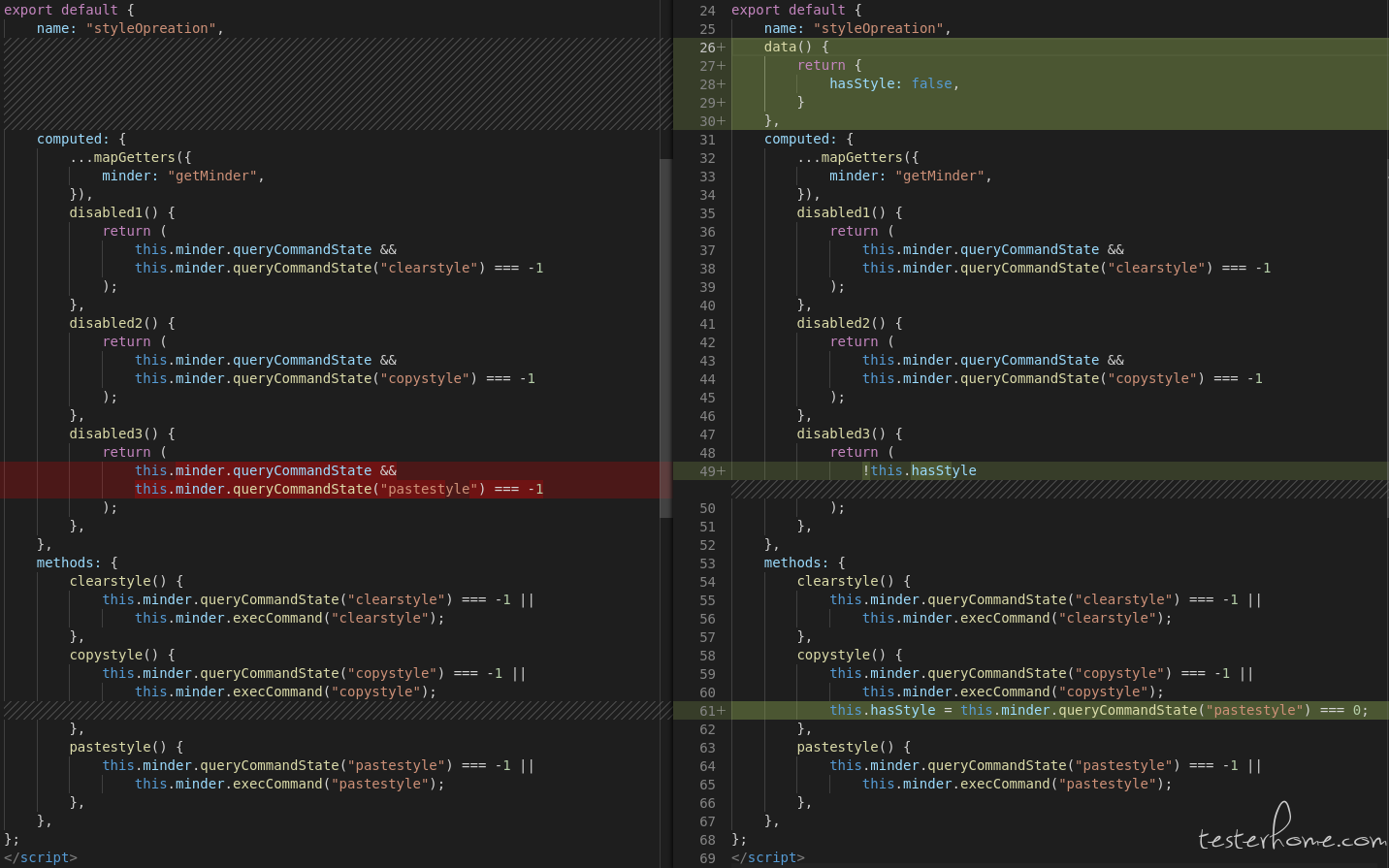

@ 一枚老男孩 其实是可以用的,默认都是无样式的,你们试着改一下字体或者字号,『复制样式』、『清除样式』就可以点了

但是『粘贴样式』是有 bug 的,只是样式上一直是 disable 的,但其实也是可以点的,试一下就知道了,找一下样式控制那个文件改一下代码就 OK 了:

-

代码覆盖率 VS 测试覆盖率 at 2021年11月15日

go、c/c++、oc 的覆盖率呢,不比 Java 用的少啊

-

Chrome 97 推出了一个预览功能 - Recorder 感觉要失业了 at 2021年11月12日

为什么连这种话题都要匿名,上瘾吗

-

在大家心里,测试是个好职业吗? at 2021年11月10日

没有好不好,只有在自己的能力范围内能胜任的最好职业,我也想去做上市公司做高薪高管,然而实力不允许啊

-

测试转研发的一年总结 at 2021年11月09日

我 30 开始兼职 CRUD,到现在(37)还是 CRUD,只不过变成了需求、架构、设计、建模、前后端都能自己搞定的 CRUD,佩服楼主的魄力,这么大年纪……

-

月初了,大家填绩效表了么?这个月又要扣工资了。 at 2021年11月03日

实名回复,我 2017~2020 这两年多的薪资状态跟楼主一样,每个月被扣,奈何电驴 5 分钟就能到公司,早九晚六,开心地忍了 2 年多

-

开源一个 vue 版的脑图编辑器,数据上已兼容 agiletc 的测试结果格式 at 2021年11月01日

我是萌新,恒捷大佬才是前辈

-

精准测试中的一些疑问? at 2021年10月28日

- 1、精准测试的前提是被测代码干净,if else 拿来做少量逻辑控制是可以的,拿来做场景分支控制就是屎山代码,这种你首先应该解决的是单测的问题,而不是精准测试这种宏观层面的手段。

- 2、能够识别调用链就不错了,已经可以减少很多无关测试,你把这一步做好再考虑后面的问题比较实际一点,再迈一步就不是测试团队自己能够解决的了。

-

在公司,我如今的 “处境” 要怎么做? at 2021年10月27日

操作都已经这么骚了,你就留下各种证据,象征性地测试一下,出了问题要背锅就甩证据,不出问题就对付一下。

留下时间自己学习和搞各种新技术——就拿项目练手便是,然后学一段时间面一下,学一段面一下,差不多就可以闪人了。 -

游戏测试 - 客户端性能 - 寻路采集热点图 at 2021年10月25日

大猫文章挺好的,就是排版让人不敢恭维~

-

toB 业务的测试难点 at 2021年10月11日

平时用个招行银行 app 转账还提示等待 10 秒,用支付宝和微信转账根本不存在这种等待,就是传统银行跟互联网的区别

我怎么觉得这是普通人对业务不了解而造成的偏见呢……

@siwen 司总给解释一下银行转帐和支付宝转帐的区别在哪里吧 -

toB 业务的测试难点 at 2021年10月11日

所以技术的价值就是给他们 bd 养胃啊,你们多做一点,他们就少喝一杯,让 bd 明白这个道理,然后他们就不敢对你们嚣张了,哈哈哈哈~

-

toB 业务的测试难点 at 2021年10月11日

土比业务,酒桌上见真章,技术是次要的

-

在游测这些年(2009-2012) at 2021年10月08日

请大猫同学后续在写的时候补充一下每年投资的分类和盈亏情况,我们来画曲线

-

使用 JDBC 查询数据库,表内字段类型为 bigint,在 java 中为啥变成 Long 了? at 2021年09月29日

mysql 和 java 的 int 范围都是-2147483648~ 2147483648,要兼容更大的数字用 bigint,那 java 里面还用 int 怎么转换?超过 2147483648 都算啥呢?

-

安全无小事,订单就更严重了,这种必须要改,不然出了资损测试一样背锅~

当然最可悲的不是测试没发现问题而背锅,而是发现了开发不改而背的锅,到时候说你不坚持、没立场…… -

目前这样该不该离职呢?出去外面的世界看看? at 2021年09月27日

刚好商城业务线也是我比较喜欢的……后来我知道这件事之后,立马反水……

谜一样的操作,估计你自己也整不明白自己到底想干啥吧~组长这么调人一般都是基于对下属能力的认可,拉你过去撑场面,把之前没搞好的搞好一点,或者觉得你的能力在 HR 这种业务里面就是浪费材料,让你去更大的舞台,优化资源配置——在我看来这都是机会……当然也不排除他有其他阴暗的心思,不过可能性很小。

-

python 实现 yaml 文件和 Excel 文件的互转,引用哪个库好一些? at 2021年09月24日

调别人的 api 岂不更爽

https://www.bejson.com/json/json2excel/ -

公司的质量平台要取名啦,大家有没有好的建议 at 2021年09月10日

我觉得在钦天监、司礼监里面选一个更好

-

公司的质量平台要取名啦,大家有没有好的建议 at 2021年09月10日

不良人、通文馆、幻音坊、玄冥教、十二峒……都可以啊