AI测试 AUITestAgent:用自然语言写大前端自动化 Case,智能化进行驱动、校验工作

我们团队做了个很有意思的项目,用自然语言写大前端自动化 Case,同时进行驱动、和校验工作,在实验和实际使用的效果都挺不错。目前在我们实际多个业务方向中用起来准确率、稳定性、易用性、可维护性都还不错。

AUITestAgent 首页:使用效果视频可在项目首页观看

论文链接

AUITestAgent 是第一个自动化、自然语言驱动的移动应用程序 GUI 测试工具,能够完全自动化整个 GUI 交互和功能验证过程(其他项目,如 AppAgent、MobileAgent 等仅能够通过自然语言进行交互定义、驱动,无法同时进行校验)。它以自然语言编写的测试需求作为输入,生成并执行 UI 交互,并验证 UI 响应是否符合需求中概述的预期。

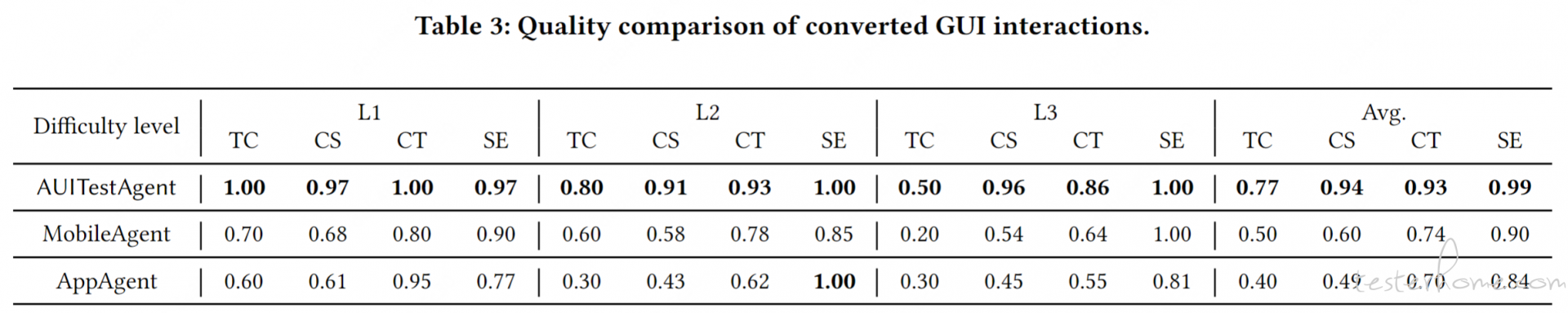

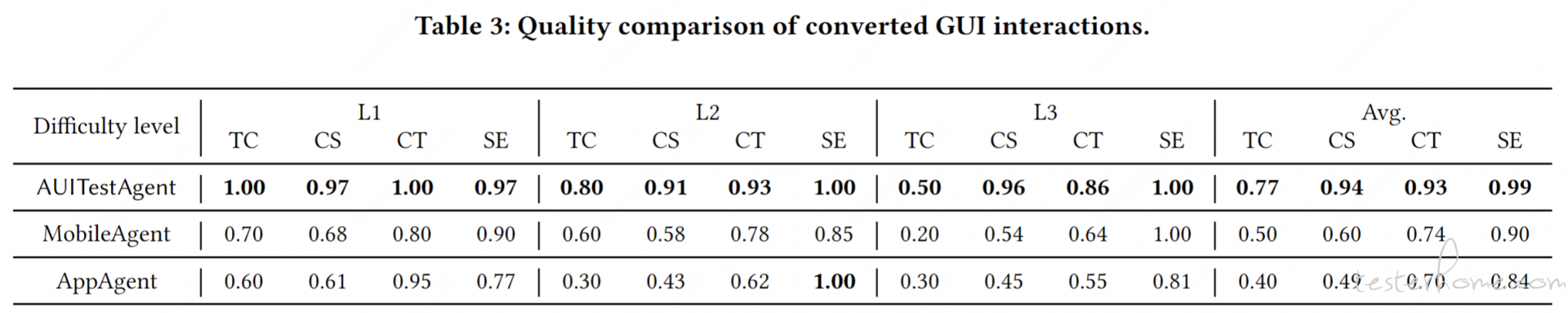

我们使用两个定制的基准(交互基准和验证基准)评估 AUITestAgent 的性能,包括 8 个广泛使用的商业应用(即美团、小红书、豆瓣、Facebook、Gmail、LinkedIn、Google Play 和 YouTube Music)。为了提供全面的评估,我们将交互任务的难度分为三个级别:简单(L1)、中等(L2)和困难(L3)。对于每个级别,我们构建了十个交互任务,描述均匀分布在英语和中文之间。

我们的实验表明,AUITestAgent 在 L1 级别准确完成 100% 的任务,L2 级别完成 80% 的任务,L3 级别完成 50% 的任务。此外,AUITestAgent 生成的 94% 的交互与通过手动交互的基准结果一致。此外,AUITestAgent 在检测注入的 GUI 功能错误方面达到 90% 的召回率,同时保持较低的误报率,仅为 4.5%。更重要的是,它成功检测到美团中的未知错误,凸显了在复杂商业应用中使用 AUITestAgent 进行 GUI 测试的实际优势。

现在这个方向挺火爆的,很多团队在研究和探索落地,希望可以交流交流。

请问代码开源了么

测试用例是咋写的? 没找到相关文件

https://github.com/bz-lab/AUITestAgent/blob/main/verification.md

这个是驱动 + 校验的 case 例子集合

我们都已经做成产品要上线了。。

对于没有文案,只有图标的按钮/控件,能实现点击吗?

运行速度咋样,毕竟大模型的交互响应是以秒为单位的

这个对于基座的要求不是特别高,国内的几个 MLLM 效果都不错,每一步操作大概耗时十几秒到 20 多秒吧

求教:

1、稳定吗?重复执行的质量咋样?

2、UI 的不合理变动,比如控件位置发生偏移、布局改坏,这些人为识别或者图像匹配识别的问题,能拦截吗?

多次执行的准确率可以参考实验结果https://github.com/bz-lab/AUITestAgent/blob/main/interaction_zh.md https://github.com/bz-lab/AUITestAgent/blob/main/evaluation_results/evaluation_zh.md 整体来看还是比较稳定的

UI 的不合理状态可以进行一定程度的检查,但是当前的检查能力没有对这种通识性布局问题进行特化,总体准确率不会特别高,在实际使用的过程中会加入针对各种类型异常的专项检测

请问跟 app 相关的知识是怎么维护的

源码可以分享一下吗

搞半天我以为你们自己训练的模型,结果是调通用大模型接口,那有啥用啊

@white 看完了论文以及视频,同求加微信交流一下是否可以采购相关的

hello,可以微信沟通一下产品吗

18765969196