前言

作为一个资深 DOTA、LOL、王者荣耀玩家(虽然已经退游多年),一直觉得游戏里的竞赛机制设计的非常有意思,能够让玩家乐此不彼的力争上游;比如 DOTA 在 11 平台的天梯积分排名系统、LOL 和王者荣耀的排位赛及巅峰赛机制。在充分的竞争下,把玩家在比赛过程中的表现进行数据量化,相对客观的反映出每个玩家的真实实力。

那如果能把这样富有竞争性质的积分体系引用到质量团队的管理中,会不会也变得很有趣呢?

背景

如火如荼的效能建设

“效能” 一词几乎成为各中大厂绕不开的话题,能效指标、体系建设、能效看板仿佛都成了公司研发管理标配,当然不同的岗位度量的指标或方式会有些许差异,我司在 2022 年也在大力建设效能度量体系。

绩效管理的痛点

如果公司有绩效考核的正态分布机制,那么每年打绩效、谈绩效就成了鬼门关,TL 不想过,普通员工也不想过。

每次的绩效考核,在员工自评环节,往往收到的自我评价和评分都非常的高,但在团队中是要进行排序的;可能会有人说,绩效不就是谁跟领导关系好,谁会舔领导会做向上管理,谁的绩效就好。当然不是,至少在我这儿不是,所以客观的输出量化数据就成了非常重要的参考。

大部分同学都相对只关注自己负责的那部分业务,很少看的到团队的全局,如果业务无交集,那么团队内的交集也变得比较少;团队内部都是这样,更何况不同的团队之间,TL 也都觉得自己负责的团队成员都很优秀,所以每次绩效 PK 也出现了各说各话,变成了拼口才、拼人情世故。

目标管理的盲点

福报厂有个很出名的方法论:定目标、抓过程、拿结果。

实际操作过程中,目标怎么定,基于什么来定,往往最后都是拍一个目标,也不管它的可达性。

过程的把控不用日报、周报的话,有更智能化的方式吗?

拿到的实际客观结果是多少,离目标结果又有多少差距?如果过程管控不到位,那么季度末复盘 OKR 就成了团队一起来开盲盒。

为什么做

- 能够指导团队各周期 OKR 建设,基于数据定目标,基于目标调指标

- 能够驱动团队内部成员良性公平竞争,团队顺利拿到结果

- 能够及时给与团队成员数据反馈,过程公开透明

怎么做

圈定指标的原则

- 既是一线测试工程师想要的,也是 TL、部门希望拿来拉通做对比的

- 指标是可被量化的、可线上化的

- 指标与指标之间需要存在互相制约性,避免出现造指标的风险

- 指标不宜过多,满足 2/8 原则,20% 的指标覆盖团队 80% 的工作过程与结果

- 团队成员对于最终指标的确定有投票权,但无决定权,因为众口难调无法满足到每一个人的诉求

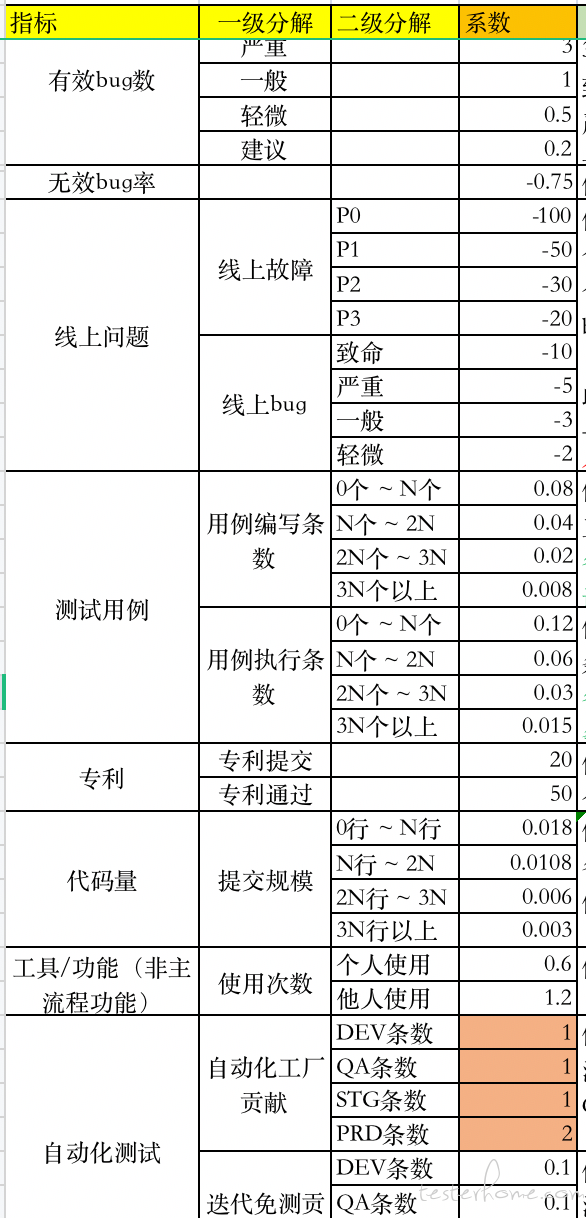

经过了 1 次团队工作坊、3 次对齐会,通过匿名收集、共性指标整理、可行性分析、匿名投票的方式,最终确定出 Top10 指标:

- 有效 bug 数

- 无效 bug 率

- 线上问题(bug、故障)

- 功能用例设计

- 功能用例执行

- 专利(受理、通过)

- 代码量

- 工具节约成本

- 自动化工厂用例贡献

- 自动化用例应用

指标的计分总规则的确定:

- 方式一:各指标分权重百分比,总分 100

- 方式二:各指标有计分系数,总分无上限

其他 TL 更倾向方式一,我更倾向方式二;各有利弊。

方式一把每个人按照固定的框架去限定,最后大概率会变成同一类人:各方面能力比较均衡,并且可以预料出最终每个人的得分比较接近,难分伯仲;

方式二能够鼓励同学们发挥自己的优势,长板可以很长,但也有一定的阶梯积分法,在长板足够长的情况下,去补短板,分数区间会被拉的很大,能够一目了然识别出高产的同学和低产的同学。

好在最后我说服了其他 TL 以及团队的小伙伴,让我的天梯计划能够跨出第一步。

指标取数规则、系数、计算逻辑的确定:

即然要做在线化,那么就涉及到指标怎么自动计算与展示;每个指标的规则是否公平客观,数据从哪里取,怎么进行加工。

各指标系数的确定:

同样通过匿名收集的方式,拿到每个同学心目中系数情况(说实话差异太大,每个人都想往对自己有利的方向去定,甚至 TL);统计筛除异常样本、统计往年历史数据表现(做分数模拟),再经过 TL 层面反复讨论,最终定出终版:

数据源:

由于我们自建了测试平台,包含了功能测试管理、自动化测试、工具集成与组装等模块,让我们在取数渠道上少了很多麻烦,大量的过程数据已经有沉淀。只是部分指标上需要特殊处理:专利情况的手动录入(专利并不多)、代码量的获取(基础架构部门在统计代码量,开了个接口在拉取同步)、工具使用增加埋点统计

计算规则:

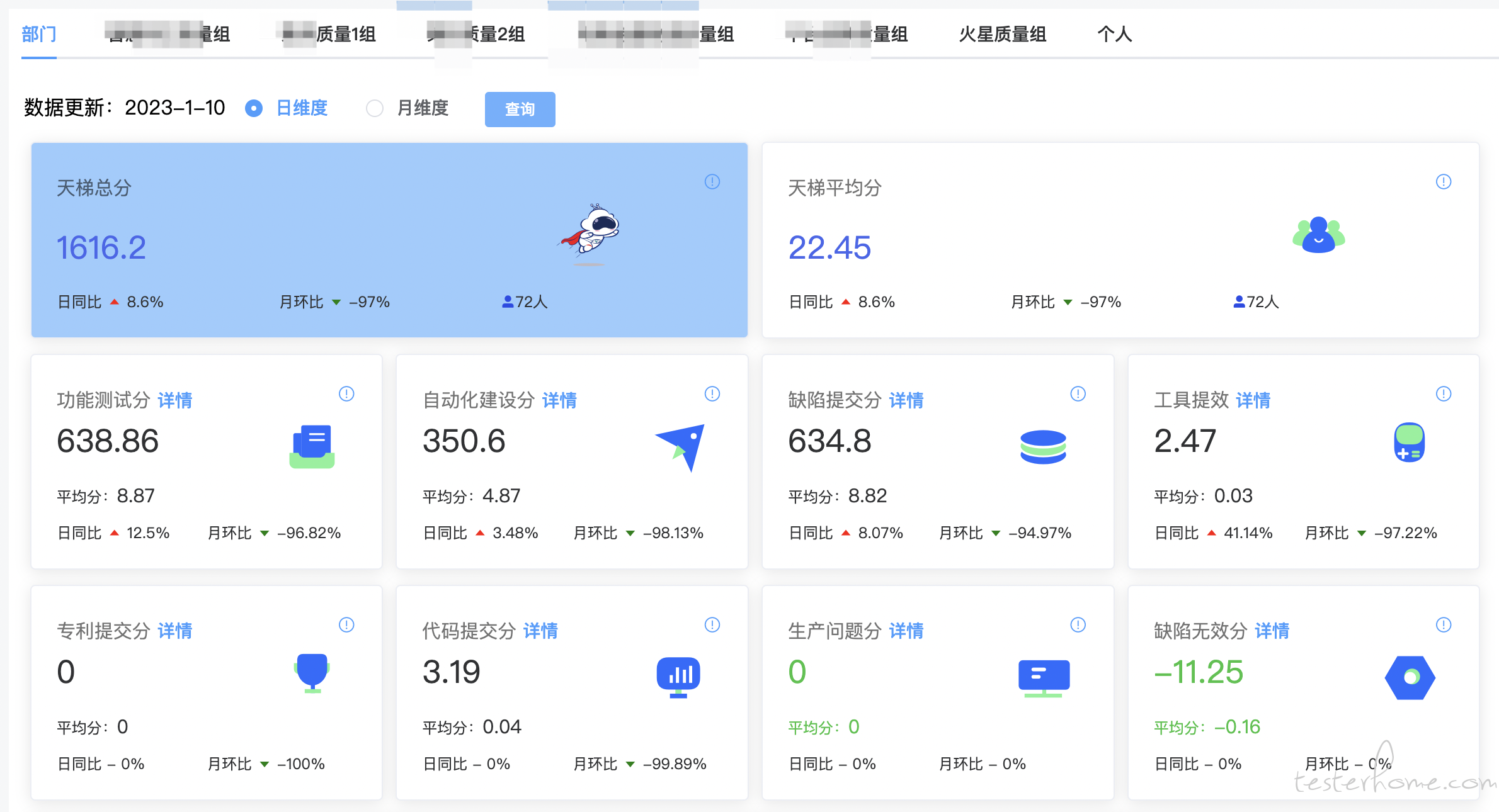

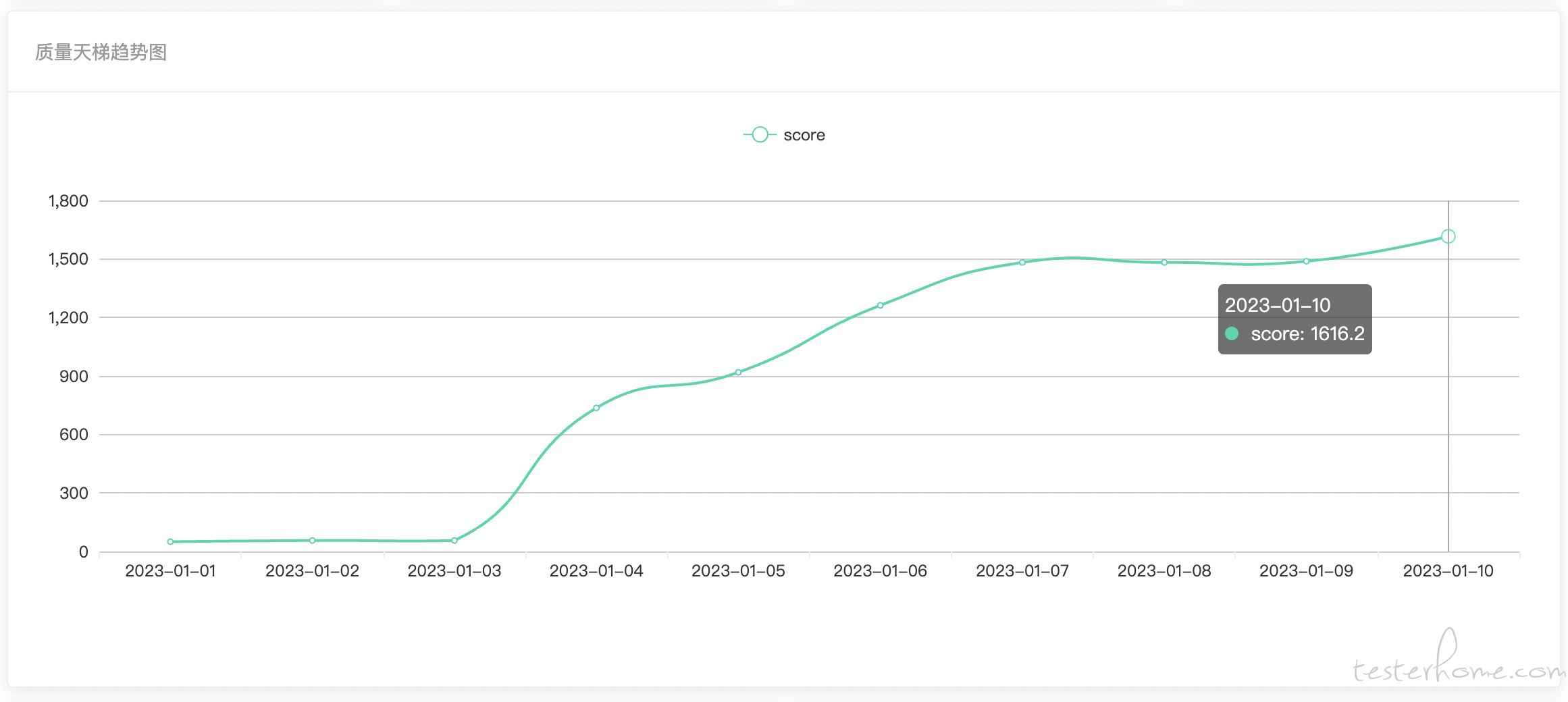

积分的计算规则按照个数与阶梯系数进行加权,有加分、有减分,即可得到天梯总分;以 T+1 的形式用 job 产出每日分数,可以观测到部门、团队、个人的每日趋势;积分在每年 1 月 1 日清零重新积分

效果展示

(由于 1 月 1 日积分清零,所以整体分数偏低):

结果展示

那天梯积分对于部门目标、团队目标到底有没有指引作用呢?

举个例子:去年部门的年度目标(专业线)是想要拿到自动化建设的结果,希望建设一批稳定的可用于回归的自动化用例(OKR 目标 500 个稳定用例);为了拿到这个结果,经过 TL 层商定,暂时把 Q4 的自动化工厂(稳定用例)系数调高 3 倍,调动了同学们的积极性,从年底拉取的数据来看,部门总共建设了 7500+ 条自动化用例,其中 4700+ 条进入了自动化工厂,拿到超目标 9 倍的结果

而今年(2023 年)我们将向自动化工厂的应用方向进行引导,会把免测贡献、自动化创建 bug、生产业务可用监控(持续跑自动化)、DevOps 质量门禁保障 等等纳入工厂应用且调高系数,期望拿到结果

思考复盘

天梯积分体系在部门跑了快半年了,零零散散收到同学们的一些建议和看法,我们也发现了部分同学在故意造指标刷分的情况出现(送他个 D,哈哈),但从整体来看,磨合的还算成功;

天梯无法收集到团队成员的所有产出,特别是高职级的同学,比如沟通协作管理的输出无法被量化;所以天梯积分对于绩效考核而言,仅做数据的重要参考而不是最终的绩效排名。

在 2023 年,我们会继续增加天梯积分的指标:比如需求评审问题发现数、CR 问题发现数,期望通过这两个指标引导小伙伴们进行质量能力左移;根据 2022 年积分分布对部分指标进行微调,希望这个体系能够越跑越合理,对过程和目标有更清晰的把控。

最后,希望通过这篇介绍能够给读者带来一些思路,也欢迎大家讨论拍砖给建议。