-

Boomer 实战压测 mqtt,2w 并发轻松实现 at 2021年09月02日

tps 的时间统计,在代码中有体现,是单个请求维度的。

locust 没有 tps 的概念,是 rps。

另外本次压测最关注的点是消息是否有丢失,和最大并发量。至于响应时间,并不是最重要的。 -

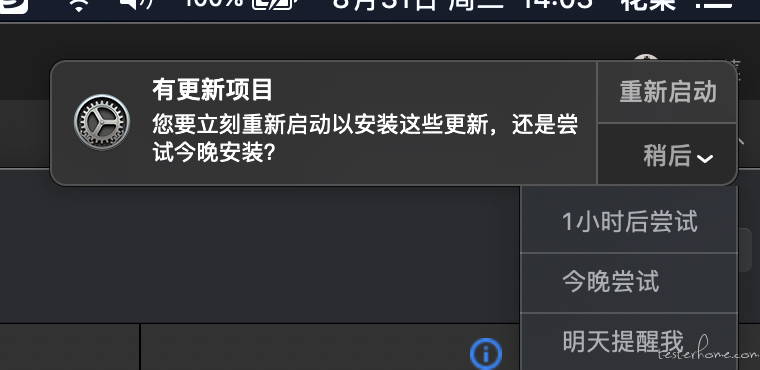

相对可以长期使用的阻止 ios 自动升级方法 at 2021年08月31日

每天都有这个弹窗,我明明已经取消了自动更新。

-

相对可以长期使用的阻止 ios 自动升级方法 at 2021年08月26日

有 Mac 阻止升级提示吗?

现在是 10.15.7,不想升级 bigsur,但又天天提醒,挺烦的。 -

【腾讯急招:高级测试专家/工程师,base 深圳/北京/广州/成都】 at 2021年08月16日

-

测试平台打通 YAPI 和 Swagger,定时同步接口信息 at 2021年08月11日

不支持。

但我想,YAPI 的用例集已经一个成熟的用例,它应该学会自动跑过来才行。 -

大家有什么要吐槽测开或者称赞测开的?欢迎大家来灌水! at 2021年08月05日

说说我做的吧

- 目前测试组有二十多个人,日活大概 2/3 的样子。因为有部分是硬件童鞋,用不上,平台主要是 HTTP 接口测试。

- 收益最明显的是那种没有界面,纯接口的项目,有个新项目,近 300 个接口。没用平台之前,每次回归要用 3h 左右,在 postman 一个个发送。用了平台后,回归就 1min,时间大大缩短。

- 其次就是造数据。在大数据实时计算过程中,都是依赖发送 kafka 来生成数据,写 redis 来做基础信息,最后断言就靠消费 kafka 和读 redis。通过测试平台配合数据工厂(提供各种 http 造数接口),可以非常方便的完成这些工作。重点是界面化,比脚本的可读性高很多。并且测试和开发都能用,一个人写完,其他人就能直接使用。不像脚本那样,测试童鞋写好了,开发童鞋想借用一下,结果发现并没有 python 环境,运行不了。

- 打通 YAPI,快速编写接口自动化。因为所有请求相关的参数都已经自动生成,包括登录。支持一个用例在多环境运行,且无需要做任何用例改动,通过切换配置实现。

- 打通 Gitlab-CI,构建就自动跑用例,且支持不同环境对应不同任务。

- 历史数据持久化,可以统计出各种各样维度的数据,这对于写 PPT 很有帮助,嘻嘻

-

接口测试如何实现重复执行还能保持结果一致 at 2021年08月01日

自动化产生的数据是要清理,但立刻清理的做法我认为不妥。定期清理可能会更好。

-

接口测试如何实现重复执行还能保持结果一致 at 2021年07月30日

新数据我觉得不算偏门,我们也是这么做。

teardown 删除我觉得并不是很好,不利于排查问题。 -

测试开发进阶:一文教你从 0 到 1 搞懂大数据测试! at 2021年07月12日

好东西,还差一个 Flink

-

postman 介绍 at 2021年07月03日

可以讲一下 postman 的 mock

-

坎坷的 2020 年 at 2021年06月22日

懂大数据常用的组件 hbase hive kafka es redis 这些就差不多啦,再高级的就是理解 Flink Spark 这些程序原理,遇到问题能够看代码定位,再再高级可能就是对 Flink 算子进行分析,提出优化建议等等

-

坎坷的 2020 年 at 2021年06月21日

大数据可以分为两种,实时计算和离线计算,你用到这两个组件是大数据很常用的。

具体算不算,我也不知道怎么定义比较好。 -

学习下 MQ at 2021年06月17日

不一致性真的是生产者生产了消息,但是由于一些原因,比如说网络波动,导致消费者消费不到吗,也就说消息丢失了?

如果是这样的话,拿 kafka 举例,生产者发送消息到 Brooker,可以设置等待所有副本都全部确认了,才认为是消息发送成功。这样就算是 master 挂掉,有副本的保障,也不会出现丢失消息。最后消费者也就能正常的消费到消息。 -

Seldom 2.0 - 让接口自动化测试更简单 at 2021年06月16日

前置和后置有例子吗~~

-

邀请码功能全面开放! at 2021年06月10日

我几乎天天都有登录耶,还不够活跃呀

-

邀请码功能全面开放! at 2021年06月10日

怎么样才能成为高级会员

-

一个 yaml 中用例中读取其他用例依赖实现方法的问题 at 2021年06月08日

可以参考 httprunner 的实现

先遍历所有的 step,把变量和函数全部提取出来,去 build_in 里面匹配,

然后运行的时候,再维护一个 run_time_varable_function 的映射 -

大佬辛苦了!

-

dubbo 接口转换成 http 便捷请求 - 基于 fastapi at 2021年05月28日

可能还有其他服务依赖这个 dubbo 服务,不能随便切换协议。

我也是几个月前也做了一个 http 转 dubbo 的。 -

测试平台 - 集成 Gitlab-CI at 2021年05月28日

运维管理,测试负责把 Gitlab-CI 和测试平台打通,测试是流水线中的一个 stage。

-

测试平台 - 集成 Gitlab-CI at 2021年05月28日

是的,取代 Jenkins。

我们还没完全自动化,上生产还是运维来处理。dev 和 qa 可以自动部署,目前还没遇到什么问题,用起来挺方便的。 -

测试平台 - 集成 Gitlab-CI at 2021年05月27日

知道就知道吧

-

测试平台 - 集成 Gitlab-CI at 2021年05月27日

-

Python 装饰器的变量作用域? at 2021年05月24日

感谢微信群各位大佬的回答

总结一下,在闭包中赋值引用类型的变量(例子 1),是不需要加 nolocal,因为对变量的引用不会改变。

(例子 2)对于非引用类型,重新赋值会使变量的引用改变了,相当操作局部变量。需要加上 nolcal 使查找变量的范围往上提,否则会出现找不到变量的错误。 -

SonarQube&Gitlab-CI 实现静态代码分析 at 2021年05月19日

图片挂了,格式换成 markdown