突然有个想法:禅道提 bug 完成,旁边有个 AI 修复按钮,测试人员/开发人员,判断是否需要 AI 修复,AI 自动根据你提的 bug 详情,进行项目源码修复,测试运行调试,更新到测试环境,禅道自动指派回测试人员,备注(修改源码详情,AI 生成测试用例)并通知测试人员。然后测试人员进行校验(参考 AI 测试用例)

可能需要的前提:

1.bug 描述要准确

2.简单 bug, 人为判断是否需要 AI 修复

3.开发可审核,看到修复具体 bug 和源码修改详情,可追溯。

......

单纯的一个想法!!

不现实

描述如何与代码模块对应上?

既然 AI 能修复 bug 了,为什么不让 AI 直接生成没有 bug 的代码?

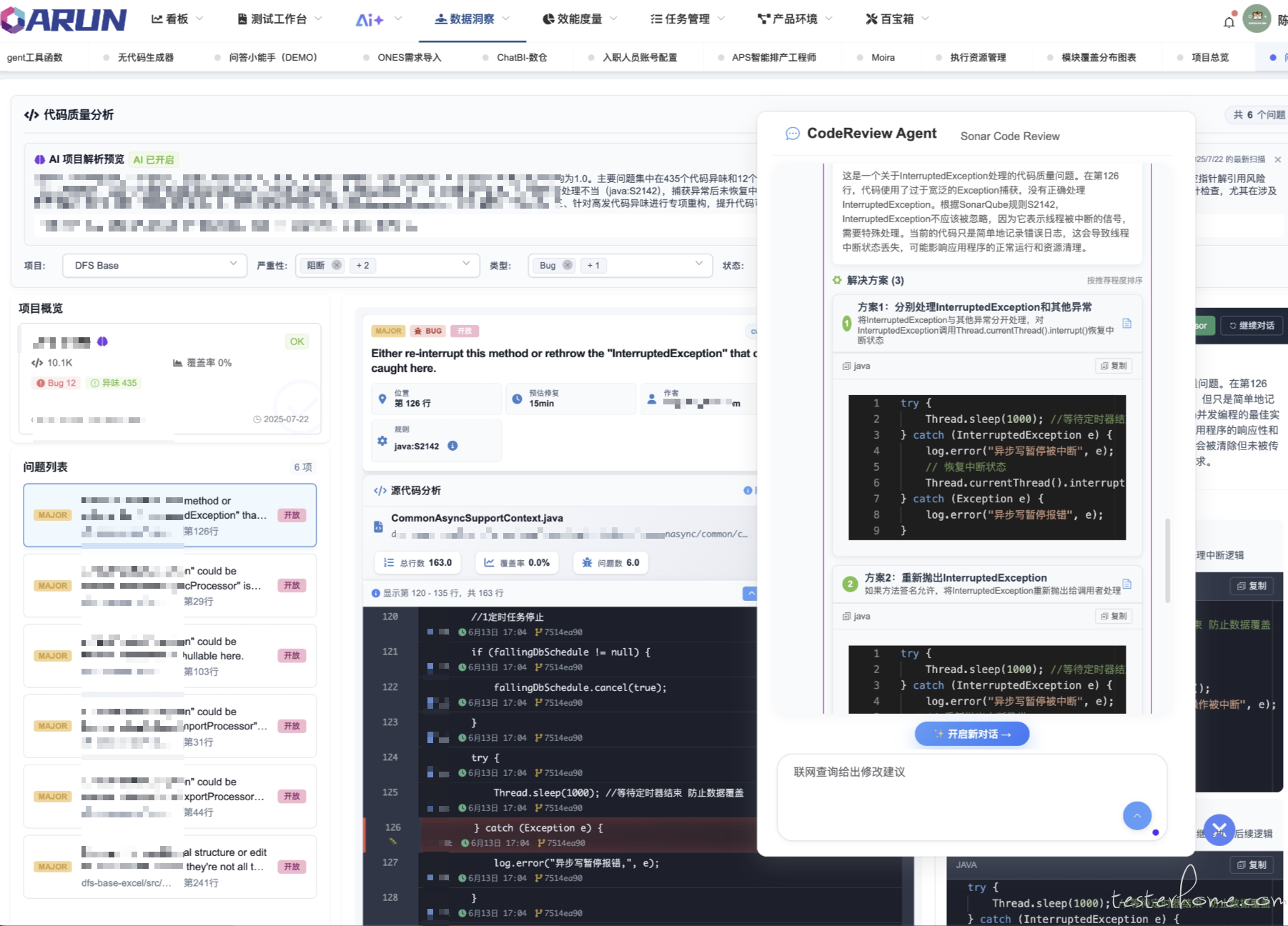

上个月基于代码/监控做的 AI 分析可以精确到行,以及提交人等 SCM 信息。后续对话解决方案/创建任务/创建 MR/ 也仅仅是几个 Tool

感觉你应该刚接触工作不久

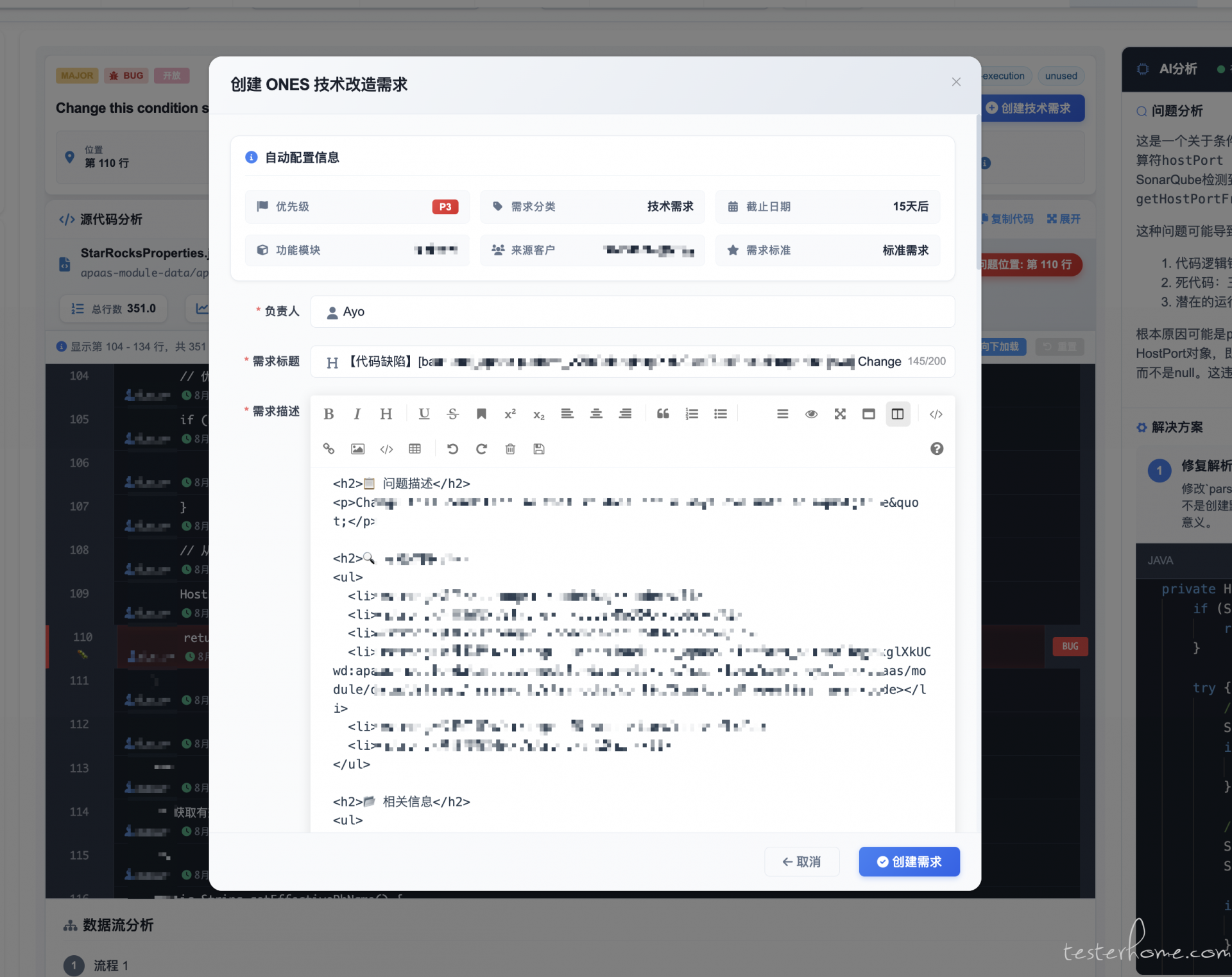

1.根据问题单编号,自动获取问题单信息,AI 分析之后生成修改意见和代码,目前已经可以实现。

2.代码提交、合并这块还是要谨慎的,当前 AI 介入不现实。

3.自动化构建打包、自动化部署、自动化测试这套流水线还是比较成熟的,暂时无需 AI 介入。

感觉可以直接产品经理对接 AI,跳过开发、测试,单纯的一个想法!

跟业务强相关的代码逻辑,AI 没有判断标准;不跟业务强相关的代码,用 AI 做辅助 CR

基于业务开发的逻辑,很难脱离业务去修改优化的

很理想的一个功能,对测试的要求比较高

bug 需要写明:

- 提交 bug 需要指明后端/前端项目名称和分支名称。(用户定位项目和开发分支)

- 将 error 日志提交到 bug 中(用于定位类和代码行)

- 需要明确写出期望逻辑/样式(用作 ai 修改代码的实现,不然 ai 容易瞎改)

痛点:

- AI 如何分项目/分支拉取代码? 目前知道 cursor 可以打开项目,拉取分支后通过对话让其修改 bug。

- 拉代码、修改、提交代码、发布整套流程走 ai,怎么保持稳定,存在一步有问题就全局失败。

AI 自动修复缺陷,这个在大模型时代之前已经很多地方都有探索了,不过没有什么拿得出手的实践。大模型时代应该能做得更好。

AI 自动验证 bug,最近开始陆陆续续听到有业务团队在探索,主要是又大模型之后,面向自然语言的图文理解简单很多,比如移动端只要解决 “点击驱动” 问题,就能开始尝试搞这类课题。

剩余的什么更新测试环境、通知,这些用不上 AI,基础的工程开发就能解决。

AI 调试也是一个新课题,不过目前没关注到身边有人在搞,部分场景下和 AI 自动验证 bug 有一定重叠。

其实就是一个 ReAct Agent 自主规划你给他的一些 Tool , 例如读写文件/执行命令啥的, 最后通过 Tool 或者 Prompt 约定输出就好啦。

我选择提高我的手速