本帖已被设为精华帖!

TesterHome_hot_words_analyse

社区精华帖的热词分析(菜鸟),写了个脚本,和大家分享。

源代码

流程

主要调用网站自带 api(地址)。

btw: 获取精华帖列表: /topics.json (),接口返回分页有问题,放弃用这个接口。

爬取页面,取得帖子总数 (get_topics_number)

调用 requests 和 re,抓取帖子总数

获取 excellent 帖子 id 列表 (get_excellent_topics_id_list)

获取完整的话题内容:/topics/:id.json

https://testerhome.com/api/v3/topics/3905.json

获取完整的话题内容 (get_topics_id_content)

获取完整的话题内容:/topics/:id.json

https://testerhome.com/api/v3/topics/3905.json

获取某个话题的回帖列表 ()

获取某个话题的回帖列表: /topics/:id/replies.json

https://testerhome.com/api#route-/topics/3905/replies.json

数据清洗 (filter_html)

- 小尾巴

- 处理换行

- HTML 标签

- url 链接

- 转义字符

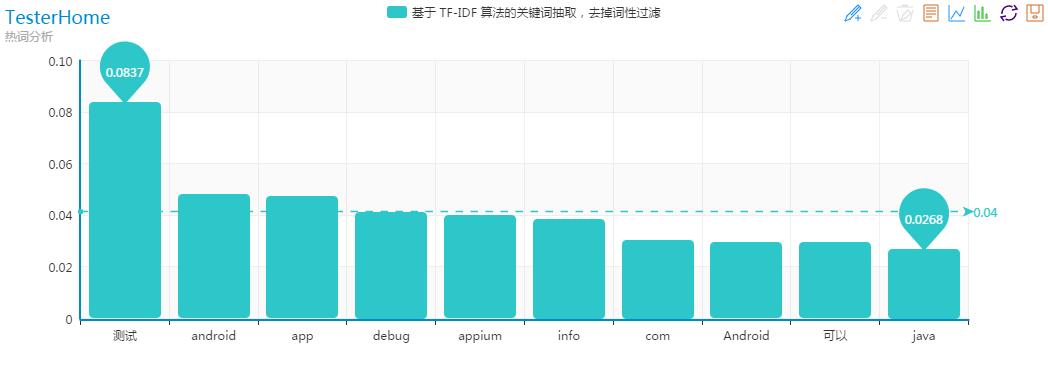

调用 jieba,基于 TF-IDF 算法的关键词抽取,去掉词性过滤

jieba.analyse.extract_tags(topics_all_contents, topK=20, withWeight=True, allowPOS=())

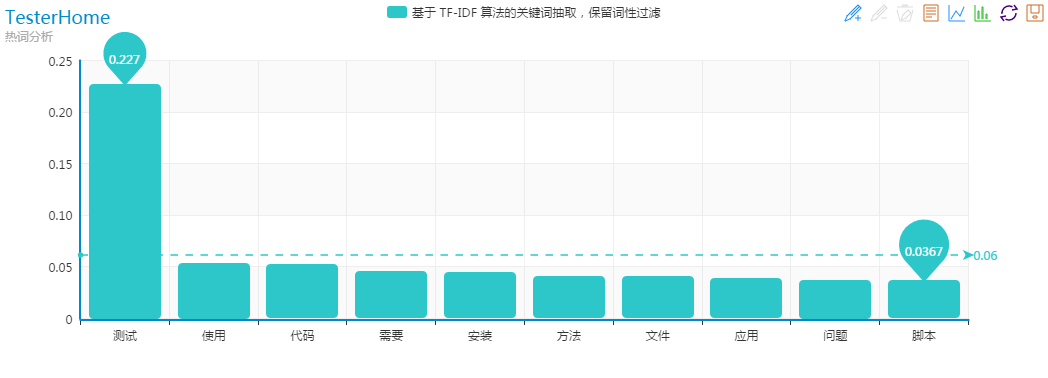

调用 jieba,基于 TF-IDF 算法的关键词抽取,保留词性过滤

jieba.analyse.extract_tags(topics_all_contents, topK=20, withWeight=True, allowPOS=('ns', 'n', 'vn', 'v'))

调用 jieba,基于 TextRank 算法的关键词抽取

jieba.analyse.textrank(topics_all_contents, topK=20, withWeight=True, allowPOS=('ns', 'n', 'vn', 'v'))

需要改进的点

- 增加并发,提高抓取时间

- 抓取的帖子内容保存在本地,只抓取新增的帖子,减少对服务器的调用。

- 对比抓取时间和帖子修改时间,进行增量智能抓取。

热词分析结果

基于 TF-IDF 算法的关键词抽取,去掉词性过滤

基于 TF-IDF 算法的关键词抽取,保留词性过滤

基于 TextRank 算法的关键词抽取

如果觉得我的文章对您有用,请随意打赏。您的支持将鼓励我继续创作!