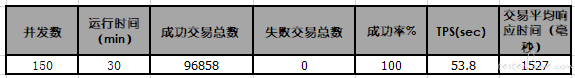

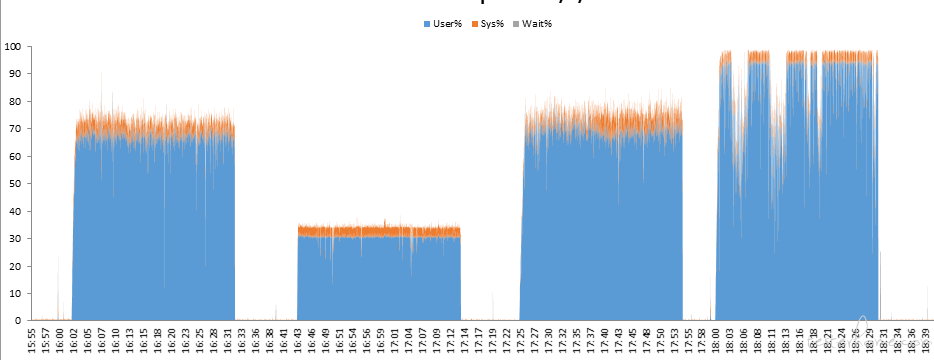

1、一共有三台服务器,均为独立的服务器,一台 nginx 采用权重 weight=1,weight=1 的方式分别发送到两台 tomcat 服务器;

现在发起压力,tomcat1 和 tomcat2 的服务器受到的压力不一致,CPU%,DISK,MEM% 都有差距。

2、前三个的场景 CPU% 看起来都较为正常且无较大波动,只有第四个场景会出现较大的波动且 tomcat1 和 tomcat2 CPU% 有互补的现象(即 tomcat1 有压力的时候,tomcat2 不会有较大的负载压力)

疑问:为什么只有场景四会出现这种现状,其他三个场景都不会出现互补的情况。

(注,图一为 tomcat1 服务器,图 2 为 tomcat2 服务器)

3、补上一些细节图

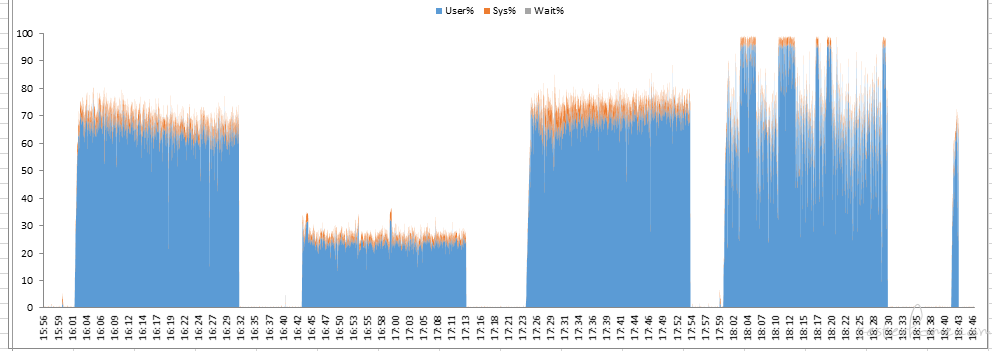

这是 TPS 图:

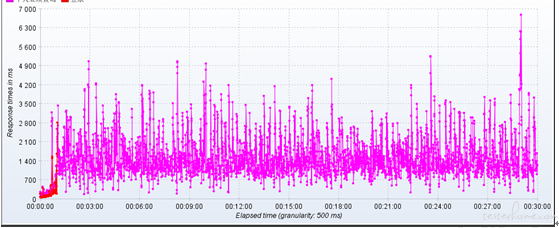

这是响应时间图:

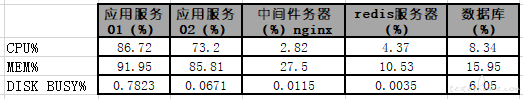

这是各服务资源监控:

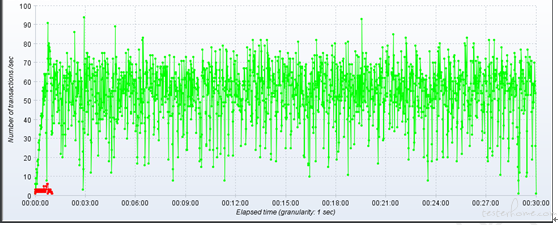

这是简陋聚合报告: