性能常识 压测服务达到瓶颈以后,继续增加并发用户数,并发请求不再增加吗?

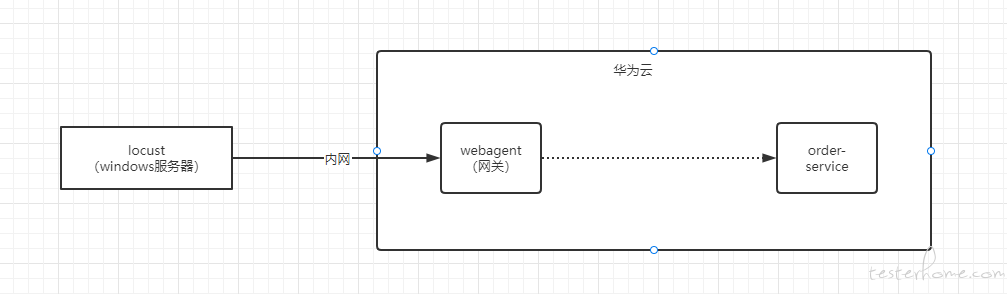

小弟负责一个功能的压测,压测简图如上。

测试过程是,通过 locust 工具,制造大量请求,经过外网网关,然后对 order-service 施加压力,目的是想得到订单查询的性能基准。

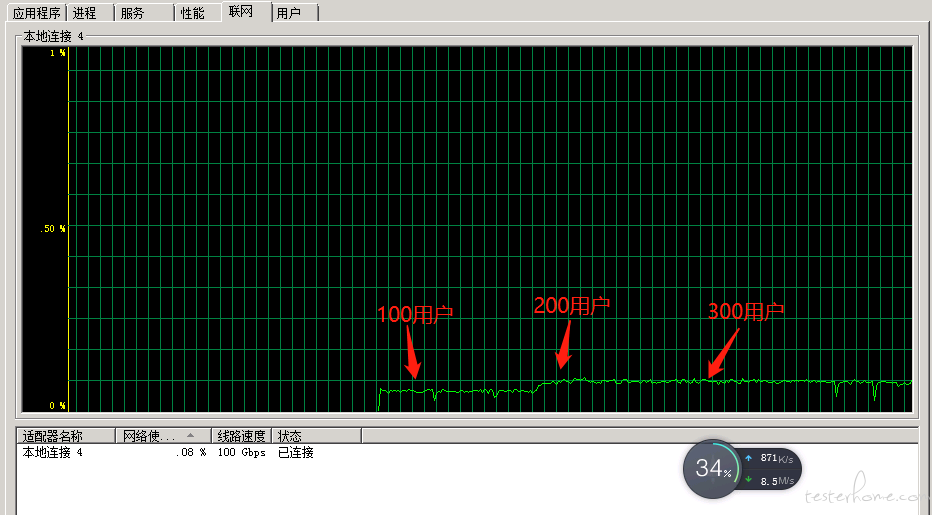

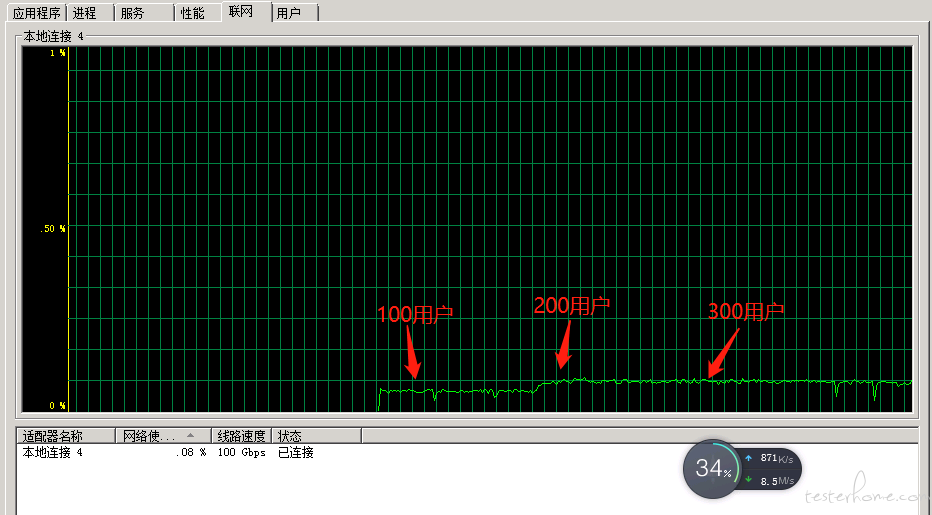

压测结果如下图,当用户达到节点 1 应该就是瓶颈了。

关键是,当用户上升到节点 2 的时候,本来预期压力机应该会发出请求量进一步增加,然后系统出现大量报错。但是用流量统计查看了压力端的网络流入和流出,发现并没有明显的增加。

所以想问下大家,为什么增加用户数,发出的请求却不变呢 ? 多谢

ps: locust 压力机也在华为服务器,跟运维确认了,没有网络限制。

流量监控情况: