-

后端发布后,有部分服务器未发布成功,这个是什么原因导致的? at June 01, 2023

这问题比中东局势的问题还要大

-

突然不想提 bug 了。。 at June 01, 2023

不光测试行业,其他行业也可能存在这种情况。楼主这心态不利于个人发展呀

-

测开专职来搞接口测试是不是太浪费了 at May 26, 2023

自动化框架?写测试平台?搞代码覆盖率?

能搞定一个就非常不错了吧,即使都搞定,还有精准化测试、AI 自动化测试。。。 -

每个月需要进行技术分享,导致现在有点迷茫 at May 26, 2023

只有罚没有奖?这么高频率的分享,除非给出准备的时间,不然还是蛮有负担的。再有,请客 300 的标准。。。我辛苦上班才赚几个钱。目的是好的,只是这个形式值得商榷

-

每个月需要进行技术分享,导致现在有点迷茫 at May 24, 2023

每月一次,还只能是技术。。。这频率确实有点高。

1、是不是可以把整块的技术拆成点,也能借此机会把细节想明白;

2、不光可以分享,也可以问,痛点或者是项目应用方面的问题,也可以提出来,引导一下领导去推动解决; -

jacoco dump 基于 k8s 的实现 at May 16, 2023

然后我们从 pod 读取文件/app/jacoco.exec 写入我们的报告生成服务即可

请问大佬从 pod 读取 exec 文件是如何实现的?

-

关于接口自动化请教一些问题 at April 24, 2023

1、建议日构建,发布构建太频繁不建议使用;

2、出现执行失败要分析,环境问题、数据问题、用例问题、出现 bug;大部分接口自动化发现的问题都是误修改引发的,比如修改 A 接口,影响了 B 接口,导致 B 接口用例执行失败;

3、根据研发流程来,如果有较详细的接口文档,可以修后接口用例后再执行;不然就是执行失败后再针对性调整; -

null at March 20, 2023

提出这种问题,看来楼主还没遭受过社会的毒打。千万不要自作主张动生产数据,无论什么目的,即使领导让你动,也要获取多方确认(领导、运维、业务等)后再实施。不然出了问题锅只能自己背,小测试的抗风险能力差,如果遇到这种问题,基本就是走人了,慎重!

-

最近在做公司的中间件测试,想请教下大佬们 at March 20, 2023

除了正常场景,有些异常场景是否也要覆盖,比如 读取的文件不存在、文件格式不符合要求、大文件、空文件等

-

pytest+yaml 文件,怎么在 yaml 文件中引用变量? at March 20, 2023

收到,谢谢

-

pytest+yaml 文件,怎么在 yaml 文件中引用变量? at March 13, 2023

有个疑问,这种替换方式只适合字符串吗?比如有个字段 age=18 是整形,替换后是字符串

-

【求助】pytest 自定义命令行参数不生效的问题 at March 07, 2023

pytest.main() 写在最外层的 conftest.py 即可

-

jmeter 和 postman 发送接口的响应时间不同 at February 22, 2023

工具机制不同,请求数据不同,网络状态不同,硬件条件不同。。。很多原因都会造成这个现象。具体原因具体分析吧,最好直接看 server 端的日志

-

pytest 打印用例结果问题 at February 22, 2023

pycharm 可以看到 pytest 的版本,全局的可以用 pip show pytest 命令看下

-

pytest 打印用例结果问题 at February 22, 2023

-

最近要转正,打算送同事礼物,想了半天,突然想到还是送一本关于测试的书吧,有人推荐吗,最好是比较新的 at February 09, 2023

千万别送书,尤其是本职工作相关的。奶茶点心不香吗,这么想不开

-

虽迟但到,我的 2022 年终总结 at February 01, 2023

楼主优秀

-

6 年测试经验还停留在功能测试!该何去何从? at January 17, 2023

测试技术提升只是一方面,也可以多学习质量管理方面的内容,比如推动更好的测试流程落地,甚至是项目质量流程。不要太焦虑,今天比昨天好就算进步

-

请问在 ui 自动化中,如何解决图形验证码类的问题,求个解决问题的思路或者方向 at December 30, 2022

首选 redis,其次 ddddocr 识别

-

接口测试 - 从 0 不到 1 的心路历程 at December 09, 2022

1、对应用例后面可以加字段,作为用例级的前/后置条件;

2、再加个单独的 sheet 页,维护项目级的前/后置;

3、登录也可以作为一条普通用例写在 Excel 中,无非是要处理 cookie,token 之类的 (框架要处理大量的项目兼容性)

本意是使用者无需接触,只需要关注用例的编写和维护,其他全部交给框架处理 -

求助:自动化工具 katalon 相比于自己手写框架那个方案更好一些? at December 08, 2022

要看公司的情况,权衡自研还是采购

1、katalon 开始收费,价格还不便宜,并且相较于其他商用工具优势没那么明显

2、有没有自研能力,自研出来的框架/工具能发达到预期 -

接口测试 - 从 0 不到 1 的心路历程 at November 23, 2022

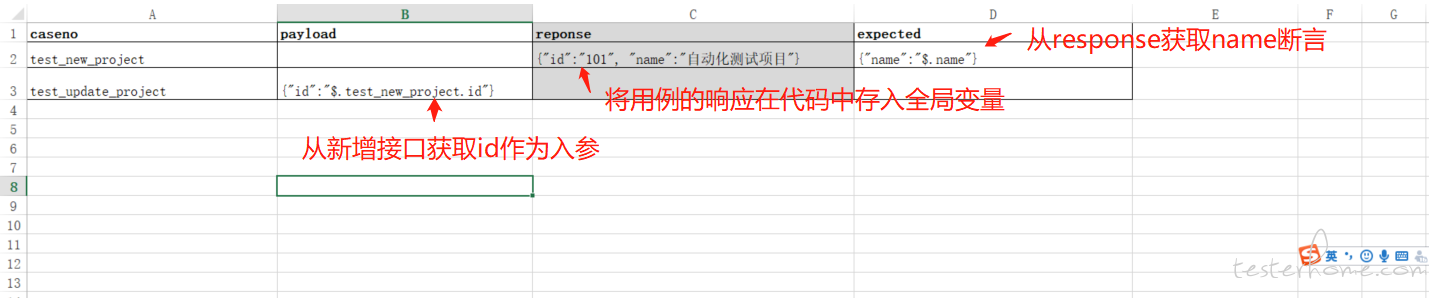

问题 1:大概是这么个过程:

问题 2:

接口自动化框架,支持数据库断言是必要的,与环境无关 -

接口测试 - 从 0 不到 1 的心路历程 at November 22, 2022

问题 1:可以考虑将所有 response 存储一下,用的时候使用jsonpath获取一下

问题 2:数据库查询时传入参数(类似于问题 1 使用 jsonpath 方式获取到的 id)

问题 3:建议将用例和测试结果解耦,Excel 只用来维护用例,测试报告使用 allure 插件;

用例和报告解耦有几个好处:

1、用例多了后 Excel 会非常庞大,写数据比较慢还可能造成文件损坏;

2、allure 内容详尽,样式美观,可以作为标准的测试报告进行输出。可以多看看HttpRunner的实现方式,是非常优秀的

同样是在 0 到 1 的过程中,共同进步 -

allure 如何动态配置用例标题 at November 18, 2022

试试 allure 动态生成功能:allure.dynamic.title(casename)

-

大家开会的时候,有没有发现很多人在看手机~ at November 17, 2022

现在的问题是,会议组织者怕遗漏或者担责任,拉会议时不管是否想干的全都拉上,导致大家参会越来越多,效率确越来越差。