-

测试参与 CodeReview 主要关注哪些方面 at 2023年05月19日

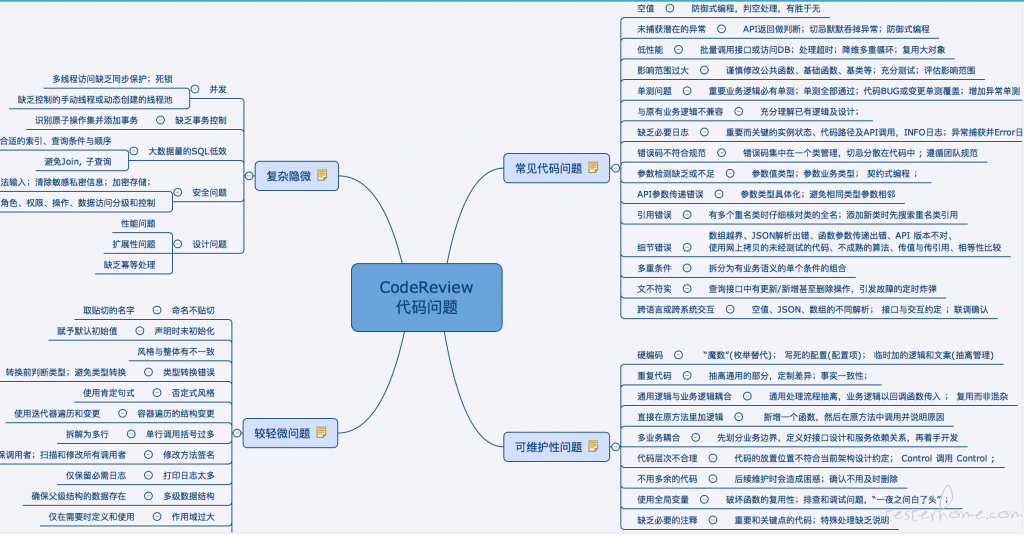

站在测试的角度,重要的还是对业务足够熟悉,更多的从业务出发去思考。最后贴一张图

-

Go 实现 json 格式定义 http 协议压测脚本 at 2022年07月14日

娃刚出生,比较忙,以后有机会哈

-

大厂面试总结 at 2021年07月06日

很优秀,向飞哥学习

-

使用插桩技术解决慢查询测试问题 at 2021年05月25日

-

关于 golang 里,grpc 接口测试。大佬们是如何进行测试的 at 2021年05月20日

你只需要依赖你测试的接口的接口描述,不需要管它的依赖吧。另外建议把这些描述类文件都放到一个公共仓库统一管理

-

关于 golang 里,grpc 接口测试。大佬们是如何进行测试的 at 2021年05月20日

有新增接口,更新下接口描述和 PB,就可以写新接口的测试啦

-

关于 golang 里,grpc 接口测试。大佬们是如何进行测试的 at 2021年05月20日

我理解有两种方式:

1、自己实现 GRPC client,这种需要自己根据 ip:port 调用 dial 连接这些方法,然后构造请求对象去调用具体的 grpc 方法,这种方式比较通用。可以参考:https://github.com/myzhan/boomer/blob/master/examples/grpc/main.go

2、看看自己项目其他应用是如何调用被测应用的 grpc 接口的,比如我们项目是使用 microkit 的,它的 rpc 接口通过 pb 定义,并生成.pb.go,.microkit.go 文件,里面就有 NewClient 方法,拿到 client 后直接用来发起请求就可以了。client := livetech.NewClient() req := &livetech.GetQualityListRequest{ } resp, err := client.GetQualityList(context.Background(), req).pb.go,.microkit.go 文件 可以理解成是 rpc 服务的接口说明,用就是了。

-

Go 实现 json 格式定义 http 协议压测脚本 at 2021年04月28日

最好能把 worker(slave) 那边的图贴出来,你是运行 go 版本的吧,默认是找本地 5557 端口的 master,你可以看看端口情况

-

AppCrawler 使用中遇到问题的问题及解决 at 2021年04月13日

感谢分享

-

测试分析之原创面试题分享 at 2021年03月29日

今年以来我也开始担任面试官了,你这种循序渐进,开放式的面试方式很棒,学习到了,感谢分享~

-

使用插桩技术解决慢查询测试问题 at 2021年03月25日

感觉真的好奇妙啊,我们对这个问题的解决思路竟然如此的相似,两年前我做的一个开源项目就是用这个思路,一直没推广,换公司后用 go 比较多了,已经好久没更新了。 https://github.com/bugVanisher/no-slow-query

-

Mac 版微信 3.0 可以看朋友圈了 at 2021年03月12日

哈哈哈

-

各位同行 大佬想问下你门知不知道怎么测试多人的音视频的性能测试呢 at 2021年02月22日

webrtc 性能测试可以参考下面两篇文章,如果你的业务可以直接在 pc 浏览器上发起会话(或者包一层 web sdk),那还是比较容易做的。

https://www.cnblogs.com/chenkx6/p/13639629.html

https://blog.piasy.com/2020/03/28/KITE/index.html我所在的 webrtc 业务有 web、安卓、iOS sdk,最近我使用 web sdk 模拟多房间在线会话,为压力测试提供了可能,不过相当耗费资源

-

Go 实现 json 格式定义 http 协议压测脚本 at 2021年02月06日

哈哈,我将持续更新,欢迎交流探讨

-

坎坷的 2020 年 at 2021年01月03日

不知不觉我工作也六年半了

,时间好快,加油加油

-

深入浅出 Locust 实现 at 2020年10月16日

麻烦看完我的系列文章,相信你会有自己的答案

-

如何提高 Locust 的压测性能 at 2020年08月05日

不好意思,最近没怎么上来。

对于你的问题,连接池在纯产生压力的场景确实是没什么必要的,因为压力机就是为了在最短的时间产生最多的请求,这个在多协程共用单连接的时候达到顶峰。连接池的使用场景是在低频的请求序列时保持连接,减少反复连接 - 断开的开销。是的,文章里我应该说明一下,真实的场景是内部应用之间维护连接池,而不会只创建一个连接,使用连接池是因为我想保持跟 grpc 框架一致。这里我有一个问题,你是怎么理解并发用户数和连接数之间的关系的?在 http 和 grpc 的场景下,应该是不一样的 -

Burp Suite 拦截手机数据包还未进行释放,为什么还能进行请求,释放数据后没反应? at 2020年07月29日

你是看到 history 有多个请求吧?这种情况一般是客户端有超时重试机制,一旦重试了,burp suite 再释放它已经没用了,因为客户端已经丢弃。

-

如何提高 Locust 的压测性能 at 2020年07月23日

用得顺手都是好工具

-

深入浅出 Locust 实现 at 2020年06月19日

嗯嗯,分布式模式下每个 slave(worker)都是独立的,如果你的文件是一样的那就会重复。文件中的数据是否一样,取决于你的需求场景啊,如果必须保证全局唯一,方法是有很多的,我提供一个比较『骚』的思路:

整体思想就是每个 slave 在压测前去获取一批全局唯一的数据

1、利用 init 事件钩子在 master 注册一个新的 API,负责分发唯一数据。

2、同样利用钩子在 slave 压测前去 master 获取并初始化全局唯一数据,然后压测。 -

深入浅出 Locust 实现 at 2020年06月18日

纯 Python 压测会給自己带来很多麻烦,不建议在实际业务中这么做哈,接下来的两篇文章感觉是给我自己挖坑了

,我尽量写出点干货吧,哈哈

-

深入浅出 Locust 实现 at 2020年06月18日

我的博客分了几篇来写,这里我做了整合,没有必要一篇篇来了,一次看个过瘾吧,,

-

深入浅出 Locust 实现 at 2020年06月18日

社区的第一篇文章,除了有点长,还是有诚意的。。。

-

深入浅出 Locust 实现 at 2020年06月18日

哈哈,感觉是挖了个坑給自己