-

[深圳] 大疆创新 (互联网事业部) 春季专场招聘会 (3.18) at 2017年03月11日

不过比较贵,哈哈

-

[深圳] 大疆创新 (互联网事业部) 春季专场招聘会 (3.18) at 2017年03月11日

可以来试试嘛,周六一天搞定

-

[深圳] 大疆创新 (互联网事业部) 春季专场招聘会 (3.18) at 2017年03月10日

社招,不硬性要求学历,主要还是自身能力吧

-

无参与不推广 at 2017年03月10日

对于个人博客作者来说,将文章贴过来以后,加上博客地址,也算合情合理的吧

-

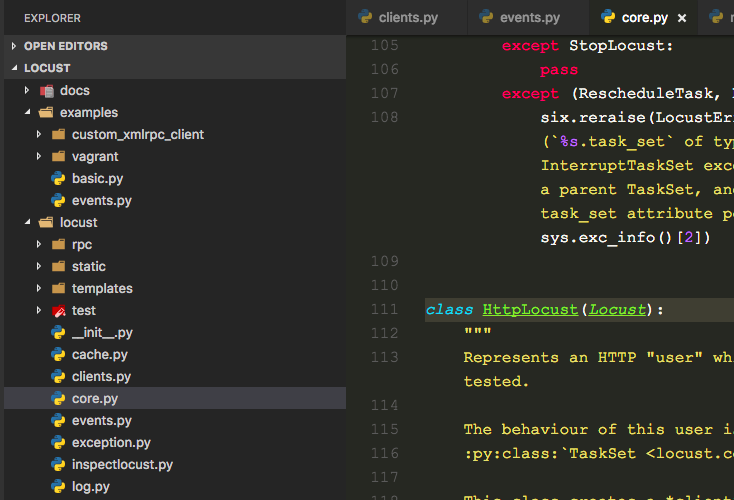

深入浅出开源性能测试工具 Locust (使用篇 2) at 2017年03月10日

-

深入浅出开源性能测试工具 Locust (使用篇 1) at 2017年03月10日

-

自动打包平台 at 2017年03月06日

原来你喜欢这样风格的

-

深入浅出开源性能测试工具 Locust (使用篇 2) at 2017年02月24日

多谢!改天我也来搞个 benchmark 测试看看

-

深入浅出开源性能测试工具 Locust (使用篇 2) at 2017年02月24日

那你是怎么确定是 locust 的结果不准,而不是 ab 呢?

-

深入浅出开源性能测试工具 Locust (使用篇 1) at 2017年02月24日

最近大疆互联网事业部在招聘测试,有兴趣的可跟我联系。欢迎推荐和自荐哈! -

深入浅出开源性能测试工具 Locust (使用篇 2) at 2017年02月23日

谢谢啦!

-

深入浅出开源性能测试工具 Locust (使用篇 2) at 2017年02月23日

你是怎么测的单机并发能力啊?可否分享下?

-

深入浅出开源性能测试工具 Locust (使用篇 2) at 2017年02月23日

你说的 8 个节点是 8 个 slave 进程的意思么?

-

深入浅出开源性能测试工具 Locust (使用篇 2) at 2017年02月23日

通过 pypi 安装的包都会滞后些,哪怕版本号相同,但是跟源码 master 分支的最新代码还是可能不一致的

-

深入浅出开源性能测试工具 Locust (使用篇 2) at 2017年02月23日

更好的方式是,直接从 github 项目源码进行安装。

$ pip install git+git://github.com/locustio/locust.git@master#egg=locustio -

深入浅出开源性能测试工具 Locust (使用篇 1) at 2017年02月23日

-

深入浅出开源性能测试工具 Locust (使用篇 1) at 2017年02月22日

全局搜索就能找到啊。

-

深入浅出开源性能测试工具 Locust (使用篇 1) at 2017年02月22日

#2 楼 @wuxixuxiaodong 还真没用过

stop_timeout,学习了 -

深入浅出开源性能测试工具 Locust (使用篇 1) at 2017年02月22日

-

[重庆] 轻推 招聘 2--3 名中高级测试工程师 at 2017年02月15日

赛迪,是北赛迪、南赛宝那个赛迪么

-

测试开发之路 (工具篇)----pytest and pytest-allure-adaptor at 2017年02月14日

赞!!

-

网站链接测试工具 xenu at 2017年02月08日

哈哈,我年前也做了一个类似的工具,放到 Jenkins 上定时检测用。https://github.com/debugtalk/WebCrawler

WebCrawler

A web crawler for testing website links validation.

Features

- running in BFS or DFS mode

- specify concurrent running workers in BFS mode

- crawl seeds can be set to more than one urls

- configure hyper links regex, including match type and ignore type

- group visited urls by HTTP status code

- flexible configuration in YAML

- send test result by mail

Usage

$ python main.py -h usage: main.py [-h] [--seeds SEEDS] [--crawl_mode CRAWL_MODE] [--max_depth MAX_DEPTH] [--max_concurrent_workers MAX_CONCURRENT_WORKERS] [--log_level LOG_LEVEL] [--build_number BUILD_NUMBER] [--mail_notification MAIL_NOTIFICATION] [--mail_config_file MAIL_CONFIG_FILE] [--smtp_host_port SMTP_HOST_PORT] [--smtp_auth_account SMTP_AUTH_ACCOUNT] [--email_recepients EMAIL_RECEPIENTS] Store automation test. optional arguments: -h, --help show this help message and exit --seeds SEEDS Specify crawl seed url(s), several urls can be specified with pipe; if auth needed, seeds can be specified like 'url1,user1:pwd1|url2,user2:pwd2' --crawl_mode CRAWL_MODE Specify crawl mode, BFS or DFS. --max_depth MAX_DEPTH Specify max crawl depth. --max_concurrent_workers MAX_CONCURRENT_WORKERS Specify max concurrent workers number. --log_level LOG_LEVEL Specify logging level, default is DEBUG. --build_number BUILD_NUMBER Specify jenkins build number. --mail_notification MAIL_NOTIFICATION Specify whether to turn on mail notification. --mail_config_file MAIL_CONFIG_FILE Specify email configurations with YAML file. --smtp_host_port SMTP_HOST_PORT Specify email SMTP host and port. --smtp_auth_account SMTP_AUTH_ACCOUNT Specify email SMTP auth account. --email_recepients EMAIL_RECEPIENTS Specify email recepients.Examples

Crawl in BFS mode with 20 concurrent workers, and set maximum depth to 5.

$ python main.py --seeds http://debugtalk.com --crawl_mode bfs --max_depth 5 --max_concurrent_workers 20Crawl in DFS mode, and set maximum depth to 10.

$ python main.py --seeds http://debugtalk.com --crawl_mode dfs --max_depth 10Crawl several websites in BFS mode with 20 concurrent workers, and set maximum depth to 10.

$ python main.py --seeds http://debugtalk.com,http://blog.debugtalk.com --crawl_mode bfs --max_depth 10 --max_concurrent_workers 20 -

[思寒] 2016 个人总结_未来仍可期待 at 2017年02月06日

前几天在回顾春节旅行之意法印象时,最后有一段感觉跟文中说到的 35 岁挺贴切的。

之前可能是一直处于天朝的大环境中,多多少少会变得有些功利和急躁,大至职业发展薪酬涨幅,小至绩效考核分数排名,很难做到不那么在意。但是当我在欧洲街头看到各类艺人专注于技艺表演时,在阿诺河旁看到白发老人沉浸于绘画写生时,我不禁在想,专注于自己喜爱的事情已经就足够幸福了,何必被世俗的眼光所左右,被眼前的蝇头小利所蒙蔽呢。虽说人生短暂,但是即使从现在开始,也还有好几十年的时光,足够自己折腾了。

嗯,前提是永远不要为自己设限。思寒前辈加油,向你学习!

-

TesterHome 新秀培养计划 at 2017年02月06日

Hi,我叫九毫,网络 ID

debugtalk,个人博客:http://debugtalk.com

QQ: 863919190

当前所在公司:大疆创新

工作年限:不到 6 年

技术方向:测试开发(Ruby、Python)、服务器端性能测试、移动 APP 自动化测试(iOS & Android)、Android 客户端性能测试、持续集成、接口自动化测试。 -

[深圳] DJI 大疆创新招聘测试 / 测试开发工程师 at 2017年02月04日

兄弟是哪个部门的?