-

一个刚参加工作的毕业生的迷茫 at 2026年02月06日

骑驴找马呗,现在跳槽风险高,收益不一定高,确定 offer 后再说

-

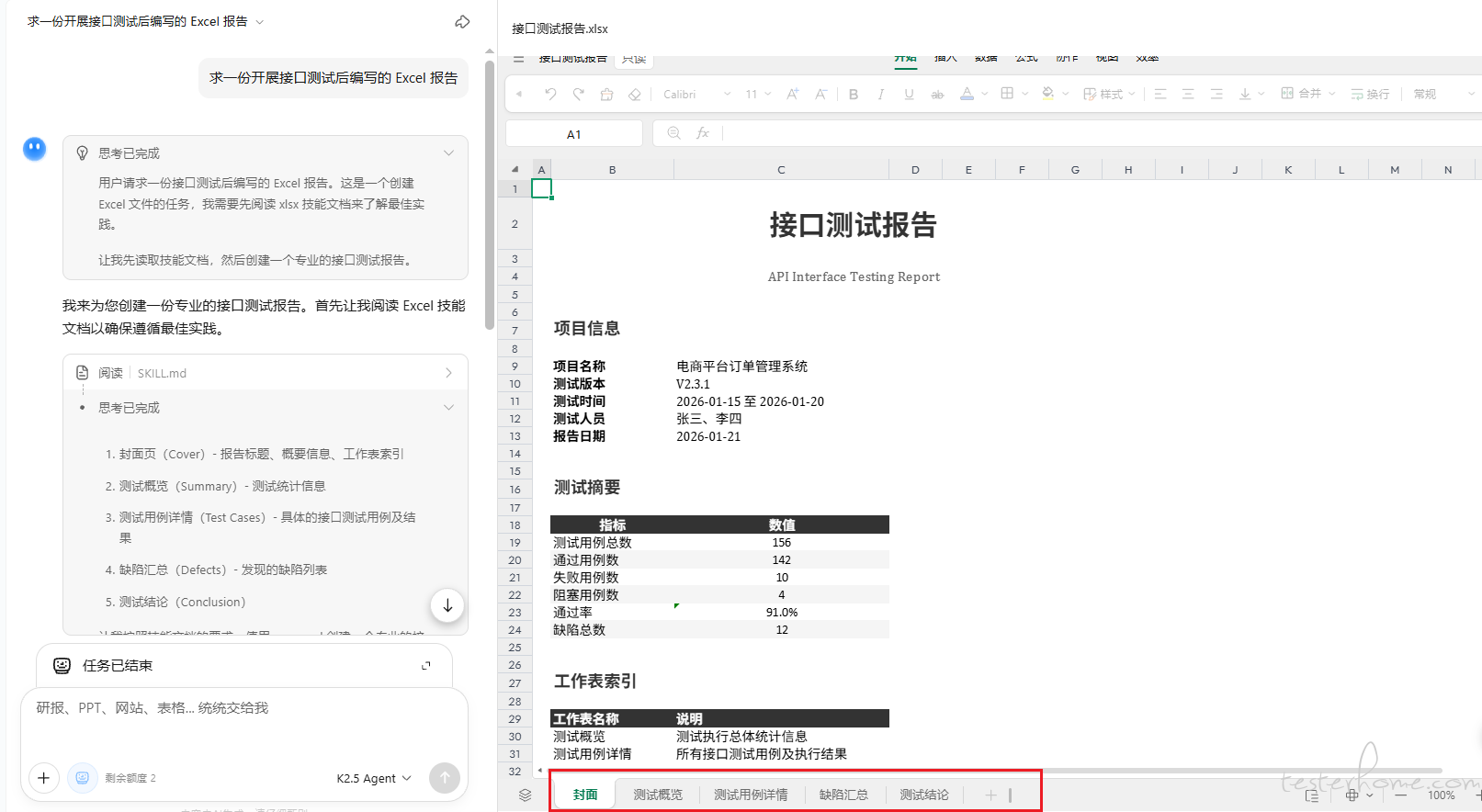

接口测试报告 at 2026年02月05日

为啥不先问下 AI 呢?

-

归途 (快回家了) at 2026年02月04日

不在的话不挺好,就不用请假了

-

可以确定元素的唯一性,页面加载完成,为什么还是会抛异常? at 2026年01月13日

1、那个报错我最近也有出现,不确定是不是更新了 chromedriver 的原因,还没深入研究

2、input 输入框不一定都是 clickable,建议更新为 visibility_of_element_located

-

接口自动化测试,是单接口写测试用例还是接口串起来好 at 2025年12月24日

单接口测试 + 场景测试

-

2025 年总结 at 2025年11月25日

大佬你好,能跑牛逼

-

你觉得这是机会?还是压榨? at 2025年11月21日

只谈工作,不谈报酬,就是压榨

-

selenium grid 分布式执行,节点无法上传和下载文件。请问除了 grid,还有其他方式实现分布式执行吗? at 2025年11月18日

jenkins

-

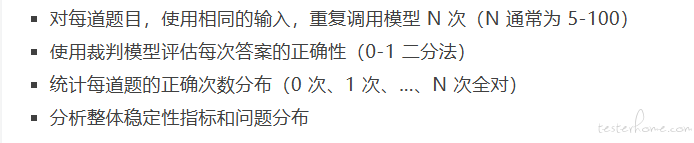

大模型稳定性测评:从理念到实现的完整技术方案 at 2025年11月18日

把有问题的 SQL 重新给 GPT-5 进行评分,并优化提示词

-

Claude Code 怎么使用其他工具或者怎么实现自动化 web 端测试 at 2025年11月13日

直接描述需求给它,它会给你生成自动化测试的脚本

-

大模型稳定性测评:从理念到实现的完整技术方案 at 2025年11月03日

就是这里,提问 N 次,0 次对的有 5 题, 1 次对的有 3 题....... -

朋友分享给我一个 ai 测试大数据测试的培训视频课程 at 2025年11月03日

AI 测试 大数据测试前景肯定是更好的,但是学历要求高,限制比较多吧

-

对 AI 测试的一个想法 at 2025年10月30日

感觉可以直接产品经理对接 AI,跳过开发、测试,单纯的一个想法!

-

一年要过去了,大家在 AI 在测试领域有哪些应用? at 2025年10月28日

自建大模型,争取实现测试 100% 覆盖,线上零问题

-

公司现在需要写一份用 AI 辅助测试的调研报告 at 2025年10月28日

直接用 AI 写这份 AI 辅助测试的调研报告就好了

-

大家喜欢测试吗,测试工作中快乐的部分 at 2025年10月22日

以前周一到周五,每天都干劲满满;现在周一就想着赶紧周五;业务固化,也不涨薪,并不是很快乐

-

大家喜欢测试吗,测试工作中快乐的部分 at 2025年10月21日

快乐,快乐死了

-

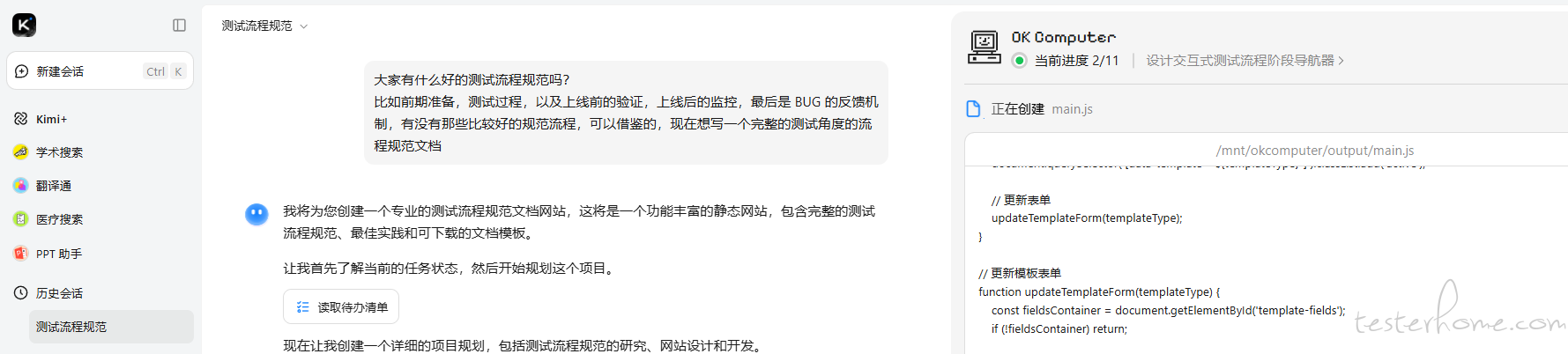

测试流程规范 at 2025年10月20日

-

测试流程规范 at 2025年10月20日

可以试试 KIMI 新出的这个模式 -

如何应对 35 岁乃至 40、50 的职业危机? at 2025年10月16日

路到桥头就掉进去了

-

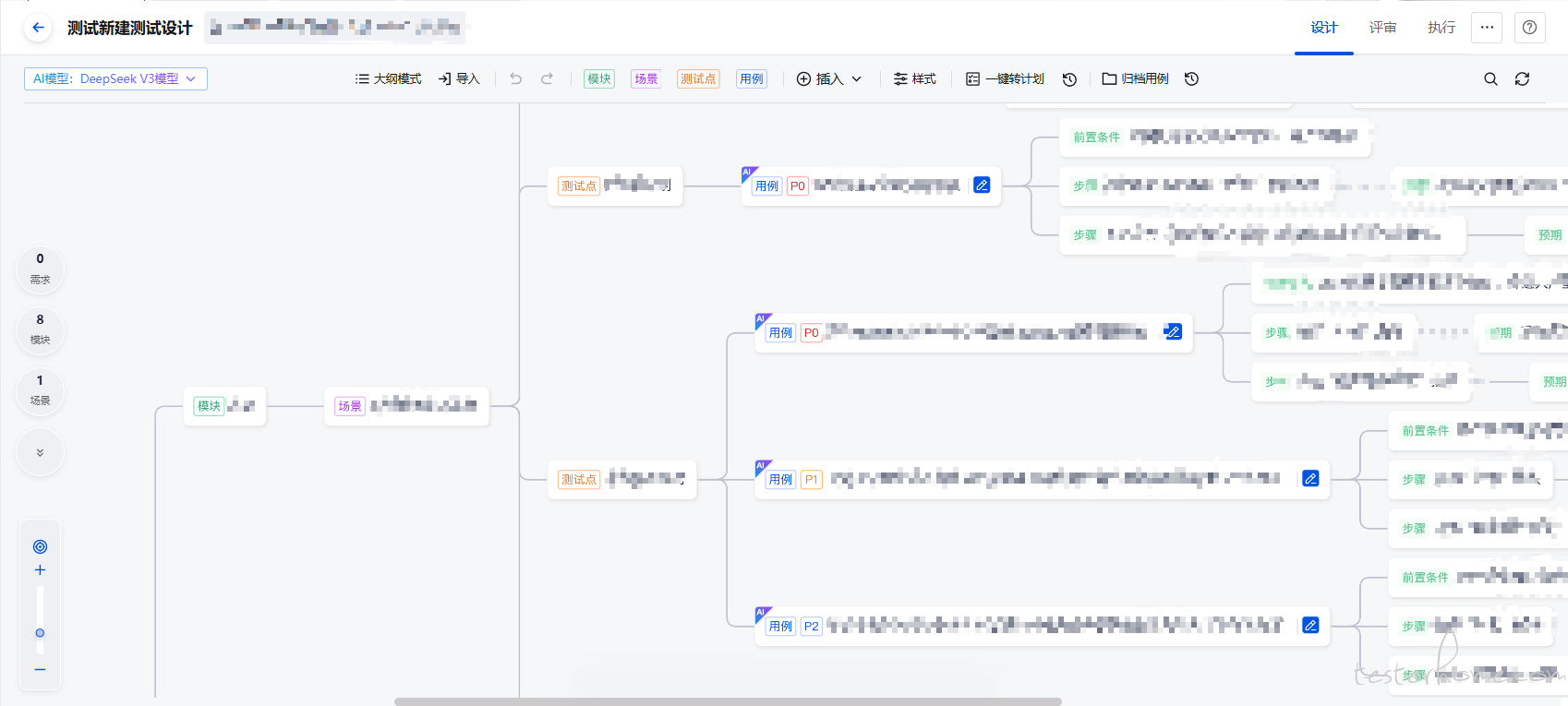

有在研究利用 AI 生成测试用例的团队么?效果如何?遇到哪些瓶颈? at 2025年09月04日

-

有在研究利用 AI 生成测试用例的团队么?效果如何?遇到哪些瓶颈? at 2025年09月04日

当时 TAPD 给的使用文档,试用了下,不太适合公司业务,就没深究 -

【求助】新晋测试组长,如何做出成绩让团队及领导认可? at 2025年09月01日

通过调用 API 引入 AI

-

自动化平台上的 case 大家是如何编写和思考的? at 2025年08月29日

封装

-

突然发现还有积分商城,现在还可以换笔记本吗? at 2025年08月22日

好家伙