-

Jacoco-报告改造实践 at 2021年01月25日

很棒的实践

-

selenium 执行过程如何实现录屏? at 2021年01月25日

ffmpeg 我用过,每一步操作截图,并且记录坐标点击操作,先对截图的图片编辑增加 坐标点操作的显示(我是绘图一个准星上去),然后再用这一系列的截图生成视频

-

CPU 上下文切换详解 at 2021年01月06日

看业务场景是怎么样的,我们这边涉及很多 CPU 密集型的任务,特别是在云原生环境下的 CPU 密集型任务, 了解 CPU 切换和 CPU 调度,能大大提高性能

-

[沟通交流] 又到了一年制定计划的时候 at 2020年12月10日

集成 Chrome 插件 到时候可以一起交流交流

-

[沟通交流] 又到了一年制定计划的时候 at 2020年12月09日

虚的主要是给上面看的

-

[沟通交流] 又到了一年制定计划的时候 at 2020年12月09日

大佬别这样啊,一起交流交流。

-

[沟通交流] 又到了一年制定计划的时候 at 2020年12月09日

大佬别这样啊,一起交流交流

-

[沟通交流] 又到了一年制定计划的时候 at 2020年12月09日

感谢提醒。已经修改

-

[沟通交流] 又到了一年制定计划的时候 at 2020年12月08日

小部门没多少人的负责人。没啥厉害,可能都比不过大部门的一个主力

-

[沟通交流] 又到了一年制定计划的时候 at 2020年12月08日

我自己先来

工作 6 年, 目前担任测试开发负责人

下一年度计划 (20201209 修改):

1.完成测试工具,测试能力的整合,打造 pipeline 级的测试能力生命周期,及一站式接入

1.1 目前已有测试能力: 代码门禁(单测,覆盖率,静态检查),精准化分析,性能测试,自动化测试,UI 测试,测试报告

1.2 目前上述能力都是分散的能力孤岛,希望接下来能够将能力进行整合关联,能力之间能够互相输出提高,打造成一条测试质量 pipeline

1.3 强化当前的 CD 能力,目前 CD 能力特别弱,得调研下 GitOps 概念及工具 argo

2.接口自动化提效:自动化框架下沉自动化服务,集成附加测试能力,支持业务流程自动录入

2.1 自动化框架的底层功能作为服务,通过 RPC 调用的方式执行用例

2.2 分离用例,接口模型,环境信息。附件其他测试能力如 fuzzing, 交叉,及在线编辑

2.3 集成 Chrome 插件 可以让业务测试执行的时候自动生成业务自动化脚本。

3.引入 AI 能力赋能测试质量测试效率

3.1 AI Web 遍历检查 JS 和 HTTP 报错,并输出操作步骤视频

3.1 AI Web 遍历 通过 接口自动化和 UI 自动化的操作进行训练,打造成 基于业务操作的遍历 -

jmeter 在压测过程中,有办法通过接口请求实时拿到聚合报告中的指标数据吗? at 2020年11月05日

我们这边是根据 grafana 的指标跟 jmeter 自己的指标做过 TPS 对比,在 10k+ 以上 也是差不多的。你们的表现是两边指标 结果差距很大 还是用了 backendListener 影响结果

-

jmeter 在压测过程中,有办法通过接口请求实时拿到聚合报告中的指标数据吗? at 2020年11月04日

我现在就是这样做的,我觉得数据挺可信的,请问大佬一定程度 上不可信 指的是什么情况?

-

记一次静态代码扫描实践 at 2020年10月26日

楼主有没有碰到 sonar webhook 的状态 偶尔是 Server Unreachable

-

接口级集成测试怎么写,怎么体现价值 at 2020年08月31日

感谢大佬耐心回复,我也想问下你们是代码仓库变更,接口管理自动更新,还是接口自动化用例自动更新?

-

[咨询问题] 有关 Allure 报告的技术问题,希望大家给点思路和具体的实现方法。 at 2020年06月08日

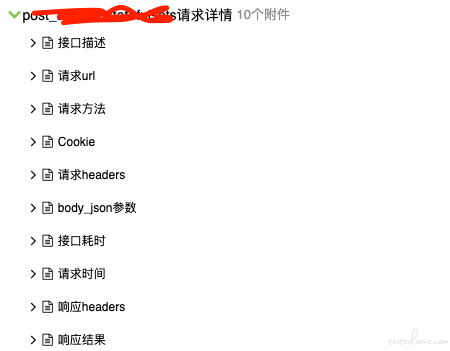

3.最好是在接口请求层面做统一封装,关键信息增加到报告里。

4.可以对 allure 的测试结果数据 自己做二次开发,我们现在的单次结果报告就是对 allure-result 目录里的结果数据做分析 -

UI 调度自动化平台 at 2020年06月01日

查看正在执行的用例是用什么技术实现的?

-

接口性能压测工具 Locust 学习笔记 at 2019年12月02日

min_wait , max_wait 这两个参数设置了吗

-

(pytest) 类中函数装饰器中调用的当前类中的另一个函数, 引发的问题 at 2019年10月28日

改成类方法应该就可以了

-

有什么工具或框架可以对 Tcp 协议的接口进行新能测试的吗? at 2019年10月28日

JMeter 的 TCP Sampler 可以测试同步情况下的 TCP 性能,我是自己用 Locust 测试异步的 TCP 性能

-

Jmeter 能够测试无响应返回的接口性能吗 at 2019年10月11日

请问 怎么做呢?是用 jmeter 的哪个控件?

-

Jmeter 能够测试无响应返回的接口性能吗 at 2019年10月11日

不会有任何返回

-

请问各位兄弟们自动化接口的时候断言有几种方法? at 2019年09月04日

我们也是用 doclever 管理接口的,不过我们自动化脚本不是在 doclever 上写。我们是用 pytest 写

-

Allure 生成的报告中类别和趋势模块都显示为空,这个怎么解决呢? at 2019年07月22日

他这个类别是 error 的类别,你 case 有报错 就会出现, 这个 trend 我记得应该要结合执行器才会出现,比如结合 jenkins

-

请问什么是 mock 写入 at 2019年07月22日

这要结合上下文语境来猜测了 ,别人具体是问 mock 写入时,XXXXXX?

-

精准测试如何根据未覆盖的代码自动生成测试用例? at 2019年06月18日

通常看到大部分人的做法都是 做相关的 testcase 和代码行的关系 mapping,获取未覆盖的代码行,就能找到对应的 testcase。这样的前提是 testcase 已经存在的情况。像你这里提的需求 是根据未覆盖的代码生成测试用例,其实难点在这些代码怎么能够执行到,很多代码都是未暴露对外的 function ,对于黑盒测试很难覆盖到,所以我觉得你这个需求 只能在单元测试阶段去做,集成测试和系统测试阶段比较难,单元测试自动生成用例,我了解的有个叫 evosuite 可以生成单元测试用例 颗粒度是 class 级别的。