今年正好是不惑之年,步入测试这个行业十多年了,曾经也在大厂短暂待过,目前在一家算是中厂的公司,坐标北京,2 年前入职的,主要的项目从立项到现在差不多 16 个月的样子,这一年业务的变化非常快,下面仅从数据的维度来给自己做个简要的总结。

工作

- 测试团队 1x 人,有少部分外包同学,研发测试比在 3.5 比 1 左右,功能测试占比 90% 以上;

- 全年交付大小需求 1000+,用飞书多维表格进行管理,累计提交的 BUG 数 8000+,最多的同学 1200+;

- APP A,一周一版,全年累计发版次数 50+;APP B,8 月启动,一周一版,全年累计发版 20+;DAU 均百万 +;

- 个人全年基本上 10105,发版日则取决于最终发版时间,全年平均发版时间应该在晚上 11 点-12 点之间,最晚凌晨 3 点多;

- 全年有测试主导或者参与的线上事故问题复盘共 6 次,没有出现 P1 和 P2 级别的问题,其中测试人员被罚款共有 2 次,主要原因:

- 新版本 T,需求 A 影响到了已有功能 B,测试阶段和回归阶段未发现,T+1 版本回归测试发现连带问题并一并修复,但 T 版本对该功能造成了一定影响(非收入),最终客户端研发和测试责任对半分;

- 某核心系统存在设计上的缺陷,导致某需求上线后在部分地区存在异常,该系统研发负责人在一周后的例行巡查时发现问题,但造成了一定的资损,最终服务端研发占责任大头,测试占少部分;

- 其他的几次,要么是事故主要责任在研发,跟测试相关性不大;要么是事故等级没有到罚款的程度而作为处理。

生活

- 2025 年 3 月底参加公司的年度体检,体重超重,BMI 25.9,轻度脂肪肝;

- 从 4 月中旬开始,利用中午或晚饭后的空闲时间,开始通过快走的方式来提升能量消耗,配速 10 分出头,6 月份最长一次走了 2 个多小时,距离 13 公里 +;

- 从 6 月中旬开始,人生第一次开始尝试跑步,最初只能跑几百米,跑走结合,循序渐进,6 月底能够坚持跑到 3 公里。到了 7 月下旬,跑了人生中的第一个 10 公里。到了 8 月份,最长一次跑步 16 公里。现在主要周中和周末各跑 1 次,每次 5-10 公里之间,配速在 5-6 分之间;

- 截止到2025年12月31日,全年 8 月半月的时间,快走 234 次,累计 605 公里;6 个半月时间,跑步 62 次,累计 351 公里。体重减少 23 斤,BMI 指数 21.8,回到正常水平,脂肪肝是否消失待年后体检。

代码

- 【客户端】完成双端埋点测试辅助脚本,辅助发现重复上报、漏报、特定场景下的数据统计、关键字段校验等问题,双端代码行 400+,组内绝大部分同学都在使用;

- 【客户端】Android 端继续完善基于字节开源的 Fastbot 的自动化测试框架,全年累计自动化提交崩溃的 BUG 120+,研发解决率 70%+,线上崩溃率从最高的 3% 降低到目前 0.2% 左右;

- 【客户端】完成对 Android 端 Deeplink 的自动化测试,主要用于每个常规迭代版本的回归测试,避免新增功能影响到既有的 Deeplink 跳转,代码行 200+;

- 【客户端】完成 2 个最核心,也是最高频的基础业务场景下的 UI 自动化测试建设,主要解决长时间使用这些功能时可能会出现的页面异常或者切换失败等问题,代码行 700+;

- 【客户端】完成双端性能测试脚本的开发,覆盖 CPU 占用、内存使用、流量使用、FPS 等维度的性能数据抓取,再加上冷启动时长、核心场景下的响应时长等,上述场景全年都有优化,目前绝大部分指标都优于竞品,核心代码行 450+,HTML 趋势报告代码行 200+(非必须),现在每个月左右跑一次;

- 【服务端】在自研的数据驱动的接口自动化测试框架下新增了 5 个主要的业务场景 30+ 接口的自动化测试支持,代码行 800+,发现线上配置类问题 10+;

- 【服务端】在接口自动化测试的基础上,开发对用户可见内容的自动化测试巡检脚本,从资源维度进行全方面的巡检,代码行 1000+,发现资源维度的问题 300+,90% 以上的问题已经联动产运调整配置或者研发优化代码完成修复;

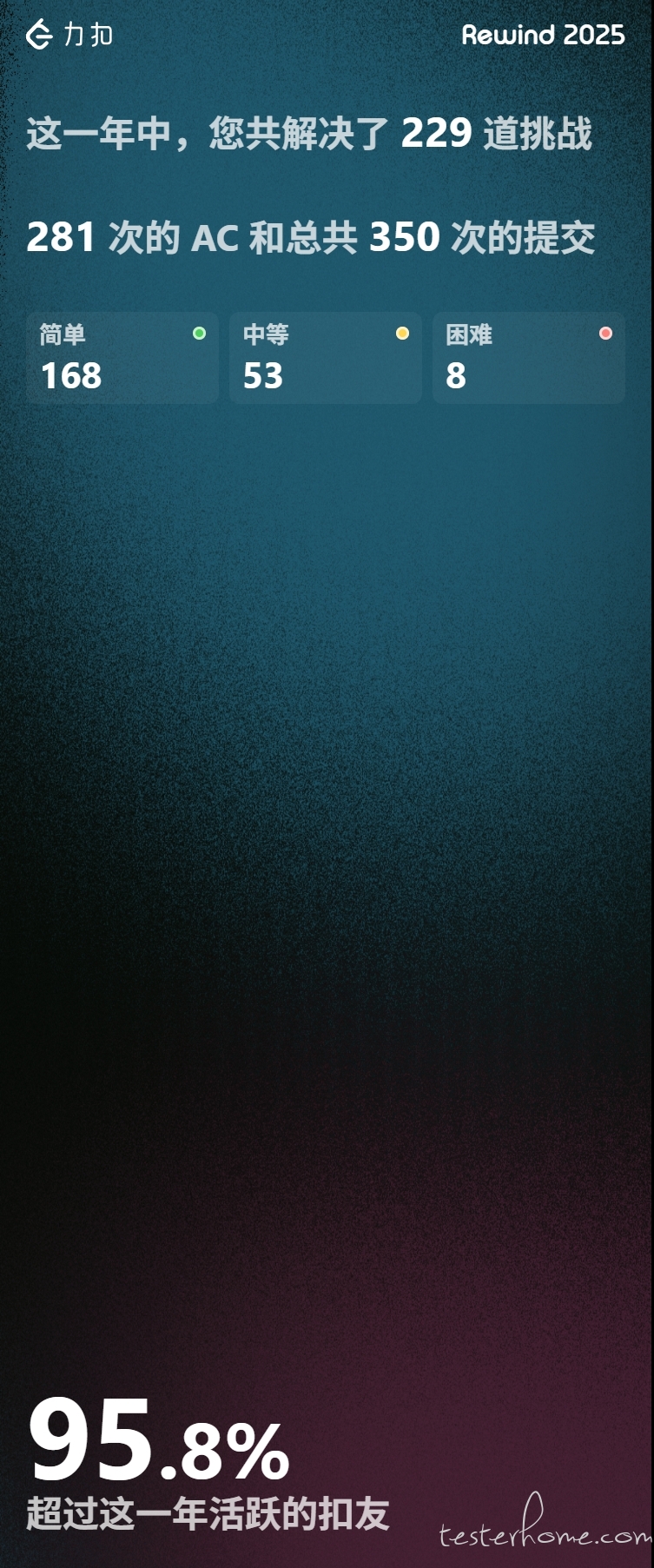

- 【个人学习】空闲时候则在 Leetcode 上刷刷题,全年共解决简单问题 168 题,中等 53 题,困难 8 题,在团队内部分享如何解题共 10 次。

「原创声明:保留所有权利,禁止转载」