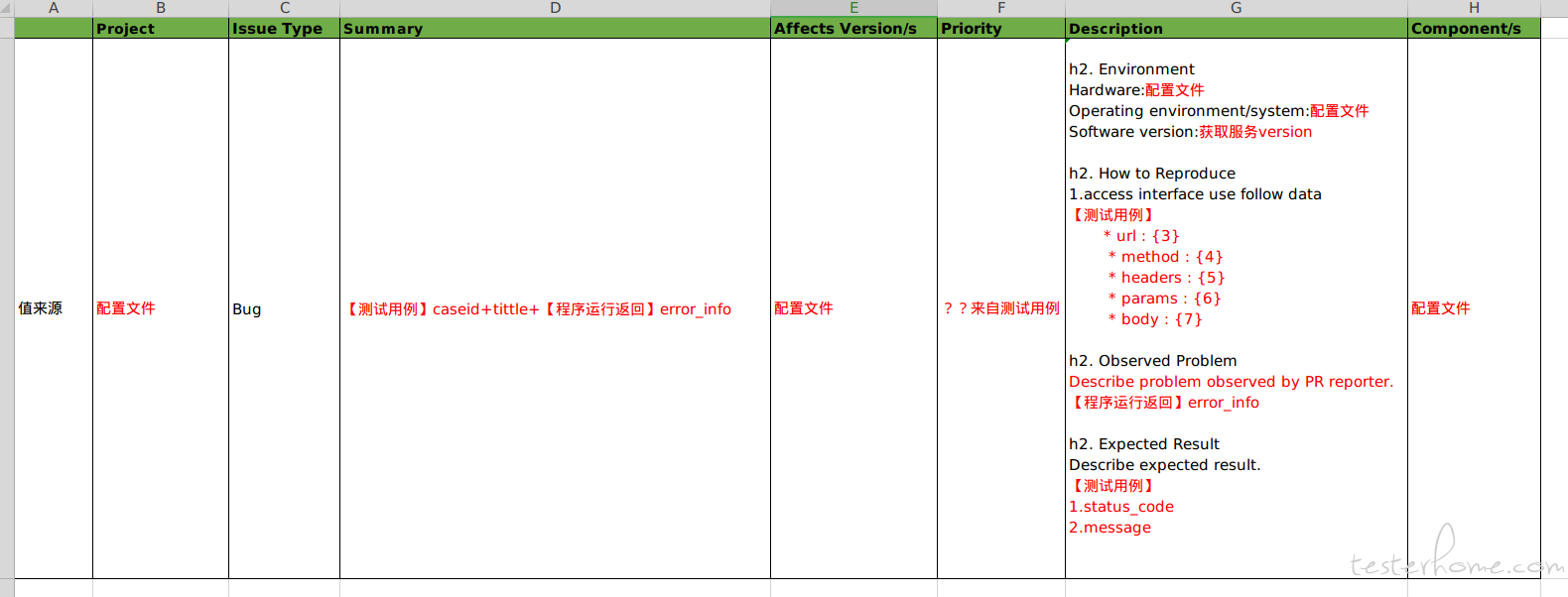

如图,接口测试完成后,代码会根据测试结果在 jira 上创建 bug,bug 数据来源如下:

bug 创建成功后显示如下

每次测试用例不通过,首先查看是否已有相关 Bug,

因为存在一下两种情况:

a)两次错误相同

b)两次错误不相同

问题:怎样判断 bug 是否已存在

补充问题:

1)bug 的 summery 现在还不确定该怎么写,因为如果 error_info 太长,创建问题可能会失败,也希望提供关于 summery 写法的意见

2)bug 的优先级应该怎样给值也没想到最好的办法,因为用例的优先级不能完全代替 bug 的优先级