不能阅读其他人的草稿。

大家好,最近使用 Locust 做了一些压测。看网上的说法,Locust 的统计结果不是很准确,所以我用 JMeter 和 Locust 对同一个 api 做了一下压测。

Api 使用 flask-restful 在本地部署的一个,直接使用的官网例子:

from flask import Flask

from flask_restful import reqparse, abort, Api, Resource

app = Flask(__name__)

api = Api(app)

TODOS = {

'todo1': {'task': 'build an API'},

'todo2': {'task': '?????'},

'todo3': {'task': 'profit!'},

}

def abort_if_todo_doesnt_exist(todo_id):

if todo_id not in TODOS:

abort(404, message="Todo {} doesn't exist".format(todo_id))

parser = reqparse.RequestParser()

parser.add_argument('task')

# Todo

# shows a single todo item and lets you delete a todo item

class Todo(Resource):

def get(self, todo_id):

abort_if_todo_doesnt_exist(todo_id)

return TODOS[todo_id]

def delete(self, todo_id):

abort_if_todo_doesnt_exist(todo_id)

del TODOS[todo_id]

return '', 204

def put(self, todo_id):

args = parser.parse_args()

task = {'task': args['task']}

TODOS[todo_id] = task

return task, 201

# TodoList

# shows a list of all todos, and lets you POST to add new tasks

class TodoList(Resource):

def get(self):

return TODOS

def post(self):

args = parser.parse_args()

todo_id = int(max(TODOS.keys()).lstrip('todo')) + 1

todo_id = 'todo%i' % todo_id

TODOS[todo_id] = {'task': args['task']}

return TODOS[todo_id], 201

##

# Actually setup the Api resource routing here

##

api.add_resource(TodoList, '/todos')

api.add_resource(Todo, '/todos/<todo_id>')

if __name__ == '__main__':

app.run(debug=True)

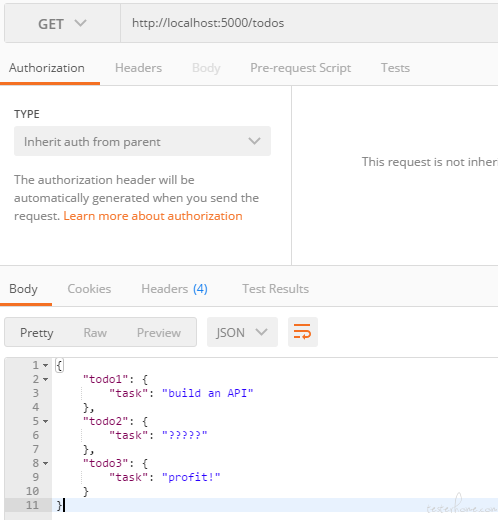

调试 get 请求http://localhost:5000/todos,成功返回

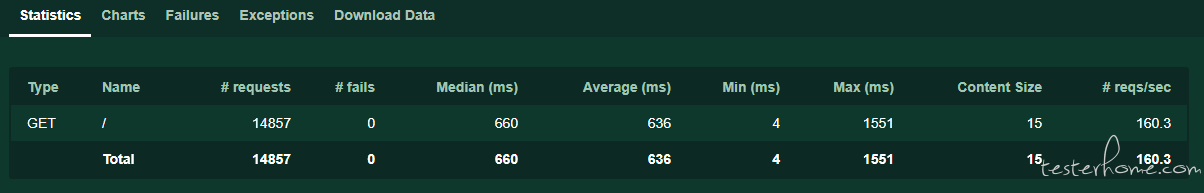

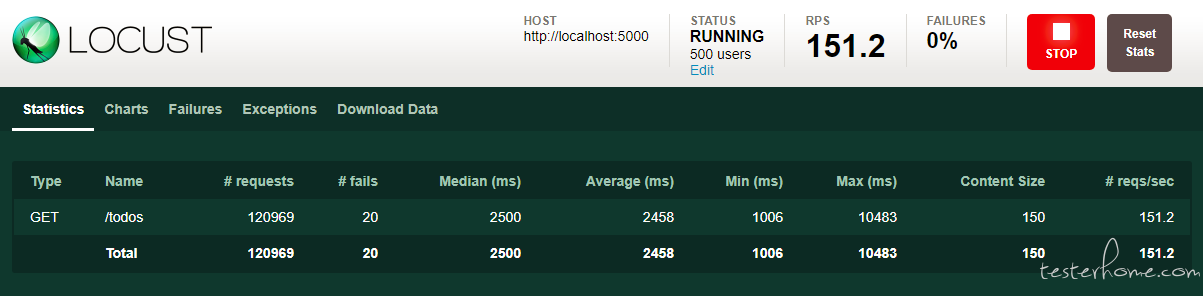

使用 Locust 的压测结果:(使用 500 个并发用户)

from locust import HttpLocust, TaskSet, task

from datetime import datetime

import random

from re import search

class UserBehavior(TaskSet):

@task

def chushen(self):

with self.client.get("/todos" , catch_response=True) as rp:

rp.encoding = 'utf-8'

if 'build an API' in rp.text:

rp.success()

else:

rp.failure(rp.text)

class WebsiteUser(HttpLocust):

task_set = UserBehavior

host = "http://localhost:5000"

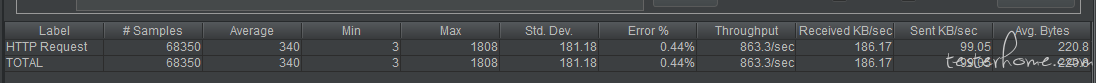

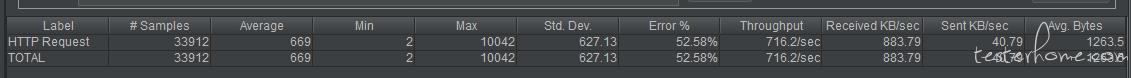

使用 JMeter 的压测结果:(使用 500 个并发用户)

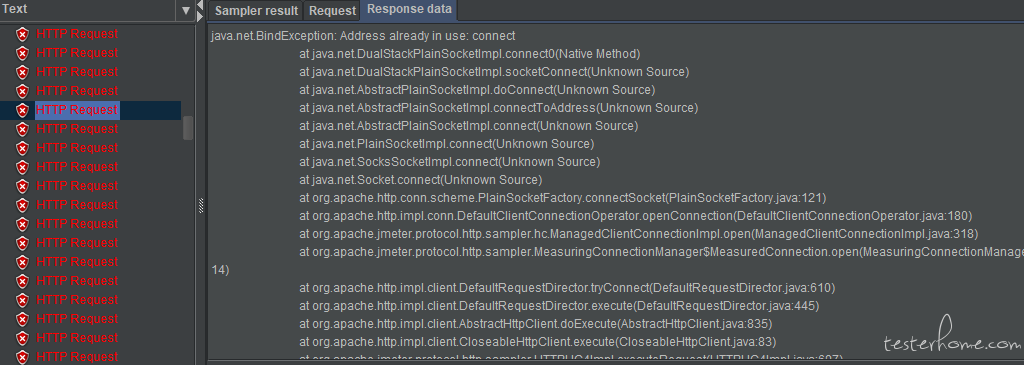

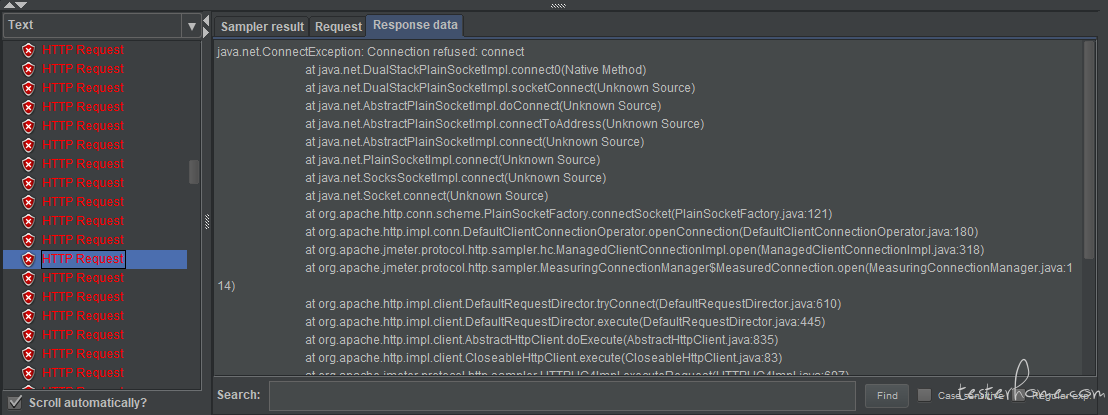

以上测试都是在我的本机上进行的,可以看到使用 Locust 压测时,fail 的 request 很少,只是 tps 不是很高,平均只有 150rps,但是使用 JMeter 压测时,错误很多,下面是报错的一些截图:

做这样一个比对的原因,是因为我想选择其中一个做为将来的主力测试工具,所以希望所选择的工具在测试结果的准确性,施压能力上都很不错。我个人比较喜欢 Locust,脚本写起来爽,但是对压测结果的准确性上还有点怀疑。大家觉得哪个比较好呢?

「原创声明:保留所有权利,禁止转载」