-

jenkins 集成输出 allure 报告无数据 at December 26, 2023

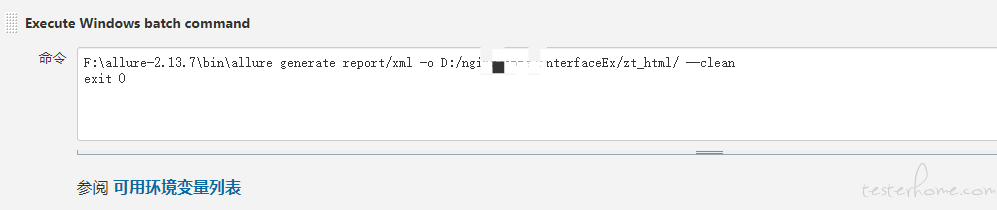

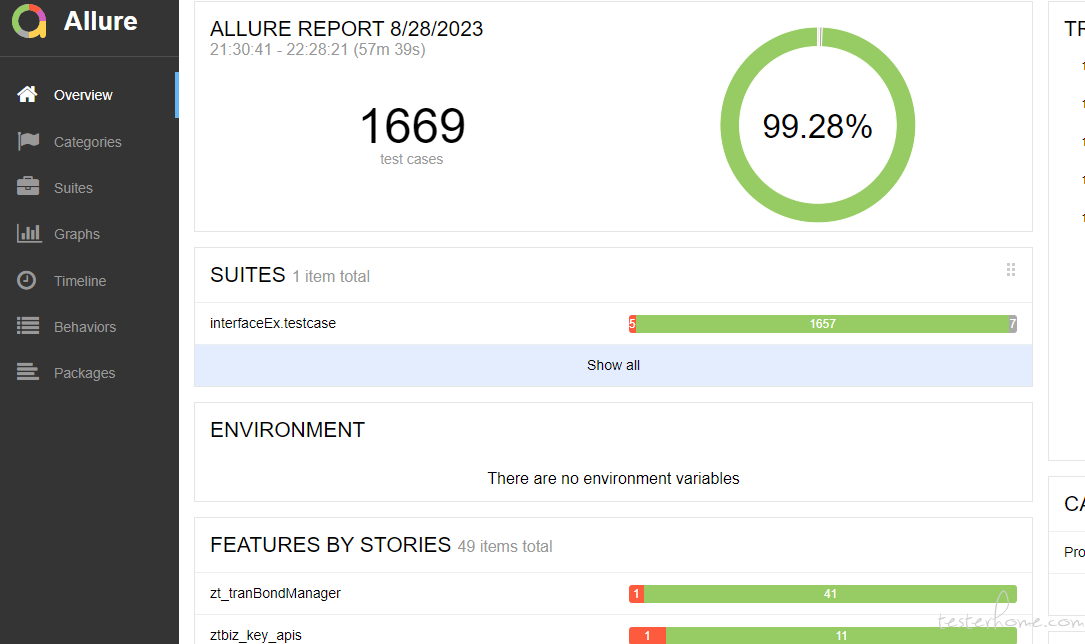

我也是 Jenkins 配置的 allure 报告,正常生成的。楼主的情况应该不是 Jenkins 的问题,可以先手动 generate 试一下。 -

面临一个转岗产品的机会,有些迷茫,想请教各位经历过转岗的前辈的意见 at December 22, 2023

机会肯定是好的,看你有没有勇气走出舒适区,迎接挑战,患得患失是最大的阻碍。选择这个机会可能后悔 3、5 年,如果失去了这个机会,是不是会后悔 30、50 年。

-

1 at December 20, 2023

点都很真实,解决方案也给的很靠谱,但有些问题还是无解。比如现在公司效益不好,研发都是以产品为导向。项目立项的时候就已经确定了上线的 deadline,过程中需求延期、开发延期、需求变更。。。,后期测试堆人能解决上线时间问题,但质量就堪忧了

-

接口自动化测试每次任务都拉起一个 docker 属于资源浪费吗? at December 20, 2023

“当前平台属于代码托管形式,在每次运行时会拉起一个 docker init 所有相关依赖后 再运行自动化脚本”

对于这个问题,是否可以拆成 2 步走:

step1:构建一个框架/平台级的基础镜像 image_base,包含所有基础依赖

step2:运行任务时基于用例 +image_base 构建可执行镜像 -

你的测试生涯中, 是否遇到过现在还没有想到如何解决的难题 at December 18, 2023

深有体会,目前的产品搞不清需求,只是个业务人员的传话筒,每次需求评审的时候就擅自定了上线日期。在开发测试阶段不停的修改需求,上线时间还不能变,头疼

-

工作两年 +,明年可能是在测试行业的最后半年了,年终总结 at December 18, 2023

祝好,努力做出改变的人,值得被命运奖励

-

求教前辈关于接口冒烟工具的可行性和建议 at October 24, 2023

我们接口自动化也是利用 swagger 获取接口信息、参数信息,然后根据参数必填和类型填写随机值。这样做的目的不是用来冒烟的,而是为后续编写自动化用例提供参考,不过效果也不是太明显。想要直接生成可用的冒烟用例太难了,目前还没有好的方案

-

测试到了管理会更好吗? at October 20, 2023

有机会还是要走管理的路,在底层永远是被动的,可以舍弃的。还有任何技术都弥补不了的信息差,任何一点风吹草动都可能是致命性打击

-

有效测试的 50 条建议 - 需求阶段(1~5) at September 01, 2023

产品就是业务的传话筒 + 搬运工,需求描述 20 个字,需要自己翻译成 1000 字的需求分析才能落地

-

接口自动化 at August 15, 2023

你这是烫手的山芋呀,1、领导想让线上跑,2、看不到效果就劝退。。。,三思、慎重

-

接口自动化怎么做,才能效益最大化? at August 14, 2023

自动化停用,这部分回归的工作还是要人来完成。自动化不是万能的,也不是一劳永逸的,leader 们确实要好好权衡这个关系。

-

大佬们看看我这样设计接口用例有啥问题吗 at August 09, 2023

大部分项目都是以前端为入口的,接口不会面对这么多考验,而且项目的人力成本投入也不支持做这么详细的校验。所以一般接口测试是用来保障正常入参、正常业务场景,项目有特殊要求除外

-

Java 代码改动影响范围分析 at July 24, 2023

对我来说目前主要用的是代码变动影响到的接口,所以树状图更直观一些

-

《随便测测》接口测试平台 开源详细文档 - 主要功能展示 at July 12, 2023

好的,多谢

-

《随便测测》接口测试平台 开源详细文档 - 主要功能展示 at July 11, 2023

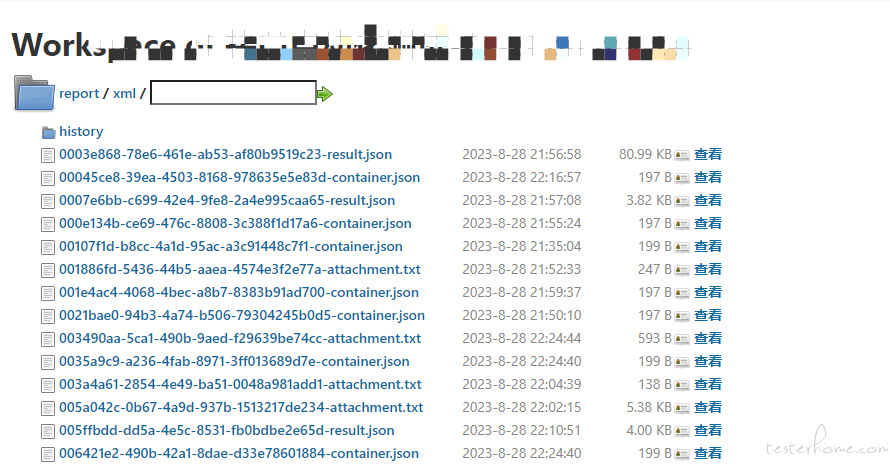

想请问下大佬,allure 报告中的 history 有解决方案吗

-

一个季度的考核绩效的质量考核合理吗 at July 06, 2023

拿 bug 绝对数量做考核,测试要被玩死了

-

已使用接口测试平台,平台外再使用造数脚本是否是一条能走的路线? at July 03, 2023

从提升平台使用率的角度看,造数的这种改造没什么帮助的吧。我们现在也面临这种尴尬处境,框架改成平台后,使用率反而降低了。了解下来,主要是以下几点:

1、框架的自由度高,而且还能看到框架的实现,调试也方便,使用者是有一定收获的;

2、使用平台限制比较多,而且写一条用例要操作几个表单才能完成,便捷性差很多; -

怎么样把 python 的 selenium 自动化脚本,放到 docker 容器 at June 28, 2023

没用过,不过理解下来可以分几步走:

1、构建一个基础镜像,包含 python、selenium、Chrome 等、脚本依赖插件等

2、每次执行,引用步骤 1 的镜像构建一个新镜像,包含最新脚本

3、基于步骤 2 的镜像启动容器

4、具体问题具体分析 -

Java 代码改动影响范围分析 at June 28, 2023

好的,多谢大佬

-

Java 代码改动影响范围分析 at June 27, 2023

好的,看到大佬的更新了,多谢

-

Java 代码改动影响范围分析 at June 27, 2023

现在的做法是每次将生成的 CCI result 贴到 echarts 里,才能生成关系图,这种应用方式比较麻烦,也不太能做成自动化。对于这部分大佬有什么方案吗?

-

Java 代码改动影响范围分析 at June 27, 2023

试了下,很不错,基本达到了预期效果,楼主威武!想问下,CCI result 除了用 echarts 展示,还有其他展示方式吗

-

关于 cookie 引用的问题 at June 06, 2023

不嫌麻烦的话 ,登录接口 response header 可以一个个试。最简单的还是找开发确认下,可能一分钟就能搞定了

-

突然不想提 bug 了。。 at June 01, 2023

才入行半年就开始摆烂不好吧

-

后端发布后,有部分服务器未发布成功,这个是什么原因导致的? at June 01, 2023

这问题比中东局势的问题还要大