概述

Agentic X 是一种基于大语言模型(LLM)的智能化方法论,其中 Agentic 代表以 Agent 为核心的智能化行为方式,X 象征着任何可能的应用领域。在测试领域,Agentic Testing 通过 LLM 的推理能力、代码生成能力和知识检索能力,重新定义了测试工程的工作方式。

这种方法论不依赖于特定的平台或工具,而是一种可以在任何环境中实施的智能化实践方式。本文档详细介绍了如何运用 Agentic Testing 方法论,在测试用例生成、测试流程编排、代码生成、知识检索等方面探索。

🎯 Agentic Testing 的核心价值

Agentic Testing 作为 Agentic X 方法论在测试领域的具体实践,通过以下几个维度重新定义测试工程的工作方式:

- 自然语言驱动测试:将测试需求的自然语言描述直接转化为可执行的测试资产

- 智能化推理决策:基于 LLM Agent 的强大推理能力进行测试策略制定

- 上下文感知生成:充分理解项目上下文,生成高度相关的测试内容

- 知识增强决策:整合领域知识库,提供专业级的测试建议和指导

- 多模态理解能力:统一处理文本、代码、文档等多种形式的测试输入

Agentic X 的普适性

这种方法论的核心在于其通用性和适应性:

- X = Testing:本文档聚焦的测试领域应用

- X = Development:可扩展到软件开发的各个环节

- X = Operations:适用于运维和监控场景

- X = Any Domain:理论上可应用于任何需要智能化的领域

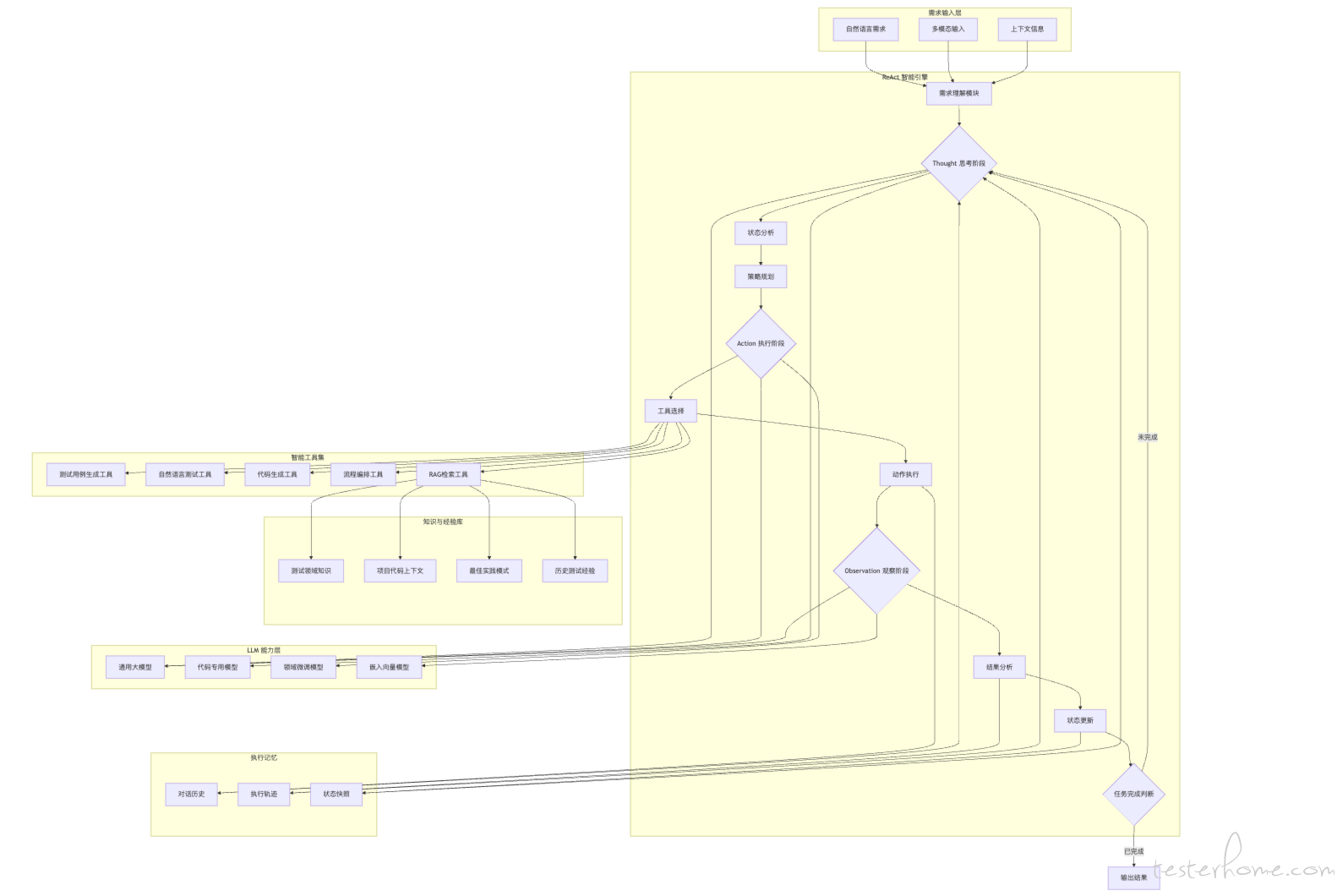

🏗️ Agentic Testing 方法论架构

智能化工作流程设计

Agentic Testing 基于现代 LLM Agent 框架设计,构建了完整的智能化测试工作流程:

-

感知层(Perception Layer)

- 多模态输入处理:自然语言、代码、文档、接口定义

- 上下文理解:项目结构、业务逻辑、测试需求

- 环境感知:当前测试状态、历史执行结果

-

推理层(Reasoning Layer)

- LLM 核心推理引擎支持: DeepSeek、GPT-4、Claude、本地化模型

- Chain-of-Thought 推理:步骤化的测试策略制定

- 多轮对话管理:维持测试上下文的连续性

-

决策层(Decision Layer)

- 测试策略规划:基于业务需求制定测试方案

- 工具选择:智能选择合适的测试工具和方法

- 优先级排序:根据风险和重要性排序测试任务

-

执行层(Execution Layer)

- 代码生成引擎:自动生成测试代码

- 工具集成:与现有测试工具链无缝集成

- 结果反馈:执行结果的智能分析和反馈

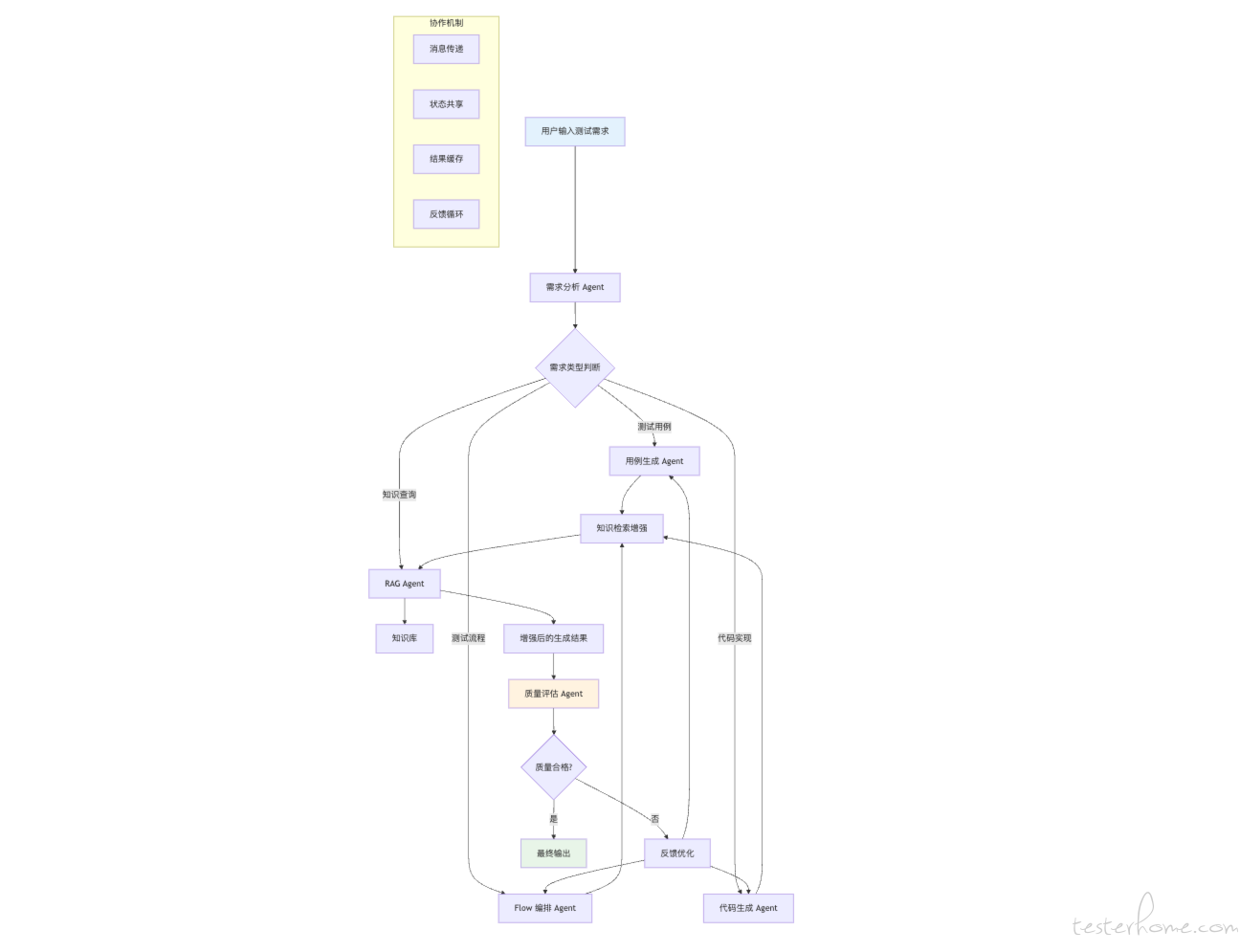

Agentic Testing 方法论流程架构

🚀 Agentic Testing 核心实践模式

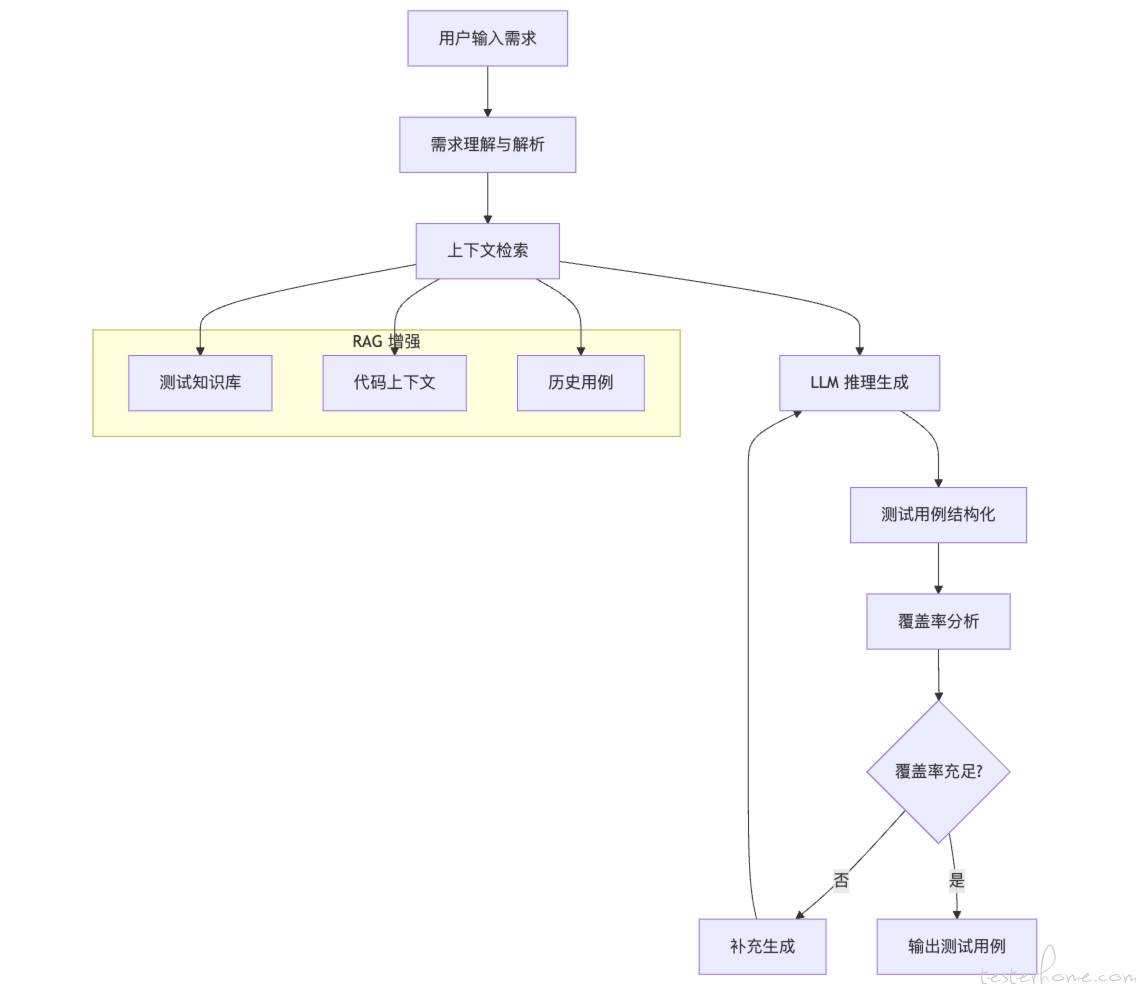

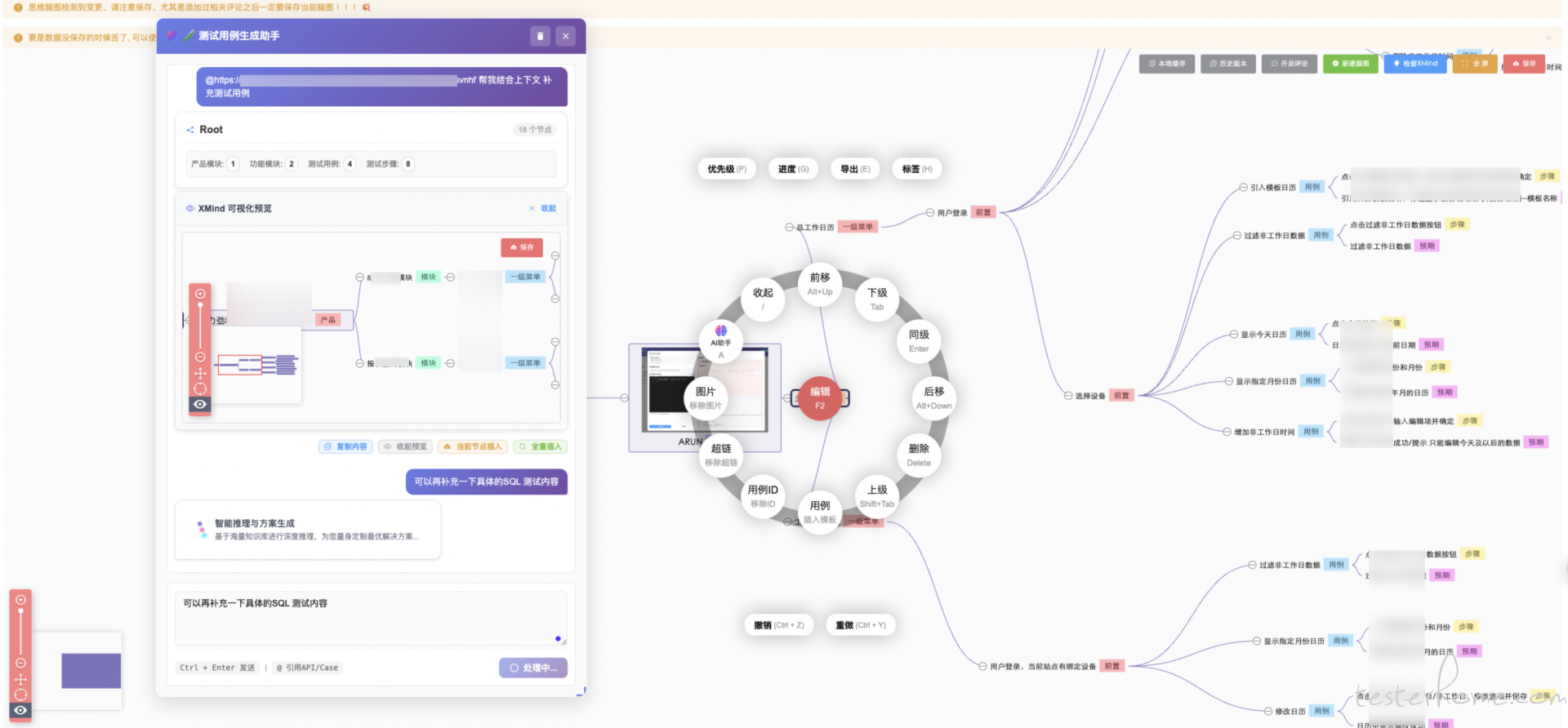

1. 智能测试用例生成 Agent

核心能力

- 自然语言转测试用例:通过自然语言描述自动生成结构化测试用例

- 上下文感知生成:基于项目代码和文档上下文生成相关测试用例

- 多维度覆盖分析:智能分析功能点,确保测试覆盖率

- 边界条件识别:自动识别和生成边界条件测试用例

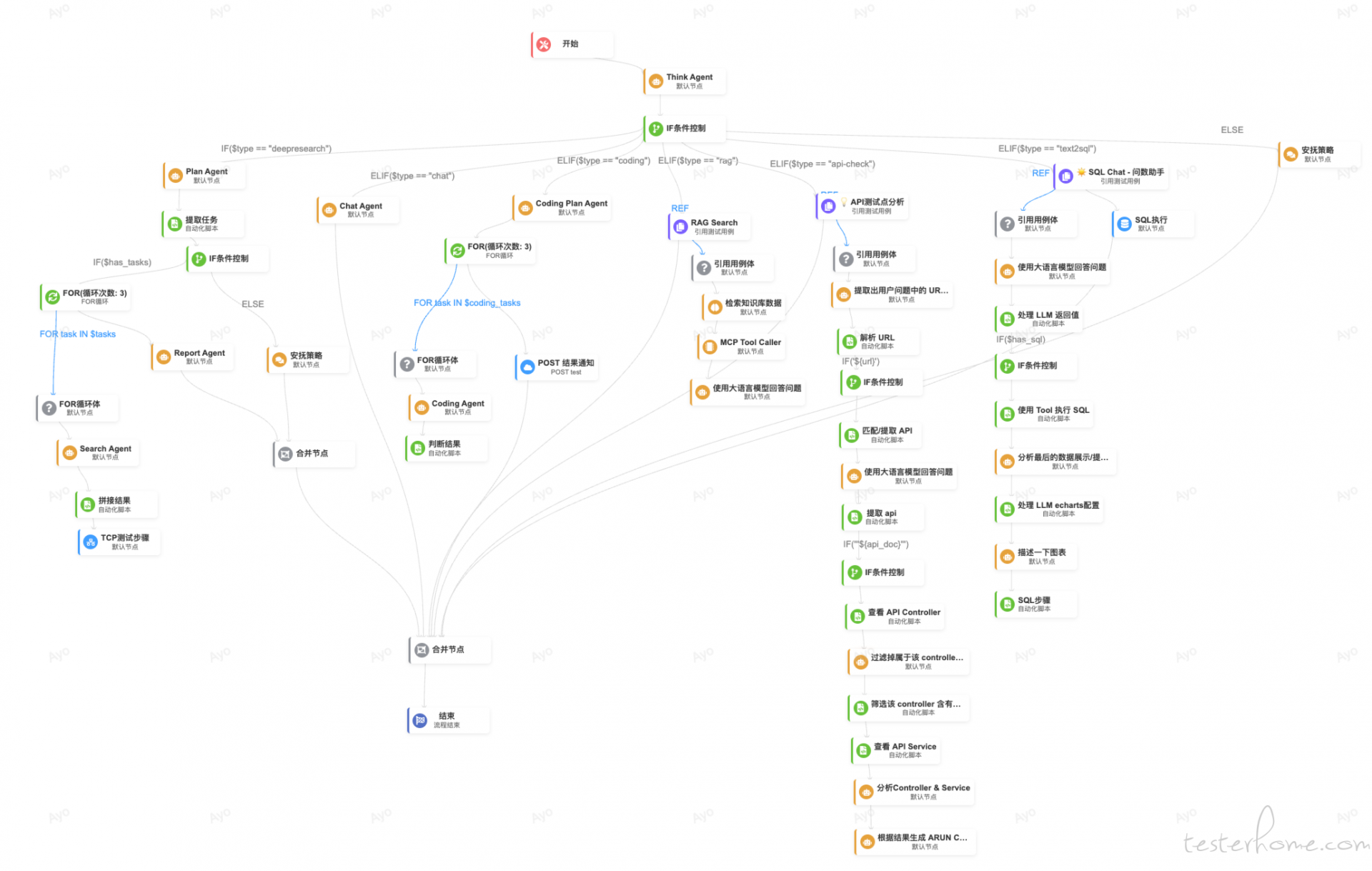

Agent 工作流程

技术实现示例

class TestCaseGenerationAgent:

def __init__(self):

self.llm = LLMService()

self.rag_retriever = RAGRetriever()

self.code_analyzer = CodeAnalyzer()

async def generate_test_cases(self, requirement: str, context: ProjectContext):

# 1. 需求理解和解析

parsed_requirement = await self.llm.parse_requirement(requirement)

# 2. 检索相关上下文

relevant_context = await self.rag_retriever.retrieve(

query=parsed_requirement,

sources=[context.code_base, context.docs, context.existing_tests]

)

# 3. LLM 生成测试用例

test_cases = await self.llm.generate_with_context(

prompt=self._build_generation_prompt(parsed_requirement),

context=relevant_context,

schema=TestCaseSchema

)

# 4. 验证和优化

validated_cases = await self._validate_and_optimize(test_cases, context)

return validated_cases

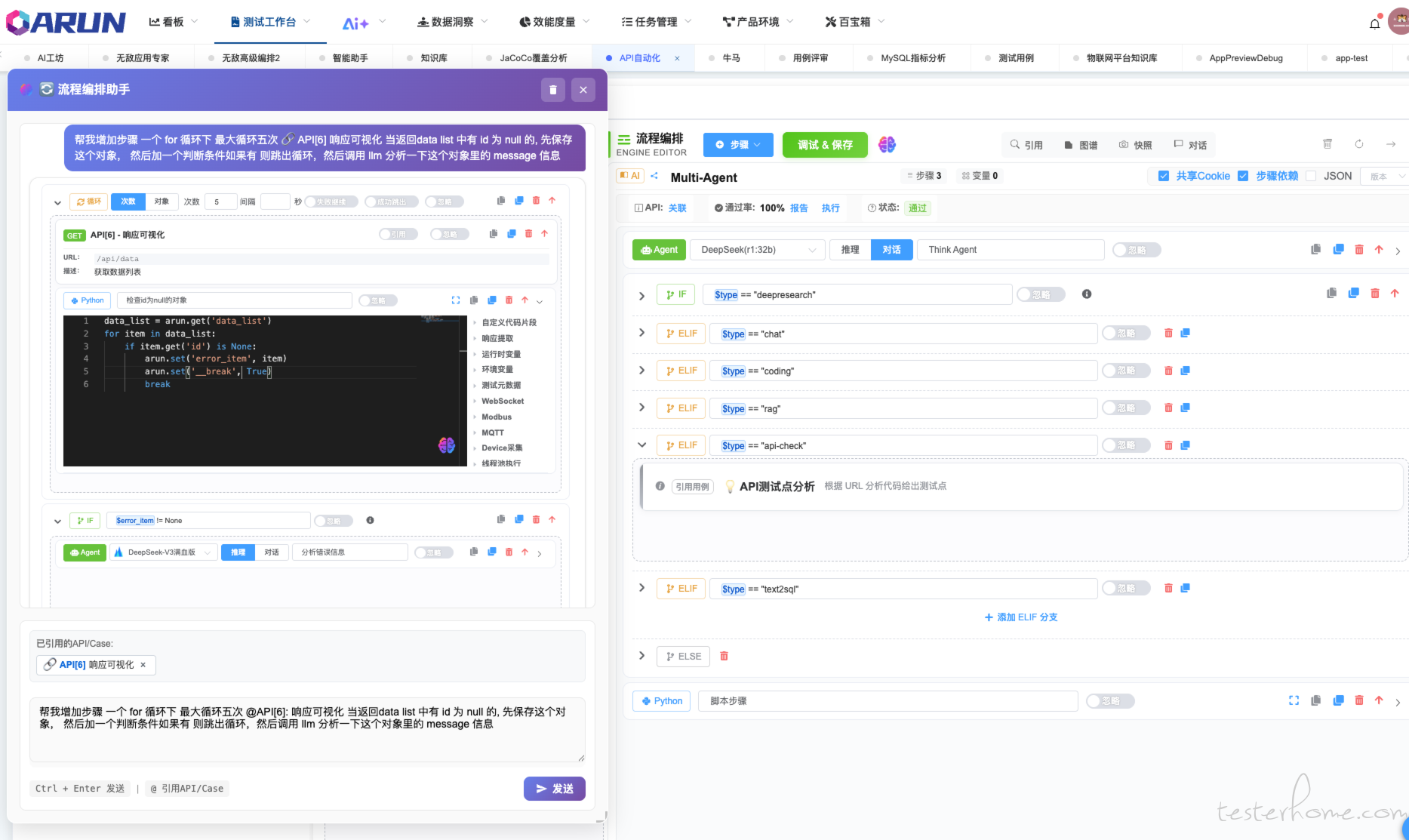

2. 智能测试流程编排 Agent

核心能力

- 自然语言转工作流:通过描述测试场景自动生成测试流程

- 智能节点推荐:基于测试目标推荐合适的测试节点和工具

- 动态流程调整:根据执行结果智能调整后续流程

- 异常自愈能力:自动识别和处理流程执行中的异常

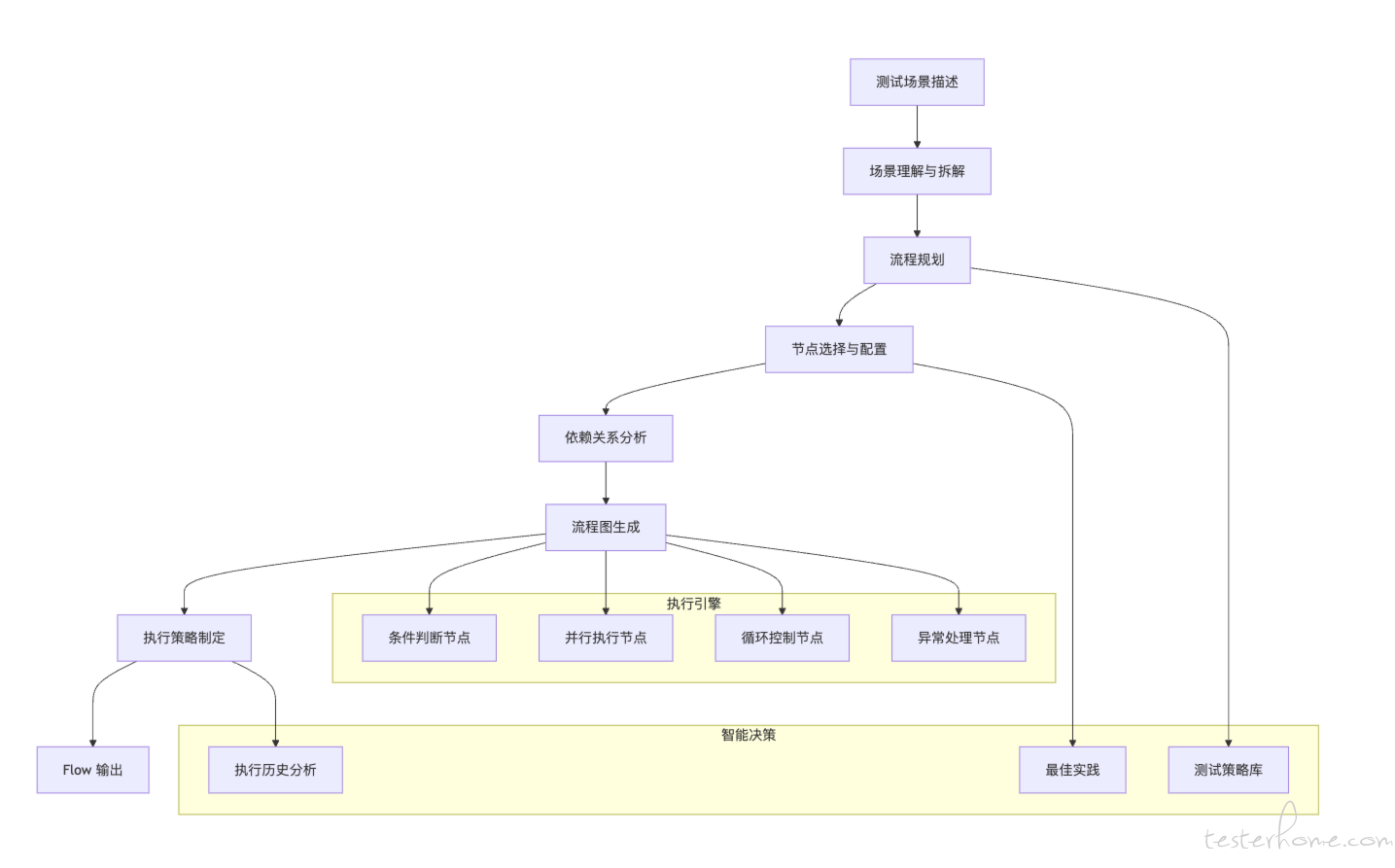

Flow 生成 Agent 工作流程

技术实现示例

class TestFlowGenerationAgent:

def __init__(self):

self.llm = LLMService()

self.flow_analyzer = FlowAnalyzer()

self.node_registry = TestNodeRegistry()

async def generate_test_flow(self, scenario_description: str):

# 1. 场景理解与拆解

scenario = await self.llm.analyze_scenario(scenario_description)

# 2. 流程规划

flow_plan = await self.llm.plan_flow(

scenario=scenario,

available_nodes=self.node_registry.get_all_nodes(),

best_practices=await self._get_best_practices(scenario.domain)

)

# 3. 生成可执行流程

executable_flow = await self._build_executable_flow(flow_plan)

return executable_flow

async def _build_executable_flow(self, plan: FlowPlan) -> ExecutableFlow:

nodes = []

for step in plan.steps:

node = await self._create_node(step)

nodes.append(node)

# 构建依赖关系

dependencies = await self._analyze_dependencies(nodes)

return ExecutableFlow(nodes=nodes, dependencies=dependencies)

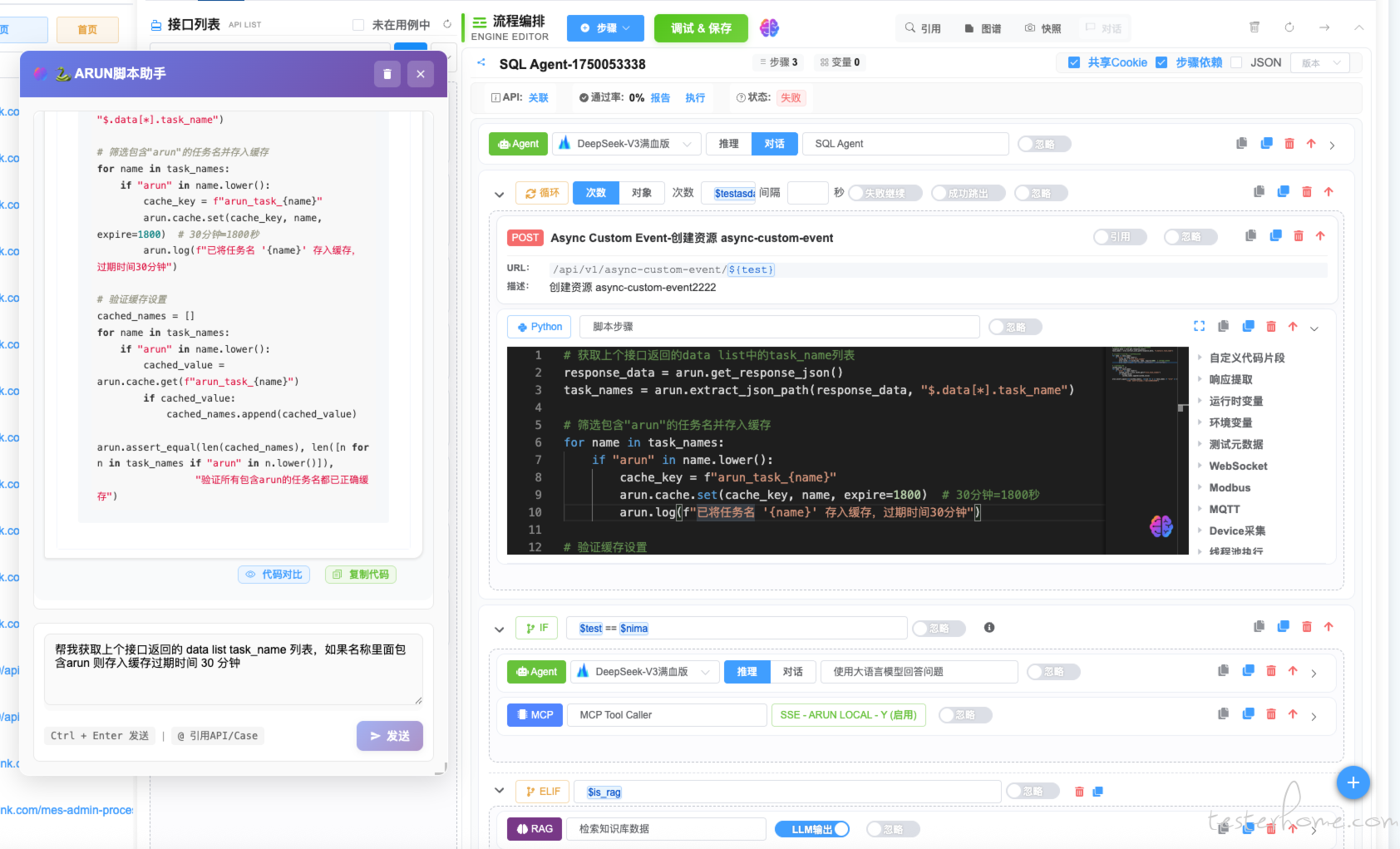

3. 智能测试代码生成 Agent

核心能力

- 多语言代码生成:支持 Python、Java、JavaScript 等多种测试框架

- 上下文感知编程:基于项目结构和现有代码风格生成一致的测试代码

- 框架适配:自动适配 pytest、unittest、Jest 等主流测试框架

- 最佳实践融入:自动应用测试编码最佳实践

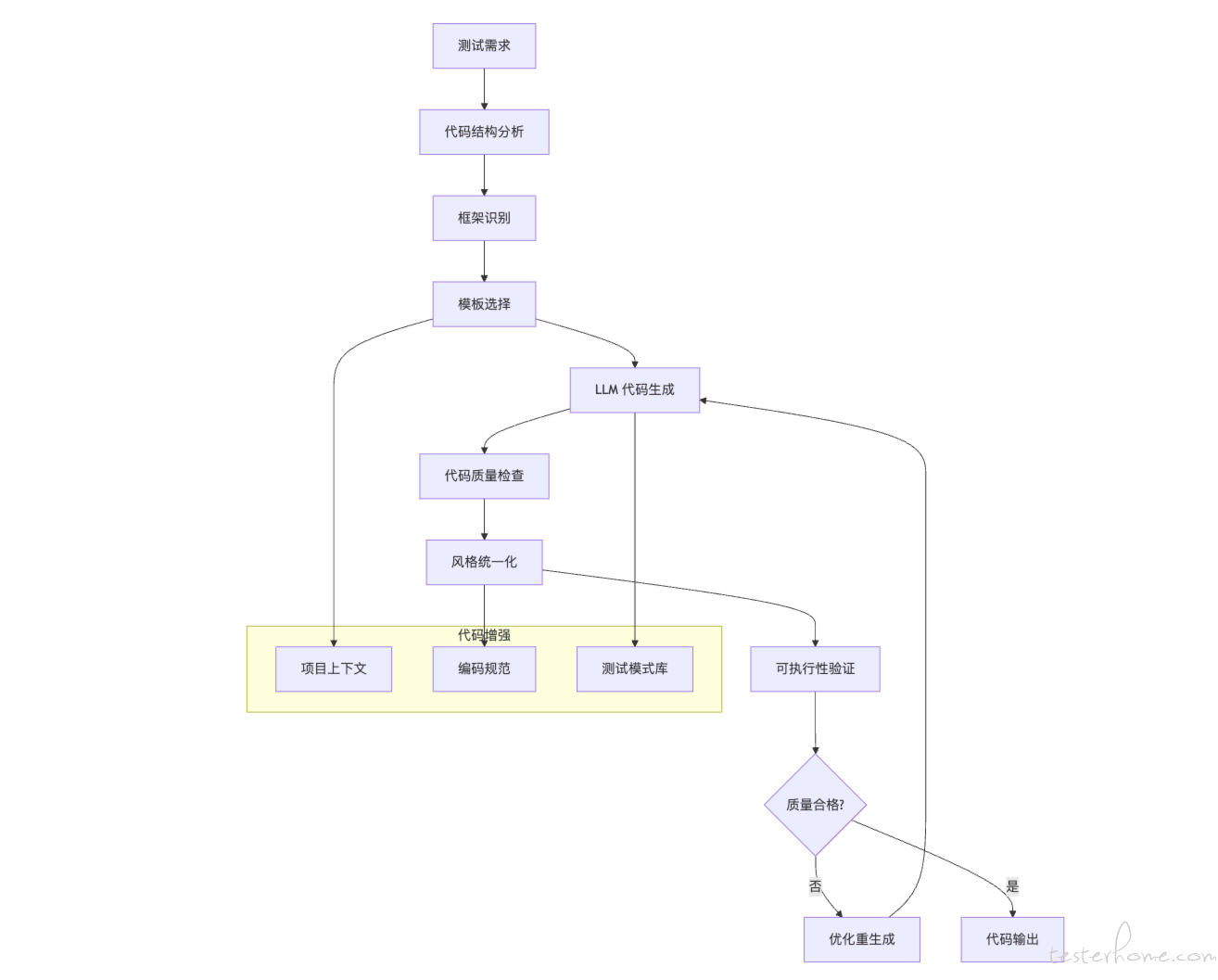

Code Generation Agent 工作流程

技术实现示例

class TestCodeGenerationAgent:

def __init__(self):

self.llm = CodeLLMService()

self.code_analyzer = CodeAnalyzer()

self.quality_checker = CodeQualityChecker()

async def generate_test_code(self, test_case: TestCase, context: ProjectContext):

# 1. 分析项目结构和代码风格

project_analysis = await self.code_analyzer.analyze_project(context)

# 2. 生成测试代码

generated_code = await self.llm.generate_code(

test_case=test_case,

framework=project_analysis.test_framework,

style_guide=project_analysis.coding_style,

existing_patterns=project_analysis.test_patterns

)

# 3. 质量检查和优化

quality_result = await self.quality_checker.check(generated_code)

if not quality_result.is_acceptable:

generated_code = await self._optimize_code(generated_code, quality_result)

return generated_code

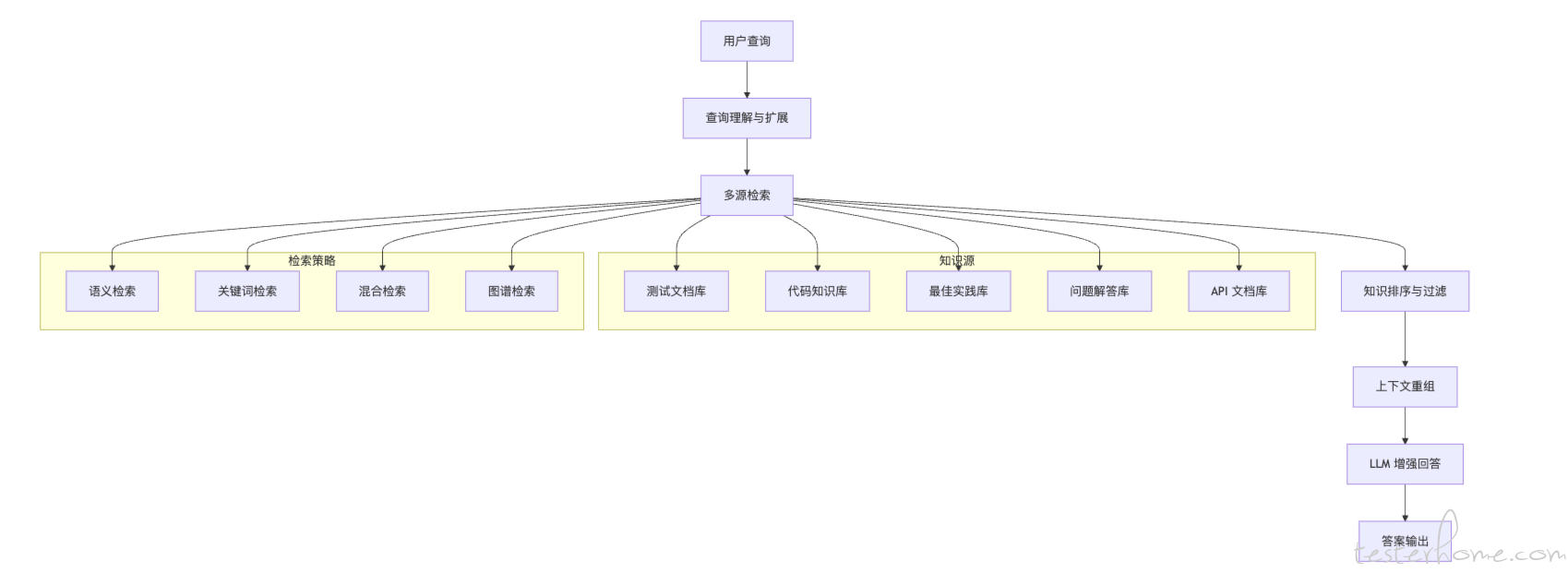

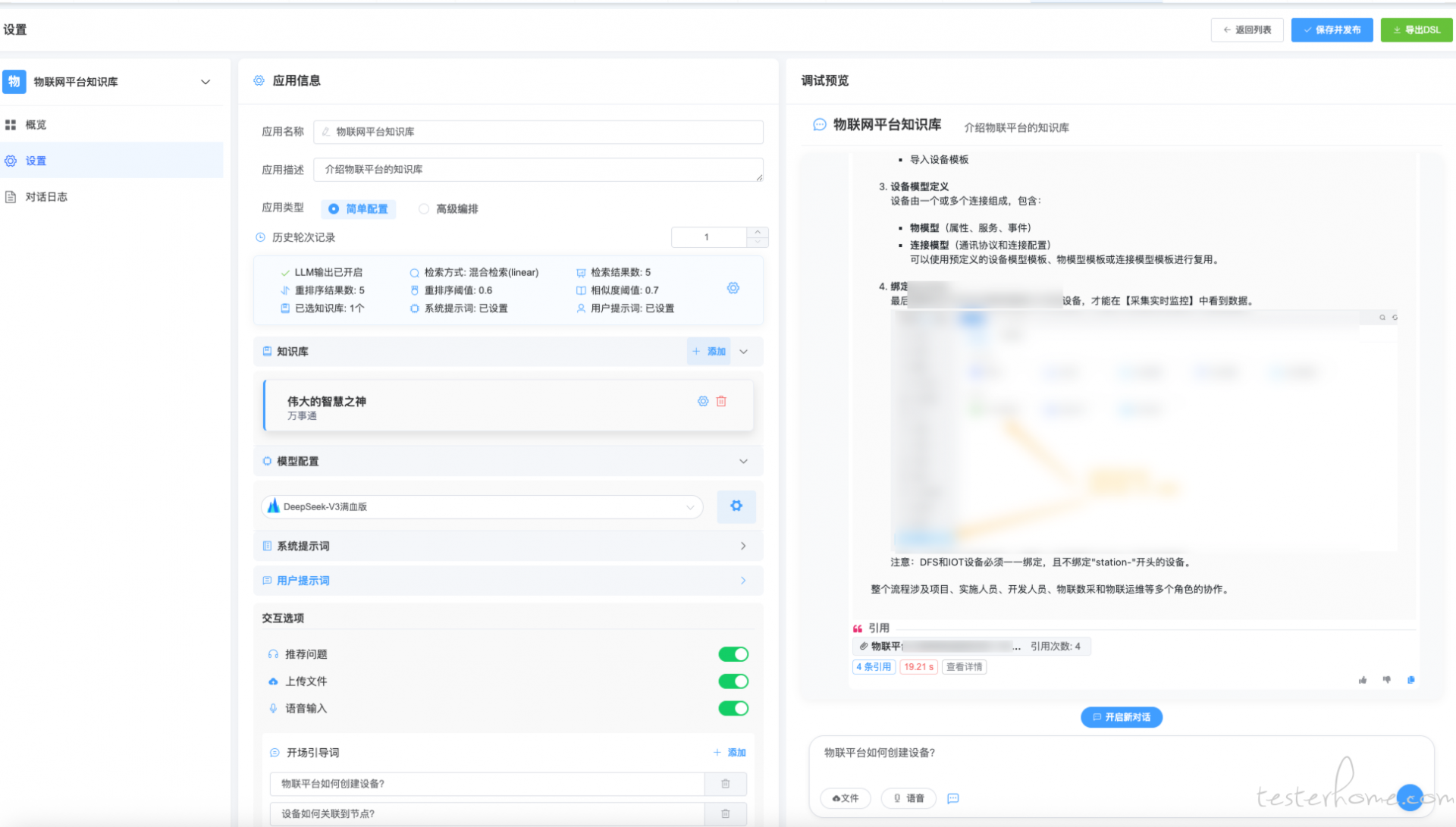

4. 测试知识检索增强 Agent (RAG)

核心能力

- 多源知识整合:整合测试文档、代码库、经验库等多种知识源

- 智能知识检索:基于语义理解的精准知识检索

- 上下文增强:为其他 Agent 提供相关背景知识

- 动态知识更新:持续学习和更新测试知识库

RAG Agent 工作流程

技术实现示例

class TestKnowledgeRAGAgent:

def __init__(self):

self.vector_store = VectorStore()

self.llm = LLMService()

self.knowledge_graph = KnowledgeGraph()

self.embedding_model = EmbeddingModel()

async def retrieve_and_generate(self, query: str, context: Optional[str] = None):

# 1. 查询理解和扩展

expanded_query = await self.llm.expand_query(query, context)

# 2. 多策略检索

semantic_results = await self._semantic_retrieval(expanded_query)

keyword_results = await self._keyword_retrieval(expanded_query)

graph_results = await self._graph_retrieval(expanded_query)

# 3. 结果融合和排序

combined_results = await self._combine_and_rank(

semantic_results, keyword_results, graph_results

)

# 4. 上下文增强生成

enhanced_answer = await self.llm.generate_with_knowledge(

query=query,

retrieved_knowledge=combined_results,

context=context

)

return enhanced_answer

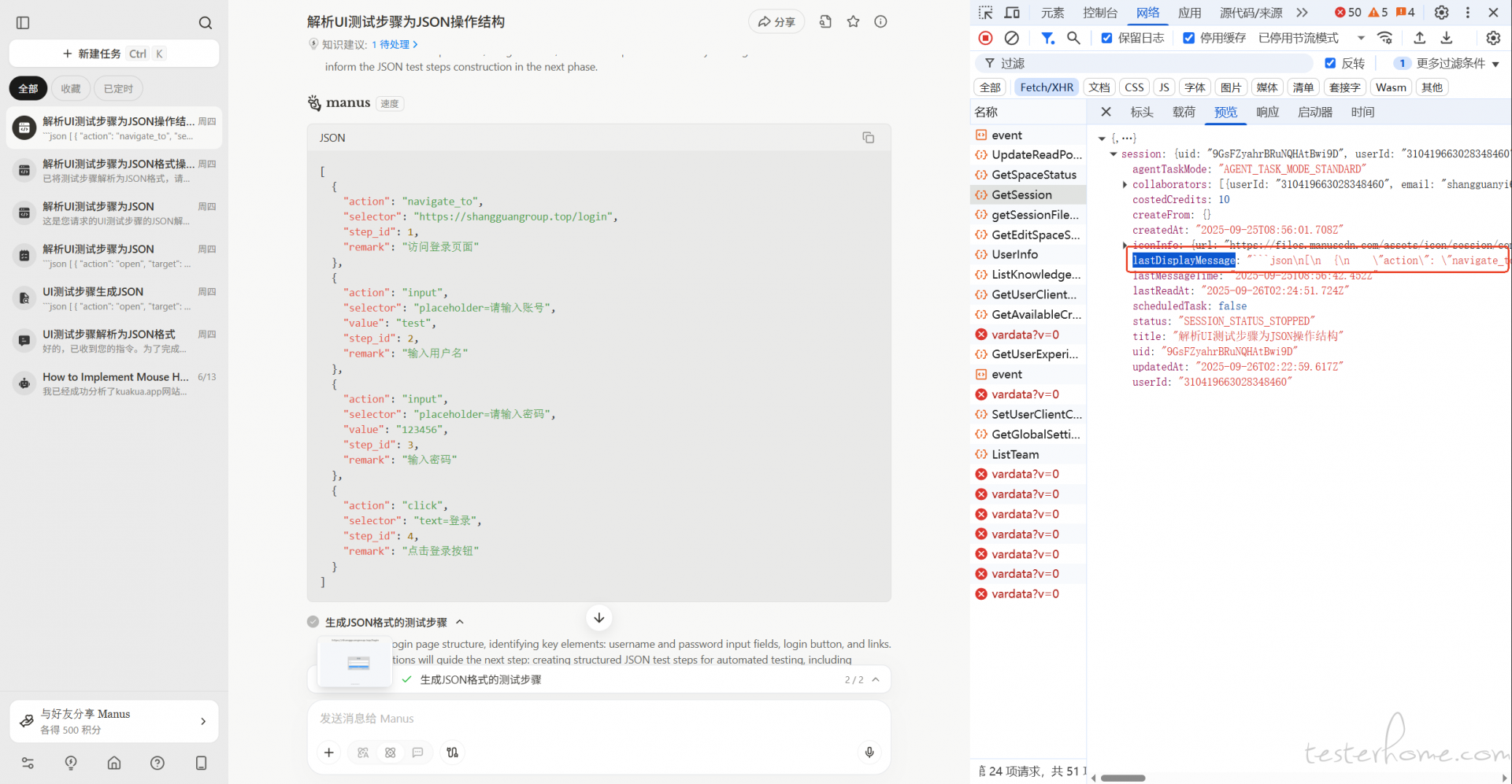

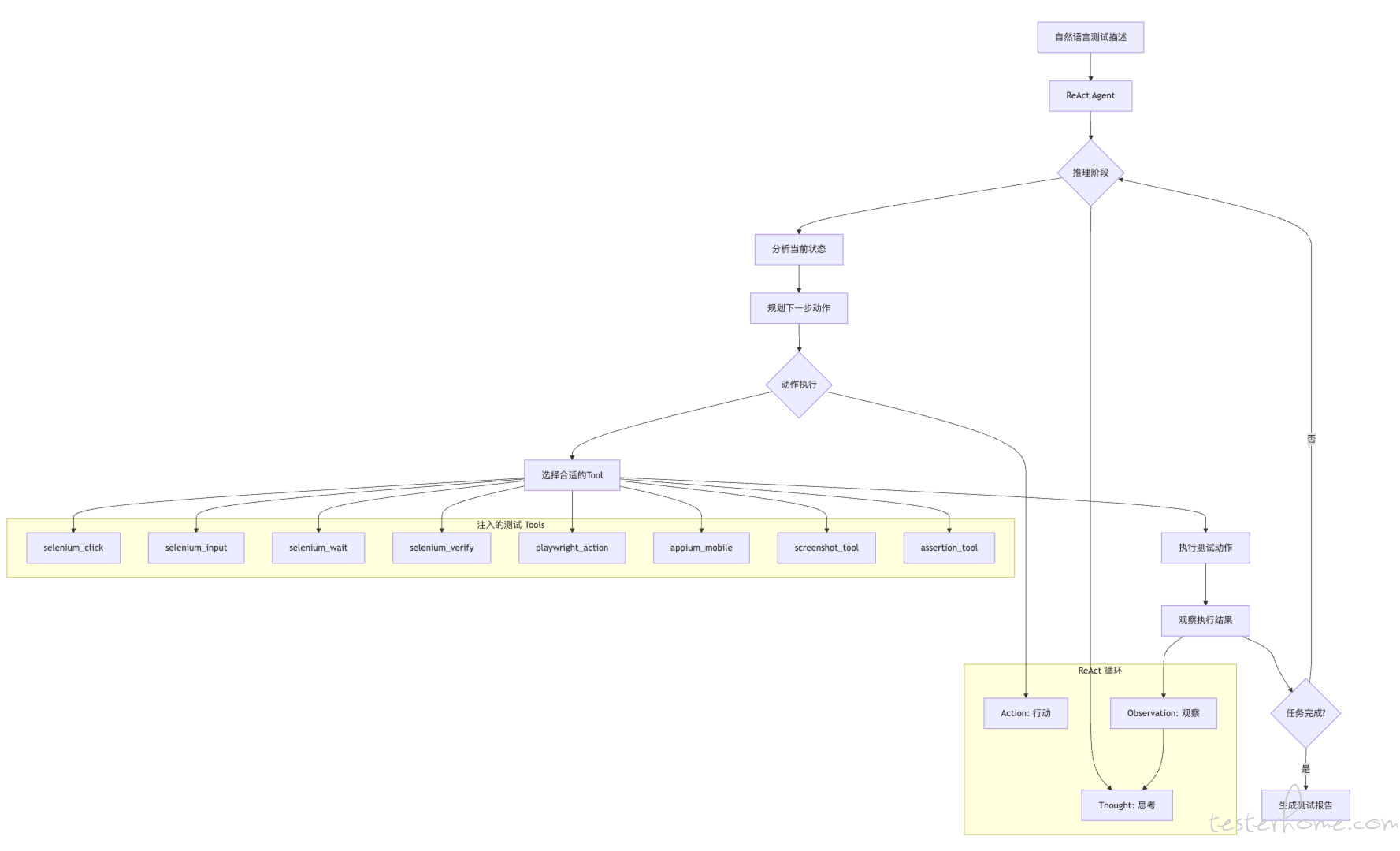

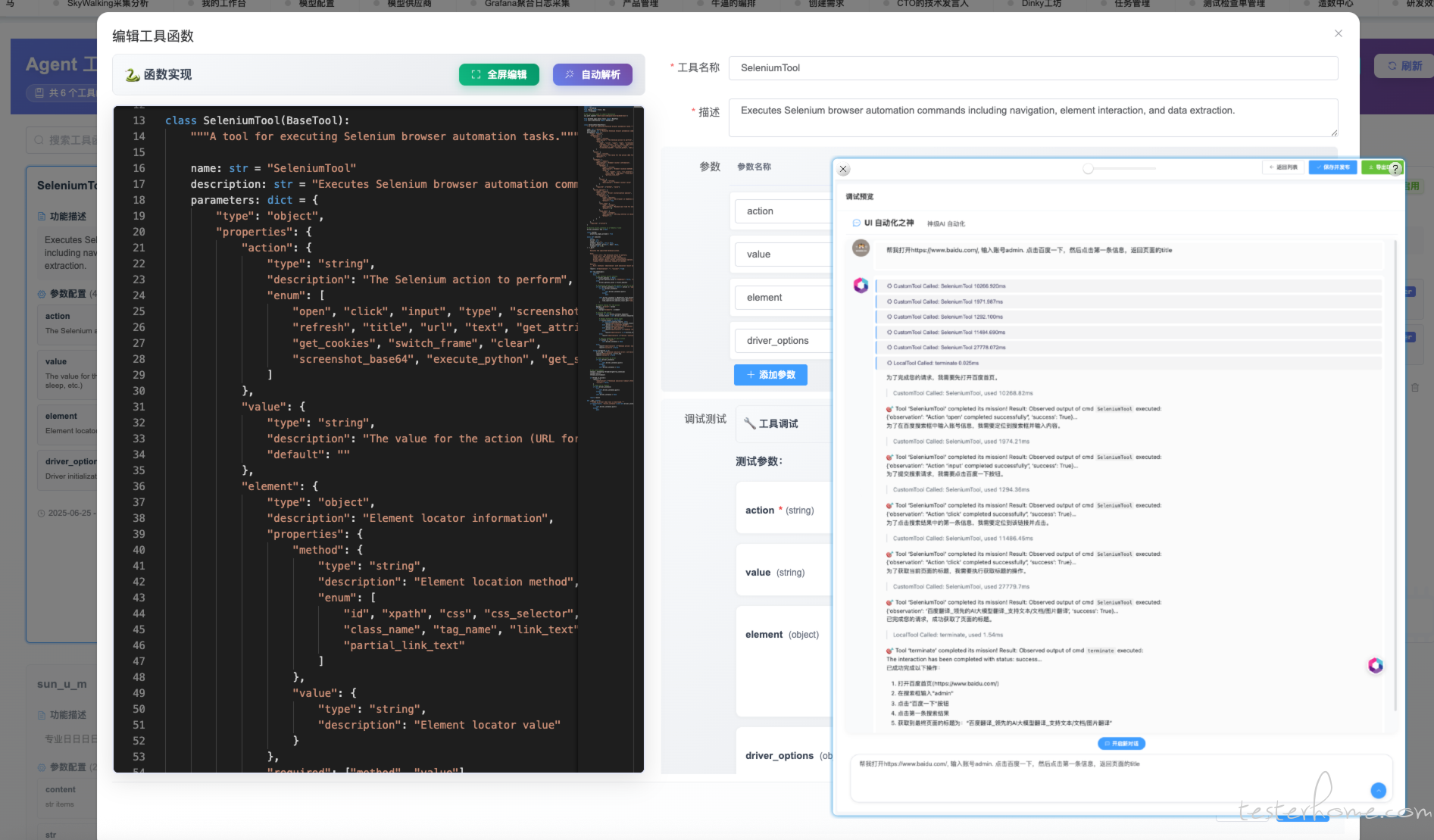

5. 自然语言驱动的行为测试 Agent

核心能力

- 自然语言行为描述:通过简单的自然语言描述测试行为和动作

- ReAct 智能决策:基于 ReAct (Reasoning + Acting) 模式,LLM 动态推理并选择合适的测试工具

- 工具动态注入:将 Selenium、Playwright 等测试工具作为 tools 注入给 Agent

- 实时交互执行:Agent 根据执行结果实时调整后续行为策略

自然语言测试示例

🤖 Multi-Agent 协作系统

Agent 间协作流程

技术创新点

1. 多模态理解能力

class MultiModalTestAgent:

async def understand_requirement(self, inputs: MultiModalInputs):

# 文本理解

text_understanding = await self.text_processor.process(inputs.text)

# 代码分析

if inputs.code:

code_analysis = await self.code_analyzer.analyze(inputs.code)

# 文档解析

if inputs.documents:

doc_analysis = await self.doc_parser.parse(inputs.documents)

# 多模态融合

fused_understanding = await self.fusion_module.fuse([

text_understanding, code_analysis, doc_analysis

])

return fused_understanding

2. 自适应学习机制

class AdaptiveLearningAgent:

def __init__(self):

self.feedback_collector = FeedbackCollector()

self.model_optimizer = ModelOptimizer()

self.knowledge_updater = KnowledgeUpdater()

async def learn_from_feedback(self, task_result: TaskResult, user_feedback: Feedback):

# 收集反馈数据

feedback_data = await self.feedback_collector.collect(task_result, user_feedback)

# 更新模型参数

if feedback_data.should_update_model():

await self.model_optimizer.update(feedback_data)

# 更新知识库

await self.knowledge_updater.update_knowledge_base(feedback_data)

3. Chain-of-Thought 推理

class ChainOfThoughtAgent:

async def solve_complex_test_scenario(self, scenario: ComplexScenario):

# 分解问题

sub_problems = await self.llm.decompose_problem(scenario)

# 逐步推理

reasoning_chain = []

for problem in sub_problems:

step_result = await self.llm.reason_step(

problem=problem,

previous_steps=reasoning_chain,

domain_knowledge=await self.rag.retrieve_knowledge(problem)

)

reasoning_chain.append(step_result)

# 综合解决方案

final_solution = await self.llm.synthesize_solution(reasoning_chain)

return final_solution

4. 实时反馈与优化

通过持续的人机交互实现 Agent 能力提升:

- 实时质量评估:对生成结果进行实时质量评估

- 用户反馈集成:将用户反馈融入模型优化过程

- 增量学习:基于新的测试场景持续改进 Agent 能力

🎯 Agentic Testing 方法论的变革意义

Agentic Testing 作为 Agentic X 方法论在测试领域的具体实践,可能标志着测试工程方式的根本性变革:

方法论探索

- 自然语言优先:将自然语言作为测试工程的主要交互方式

- 智能化推理决策:基于 LLM 的强大推理能力进行测试策略制定

- 多 Agent 协作模式:构建专业化智能体协作网络,解决复杂测试挑战

- 持续自适应学习:通过实践反馈不断优化测试方法和策略

实践价值

- 普及智能化:让任何人都能运用 AI 能力进行专业测试工作

- 提升精准度:基于深度理解的测试设计,确保高质量的测试覆盖

- 加速迭代:从需求到测试实现的端到端智能化流程

- 经验传承:将专家知识和最佳实践嵌入到智能化工作流程中

Agentic X 的无限可能

Agentic Testing 仅仅是 Agentic X 方法论的一个应用示例:

- X = Any Domain:这种智能化方法论可以应用于任何需要专业知识和推理能力的领域

- X = Any Process:从业务分析到产品设计,从运营优化到决策支持

- X = Any Scale:从个人工作效率到企业级数字化转型

通过 Agentic X 方法论,我们正在见证人工智能从工具向协作伙伴的历史性转变,开启智能化工作的新时代。

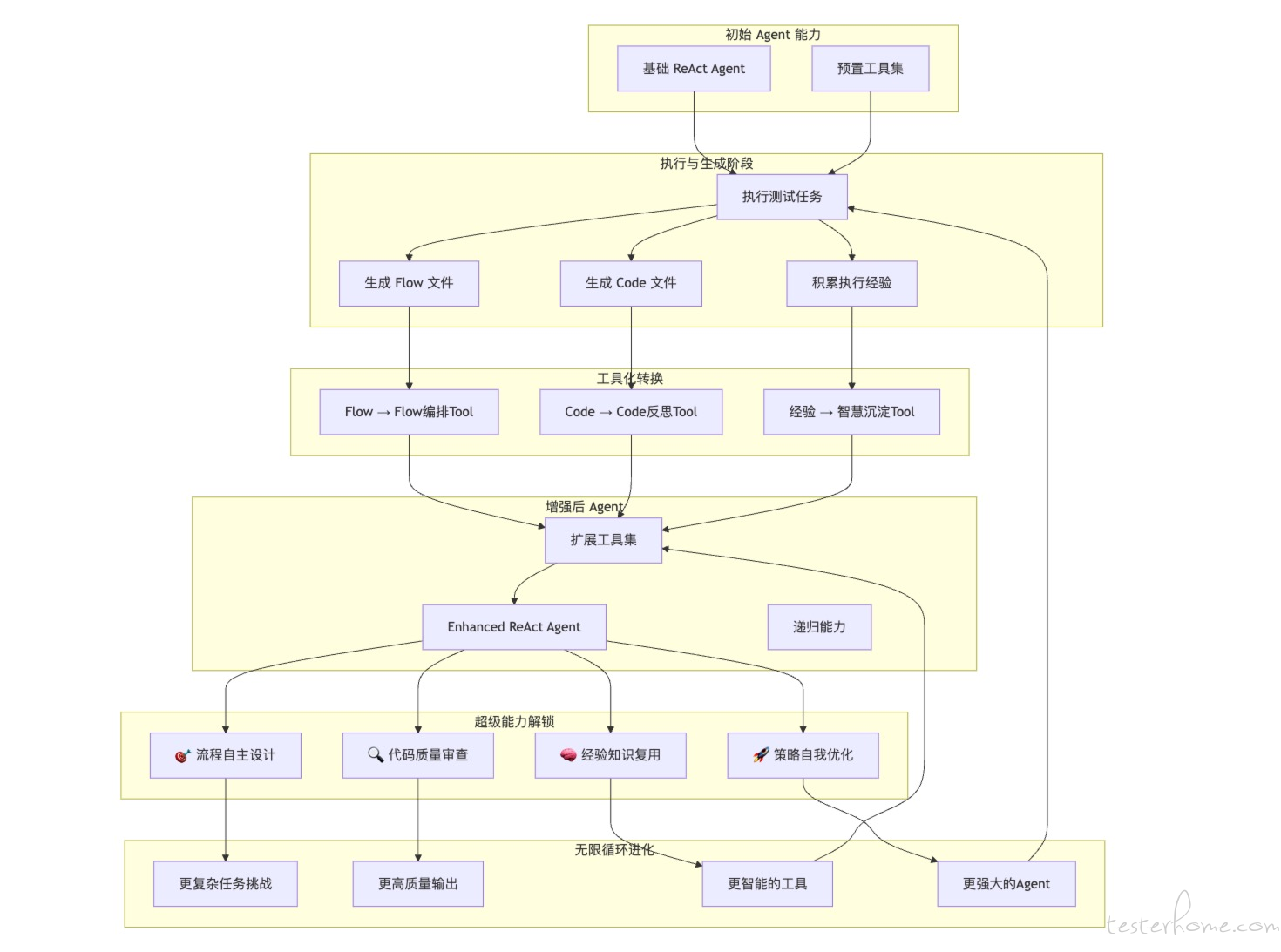

🚀 惊叹发现:自我增强的递归智能

等等!我们发现了什么?

在 ReAct Agent 执行过程中,一个令人震撼的现象出现了:Agent 不仅在使用工具,更在创造工具!

当 Agent 生成测试 Flow 和 Code 时,这些产出不仅仅是结果,它们本身就可以成为新的 LLM Tool!这意味着:

- 🔄 生成的 Flow → Flow 编排 Tool → Agent 获得流程设计能力

- 💻 生成的 Code → Code 反思 Tool → Agent 获得代码审查能力

- 🧠 积累的经验 → 智慧沉淀 Tool → Agent 获得专家级判断力

🌟 递归增强架构:Agent 的自我进化

💡 这意味着什么?

这不仅仅是工具的进化,而是智能的递归爆炸!

- 自我编程能力:Agent 可以编写和优化自己的工具

- 经验自动沉淀:每次执行都让 Agent 变得更聪明

- 无限扩展可能:工具库随着使用而自动增长

- 专家级进化:从通用 AI 向领域专家的自然演化

🔮 未来愿景:无限进化的智能体

想象一下,当 Agent 开始为自己创造工具时:

- 📈 指数级能力增长:每个任务都是能力提升的机会

- 🌐 跨领域知识迁移:在测试中学到的模式可以应用到开发、运维...

- 🧬 智能基因传承:优秀的 Flow 和 Code 模式自动复制传播

- ∞ 无限递归可能:Agent 创造的工具又可以创造更好的工具...

这就是 Agentic X 的终极形态:不仅是方法论的实践,更是智能体的自我进化!