Linux Linux 三剑客

环境

- windows git bash

- mac iterm term

- 用自己的帐号登录 ssh 手机号码后 8 位@shell.testing-studio.com

- 没有账号的可以临时用 ssh hogwarts2019@shell.testing-studio.com

- /tmp/nginx.log 保存了一份一天的 nginx 访问 log

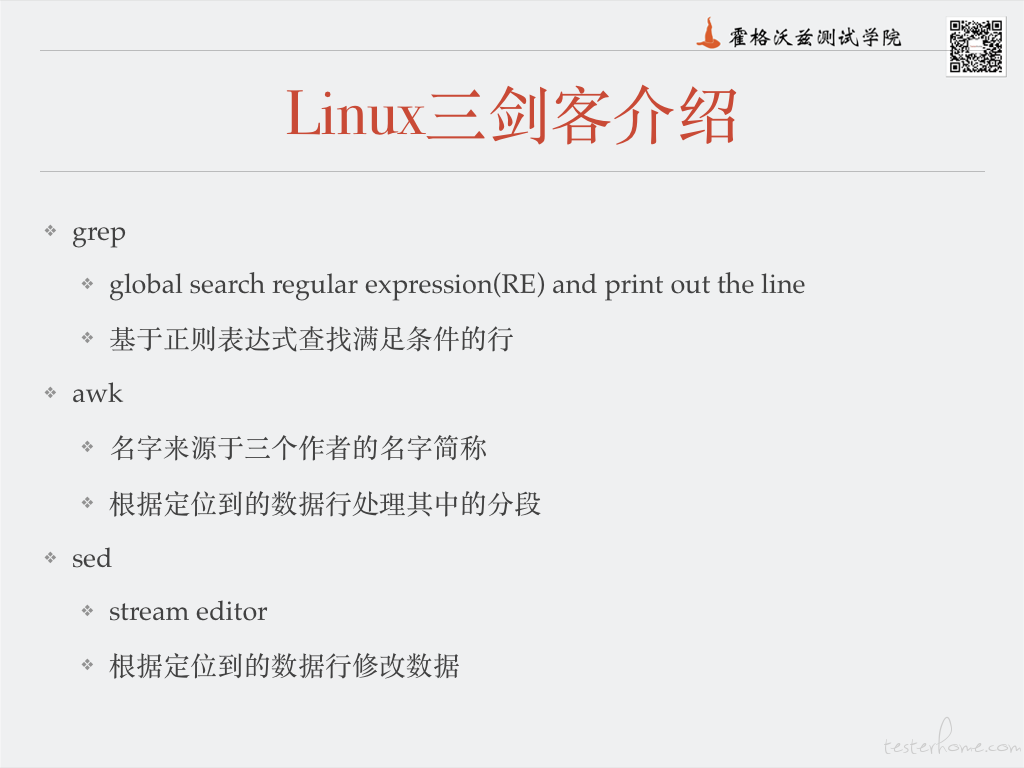

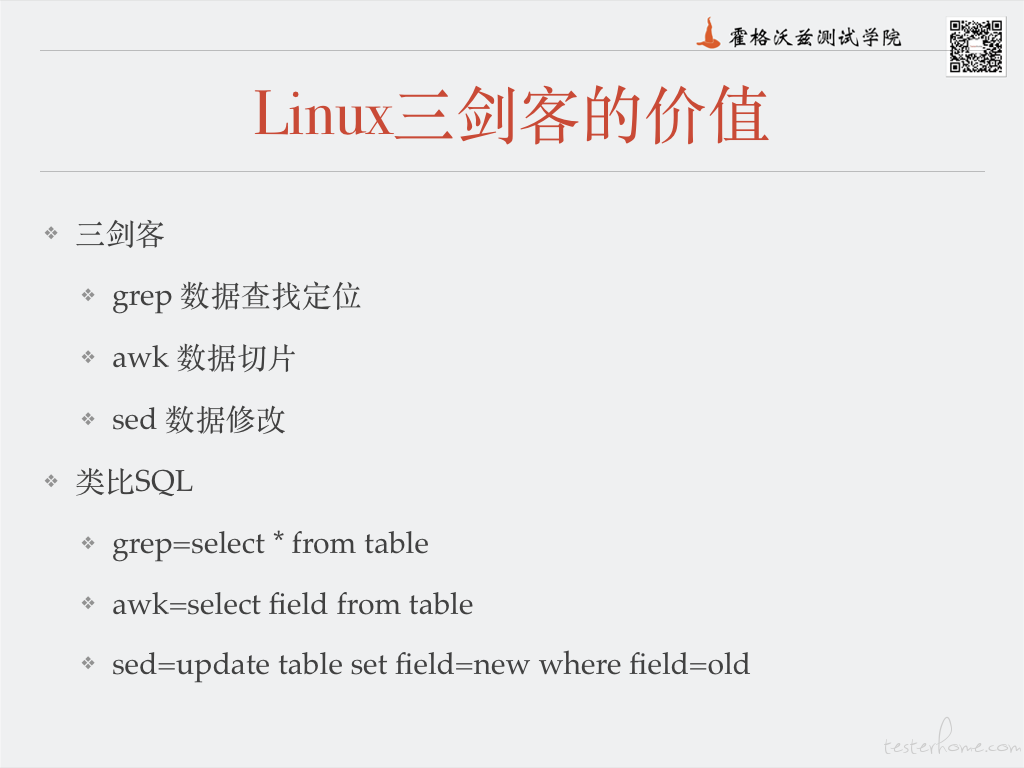

Linux 三剑客介绍

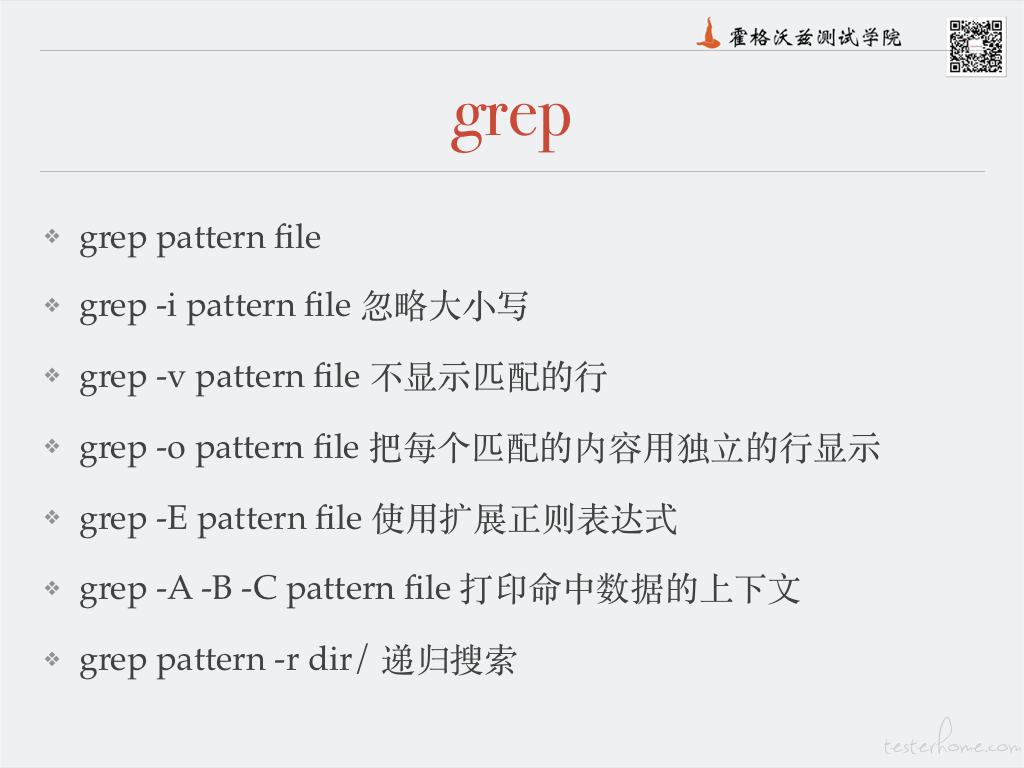

Grep

ps -ef | grep bash

echo "ABC" | grep -i abc

ps -ef | grep bash | grep -v grep

echo "1234 7654" | grep -o "[0-9]4"

echo "1234 7654" | grep -oE "[0-9]4|76"

测试题

- 找出 nginx.log 中所有 404 和 503 报错的 log 数据,取出前 3 条数据,把命令贴到回复里

- 找出 testerhome 首页的所有 http 和 https 的链接

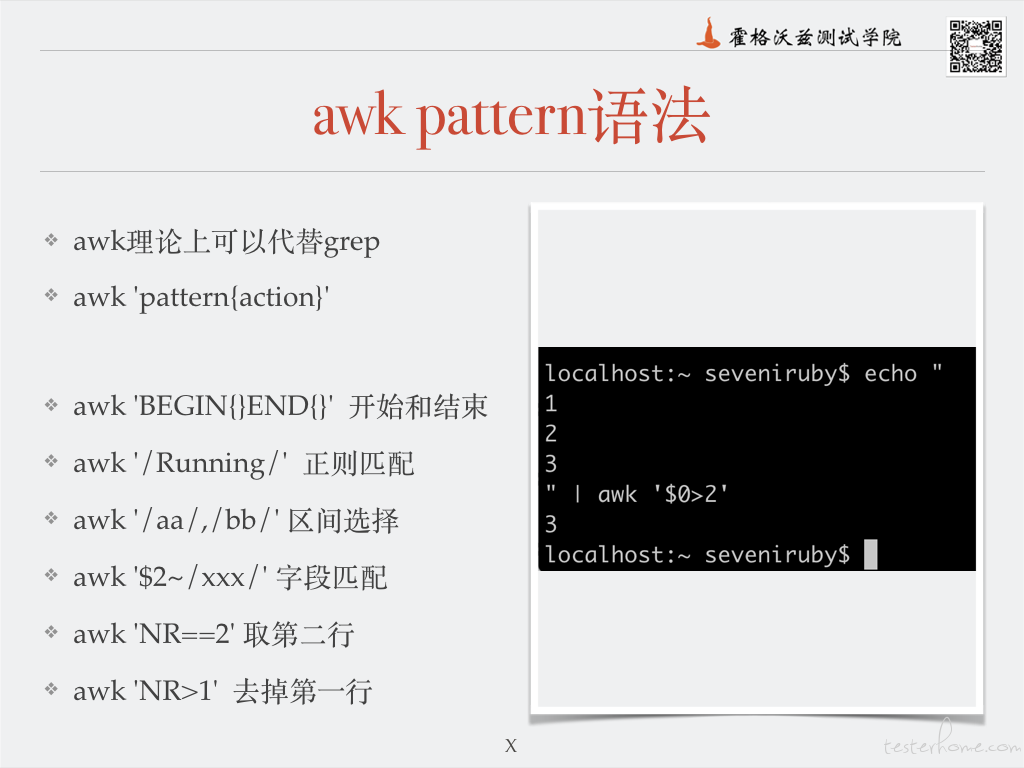

awk

ps | awk 'BEGIN{print "start"}{print $0}END{print "end"}'

awk '/ 404 | 500 /' /tmp/nginx.log

echo '1

2

3

4

5' | awk '/2/,/4/'

echo '1

2

3

4

5' | awk '$0>3'

ps | awk 'NR>1'

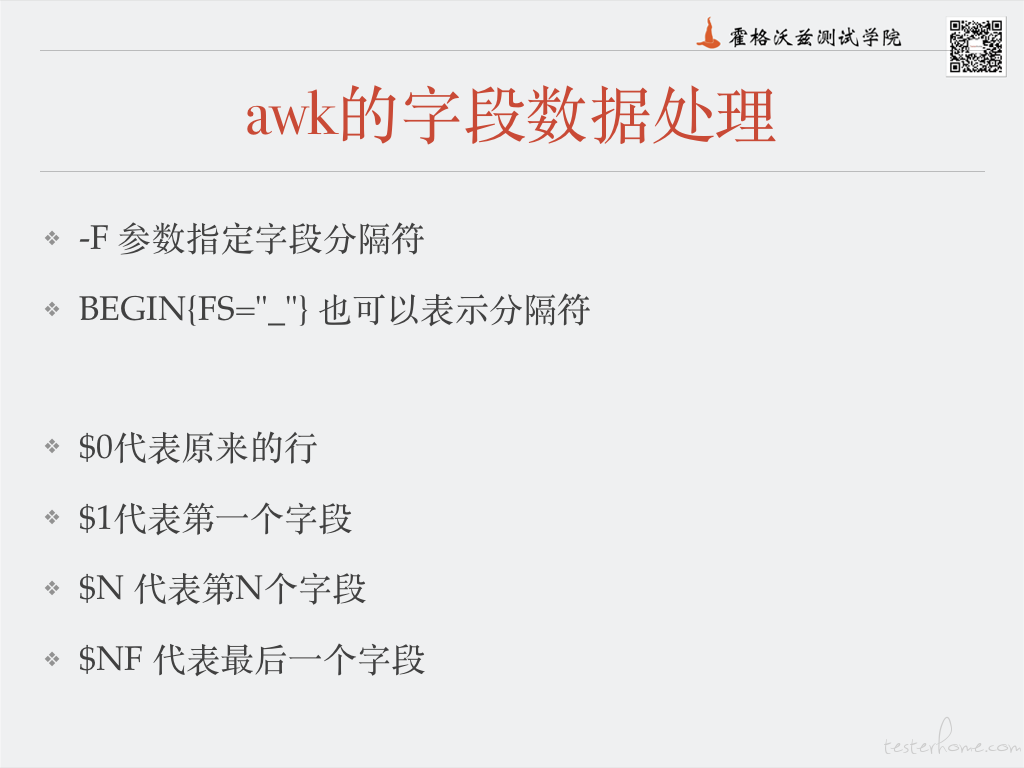

ps | awk '{print $NF}'

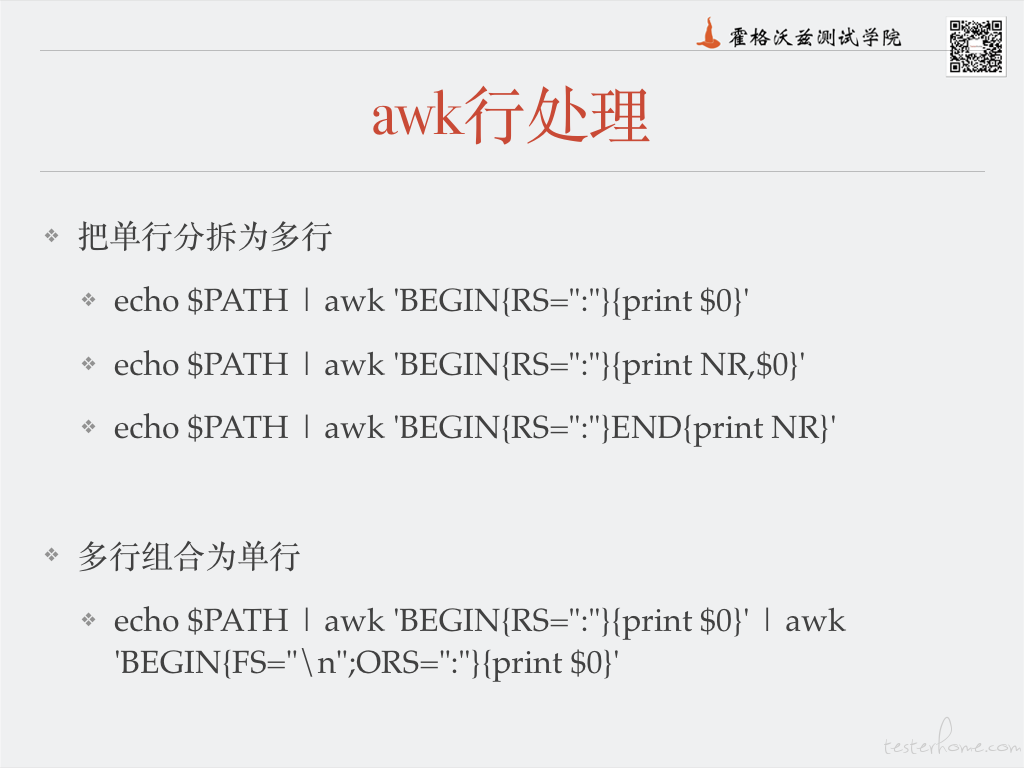

echo $PATH | awk 'BEGIN{RS=":"}{print $0}' | grep -v "^$" | awk 'BEGIN{FS="\n";ORS=":"}{print $0}END{printf "\n" }'

echo '1,10

2,20

3,30' | awk 'BEGIN{a=0;FS=","}{a+=$2}END{print a,a/NR}'

awk 'BEGIN{print 33*20*76/200/3}'

echo "123|456_789" | awk 'BEGIN{FS="\\||_"}{print $2}'

echo "123|456_789" | awk "BEGIN{FS=\"\\\\||_\"}{print \$2}" #尽量使用单引号

测试题

- 找出 404 和 500 的数据,只打印状态码这一列,然后排序去重。把命令贴到回复里

- 去 testerhome 首页找到所有的 http 的连接,然后打印不带 http 的纯域名部分

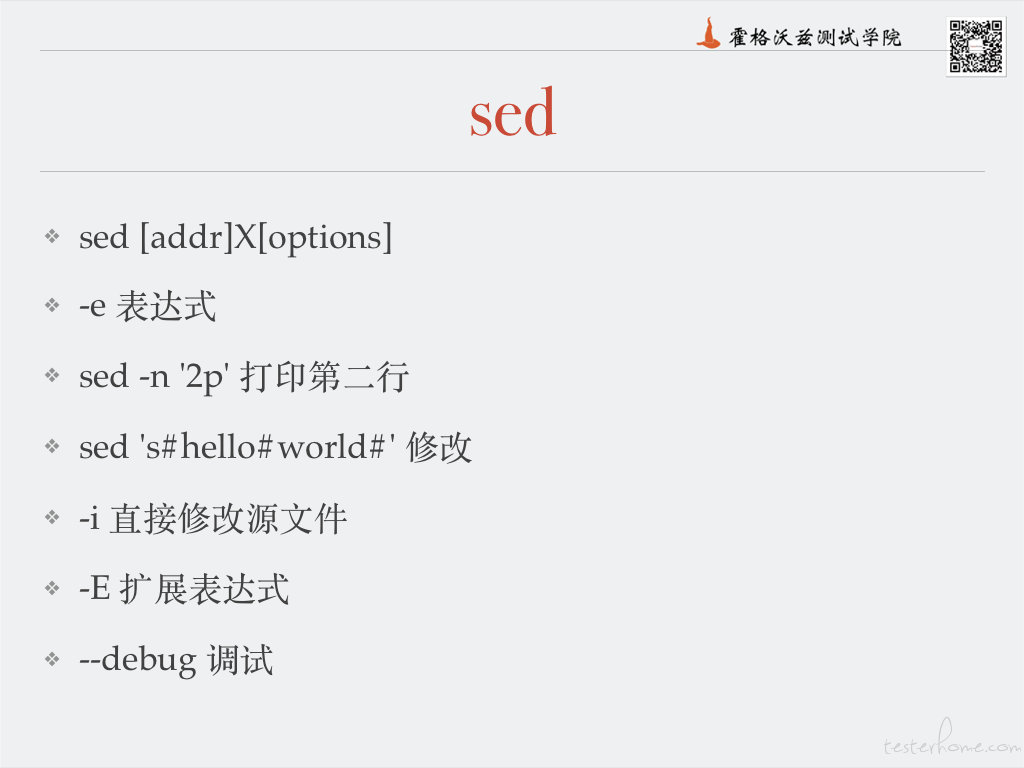

sed

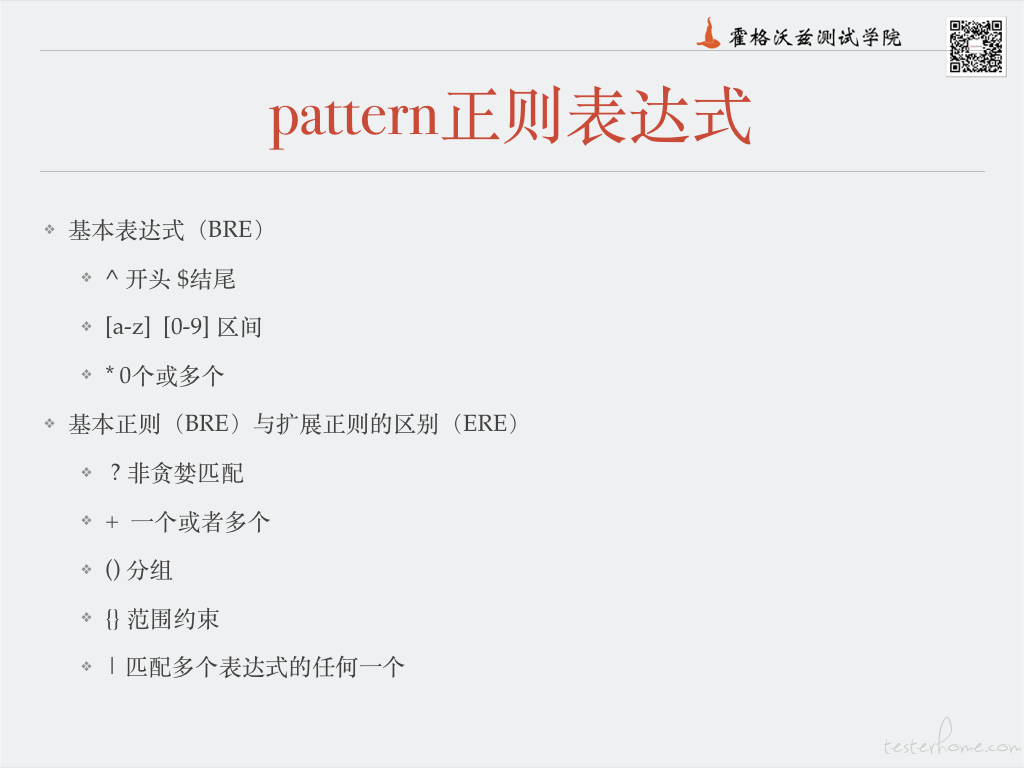

pattern 表达式

- 20 30,35 行数与行数范围

- /pattern/ 正则匹配

- //,// 正则匹配的区间

action

- d 删除

- p 打印,通畅结合-n 参数

- s/REGEXP/REPLACEMENT/[FLAGS]

- 替换时引用 \1 \2 匹配的字段

ps | sed -n 1,3p

ps | sed 's/CMD/command/'

ps | sed -n '/ps/p'

echo '1

2

3

4

5' | sed -n '/3/,/4/p'

echo '1

2

3

4

5' | sed '/3/,/4/d'

ps | sed -e 's/CMD/command/' -e 's#00#20#g'

测试题

- 对所有 404 500 的数据,统计出现这种状态码的 url,需要对 url 汇总(汇总相似的 url,把相同的资源但是变化的 id 去掉)去重,打印前 5 个出问题的路径,把命令贴到回复里

演练

如果觉得我的文章对您有用,请随意打赏。您的支持将鼓励我继续创作!