这是鼎叔的第一百零三篇原创文章。行业大牛和刚毕业的小白,都可以进来聊聊。

欢迎关注本公众号《敏捷测试转型》,星标收藏,大量原创思考文章陆续推出。

当前,AI 大模型成为最热门的概念时,每个公司都在学习和实践 AI 技术,大家对于测试和效能工作的未来也产生了更多的畅想。

作为非 AI 专业的技术团队负责人,如何帮助团队成员迈出 AI 学习和实践的第一步,是至关重要的。从实践认知出发,我推荐负责人可以做好这几方面的组织和指引:

营造机器学习/人工智能的基础理论学习氛围。

搜集和尝试业界经典的机器学习工具箱。

搜集可以供机器学习使用的业界或学界开放数据库资源。

探讨产品中可以引入机器学习的场景,如业务评测场景,测试活动场景,讨论哪一种机器学习模型适合应用在此场景,猜想能获得什么样的效果度量指标。

大胆鼓励有机器学习经验的同学进行上述场景的工程实验,可以安排资深的自动化测试工程师搭配他一起工作。

网上相关的教程很多,上手难度通常都不低,希望有意向成为 AI 实践高手的同学可以建立系统的长期学习和实验计划,欲速则不达。

下面按照机器学习不同的知识领域,先从数学和信息论开始,从经典理论和概念进行消化,简单介绍下自己是如何学习和思考其本质的。受限于本人在该领域的知识浅薄,如有错漏,敬请谅解。

高等数学相关知识

想学习 AI 的工程师,光有编码能力是不够的。数学,尤其是统计学是学习 AI 要跨过的门槛。学好统计学,不但有利于理解数据分析算法,还有利于度量体系建立和问题挖掘,受益终生。

鼎叔虽然是 985 数学系科班出身,但是高等数学与统计学学得非常惭愧,尴尬了。

借助从简单到复杂的统计指标及公式,我们可以更准确生动地描述对于数据的判断,凭此采取更优的改进措施。比如能反映样本数据偏差的平均值、加权平均、标准差、欧氏距离,曼哈顿距离等指标。再比如反映数据变化的同比和环比,反映二八分布原则的高斯分布,反映特定范围内随机事件发生概率的泊松分布,反映多次连续实验事件的成功概率的伯努利分布,等等。

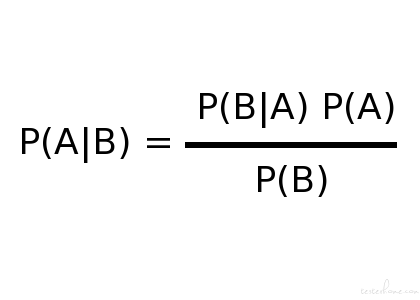

贝叶斯定律

贝叶斯定理告诉我们,如果你看到一个人经常做好事,那他多半就是个好人,用数学语言表达就是:支持某属性的事件发生得越多,则该属性成立的概率就越大。贝叶斯定律体现了先验概率的强大,条件概率很难显著改变它。

我们可以通过已知事件发生的概率,来推测相关的未知事件发生的概率。贝叶斯定律可以帮助我们解决生活中经常出现的逆向概率问题,从结果中推测造成结果的可能原因,比如医学诊断领域。

法国有个猜山羊和汽车的电视节目非常经典。舞台上有三扇关闭的门,其中一扇门后面有一辆汽车,另外两扇门后面各有一只山羊。主持人是知道哪扇门后面有汽车的。当竞猜者选定了一扇门但尚未开启它的时候,节目主持人去开启剩下两扇门中的一扇,露出的是山羊。主持人会问参赛者要不要改猜另一扇未开启的门。那么,改猜另一扇未开启的门是否比不改猜赢得汽车的概率要大?

正确的答案是:改猜能增大赢得汽车的概率,从原来的 1/3 增大为 2/3。这是因为竞猜者选定的一扇门后面有汽车的概率是 1/3,在未选定的两扇门后面有汽车的概率是 2/3,主持人开启其中一扇门把这门后面有汽车给排除了,所以另一扇未开启的门后面有汽车的概率是 2/3。

这个奥秘就在于一个事情被确认后就不再是未知的了,这个节目里主持人已经确认了哪扇门背后有汽车,他的行为就影响了概率分布。

贝叶斯分类算法在机器学习数据集较大的情况下,表现出了较高的准确性,得益于坚实的数学基础,避免了只使用先验概率的主观偏见,也避免了单独使用样本信息的过拟合现象。

朴素贝叶斯算法则进一步做了简化,它假定数据集属性之间是互相独立的,这样算法的健壮性比较好,对于不同类型的数据集不会呈现出太大的差异性。

数据统计和真相

数据不能说明真相,它可能只代表了局部信息。我们可以看到企业报告里,虽然数据图表很清晰,但是真相可能被掩盖了起来,数据图表技巧成为强调虚假业绩的帮凶。有些企业汇报高手很擅长在数据报表中掩盖真相,比如用整体趋势掩盖分组趋势,或者反之。

批判性思维这门课也告诉我们,很多媒体误导群众的观点,利用了幸存者偏差和选择性偏差。

前者是只显示了部分样本,从而导致错误的推断,比如对二战飞机中弹后返航进行统计,发现弹孔都不在发动机位置,得到结论是 “应该对发动机以外的部位进行装甲强化处理”。真实结果恰恰相反,能返航的飞机都是幸存者,而发动机中弹的飞机大部分都无法返航,所以结论应该是加强对发动机部位的装甲强化。

选择性偏差就是样本不均衡,像有的问卷调查,持正面观点的人可能就没有兴趣回答问卷,而有些地域特征的问卷没有发到对应地域的用户手上,克服选择性偏差就需要样本足够大,而且抽样随机。

对于大模型的训练,数据的偏差更有危害性和隐蔽性,将来我们围绕这点再深入分析。

有几个常见的统计概念:均值,中位数(按排序的中间值),众数(出现最多的值),用于不同场景需要谨慎挑选。比如评价工资水平,一般用中位数,因为低薪人员很容易被少量高薪人员把工资拉平均了。

人们拿到数据进行分析,最容易犯的错误就是混淆了相关性和因果性,因果性需要很强的证明过程,而相关性则不需要,因此会被别有用心的人滥用。

所谓数据,就是可被记录和识别的有意义的符号,它可以连续也可以离散。数据可以有多个维度,出现的概率低并不代表风险低,因为人的动机和行为,预测结果往往会因为人而改变。

高等数学中的矩阵计算、微积分、向量、数值分析等知识,对于 AI 学习入门也是至关重要的。

比如向量就是各种特征量数据的集合,多个向量排练一起就是矩阵,一次运算求解方程组就用了矩阵的性质。

信息论相关基础

学习信息论,有利于深入理解大数据和 AI。信息论本来是用于数字通信的,它研究如何打通数字世界和现实世界的计算模型,而人工智能的目标也是获取新的信息结论。

信息论中最重要的是香农定律、信息量计算、信息熵等概念。我们的大数据存储和压缩处理也是在去冗余化和提高计算速度之间取得平衡。信息安全知识也是重要的基础内容,它有利于研究人工智能编程的可靠性。

信息

信息,就是被消除的不确定性。当你有了批判性思维,就不容易被一篇网络文章消除不确定性(用人话说,就不容易盲信他人)。

鼎叔常挂在嘴边的一个词,就是” 信息密度 “,一本书好不好,最重要的指标就是” 信息密度 “高不高,但它和具体的人有关。看起来信息密度很高的书,可能对我没有太大启发,因为大部分内容我已经习得了。

鼎叔从工作中得到的启示是,测试工作的本质,也是获得新的信息(确定性),如果测试的目标只是尽快让用例通过,那获得的知识就无形之间被最小化了。

在互联网时代,碎片化信息更容易被获得,但无形之中降低了人们掌握完整知识的效率。AI 非常擅长构建知识图谱,但是缺乏常识,大模型的发展就是看 AI 如何更高效地掌握常识。

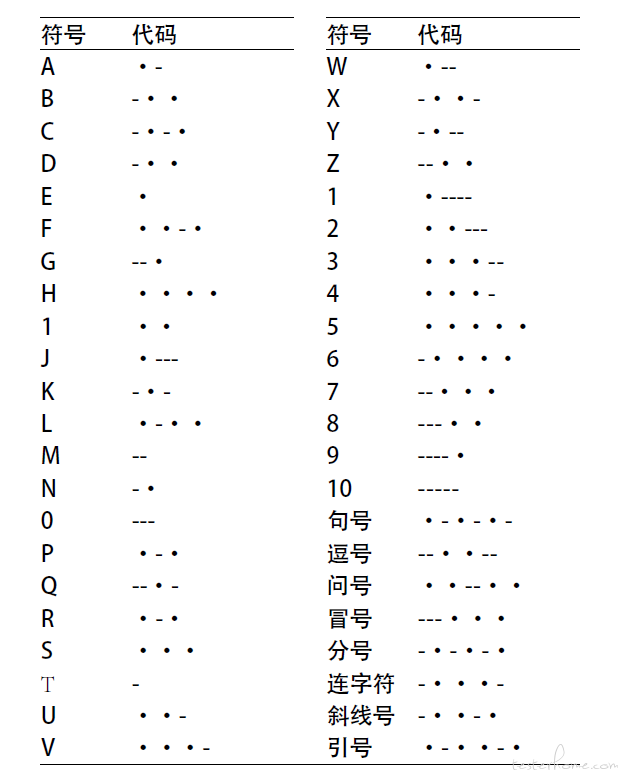

信息编码

影视剧里最常见的就是摩斯编码,它的原理就是把常见的字母用短编码,不常见的字母用长编码,尽量提高表达效率。

信息量的大小和事件发生的频繁程度是相反的。100% 会确定的事件,信息含量就是 0,这也解释了足球博彩中的一方越有确定无疑的优势,赔率越高。机器学习的训练过程,也是找到信息熵变化最大的调整方法。

人的语言包含很多信息,其中不少是冗余的,虽然过程低效,但是冗余会降低接收方产生错误理解的风险,在关键时候是可以救命的。

我们评价一个 AI 模型的泛化能力,就是看偏差、方差和噪音。偏差体现了客观差距,方差体现了是集中还是分散。把噪音误以为是信息,就是过拟合;把信息误以为是噪音就是欠拟合。信息和噪音的定义取决于具体场景,不同的目标下两者是可以转换的。

那么,人工智能与信息论之间的联系是啥?

人工智能研究如何让计算机具有类似人类智能的能力,而信息论则关注信息的传输、处理和表达方式。在过去的几十年里,这两个领域在发展中一直存在着密切的联系。

信息论提供了一种理论框架,以便有效地学习,处理和传输信息,也能有效地表示信息。因此,信息论可以帮助人工智能系统:

更好地完成大量的信息处理,以便进行决策和预测;

将问题和解决方案表示为数字形式,以便进行计算;

从环境中学习信息,以便进行适应和创新