-

想实现一个根据接口自动生成用例的工具,各位大神有什么推荐的吗?求推荐。 at 2023年04月11日

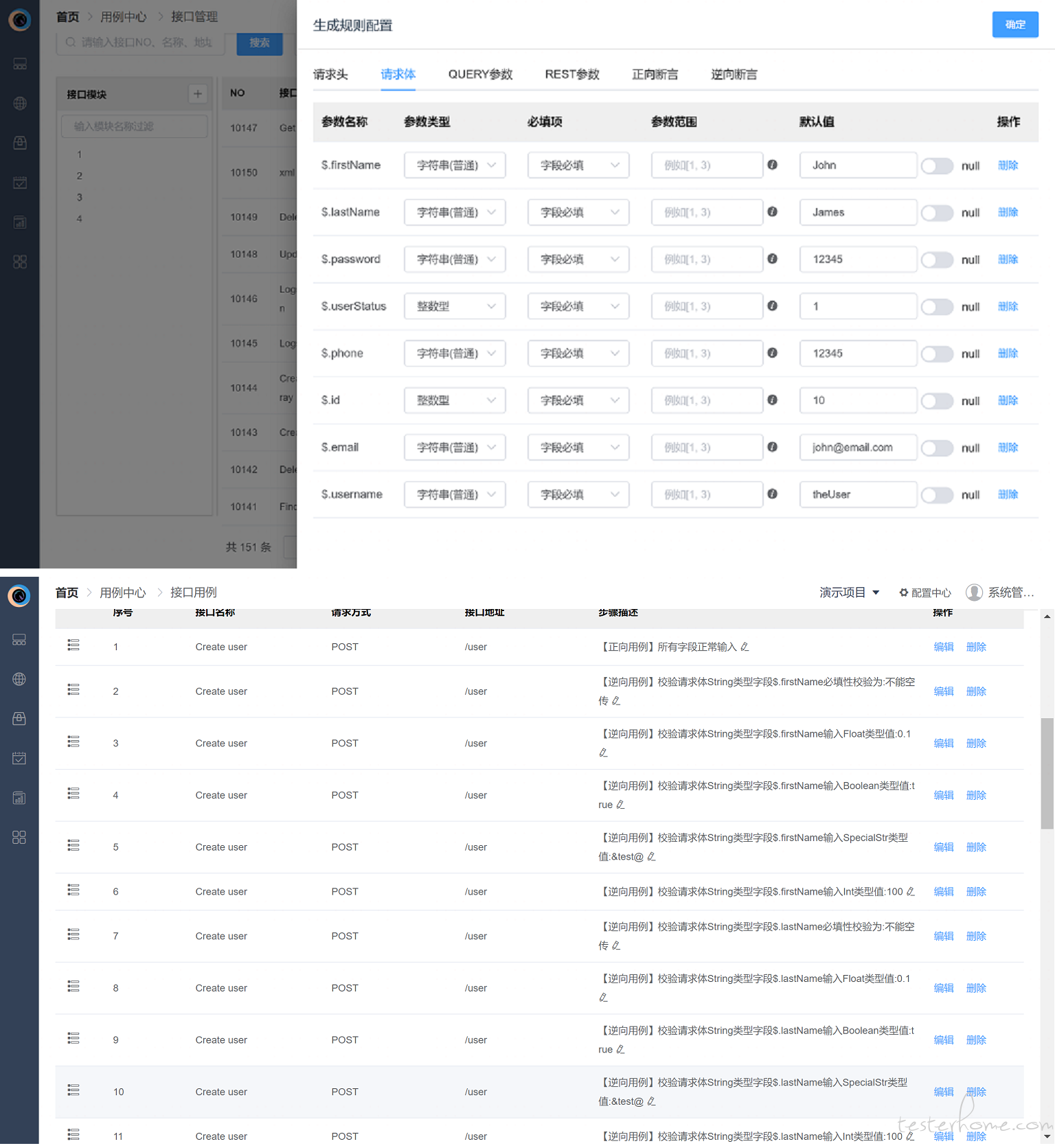

听起来大概是这样,先解析接口,然后生成默认的规则,规则可以修改,然后生成多个接口请求去校验,同时在生成前需要配置断言规则。如下图已实现的功能,不过我是在测试平台实现的,工具可能没这么方便:

-

流马测试平台 1.1 发布,除了新增 APP 测试还有更多更新 at 2023年03月09日

我没感觉哪儿难听,我也接受批评和质疑,但总要告诉我具体不行的地方,而不是光嘴说一句差得很,何况还不是第一次呢?

-

流马测试平台 1.1 发布,除了新增 APP 测试还有更多更新 at 2023年03月09日

投屏确实不是那么流畅,不过我也不是做云真机服务的尚能接受。至于测试执行的话,目前还没接触过更好且更合适的底层驱动了,如果后续发现更优秀的技术也可以引入进来。

-

流马测试平台 1.1 发布,除了新增 APP 测试还有更多更新 at 2023年03月08日

首先呢,这个平台的定位是帮助中小企业快速实现自动化。当然我不知道您所在的公司是什么规模,测试基建做到什么程度,所以高屋建瓴般说出差太远的评价。

不过该平台只是作为 devops 其中的一环,甚至只是提供自动化测试的能力,只要能集成进去就可以。如果我把项目管理、需求管理、测试管理等等这些东西一股脑的都做进来,那必然将是一个很臃肿的系统,成本也必然随之升高,参考一些平台就知道了,好不好用用过的都知道。至于其他测试基建相关的能力和技术,在企业内部都有做过,只是那种更需要量身定制才能发挥作用。

个人认为自动化测试平台就应该是个小而美的工具平台,而不是搞臃肿不堪的一站式,至少目前我是没见到好用的,反而我这个平台在现有用户群体里口碑还算可以,当然我这个平台目前易用性和交互体验也还有很多提升空间,我也在慢慢完善。

或者说如果我对大佬的差太远理解有误,也欢迎大佬举例说出一两个地方让我学习学习? -

流马测试平台 1.1 发布,除了新增 APP 测试还有更多更新 at 2023年03月08日

文档还在补充,web 测试和 app 测试使用方法差不多

-

流马测试平台 1.1 发布,除了新增 APP 测试还有更多更新 at 2023年03月08日

补上演示平台的账号密码:demo/123456

-

求助:自动化工具 katalon 相比于自己手写框架那个方案更好一些? at 2022年12月07日

如果是做 web 自动化,不如试试流马测试?还能跟接口测试配合使用,同样也不需要写代码,当然对于有代码追求的,也可以用代码做一些复杂操作或者场景步骤的封装。

-

一个接口入参很多,怎么设计接口测试用例 at 2022年11月30日

自动生成用例这个功能我之前二开 ms 做过。我自己开源的平台也准备做这个功能,不用生成一百个用例,一个用例请求 100 个接口也一样。

原理也很简单,先生成一条正向用例,然后在此基础上针对每个参数不同校验替换值并且换断言就行。 -

基于京东云轻量云主机部署 Halo 搭建个人博客站 at 2022年11月29日

新用户都没优惠吗,像腾讯云阿里云这些基本新用户 2C4G 第一年 100,后面续费也会有个折扣,比这 140 一个月便宜得多

-

测开的天花板是不是 精准测试? at 2022年11月25日

明白了,这和我们讨论的不是一种类型。我们这测试想要的是功能测试用例的推荐,我觉得是不切实际的,即便技术可行,前期录制用来映射关系也非常消耗时间

-

测开的天花板是不是 精准测试? at 2022年11月25日

请教下你们用例和代码关联时基于什么方案做的呢

-

测开的天花板是不是 精准测试? at 2022年11月24日

精准测试,不知道又是哪个大厂的人才提出来的新名词,今天开会刚讨论这个。

我的结论就是,这玩意不如一个经验丰富的测试自己评估来的准。做的不好的投产比可以干成负数,毕竟一个推荐不准确漏测上线那就是事故了。

如果测试效率可以提升,那么自动化就能完成 90%,其他的都是面子工程。 -

谁做过蓝凌审批流的接口自动化测试 at 2022年08月24日

首先先确认你们的登录鉴权是哪种方式,审批流类系统常用的是 session&cookie 或者 token。

第一种一般是每个用户的审批写成一条用例,先登录再操作,然后用测试套件组合一下,这类灵活可以复用。

第二种一般先写登录用例,一次性登录多个用户并保存 token,再写审批用例,切换 token 即可。

如果是别的鉴权方式,那也有对应的办法,可以参考我之前的帖子。 -

求助:input 型的下拉框输入文本后文本会消失 at 2022年07月19日

可以尝试分三步:第一步通过 js 设置该组件获取焦点,第二步输入,第三步选择

-

求助:input 型的下拉框输入文本后文本会消失 at 2022年07月19日

这是前端组件的原因,这个组件归根结底是个下拉选择框,不是输入框,输入只是让你搜索使用,不是给你输入用的

-

如何学习测试平台的开发? at 2022年07月01日

要不试试流马测试平台。架构轻,代码少,更适合学习使用,自动化测试核心功能都已完善,可拓展性强。另外引擎也是基于 python+unittest 写的,正好给你参考参考怎么从框架到测试平台。

关于测试平台如何设计,你可以看我之前发的帖子,供参考。

如果有帮助的话,可以 github 给个 star,哈哈。 -

流马 自动化测试平台开源啦 at 2022年06月02日

你都说了呀,复杂 bug 多。另外,我还是倾向于自动化测试平台就做自动化测试,周边功能不用做那么多。还有一点我当时做的时候 ms 是没有 WEB 和 APP 测试的

-

MeterSphere 的 UI 测试模块如何远程调用浏览器? at 2022年05月16日

其实把测试引擎独立出来本地启动就行了,我做的测试平台就是这么干的。与其把测试引擎放在和平台一起的网络,不如把引擎放在和测试环境的网络下 (也就是任意环境下都可以执行了)

-

流马 自动化测试平台开源啦 at 2022年05月12日

应其他同学需要,源码上传了 gitee 仓库:Gitee 地址

-

流马 自动化测试平台开源啦 at 2022年05月12日

厉害厉害。我懒得弄容器化部署,前后端不太需要,引擎倒是需要但是因为 WEB 测试依赖 Chrome,镜像太大了,实在懒得弄。

-

有大佬使用过这个 LuckyFrame 平台的 UI 自动化吗?想问几个问题 at 2022年05月12日

我没用。我也是做平台的。应该有的吧,元素单独维护这是基本的设计要求 =。=

-

有大佬使用过这个 LuckyFrame 平台的 UI 自动化吗?想问几个问题 at 2022年05月11日

平台化不做数据驱动但是页面元素还是单独维护的啊

-

有大佬使用过这个 LuckyFrame 平台的 UI 自动化吗?想问几个问题 at 2022年05月11日

数据驱动在测试框架设计时很有意义,但做平台化意义不大。如果把用例抽象成一个步骤模板,类似于 pom 里的模型,反而会给用例维护带来更大的成本,这是血泪教训。像你说的登录用例,步骤是一样的结果不一样,但步骤真的完全一样吗,像你说的登陆成功跳转的页面和失败后跳转的页面必然不同,那断言的对象就不同,用一个模板去做说实话真心划不来。如果是其他步骤完全一致的场景,会不会在某次迭代又改成不一致,那到时候还要重新拆分用例。我理解的数据驱动的最初目的是为了数据管理方便而设计出来的,方便数据统一维护,平台化就没这一点的困扰,所以不需要。如果嫌弃一条用例步骤反复写,用例支持复制功能就好了。

-

有大佬使用过这个 LuckyFrame 平台的 UI 自动化吗?想问几个问题 at 2022年05月07日

断言也是操作的一部分,我理解你这属于两条用例了。以前我们做平台的时候为了解决这种场景把操作拎出来当模板,后来发现维护反而更麻烦,不如写成两条用例。

-

流马 自动化测试平台开源啦 at 2022年05月05日

您说得对,我闲着无聊在造轮子呢