开发者朋友们大家好:

这里是 「RTE 开发者日报」 ,每天和大家一起看新闻、聊八卦。我们的社区编辑团队会整理分享 RTE(Real-Time Engagement)领域内「有话题的技术」、「有亮点的产品」、「有思考的文章」、「有态度的观点」、「有看点的活动」,但内容仅代表编辑的个人观点,欢迎大家留言、跟帖、讨论。

本期编辑:@Jerry fong,@ 鲍勃

01 有话题的技术

1、MIT/NVIDIA 推出 StreamingVLM:实时理解无限长视频流

MIT 和英伟达等放出的一款可以实时理解无限长度视频流的视觉语言模型:StreamingVLM,单块 H100 可达 8 FPS。

可以用于实时视频助手、直播分析、智能监控、在线会议/课堂助手等等场景。

其主要通过紧凑 KV 缓存机制和流式对齐训练策略来实现,在其 Inf-Streams-Eval 长视频理解任务超 GPT-4o-mini。

紧凑 KV 缓存机制仅保留三类信息,Attention Sink、近期视觉 token 窗口、长期文本 token 窗口,来实现恒定内存占用,以支持无限长视频流。

训练时使用短、重叠的视频片段,模拟推理时的流式注意力模式;避免训练阶段使用超长视频,降低训练成本;保持训练与推理一致性,提升模型稳定性。

2、通义实验室发布 Qwen3-VL Cookbook:详解本地部署与 API 调用

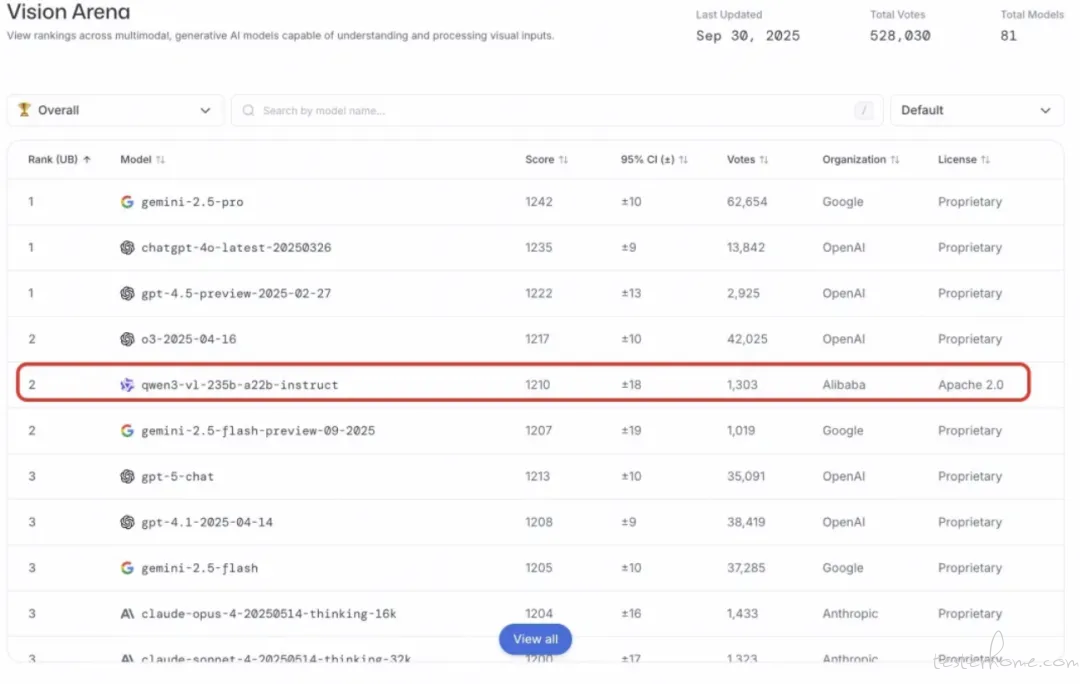

继在全球 AI 开源社区获得广泛认可后,Qwen3-VL(Qwen 视觉语言模型)近日再次迎来重磅更新。它不仅在 Chatbot Arena 的 Vision Arena 子榜单中位居全球开源冠军,并在 Text Arena 斩获纯文本赛道开源第一,成为首个同时问鼎两大领域的开源大模型,还在 OpenRouter 图像处理榜单上跃升至全球第一。

通义实验室推出 Qwen3-VL Cookbook,详解本地模型部署与 API 调用。

这些 Cookbook 围绕真实场景设计,覆盖高精度文档解析、多语言自然场景 OCR、长视频理解、3D 物体定位、空间关系推理,以及面向移动端和计算机操作的智能体控制等核心能力,全面展现 Qwen3-VL 在复杂视觉语言任务中的强大表现。欢迎试用、反馈,并与我们一起拓展多模态大模型的应用边界。

展现了包括「全能的万物识别」(动植物、商品、车辆等)、「视频理解」(长视频语义分析、OCR、时空定位)和「3D Grounding」(3D 边界框生成)等,覆盖广泛的视觉、视频及三维场景理解。

提供强大的「升级的文档解析」能力,支持 HTML、JSON、Markdown 等多种结构化输出;同时具备「通用 OCR 及关键信息提取」,可在自然场景和多语言环境下高精度识别并提取关键字段。

实现了「Mobile Agent」和「Computer-Use Agent」,Qwen3-VL 能够通过分析屏幕截图和用户指令,理解移动设备或桌面/网页界面状态,并生成触控、输入、点击、滚动等操作,实现对设备的智能控制。

展示了「带图推理」能力,结合工具实现细粒度图像理解与信息检索;以及「多模态编程」,能根据图像、文本等信息生成功能代码,适用于 UI 转代码、图表解析等。

具备「长文本理解」能力,可高效处理数十甚至上百页文档,准确回答跨页问题;同时拥有「空间理解」能力,解析物体位置、方向和相对关系,进行空间推理。

链接:

https://github.com/QwenLM/Qwen3-VL/tree/main/cookbooks

体验地址:

chat.qwen.ai(在模型列表选择 Qwen3-VL 系列模型)

模型链接:

https://modelscope.cn/collections/Qwen3-VL-5c7a94c8cb144b

(@ 通义千问 Qwen)

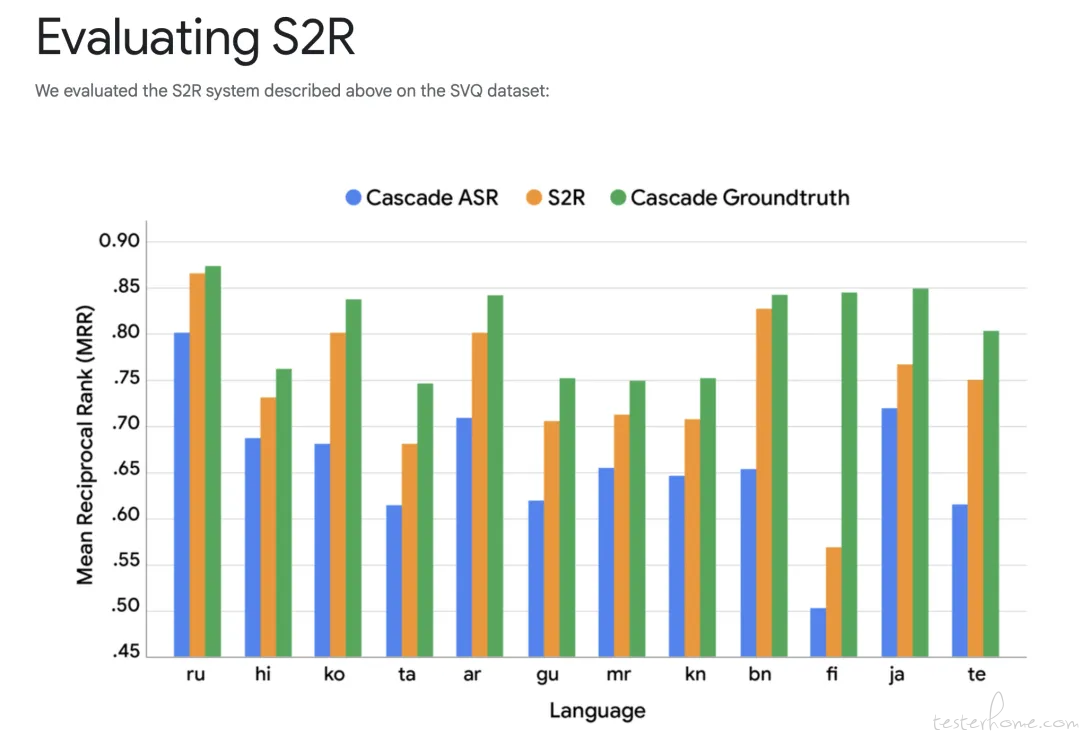

3、谷歌推出全新语音搜索技术 S2R:跳过语音转文字,直接理解语音意图

Google 提出新技术—— Speech-to-Retrieval(S2R)。 简单说,它不再把语音先转成文字,而是直接理解语音的意思,然后在海量文档中找到匹配的内容。

它的逻辑是这样的:

1.把语音转成一个「语义向量」——就像理解这句话的意思;

2.再把所有网页、文档也转成向量;

3.系统直接在「意思」层面比对——而不是靠「文字」匹配。

这样,即使你发音不标准、语气有点含糊,它也能大致明白你想要什么。

S2R 用的是一种「双编码器结构」:

一个模型负责听语音;

另一个模型负责看文字内容;

两者在训练中会不断靠近,让「语音」和「正确答案」在语义空间里越来越接近。

最终,系统听到一句话后,能直接从上千万篇文档里找到最相关的几篇。省掉了「听写」的那一步,也减少了出错的机会。

这次研究并不只是实验室成果。Google 已经在真实的多语言环境中部署 S2R,还开放了数据集,希望更多研究者参与改进。未来,S2R 可能会出现在: 智能手机语音助手、车载系统、耳机交互、智能家居语音控制等领域。

相关链接:

research.google/blog/speech-to-retrieval-s2r-a-new-approach-to-voice-search/

02 有亮点的产品

1、科大讯飞发布 AI 翻译耳机与同传大模型升级:获 IDC 8 项第一

科大讯飞在最新发布会上重磅推出全新 AI 翻译耳机,并宣布其「端到端同传大模型」迎来第三次重大升级。该耳机采用「骨导 + 气导」创新设计,实现跨城实时丝滑互译。结合 IDC 报告中科大讯飞在 AI 翻译领域斩获 8 项第一(其中 6 项满分)的卓越表现,公司正式提出「AI 翻译」战略,旨在通过「软硬一体」的全栈优势,打破语言壁垒,赋能全球融合,并以技术、赛道、生态三重壁垒铸就护城河,剑指全球 AI 翻译 No.1。

中英同传领先: 主观体验评分高达 4.6 分(满分 5 分),首字响应时间低至 2 秒,达到人类高阶同传标准,专业词库扩充至 10 万 +。

语音自然度: 合成语音自然度、拟人度显著提升,用户选择倾向达 83%。

声音复刻: 新增「声音复刻」功能,仅需一句语音样本,AI 即可复刻其音色,相似度超 90%。

语种拓展: 新增中英与阿拉伯语、西班牙语之间的同传互译,覆盖更多国际高层级和广阔大众市场。

详细链接:

https://mp.weixin.qq.com/s/g9Dqk2iZDnvUmbvZ3-Y30A

(@ 科大讯飞)

2、「Everywhere」开源:情境感知桌面 AI 助手,屏幕内容一键直达 AI 洞察

近日,在 GitHub 上开源的一款具备情境感知能力的桌面交互式 AI 助手:Everywhere。

有点厉害,它能直接感知我们屏幕上的任何内容,只需要按下快捷键,即可在任何位置上调用 AI。

无需截图、复制或切换应用,AI 便会自动理解当前屏幕内容,并直接为我们提供帮助。

主要特性:

屏幕内容自动感知,AI 直接理解当前显示的信息;

快捷键即时调用,在任何位置都能获得 AI 帮助;

支持多种主流 AI 模型,包括 OpenAI、Claude、Gemini 等;

简洁的毛玻璃界面设计,视觉体验相当不错;

内置了网络搜索功能,可获取最新信息;

支持 Markdown 渲染,显示效果更专业。

目前仅支持 Windows 系统,下载安装包后,配置相关 API Key 即可使用。

GitHub:

http://github.com/DearVa/Everywhere

03 有态度的观点

1、科幻作家郝景芳:任何声称某专业不会被 AI 淘汰的说法都不可信

在近日举办的「一席少年 · 教育论坛」上,科幻作家、童行书院创始人郝景芳发表演讲,直言「任何跟你说,学某某专业将来不会被 AI 淘汰的,都绝对不要相信」。

郝景芳指出,对于有标准答案的问题,AI 的表现远超人类,学生若仅依赖应试教育,毕业后势必面临失业风险。

她强调,人类真正的价值在于回答没有标准答案的问题,即在多目标、多价值的情境下进行选择与判断。

在谈及 AI 对创作与教育的影响时,郝景芳分享了个人实践:她在新作《折叠宇宙:吞噬文明》的写作过程中,利用 AI 辅助人物设定与背景构建,但最终的创意与统筹仍由人类主导。

她认为,未来 AI 将承担更多执行类岗位,而人类则需要具备统帅性与项目管理能力。

郝景芳进一步指出,AI 的发展不可避免,关键在于人类如何与之共生。未来在任何一个专业方向,如果你能够驾驭 AI,在 AI 的能力基础之上再去做,其实是可以超越 AI 的。

她呼吁教育体系应减少应试负担,转而培养学生的创造力与领导力。

( @APPSO)

04 社区黑板报

招聘、项目分享、求助……任何你想和社区分享的信息,请联系我们投稿。(加微信 creators2022,备注「社区黑板报」)

社区项目推荐

1、代体 AI 推出「端侧语音输入法」:迈向「真正懂你」的个人模型

来自代体:

两年前,代体就已经开始探索记忆这个方向,从最初的记忆助手,到语音记录、智能项链、记忆耳机,再到今天的语音输入法。一路走来,代体始终在寻找让个人模型真正落地的切入点。

现在,代体正专注于打造一款端侧语音输入法。它不仅快、免费、保护隐私,还将是代体迈入个人模型的重要起点。

这是一条从输入法出发,逐步走向真正懂你、记得你、能为你行动的个人模型的路径:

第一步:语音输入法。以高频刚需的入口,把产品体验与数据闭环建立起来。

第二步:自研语音识别模型。在能力与数据积累到位后,打造更适配的端侧模型。

第三步:把记忆融入模型。不仅听懂当下的话,也结合你的历史与语境去理解你。

第四步:走向个人模型。最终,它将不再只是一个输入工具,而是你专属的个人模型。它能够基于对你的深度理解,主动去组织、协调并调用不同的 AI 服务,让这些服务围绕着你去完成任务。

使用链接:

阅读更多 Voice Agent 学习笔记:了解最懂 AI 语音的头脑都在思考什么

写在最后:

我们欢迎更多的小伙伴参与 「RTE 开发者日报」 内容的共创,感兴趣的朋友请通过开发者社区或公众号留言联系,记得报暗号「共创」。

对于任何反馈(包括但不限于内容上、形式上)我们不胜感激、并有小惊喜回馈,例如你希望从日报中看到哪些内容;自己推荐的信源、项目、话题、活动等;或者列举几个你喜欢看、平时常看的内容渠道;内容排版或呈现形式上有哪些可以改进的地方等。

素材来源官方媒体/网络新闻