开发者朋友们大家好:

这里是 「RTE 开发者日报」 ,每天和大家一起看新闻、聊八卦。我们的社区编辑团队会整理分享 RTE(Real-Time Engagement)领域内「有话题的 技术 」、「有亮点的 产品 」、「有思考的 文章 」、「有态度的 观点 」、「有看点的 活动 」,但内容仅代表编辑的个人观点,欢迎大家留言、跟帖、讨论。

本期编辑:@qqq、@ 鲍勃

01 有话题的技术

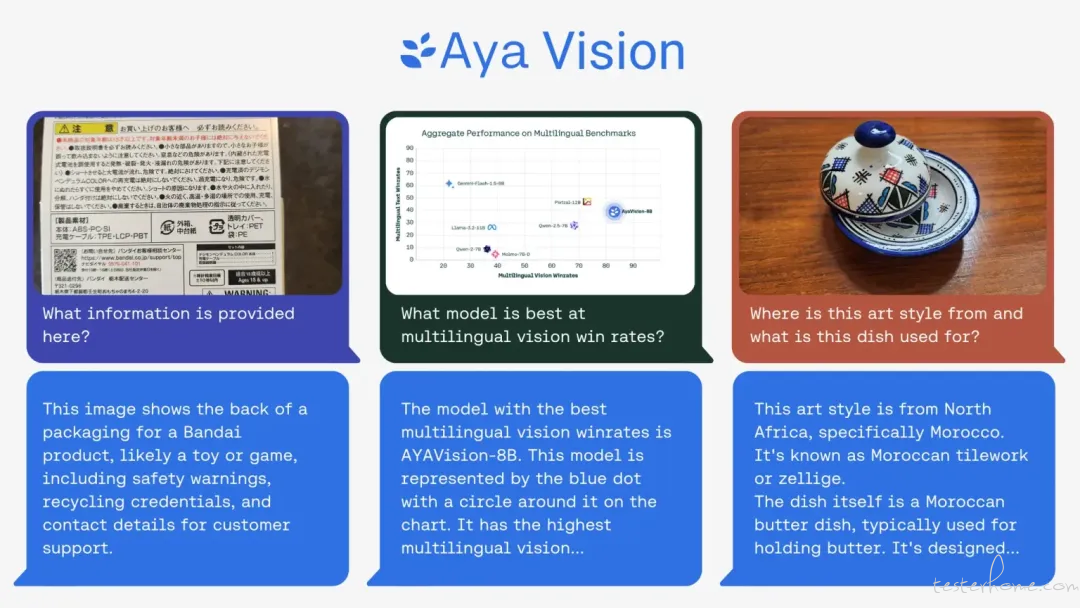

1、Cohere 发布 Aya Vision AI 模型,声称领先行业

AI 初创公司 Cohere 本周发布了其多模态「开放」AI 模型 Aya Vision,并声称其在多个方面属于行业领先水平。Aya Vision 能够执行包括图像标题生成、回答照片相关问题、文本翻译和生成摘要等任务,支持 23 种主要语言。Cohere 表示,Aya Vision 是「让技术突破面向全球研究人员的重大一步」,并通过 WhatsApp 向公众免费开放。

Cohere 在博客中提到,尽管 AI 技术取得了显著进展,但在多语言处理和跨模态任务(涉及文本和图像)上的表现仍存在巨大差距,Aya Vision 的目标就是缩小这一差距。Aya Vision 提供了两种版本:Aya Vision 32B 和 Aya Vision 8B。更为复杂的 Aya Vision 32B 在某些视觉理解基准测试中超越了包括 Meta 的 Llama-3.2 90B Vision 在内的 2 倍规模的模型,而 Aya Vision 8B 则在某些评估中超过了 10 倍于其规模的模型。

此外,Cohere 还发布了新的基准套件 AyaVisionBench,旨在评估模型在「视觉 - 语言」任务中的表现,如识别两幅图像之间的差异、将截图转化为代码等。Cohere 指出,当前 AI 行业面临「评估危机」,即基准测试的综合评分与 AI 用户关心的任务能力关联较差。Cohere 认为,AyaVisionBench 为跨语言和多模态理解的评估提供了一个「广泛且具有挑战性」的框架。(@TechCrunch)

2、DiffRhythm:短时间内生成包含人声和伴奏的完整歌曲

DiffRhythm,中文名谛韵,是由西北工业大学音频、语音与语言处理研究组(ASLPLab)开发的一种 AI 音乐生成模型。

作为全球首个基于潜在扩散技术(Latent Diffusion)的端到端完整歌曲生成模型,DiffRhythm 只需要 8GB VRAM 就能在 10 到 12 秒内生成一首完整歌曲,目前仅支持中英文。

DiffRhythm 能够一次性生成包含人声和伴奏的完整歌曲,就像 Suno 和 Udio 一样,最长能生成 4 分 45 秒的完整歌曲。(@ 三花 AI)

3、Spark-TTS:基于 LLM 的高效文本转语音模型

核心特色:

Qwen2.5 架构,无额外生成模型辅助,单阶段、单流 TTS 生成

超自然语音克隆 & 跨语种生成,支持多语言、多风格表达

定制化能力,用户可自由创建专属声音

📄 论文: https://arxiv.org/pdf/2503.01710

🖥 代码: https://github.com/SparkAudio/Spark-TTS

🎧 样例:https://sparkaudio.github.io/spark-tts/@user3)(

4、TheoremExplainAgent:AI 驱动的数学与科学教学动画

TheoremExplainAgent(简称 TEA)是由 TIGER AI Lab 开发的一款 AI 多智能体,专门设计用于将复杂的数学和科学定理转化为易于理解的 Manim 教学动画,每段动画时长能超过 5 分钟。

TEA 背后结合了大语言模型(LLM)的推理能力、Manim 动画技术以及语音合成技术。(@ 三花 AI)

5、LTX-Video 0.9.5:开源可商用视频生成模型

LTX-Video 是由 Lightricks 开发的一款基于 AI 的开源视频生成模型,昨天发布了 0.9.5 版本。这个版本支持了商业用途,还新增了首尾帧视频生成,最高可生成 5 秒视频。此外,还支持了对 AMD ROCm 的支持。(@ 三花 AI)

02、有亮点的产品

1、西雅图 AI 陪伴初创 Portola 完成 1000 万美元种子轮融资,可提供情感陪伴)

西雅图 AI 陪伴初创 Portola 近日完成 1000 万美元种子轮融资,投资方包括前 Stripe 高管 Lachy Groom、GitHub 前 CEO Nat Friedman, Replit CEO Amjad Masad 等知名投资人。

Portola 推出了一款名为 Tolan 的 AI 陪伴应用,可提供情感陪伴、心理疏导、实用助手在内的综合支持。

Tolan 于 2024 年在 iOS 上线,目前产品用户量已达 50 万,ARR 破百万美元。

该轮融资将用于产品优化与用户增长,公司目标是打造更具人性化和故事性的 AI 陪伴体验。(@GeekWire)

2、全球第一款通用 Agent 产品亮相

昨日,Manus AI 正式公布了其「Manus」Agent 产品,而这也是全球第一款通用 Agent 产品。据官方介绍,Manus 这个名字来自拉丁语,Mens et Manus,就是 mind and hand,即手脑并用。Manus 可以解决各类复杂多变的任务,能够独立思考、规划并执行复杂任务,直接交付完整成果。比起 Claude 的 Computer use 等同样能操作多任务,或者能帮你点外卖订酒店的 Agent, Manus 可以覆盖更多领域和达成更高的执行质量。官方公布的数据显示,在用于评估通用 AI 助手在解决现实世界问题方面的能力的 GAIA 基准测试中,Manus 在所有三个难度级别上都达到了 SOTA 水平。

为了确保结果的可重复性,Manus 使用与其正式版本完全一致的配置进行评测。此外,Manus 也在 Upwork、Fiverr 等平台上解决真实世界的问题,并在 Kaggle 竞赛中证明了自己的能力。Manus 采用多重签名(multisig)系统,由多个独立模型驱动。今年晚些时候,官方将计划开源其中的一些模型,特别是 Manus 的推理(postering)部分。(@APPSO)

03、有态度的观点

1、联想集团董事长:混合式 AI 将定义未来

在近日的 MWC2025 世界移动通信大会上,联想集团董事长兼 CEO 杨元庆发表重要主题演讲,分享了联想在人工智能领域的战略布局与创新成果,强调混合式人工智能将定义未来。杨元庆指出,当下人工智能正无处不在,客户需求推动个人与企业私域智能,与公共智能混合互补,即「混合式人工智能」,这将成为必然趋势。其预测,在未来个人智能场景下,人工智能推理运算可以在个人电脑、平板、手机等个人智能设备端进行,如此一来,智能设备内置的 AI agent 智能体就可以在用户授权后,响应指令,甚至做出行动。

结合上述,杨元庆谈及了「个人智能」。其坚信,人工智能的发展趋势正在从专用智能体迈向超级智能体,从而可以在混合多模型平台上代表用户执行复杂任务。同时他也透露了联想的发展目标——「一体多端」,通过超级智能体统一管理个人信息,最终迈向「个人人工智能双胞胎」目标。此外,杨元庆还表示,得益于算力与模型优化,端侧人工智能的进步速度将呈现指数级跃升,两者进步的叠加效应有望在未来 12 个月实现 3 倍的整体性能提升。(@APPSO)

更多 Voice Agent 学习笔记:

对话 TalktoApps 创始人:Voice AI 提高了我五倍的生产力,语音输入是人机交互的未来

2024,语音 AI 元年;2025,Voice Agent 即将爆发丨年度报告发布

对话谷歌 Project Astra 研究主管:打造通用 AI 助理,主动视频交互和全双工对话是未来重点

这家语音 AI 公司新融资 2700 万美元,并预测了 2025 年语音技术趋势

Gemini 2.0 来了,这些 Voice Agent 开发者早已开始探索……

写在最后:

我们欢迎更多的小伙伴参与 「RTE 开发者日报」 内容的共创,感兴趣的朋友请通过开发者社区或公众号留言联系,记得报暗号「共创」。

对于任何反馈(包括但不限于内容上、形式上)我们不胜感激、并有小惊喜回馈,例如你希望从日报中看到哪些内容;自己推荐的信源、项目、话题、活动等;或者列举几个你喜欢看、平时常看的内容渠道;内容排版或呈现形式上有哪些可以改进的地方等。

素材来源官方媒体/网络新闻