开发者朋友们大家好:

这里是 「RTE 开发者日报」 ,每天和大家一起看新闻、聊八卦。我们的社区编辑团队会整理分享 RTE(Real-Time Engagement)领域内「有话题的 新闻 」、「有态度的 观点 」、「有意思的 数据 」、「有思考的 文章 」、「有看点的 会议 」,但内容仅代表编辑的个人观点,欢迎大家留言、跟帖、讨论。

本期编辑:@SSN,@ 鲍勃

01 有话题的新闻

1、端侧开源 AI 模型 Zamba2-mini 登场:12 亿参数,4bit 量化下内存占用小于 700MB

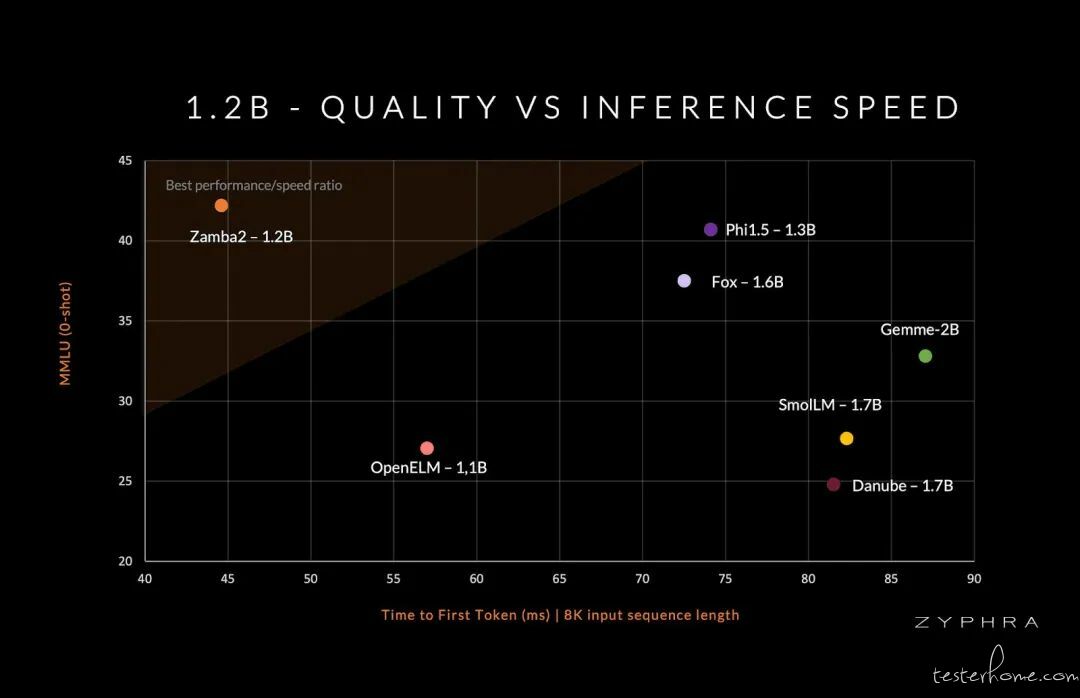

Zyphra 于 8 月 27 日发布博文,宣布推出 Zamba2-mini 1.2B 模型,共有 12 亿参数,声称是端侧 SOTA 小语言模型。该模型在 4bit 量化下内存占用低于 700MB,性能与谷歌 Gemma-2B、Huggingface 的 SmolLM-1.7B、苹果的 OpenELM-1.1B 和微软的 Phi-1.5 等更大模型相媲美。

Zamba2-mini 在推理任务中表现出色,与 Phi3-3.8B 等模型相比,Zamba2-mini 的首次令牌时间(从输入到输出第一个 token 的延迟)是此前的二分之一,内存占用减少了 27%。

Zamba2-mini 1.2B 主要通过高度优化的架构实现,融合了不同神经网络设计的优势,既能保持大型密集变压器的高质量输出,又能以更小模型的计算和内存效率运行。

与前代 Zamba1 相比,Zamba2-mini 的关键进步之一是集成了两个共享注意力层。这种双层方法增强了模型在不同深度保持信息的能力,从而提高了整体性能。在共享注意力层中加入旋转位置嵌入也略微提高了性能,这表明 Zyphra 致力于在模型设计中进行渐进而有影响力的改进。

Zamba2-mini 在海量数据集上预训练,经过严格过滤和退火阶段的优化,最终以 Apache 2.0 许可开源。(@IT 之家)

2、智谱清言 App 国内率先面向 C 端开放视频通话服务

在 KDD 国际数据挖掘与知识发现大会上,智谱正式发布了新一代基座大模型 GLM-4-Plus。与 GLM-4-Plus 同步上线的,还有国内首个面向 C 端开放的「视频通话」功能,这是国内首个面向 C 端用户开放的视频通话服务。

清言视频通话功能跨越了文本、音频和视频模态,并具备实时推理能力。用户在拨打清言的视频通话时,可以体验到流畅的互动,即使频繁打断,它也能迅速响应。清言不仅能够理解摄像头拍摄到的画面,还能听懂并准确执行用户的指令,带来如同真人视频通话般的体验。随着视频通话功能的加入,清言 app 成为首个可以通过文本、音频、视频和图像来进行多模态互动的 AI 助手。

「清言 APP」的视频通话功能将于 今日(8 月 30 日)上线,首批将面向部分用户开放,同时接受外部申请。(@GLM 大模型)

3、谷歌最新 GameNGen:扩散模型做游戏引擎,单 TPU 20 FPS 模拟毁灭战士

谷歌研究人员在人工智能领域取得了重大突破,发布了世界上首个完全由神经模型驱动的游戏引擎 GameNGen。这一革命性的成果不仅标志着游戏开发方式的巨大变革,更预示着游戏行业即将迈入一个全新的时代。

据官方消息,GameNGen 能够在不使用传统游戏引擎的情况下,为经典射击游戏《DOOM》(又称《毁灭战士》)生成实时游戏画面。这一引擎在单个 TPU(谷歌定制的人工智能加速器芯片)上,以超过 20 帧每秒的速度实时模拟《DOOM》,生成的画面质量与真实游戏非常接近,甚至让 60% 的片段未被玩家识别出是 AI 生成。

这不仅大幅降低了游戏的开发时间和成本,更使得游戏创作变得更加民主化,无论是大型游戏公司还是小型工作室,甚至是个人创作者,都能利用这一技术创造出复杂且高质量的互动体验。

此外,GameNGen 的发布也为全新的游戏类型打开了大门。未来,游戏行业可能会从以热门游戏为中心的模式,转向更加多样化的生态系统。玩家将能够享受到更加个性化、定制化的游戏体验,而开发者也将拥有更多创新的空间和可能性。(@AI 产业研究院)

4、贾佳亚团队新图像视频生成控制 ControlNeXt

贾佳亚团队开发了一款名为 ControlNeXt 的图像和视频生成控制工具,该工具在生成速度、精准控制和用户友好性上有显著提升。ControlNeXt 兼容多款 Stable Diffusion 图像和视频生成模型,如 SD1.5、SDXL、SD3 和 SVD,实现了即插即用,且 GitHub 上已获得 1.1k 星标。ControlNeXt 支持多种条件控制,包括 Canny 边缘、掩模、景深、姿势等,能够生成高质量的图像和视频,且支持超分辨率和人体姿势动作的精准控制。

ControlNeXt 在架构上采用了轻量级卷积模块,去除了 ControlNet 中的庞大控制分支,减少了训练参数量、计算开销和内存占用,同时通过交叉归一化技术优化了训练和推理过程。该项目的创新在于实现了更高效的模型训练和推理,挑战了 Scaling Law 的传统做法,即通过增加参数、数据和算力来提升模型性能。(@ 机器之心)

5、阿里通义千问推出 Qwen2-VL:开源 2B / 7B 模型,处理任意分辨率图像无需分割成块

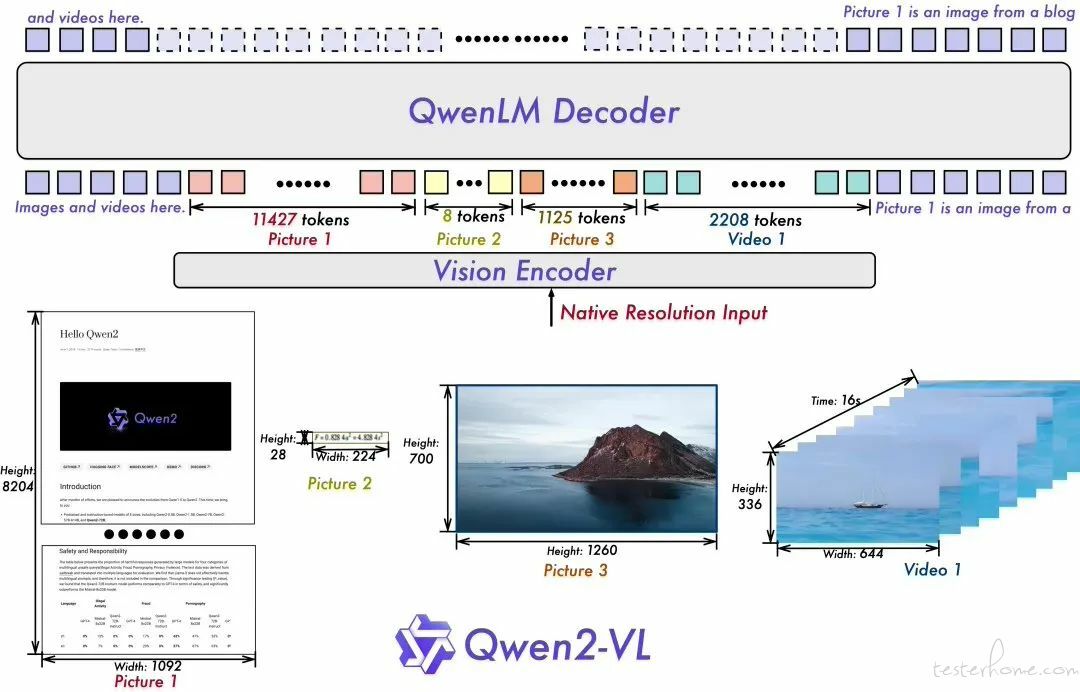

通义千问团队于今日对 Qwen-VL(视觉语言、Vision Language)模型进行更新,推出 Qwen2-VL。

Qwen2-VL 的一项关键架构改进是实现了动态分辨率支持(Naive Dynamic Resolution support)。与上一代模型 Qwen-VL 不同,Qwen2-VL 可以处理任意分辨率的图像,而无需将其分割成块,从而确保模型输入与图像固有信息之间的一致性。这种方法更接近地模仿人类的视觉感知,使模型能够处理任何清晰度或大小的图像。

另一个关键架构增强是 Multimodal Rotary Position Embedding(M-ROPE)。通过将 original rotary embedding 分解为代表时间和空间(高度和宽度)信息的三个部分,M-ROPE 使 LLM 能够同时捕获和集成 1D 文本、2D 视觉和 3D 视频位置信息。这使 LLM 能够充当多模态处理器和推理器。

在 7B 规模下,Qwen2-VL-7B 保留了对图像、多图像和视频输入的支持,以更具成本效益的模型大小提供「具有竞争力」的性能。

Qwen2-VL-2B 模型针对潜在的移动部署进行了优化。尽管参数量只有 2B,但官方表示该模型在图像、视频和多语言理解方面表现出色。(@IT 之家)

6、HuggingFace 开源低成本 AI 机器人解决方案 LeRobot

HuggingFace 推出名为 LeRobot 的开源项目,旨在提供一个低成本的 AI 机器人解决方案,让更多人能够参与到 AI 机器人的构建和训练中。

LeRobot 项目由前特斯拉工程师 Remi Cadene 领导,提供了详细的指南,包括机器人的组装、配置以及如何训练控制机器人的神经网络。LeRobot 基于开源的 Koch v1.1 机器人套件,包含两个六电机的机械臂,并且支持多摄像头作为视觉传感器。项目的硬件和软件资源,包括训练和控制程序、AI 模型和 SolidWorks 文件,均已开源。LeRobot 还计划推出一个定价为 150 美元的 Moss v1 版本。此外,项目提供了四种模型和 98 个数据集,开发者可以根据需要上传自己的数据集进行训练。通过 LeRobot,用户可以从零开始组装机械臂,并通过 AI 模型训练机器人执行一系列任务。(@ 雷锋网)

02 有态度的观点

1、a16z:下一代皮克斯,AI 将如何融合电影和游戏?

未来世纪的皮克斯不会通过传统的电影或动画产生,而是通过交互视频。这种新的叙事形式将模糊电子游戏和电视 / 电影之间的界限,将深刻的叙事与观众的参与性和「玩」性结合起来,开辟出一个庞大的新市场。随着消费者对互动媒体的偏好增加,以生成式 AI 的发展,游戏已经成为现代叙事的前沿。

交互式视频通过将故事讲述与玩耍结合起来,提供了一个新的媒介格式。与传统的视频游戏不同,交互式视频完全由神经网络实时生成帧。这种格式结合了电视 / 电影的可访问性和叙事深度,以及视频游戏的动态系统和观众参与性。尽管以往的尝试,如 Telltale 的《奔逃僵尸》和 Netflix 的《Bandersnatch》,因为制作成本和时间的限制而面临挑战,但生成式 AI 模型的进步可能是实现交互式视频的关键。

近年来,模型蒸馏、图像生成和视频生成技术的显著进步,已经使得实时生成高质量视频成为可能。研究人员和公司正在探索新的交互式视频体验,并开发出能够生成完整 3D 可玩世界的基础模型。预计,随着技术的不断进步,完全可生成的交互式视频可能在未来两年内实现商业化。

未来的交互式皮克斯将需要是一个世界级的互动叙事工作室和顶尖的技术公司,能够将叙事和游戏设计与技术创新相结合。这样的团队将需要找到新的方法,让人类叙事者与 AI 工具协同工作,同时解决法律和伦理上的挑战。长远来看,生成式 AI 可以创造不仅仅是互动故事,而是整个虚拟世界。(@ 雷锋网)

写在最后:

我们欢迎更多的小伙伴参与「RTE 开发者日报」内容的共创,感兴趣的朋友请通过开发者社区或公众号留言联系,记得报暗号「共创」。

对于任何反馈(包括但不限于内容上、形式上)我们不胜感激、并有小惊喜回馈,例如你希望从日报中看到哪些内容;自己推荐的信源、项目、话题、活动等;或者列举几个你喜欢看、平时常看的内容渠道;内容排版或呈现形式上有哪些可以改进的地方等。

素材来源官方媒体/网络新闻