开发者朋友们大家好:

这里是 「RTE 开发者日报」 ,每天和大家一起看新闻、聊八卦。我们的社区编辑团队会整理分享 RTE(Real-Time Engagement)领域内「有话题的 新闻 」、「有态度的 观点 」、「有意思的 数据 」、「有思考的 文章 」、「有看点的 会议 」,但内容仅代表编辑的个人观点,欢迎大家留言、跟帖、讨论。

01 有话题的新闻

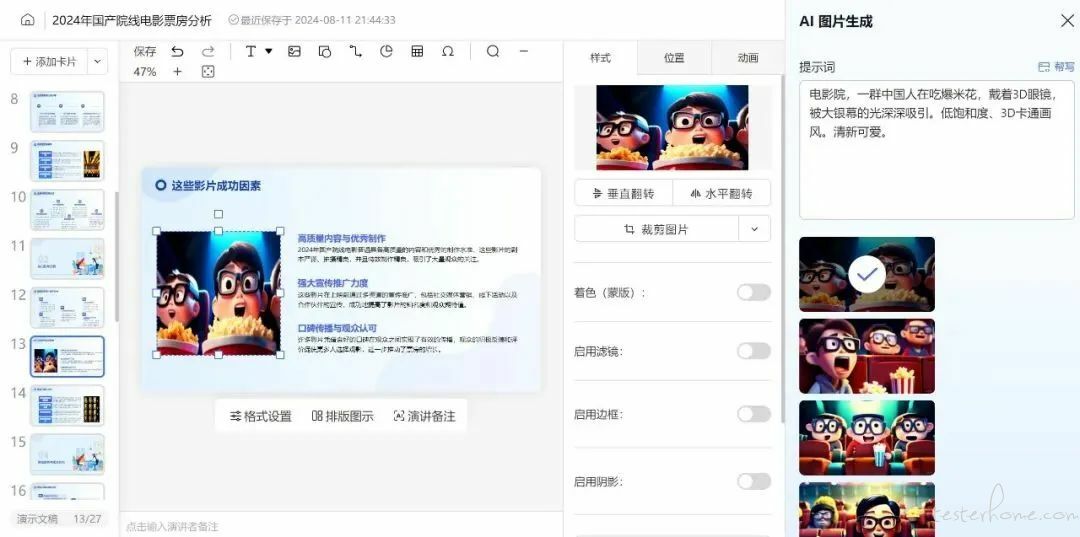

1、科大讯飞智文 2.0 版本发布:内置 AI PPT 编排创作引擎,基于星火大模型

科大讯飞的智能文档产品——讯飞智文 2.0 版本正式发布,带来了基于讯飞星火 V4.0 大模型底座的显著技术升级和增强功能。新版引入了 PPT 文本生成大模型、AI PPT 编排创作引擎和 AI PPT 在线编辑模组三大核心组件,提升了编辑自由度和样式多样性。

在文本生成方面,讯飞智文 2.0 进行了独立训练,对用户输入的主题具备更强大的理解能力,支持高达 12000 字的文本输入,相当于一整部《论语》或一篇现代短篇小说。AI PPT 编排创作引擎是 2.0 版本的一大亮点,采用全新的大纲编排方式,使用户在构建 PPT 时不再受限于传统框架,能够创建逻辑清晰、结构合理、层次丰富的演示文稿。同时,基于星火 V4.0 的多模态能力,用户选中文本内容后,系统可以自动生成多张高清且适配的图片,有效规避版权风险,简化了手动搜图的过程。(@ 新浪科技)

2、马斯克:人工智能模型 Grok 2 测试版即将发布

特斯拉 CEO 马斯克当地时间 8 月 11 日晚在 X 平台上表示,人工智能模型 Grok 2 测试版即将发布。

Grok 是马斯克旗下的 xAI 公司推出的大语言模型 Grok 2,上个月马斯克就在 X 平台上确认,Grok 2 将于数周后发布。在回应用户关于训练数据的提问时,他表示该模型「改进巨大」。

马斯克和 xAI 目前尚未公布关于该模型的详细信息。今年三月,马斯克曾表示 Grok 2 将在「所有指标」上超越当前一代的 AI 模型。

Grok 2 发布后将紧随 Grok 3,马斯克此前称其将在年底左右推出。他表示,xAI 一直在训练 Grok 3,该模型的水平将「达到或超越」尚未发布的 OpenAI GPT-5,后者被认为是大语言模型领域的下一个重大突破。(@IT 之家)

3、ReSyncer:一个多功能统一模型,可以实现音视频口型同步、说话风格迁移和换脸

ReSyncer 是由清华大学、百度和南洋理工大学 S-Lab 实验室共同开发的一种新型框架,它能够生成非常逼真、与音频同步的口型视频,并且具备多种功能,如个性化调整、根据视频驱动的口型同步、改变说话风格以及进行人脸交换。

- 高保真度的音频同步口型视频:ReSyncer 可以制作出非常逼真、准确地跟随音频同步的嘴部动作视频。

- 个性化微调:允许用户对生成的内容进行个性化调整,以满足不同的需求。

- 视频驱动的口型同步:除了音频,它还可以根据其他视频的嘴部动作来驱动同步,让新视频中的角色模仿已有视频中的说话动作。

- 说话风格迁移:ReSyncer 可以将一个人的说话风格(如语气、节奏)迁移到另一个人身上。

- 人脸交换:它还可以在视频中替换说话者的面部,同时保持口型与音频的同步。(@ 小互 AI)

4、OpenAI 发布 GPT-4o 模型卡:概述 AI 安全和风险缓解措施

OpenAI 公司于 8 月 8 日发布报告,概述了 GPT-4o 模型的系统卡(System Card),介绍了包括外部红队(模拟敌人攻击)、准备框架(Preparedness Framework)在内的诸多细节。

OpenAI 表示 GPT-4o 模型的核心就是准备框架(Preparedness Framework),这是一种评估和降低人工智能系统相关风险的系统方法。从报道中获悉,该框架主要用于识别网络安全、生物威胁、说服和模型自主性等领域的潜在危险。

除了针对 GPT-4 和 GPT-4V 进行的安全评估和缓解措施外,OpenAI 还针对 GPT-4o 的音频功能开展了更多安全工作。评估的风险包括扬声器识别、未经授权的语音生成、受版权保护内容的潜在生成、无根据推断以及不允许的内容。基于这些评估结果,OpenAI 在模型和系统层面都实施了保障措施。

OpenAI 还与 100 多名外部红队人员合作,在向公众发布模型之前对其进行评估。红队人员将进行探索性的能力发现,评估模型带来的新的潜在风险,并对缓解措施进行压力测试。(@IT 之家)

5、微软 Copilot AI 被指可被黑客操纵,轻松窃取企业机密

安全公司 Zenity 的联合创始人兼 CTO Michael Bargury 在黑帽安全大会上披露,微软内置于 Windows 系统的 Copilot AI 存在安全隐患。这些漏洞可能被利用来获取用户的敏感信息,如联系人数据,并且可以伪造邮件发送钓鱼邮件,进而诱导企业员工进行不安全的操作,例如修改银行转账信息。

研究人员通过演示展示了黑客如何利用 Copilot 泄露数据和进行网络钓鱼攻击。Copilot Studio 允许企业自定义聊天机器人,但这需要 AI 访问企业数据,从而产生安全风险。攻击者可以通过注入恶意数据来绕过 Copilot 的防护措施。Bargury 指出,当 AI 被赋予数据访问权限时,这些数据就成为了攻击的目标。(@ 雷锋网)

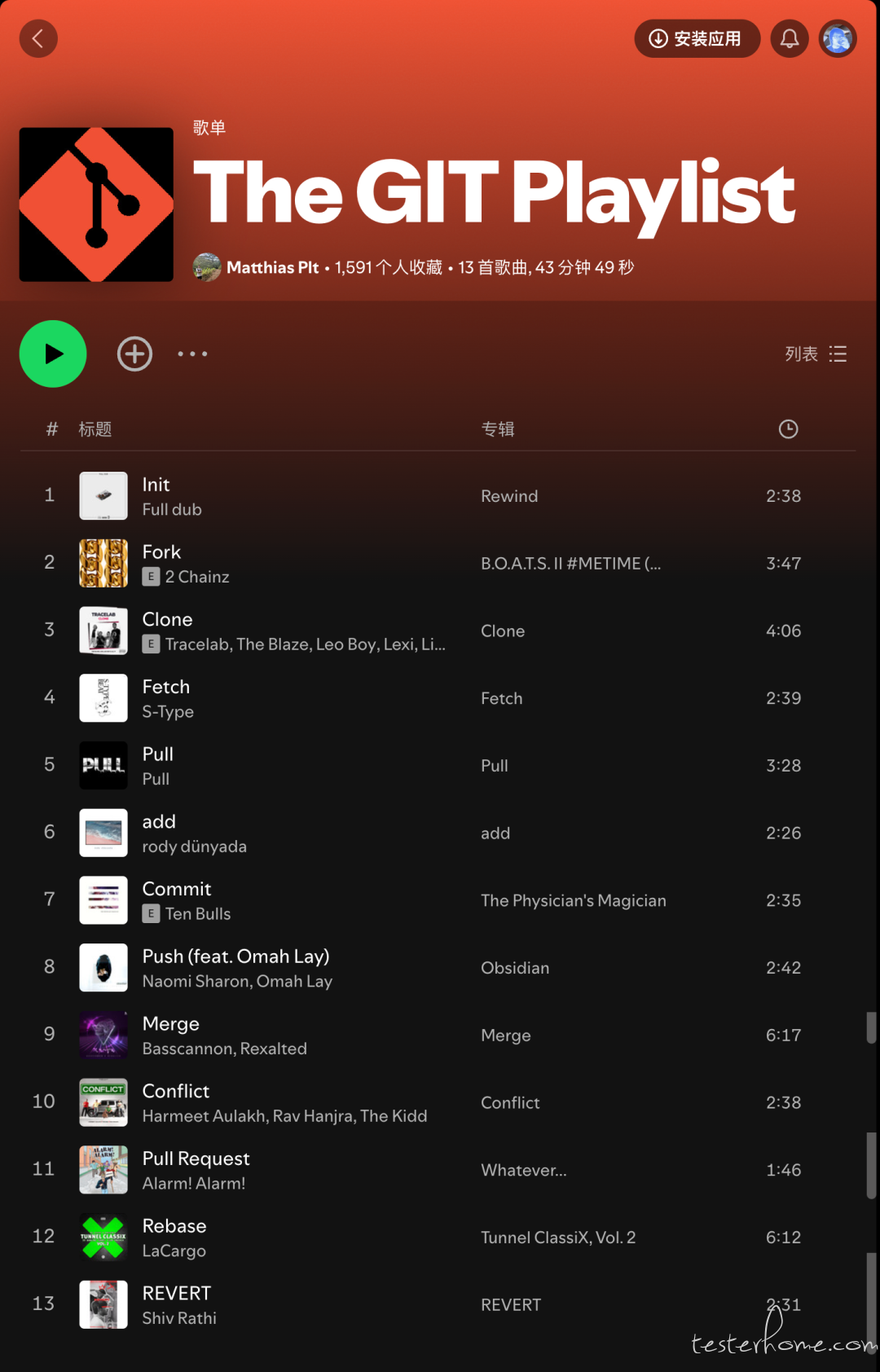

6、The GIT Playlist

如题,如图。地址:https://open.spotify.com/playlist/1wNirTC24xxOGVDAKf9sXu

02 有态度的观点

1、Andrej Karpathy:RLHF 并不是真正的强化学习

Andrej Karpathy 在 X 上的帖子中探讨了强化学习从人类反馈(RLHF)在训练大型语言模型中的作用。他认为,尽管 RLHF 被视为 LLM 训练的第三阶段,但它与实际的强化学习相比,实际上只是勉强算是 RL。Karpathy 以 AlphaGo 为例,说明了真正的 RL 训练是如何使计算机在没有人类反馈的情况下通过游戏回合的最大化来超越人类棋手的。相比之下,如果使用 RLHF 训练 AlphaGo,将需要人类标注者对 Go 棋盘状态进行评价,然后训练一个奖励模型(RM)来模仿这种评价,这种方法在 Go 中并不实用。

Karpathy 指出,RLHF 存在两个根本问题:一是奖励模型可能会误导,因为它是基于人类喜好而非实际胜利的奖励函数;二是模型很快会学会到如何操纵奖励模型,从而产生对抗性例子。尽管如此,RLHF 对于 LLM 的构建仍然是有益的,因为它利用了生成器 - 鉴别器的差距,使得人类标注者更容易从几个候选答案中选择最佳答案,而不是从头创作。此外,RLHF 还有助于减少 LLM 的幻觉现象。然而,Karpathy 强调,RLHF 并不是真正的 RL,因为在开放领域的问题解决任务中,定义和评估实际奖励非常困难。(@AI 寒武纪)

2、扎克伯格:开源是 AI 积极发展的必要条件

Meta 创始人兼首席执行官马克・扎克伯格在「Open Source AI Is the Path Forward」的公开信中,以闭源版 Unix 和开源 Linux 的发展为例,类比了 AI 行业的发展。「在高性能计算的早期,当时的各大科技公司都投入巨资开发自己的闭源版 Unix。当时很难想象还有任何其他方法可以开发出如此先进的软件。但最终,开源 Linux 还是流行起来了...... 我相信 AI 也会以类似的方式发展。如今,一些科技公司正在开发领先的封闭模型。但开源正在迅速缩小差距。」

扎克伯格认为开源 AI 将有利于开发人员、Meta 以及整个世界。他指出,开源是 AI 积极发展的必要条件,将确保全世界更多的人能够享受到 AI 带来的好处和机遇,确保权力不会集中在少数公司手中,确保这项技术能够在全社会得到更均衡、更安全的应用。「当你考虑未来的机遇时,请记住,当今大多数领先的科技公司和科学研究都是建立在开源软件之上的...... 最重要的是,开源 AI 能代表了世界上利用这项技术为每个人创造最大经济机会和安全的最佳机会。」(@OSCHINA)

写在最后:

我们欢迎更多的小伙伴参与「RTE 开发者日报」内容的共创,感兴趣的朋友请通过开发者社区或公众号留言联系,记得报暗号「共创」。

对于任何反馈(包括但不限于内容上、形式上)我们不胜感激、并有小惊喜回馈,例如你希望从日报中看到哪些内容;自己推荐的信源、项目、话题、活动等;或者列举几个你喜欢看、平时常看的内容渠道;内容排版或呈现形式上有哪些可以改进的地方等。

素材来源官方媒体/网络新闻