马斯克一直在指责 OpenAI 没有开源,终于开源自家的大模型 Grok-1,也把压力给到了 OpenAI

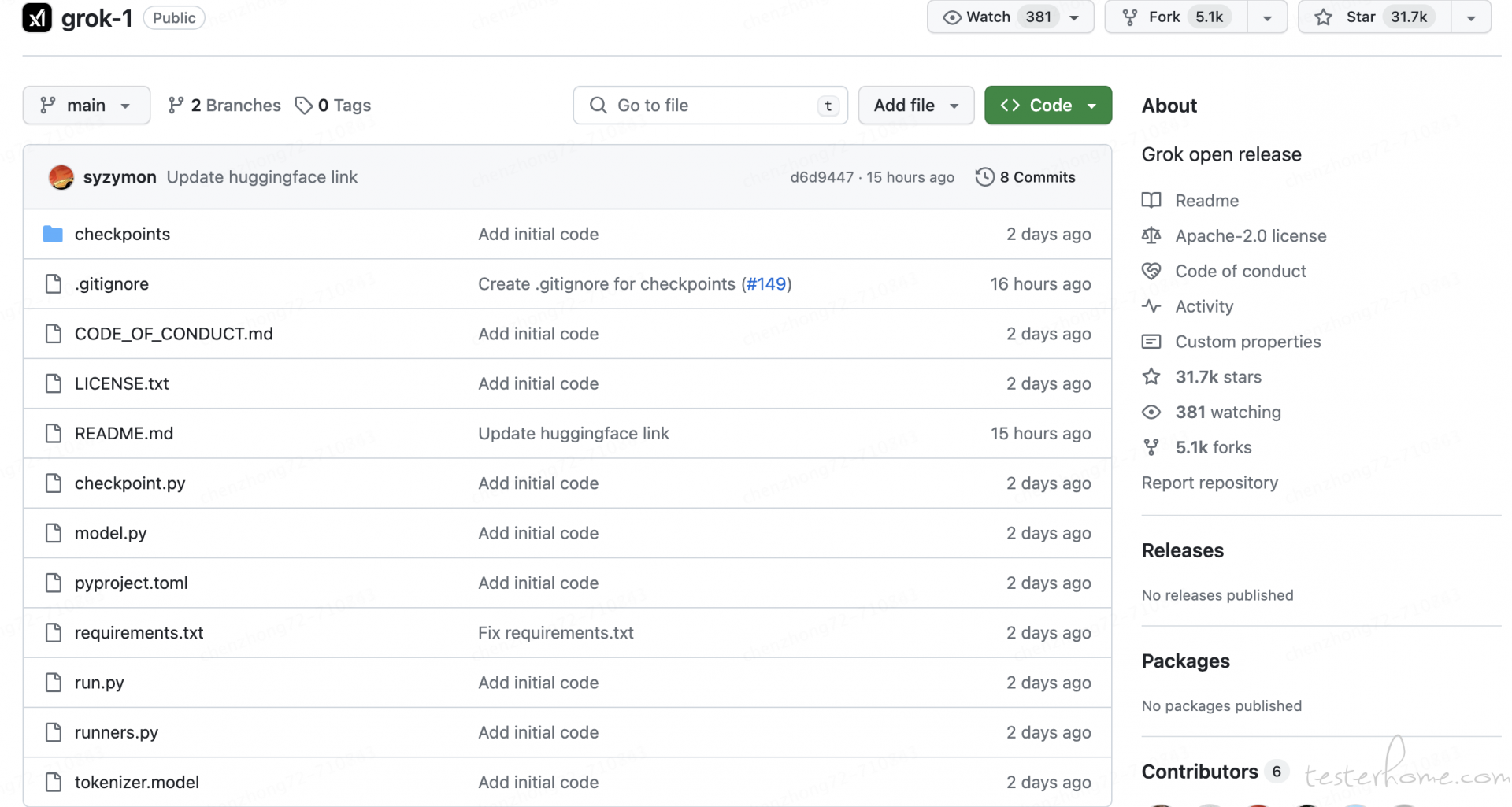

GitHub 链接:https://github.com/xai-org/grok-1

居然短短一天就有 29k 的 star!

Grok-1 的模型参数:

•Parameters: 314B

•Architecture: Mixture of 8 Experts (MoE)

•Experts Utilization: 2 experts used per token

•Layers: 64

•Attention Heads: 48 for queries, 8 for keys/values

•Embedding Size: 6,144

•Tokenization: SentencePiece tokenizer with 131,072 tokens

•Additional Features: Rotary embeddings (RoPE)

•Supports activation sharding and 8-bit quantization

•Maximum Sequence Length (context): 8,192 tokens

第一步:下载模型权重

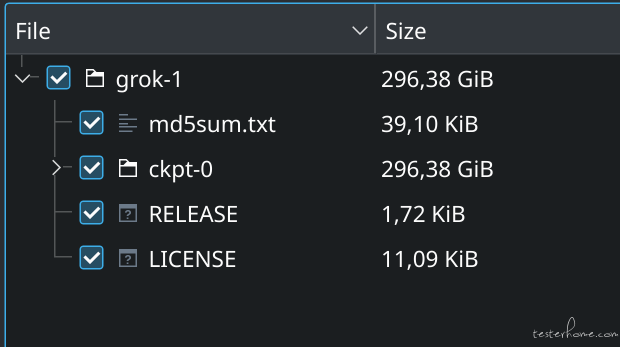

用户需要确保先下载 checkpoint,并将 ckpt-0 目录放置在 checkpoint 中。

模型权重约为 296.38 GB,如下图,要注意自己磁盘的容量

有下面两种下载方法

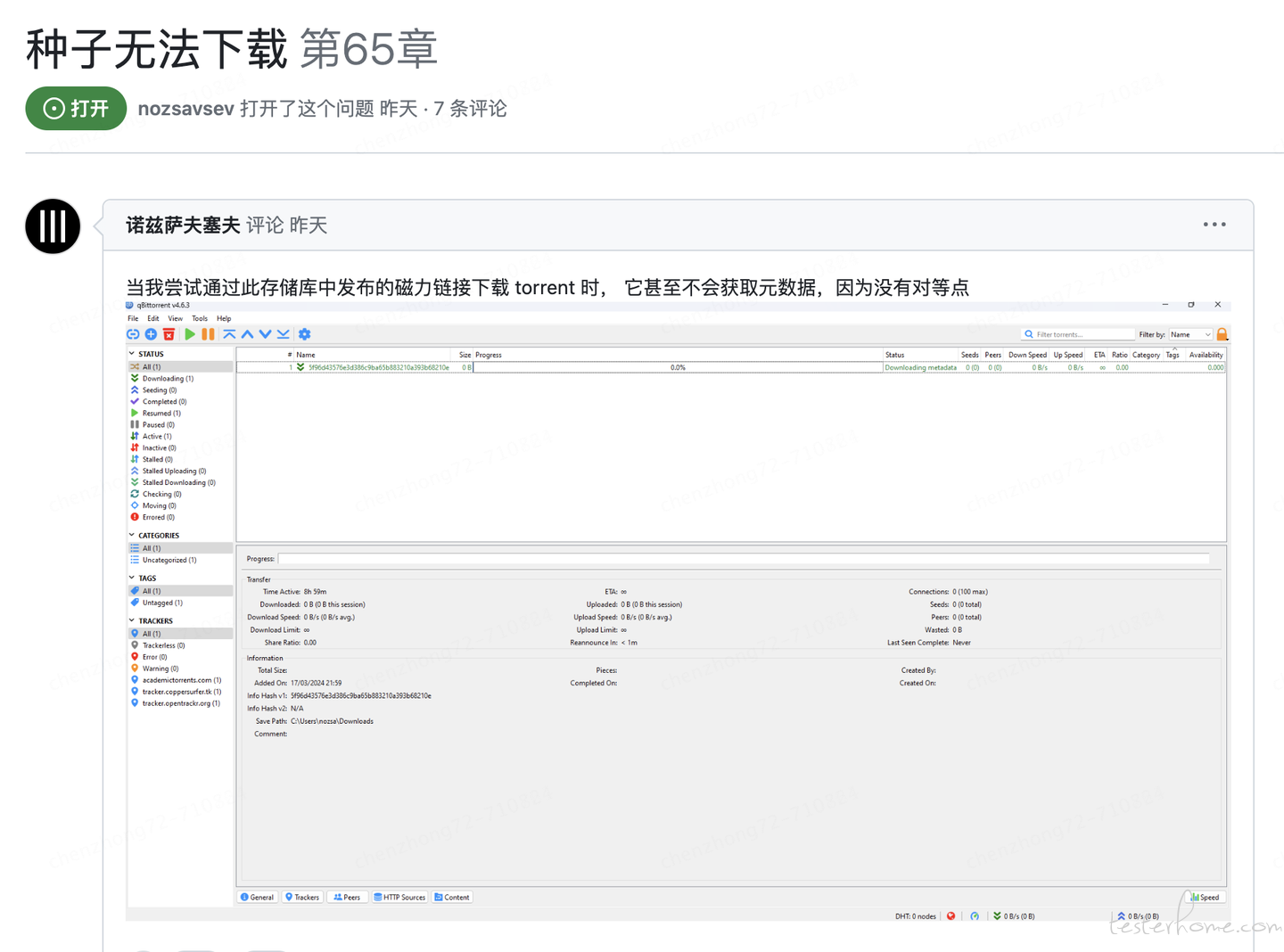

1.可以使用 torrent 客户端和此磁力链接下载权重

magnet:?xt=urn:btih:5f96d43576e3d386c9ba65b883210a393b68210e&tr=https%3A%2F%2Facademictorrents.com%2Fannounce.php&tr=udp%3A%2F%2Ftracker.coppersurfer.tk%3A6969&tr=udp%3A%2F%2Ftracker.opentrackr.org%3A1337%2Fannounce

- 直接使用 HuggingFace

链接 https://huggingface.co/xai-org/grok-1

HuggingFace 上面有很多预训练模型(如 GPT,BERT),也有很多数据集,十分强大 ,推荐大家使用

执行下面的代码

git clone https://github.com/xai-org/grok-1.git && cd grok-1pip install huggingface_hub[hf_transfer] huggingface-cli download xai-org/grok-1 --repo-type model --include ckpt-0/* --local-dir checkpoints --local-dir-use-symlinks False

第二步:运行大模型

安装依赖环境,执行代码

pip install -r requirements.txt

requirements.txt 的文件内容:

dm_haiku==0.0.12

jax[cuda12_pip]==0.4.25 -f https://storage.googleapis.com/jax-releases/jax_cuda_releases.html

numpy==1.26.4

sentencepiece==0.2.0

然后执行代码

python run.py

注意:硬件要求多大呢?

由于模型规模较大(314B 参数),需要有足够 GPU、内存的机器才能使用示例代码测试模型。

那具体需要多大呢?

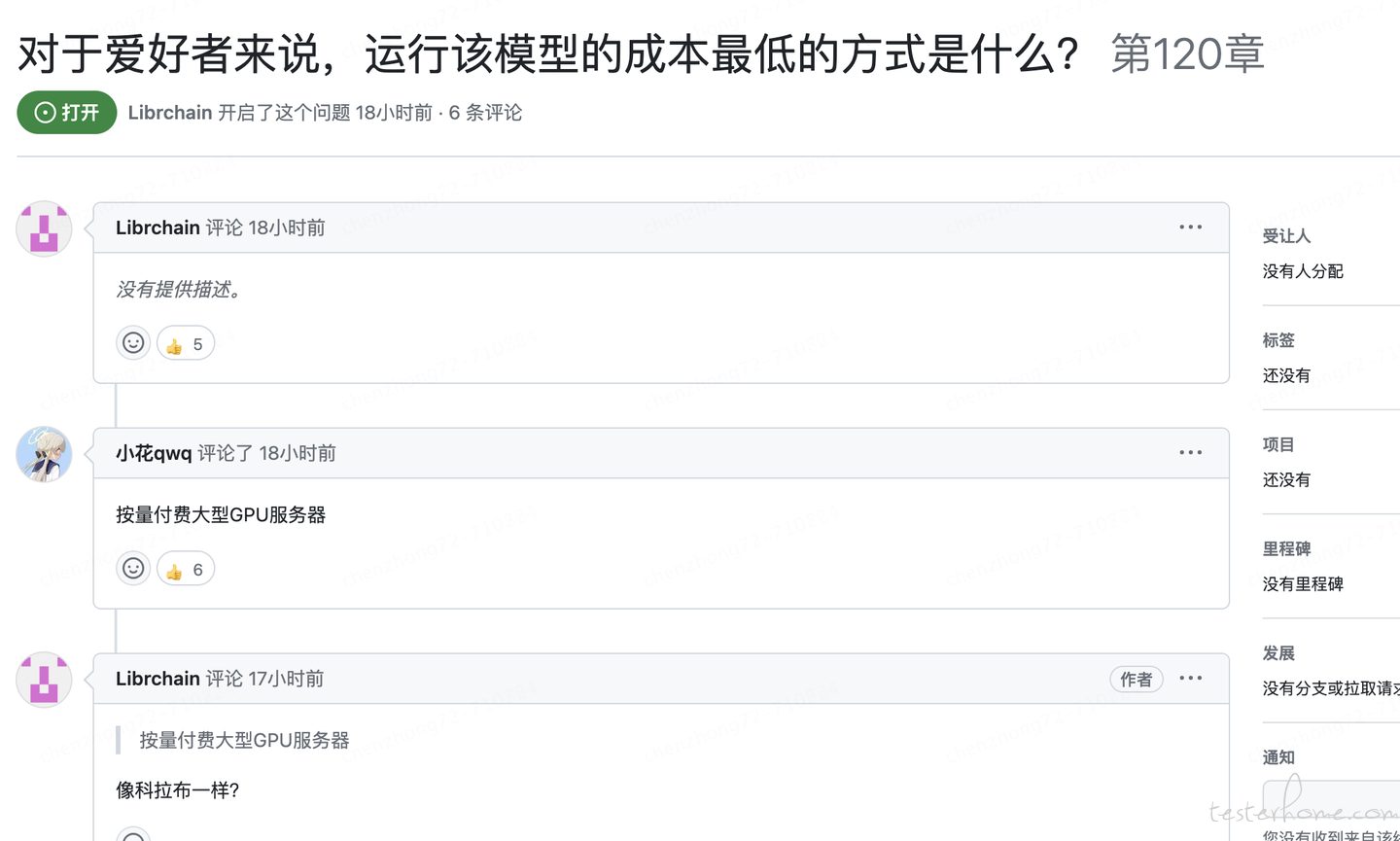

这个也是提的比较多的问题,有人给出了回复,但暂时未确认

由于由于 the mesh shape assertion(1, 8),因此需要 8 个 GPU。要以本机大小运行,您可能需要 8x80GB GPU (A100 80GB / H100GB)。

详见 issue:https://github.com/xai-org/grok-1/issues/62

容易出现的问题

大家遇到比较多的是下载问题,比如种子无法下载

还有硬件资源的问题,毕竟需要的 gpu 和内存太高了,对于个人来说成本太高了,个人没法玩了啊