前言

在做接口性能测试的时候也使用过几个工具:AB、Jmeter、Locust、Vegeta。

这几个工具中,应该当属 Jmeter 的功能最强大,使用的人也最多,但使用上也比较繁琐,如果测的接口比较单一,需要得到的值也就是并发量、每秒请求数、响应时间这三个的话,那就推荐使用个简单点儿的工具。在这儿主要介绍 Locust,原因无非是使用简单,另外在 web 界面能实时显示性能测试情况,可以随时调整参数,也支持分布式。

使用 Locust 也需要编写脚本,对于不熟悉 Python 的人来说,又是一个障碍。为此笔者编写了一个工具Easy-Locust,Locust 的几种使用方式都有,并且参数和 Locust 也保持一致,需要操作的就是在 Excel 中编辑好参数就行。

GitHub: Easy-Locust

使用介绍

安装

执行下面命令会自动安装 easy-locust 及 locustio>=0.13.5 的版本

pip install easy-locust

参数介绍

此处只介绍和 Locust 不同的地方,如果想了解详细参数,请查阅:Locustio

-f 如果为.py文件则直接执行,如果为.xls文件则根据里面的配置生成locustfile并执行

--demo 在当前文件夹下生成`PtDemo.xls`文件和`demo.json`,可以根据此文件进行配置

--xf 根据.xls文件生成locustfile但不执行(或根据json文件生成locustfile)

-d 在master模式下此参数生效,自动向slave机器发送locustfile文件并在slave机器中开启服务,前提是slave机器中装有locustio>=0.13.5

API 调用介绍

传入对应的 dict 格式,返回 string 格式的 Locustfile。

import easy_locust

data = {

"config": {},

"apis": [],

"auth": {},

"user_info": [],

"master_ip": "",

"slaves": []

}

locustfile_str = easy_locust.factory(data)

XLS 模板配置介绍

一共 4 个 sheet 页,逐一进行介绍

-

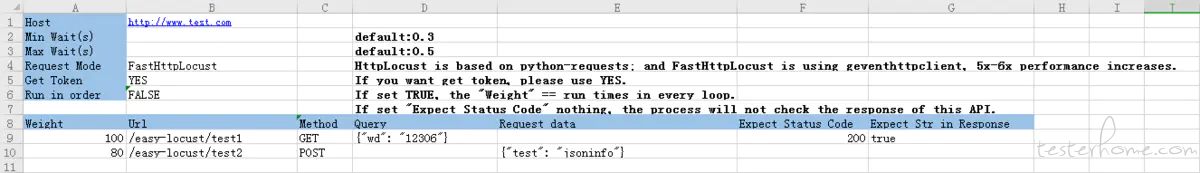

PT:locust 主要参数

下面为参数说明:Host ——需要进行测试的接口URL前缀 Min Wait ——最小等待时间(s),默认0.3s Min Wait ——最大等待时间(s),默认0.5s Request Mode ——请求模式,Locust中模式有两种,一种为HttpRequest基于python-requests,另一种为FastHttpRequest基于geventhttpclient,性能是前者的5-6倍 Get Token ——是否获取token进行认证,如果选择YES的话需配置AuthInfo页 Run in order ——是否按顺序执行下面的接口 # 下面为对接口的配置 Weight ——接口权重,如果Run in order为TRUE,则为每轮次接口执行次数 Url ——接口url Method ——接口请求方法 Query ——query参数(json格式) Request data ——请求体(json格式) Expect Status Code ——期望响应码(为空默认则判断4XX/5XX为失败) Expect Str in Response ——在返回体中的期望字符串 -

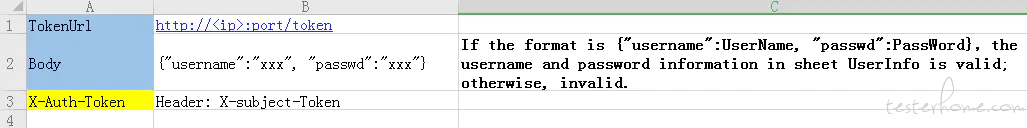

AuthInfo:认证参数

TokenUrl ——获取token的接口(默认POST方法) Body ——请求体不局限于模板中的格式,如果填写参数中填写UserName和PassWord的话,UserInfo中的数据会生效 X-Auth-Token ——图例中为从返回的Header中获取x-subject-token的值,并放到性能测试接口的x-auth-token参数中,表格中x-auth-token值可以更改除了可以从 Header 中获取 token 外还可以从 json 中获取,格式为

Json: body.token,获取到的值会在调用接口时填充到 header 中,这个地方在 Excel demo 文件中无法配置,如果要改的话,可以生成 locustfile 文件,然后小改一下 locustfile 文件即可。 -

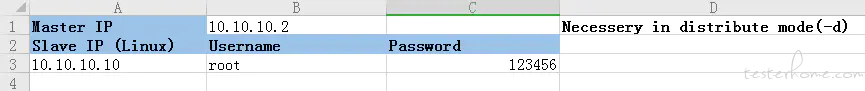

Slave:分布式压测,压测机信息

Master IP ——当前机器的IP地址 Slave IP ——压测机IP Username ——后台登陆用户名 Password ——后台登陆密码注意:需要指定

-d参数才可生效;各压测机中需要提前安装好相同版本的 locustio>=0.13.5 -

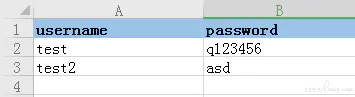

UserInfo:用户登陆信息,配合 AuthInfo 使用

username ——用户名 password ——密码如果希望使用多个用户信息随机进行压测则可以使用此功能。

与 Jmeter 对比

这篇比较的文章比较不错,贴一下:性能测试工具 Locust 和 JMeter 比较,文章中提到并发用户数那,jmeter 和 locust 实现的机制不一样,所以测得的值也是有差别的,一般同样并发数下 jmeter 的每秒请求数更高一些。

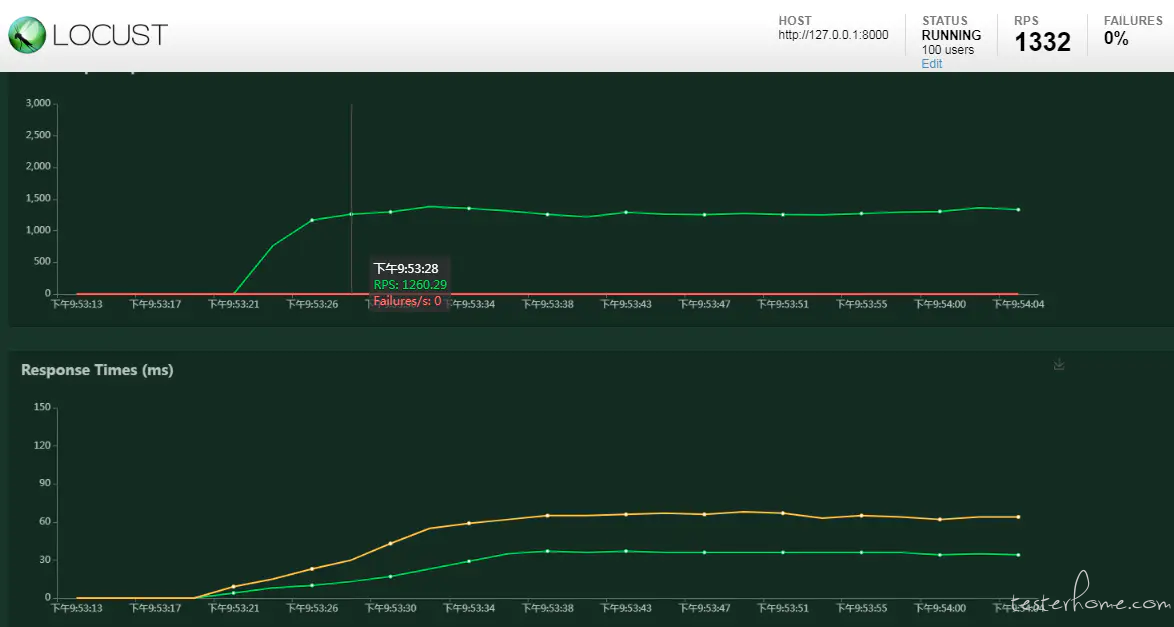

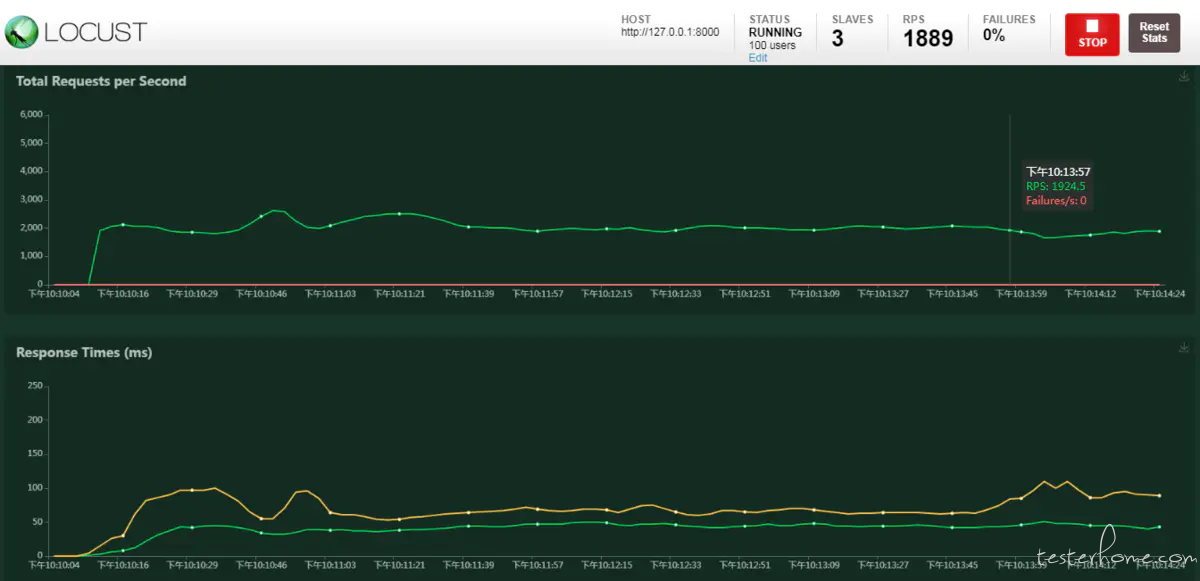

Locust 开启服务只占用一个进程,如果机器是多核的,则可以开启 master-slave 模式,开一个 master,剩下几核就开启几个 slave,充分利用机器性能。下图是在本地笔记本(虚拟 4 核)上执行的普通模式和master-slave 模式的对比:

master-slave 模式下 RPS 最高值达到了 2600,最低值 1300,大概稳定在 1900 左右。

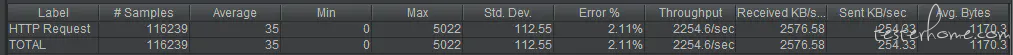

下面是使用 Jmeter 的一个测试数据:

Throughput 峰值达到了 3000,最低值 1900,后续稳定在 2200 左右,但出现了报错,不过服务端那并没有报错。

上面三张图对比,可以看出在单核机器上如果使用 Jmeter 和 Locust 的话测得的数据应该相差不大,多核机器上 Locust 需要使用 master-slave 模式才能达到 Jmeter 的性能。不过说到底,两者之间对并发用户数的实现是不同的,测得的数据必定有差值。

后记

性能调优或测个粗指标的话,十八般工具都可以用,只要保证一直使用同一个工具测就行了。如果测精细指标的话,还得是工业级别的工具/测试仪来完成。

另外 Locust + Boomer 在相同并发数的情况下,RPS 比 Jmeter 还要高,得益于 Go 语言天生的优势,可以直接使用 Boomer 示例中的 client 文件,获取编译好的文件及简单使用方法点击下面链接:

http://note.youdao.com/noteshare?id=38202fe283539461e3a49b800949bc9d&sub=683B4DBECED3468CACFC386E51F8B33E