之前看过文档,max_wait/min_wait: 每个用户执行两个任务间隔时间的上下限(毫秒),就是说如果都设置 1000 的话,每秒就能固定发送多少个请求,

但是实际使用发现并不是这样,虚拟用户数设置为 1 个,总共发送 100 条请求

执行结果抓包发现有时候会跳秒,大概 20 多条跳 1 秒,平均相应时间几十毫秒,是发出去的时间 + 等待时间 + 响应时间?

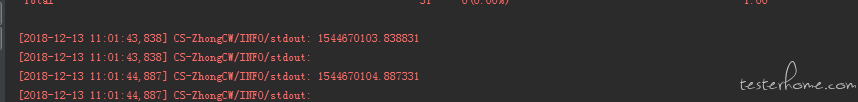

然后把每次请求发出去的时间打了出来,他们之间的间隔确实不止 1 秒,是 1 秒 + 上一个接口响应的世界

那这样的话要每秒并发几千的话,误差会很大,这种怎么解决??