一盏小灯 提前的年度总结

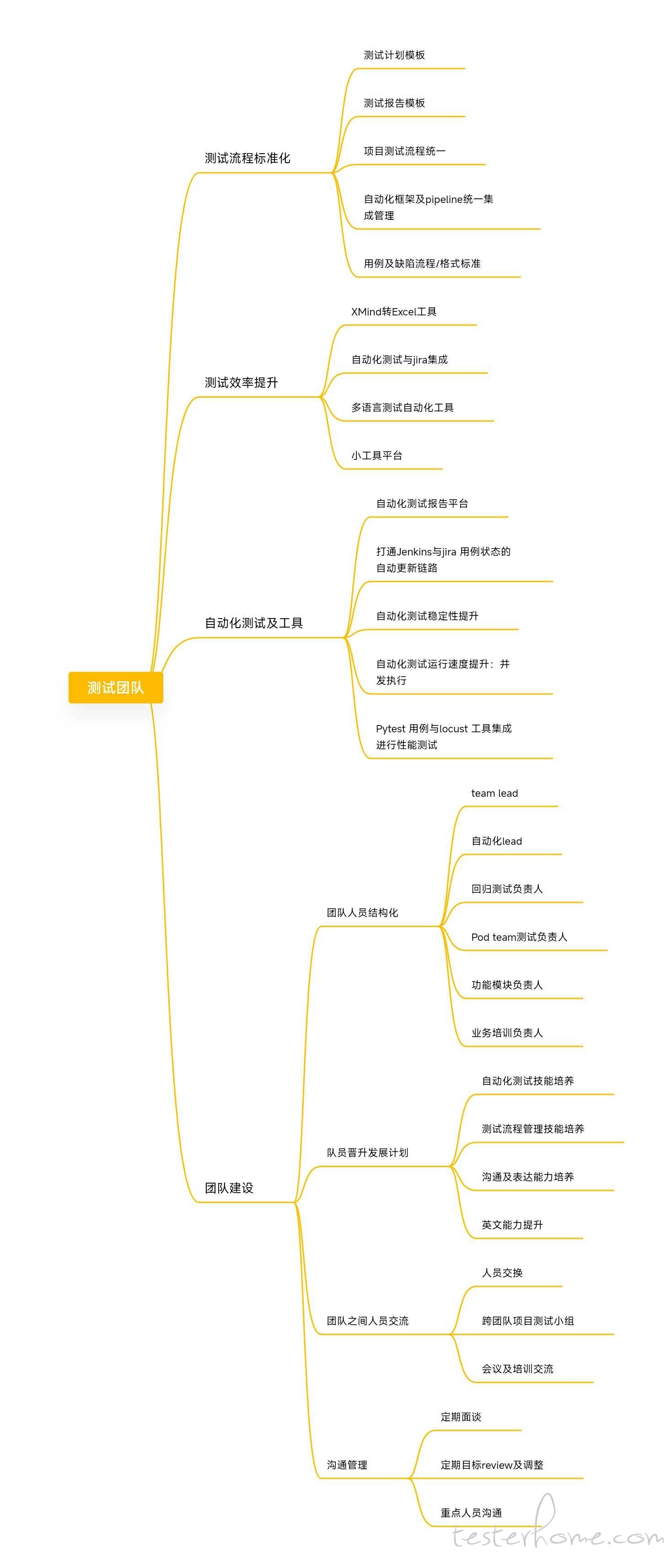

好久没更新什么内容了。这段时间在做团队的年度总结,把大致的点列一下吧:

我昨天准备年终总结,结合年初计划,咦,我年初计划是这样的??

好奇 “多语言测试自动化工具”

工作内容大体上差不多

楼主可以介绍一下 自动化测试与 Jira 集成 jenkins 与 jira 打通 具体是做什么吗?

我们在自动化用例的注释上面会加上对应用例的 jira ID,pipeline 会在跑完自动化用例之后会自动收集执行结果,然后调用 jira 的 api 把结果更新到对应的 cycle 上面。 这样在大版本回归测试的阶段,我们可以直接看到自动化已经跑通了多少用例,剩下没跑通的就通过手工测试去补充。

之前没有打通这个链路,是每个测试的同事要根据自动化的结果把用例一条一条地去标记结果,很浪费时间。

请问自动化并发执行后,测试结果的日志怎么处理的,现在我们的日志在自动生成的测试报告里都是乱序的,基本上不能通过日志来排查问题

你们用的是什么框架?

我们这边是在原来的 pytest+allure 的 api 测试上面加入了 pytest-xdist 插件来做并发执行,对结果没有什么影响,allure 里面还是能正常看到每条用例的日志和输出。

我用的 pytest-parallel 和 pytest-html,多线程执行无法收集到正确的日志

刚刚测试了 xdist,可以收集到日志,谢谢

如果对用例管理,或者执行统计,燃尽图之类的有需求,可以考虑一起加进去。

我们针对用例部分的效率提升,除了是和自动化用例挂钩之外,还有一个就是将 xmind 的测试点转换成 jira 的 Excel 模板格式用例,达到批量用例上传的效果,提高用例的转换效率。

xmind 数据解析生成用例 我也了解过 需要指定 xmind 的格式才行吧 我们的测试点分析没有一定的格式 解析起来比较麻烦 而且我们的用例大部分是以 Word 格式存储的(交付需要) 所以没有朝这方面发展

jira 方面现在只做了缺陷的跟踪提醒,每天定时统计缺陷,

对测试发送当日的新增、关闭、待复验的缺陷信息以及缺陷信息规范性校验

对研发发送各自关联的待解决缺陷,延期缺陷和一些其他的预警信息 另外数据落盘方便后续的统计分析