一、环境准备(没有 GPU 可以考虑使用 2B 尺寸的模型,自己本地电脑无 GPU,内存 16G,运行 8B 的进行推理,基本卡死不可用)

1)Linux:

1.1、python 安装:

务必注意这里需要安装 3.8 版本以上

sudo apt update

sudo apt install python3

python3 --version

1.2、pytorch 安装

pip3 install torch torchvision torchaudio -f https://download.pytorch.org/whl/torch_stable.html -t /data2/torch

2)windows:

1.1、安装 python

1.2、pytorch 安装

二、相关开源软件下载(windows 使用 gpt4all,里面需要使用 llama.cpp 量化部署,下期会重点讲解)

1)ollama

curl -fsSL https://ollama.com/install.sh | sh

2)open-webui

docker run -d --network=host -v open-webui:/app/backend/data -eOLLAMA_BASE_URL=http://127.0.0.1:11434 --name open-webui --restart always ghcr.io/open-webui/open-webui:main

三、启动运行

1)ollama(如果网络限制建议来个科技,hugface 上下载一个 gguf 模型,0llama 本地加载,下期也会重点讲解)

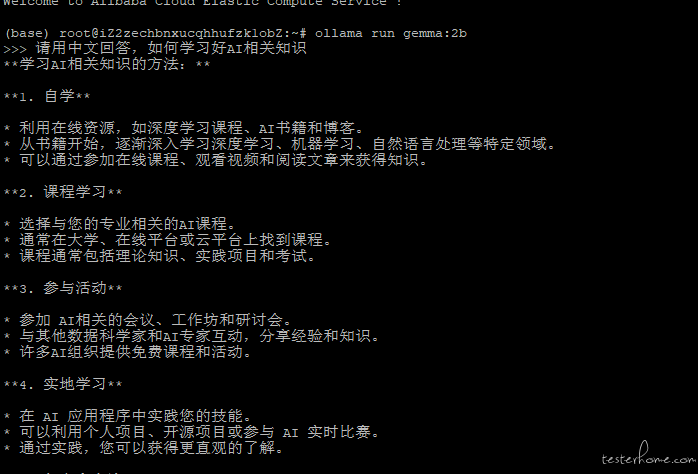

ollama run gemma:2b(这里用的是一个开源的 GOOGLE 的 2B 大模型)也可以 qwen:7B

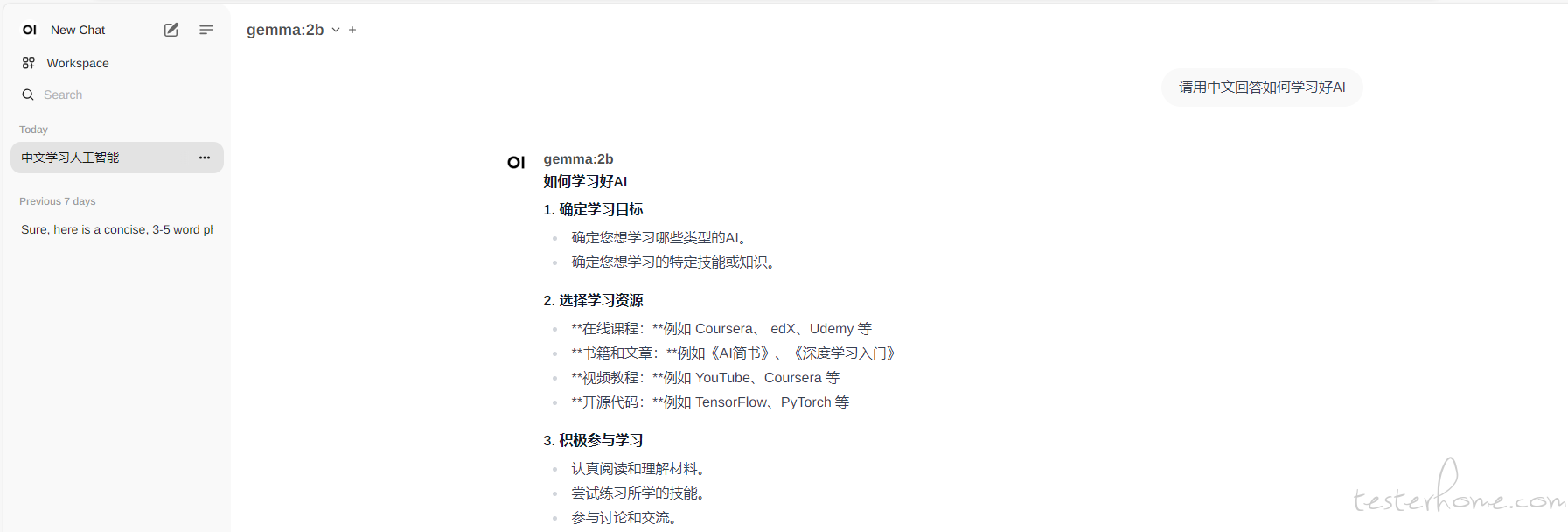

2)open-webui

docker start open-webui(docker ID)

http://自己的 IP 地址:8080/

四、效果: