2、破解

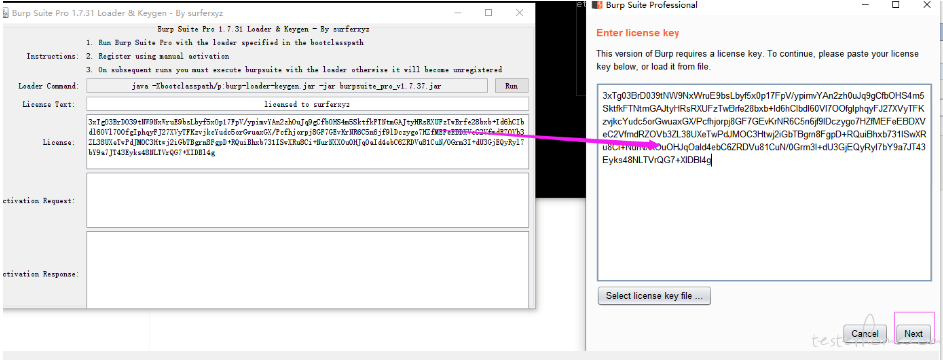

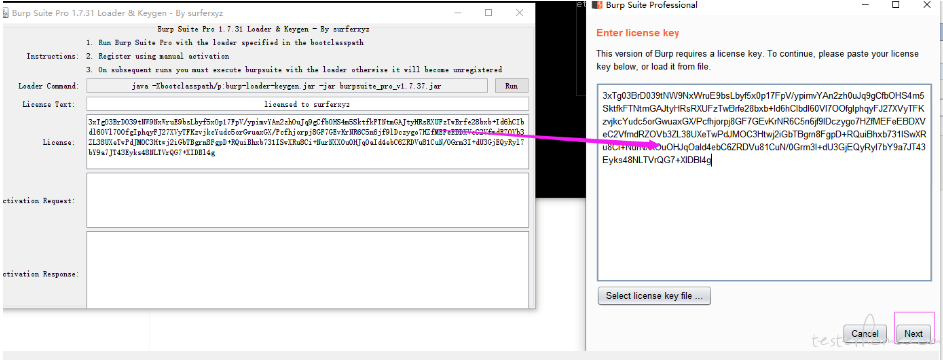

CMD 命令行中输入:java -jar burp-loader-keygen.jar

点击 Run 即可启动 BurpSuite 的主程序

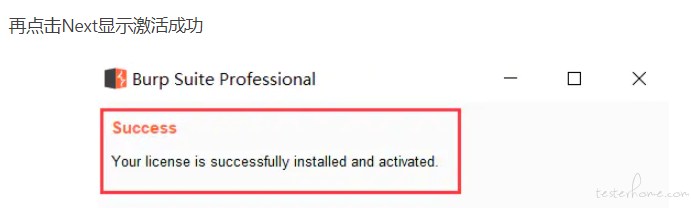

注意将左侧 keygen 中得到的 License 复制粘贴到这里然后点击 Next

Burpsuite 是一款渗透性测试工具,以拦截代理的方式,拦截所有通过代理的客户端请求,服务器端的返回信息等。

目标 Target,代理 Proxy、爬虫 Spider、扫描 Scanner,入侵 Intruder 是 Burpsuite 的核心功能。重放 Repeater,序列器 Sequencer,解码器 Decoder,对比 Comparer 是辅助功能。

Bursuite 支持第三方拓展插件,可以在线安装,也可以手动安装,比如 Sqlmap

1、需要 java jdk 1.8 的环境,并设置好环境变量

2、破解

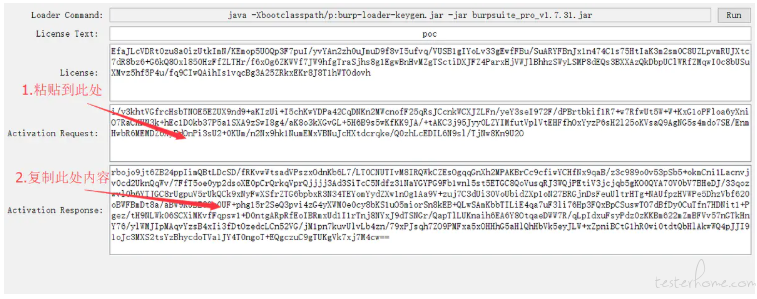

CMD 命令行中输入:java -jar burp-loader-keygen.jar

点击 Run 即可启动 BurpSuite 的主程序

注意将左侧 keygen 中得到的 License 复制粘贴到这里然后点击 Next

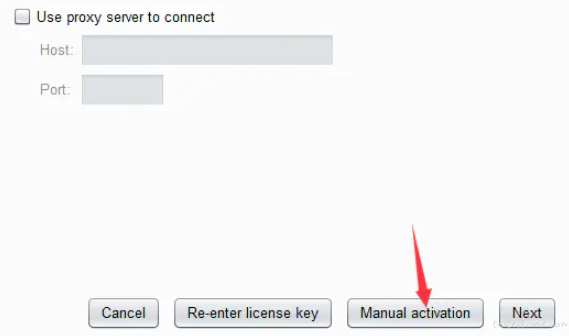

点击 Manual activation

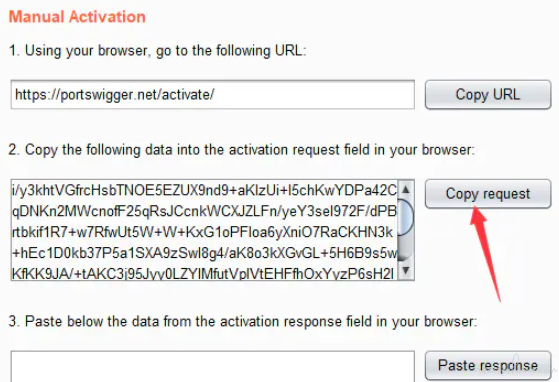

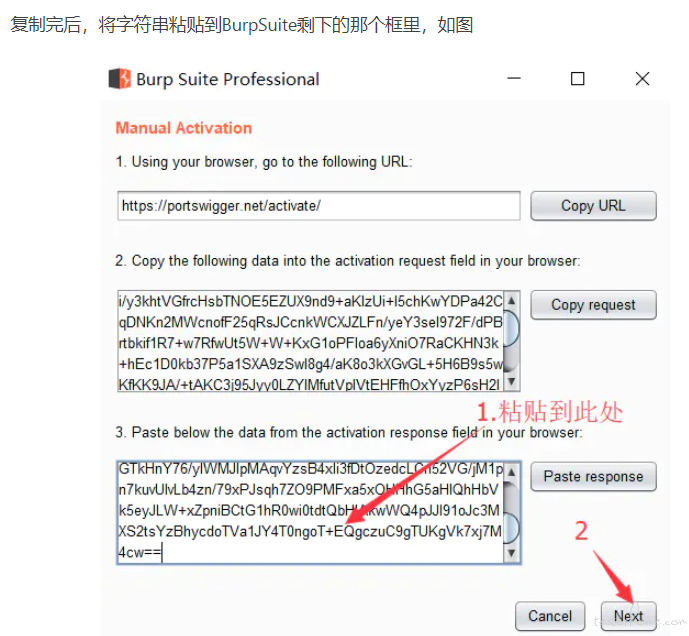

点击 Copy request,复制完成之后,将字符串粘贴到首次打开的 keygen 的 Activation Request 框里,然后 Activation Response 框里就有了结果,如下

激活之后,不能通过双击 BurpSuite 主程序来启动,否则启动之后还是需要输入 key,两个文件必须放在一个目录下,启动方式有两种

1、通过 keygen 上的 run 按钮来启动

2、在文件目录下执行 java -Xbootclasspath/p:burp-loader-keygen.jar -jar burpsuite_pro_v1.7.31.jar 来启动.为了方便,可以将命令保存为一个 bat

目标 Target 是代理 Proxy、爬虫 Spider、扫描 Scanner,入侵 Intruder 的基础,得先要有目标 Targe。其中入侵 Intruder 主要是后台网站的入侵爆破。

User options-Display,设置字号大小以及字体(尽量选择中文),目的减少中文乱码的情况,但 Burpsuite 没办法彻底解决乱码的问题,只能尽量减少。

目标 Target:目标模块用于设置扫描域,生成站点地图。

代理 Proxy:代理模块用于拦截浏览器的 http 会话内容。

爬虫 Spider:爬虫模块用于自动爬取网站的每个页面内容,生成完整的网站地图

扫描 Scanner:扫描模块用于自动化检测漏洞,分为主动和被动扫描

入侵 Intruder:入侵模块根据前面检测到的可能存在漏洞的链接,调用攻击载荷,对目标链接进行攻击。其原理是根据访问链接中存在的参数变量,调用本地词典,攻击载荷,对参数进行渗透测试。

重放 Repeater:重放模块用于实现请求重放,通过修改参数进行手工请求回应的调试

序列器 Sequencer:序列器模块用于检测参数的随机性,例如密码是否可预测,以此判断关键数据是否可被伪造。

解码器 Decoder:解码器模块用于实现对 URL,HTML,Base64,ASCII,二/八/十六进制,哈希等编码转换。

对比 Comparer:对比模块用于对两次不同请求和回应进行可视化对比,以此区分不同参数对结果造成的影响。

1、首先把本机防火墙关闭

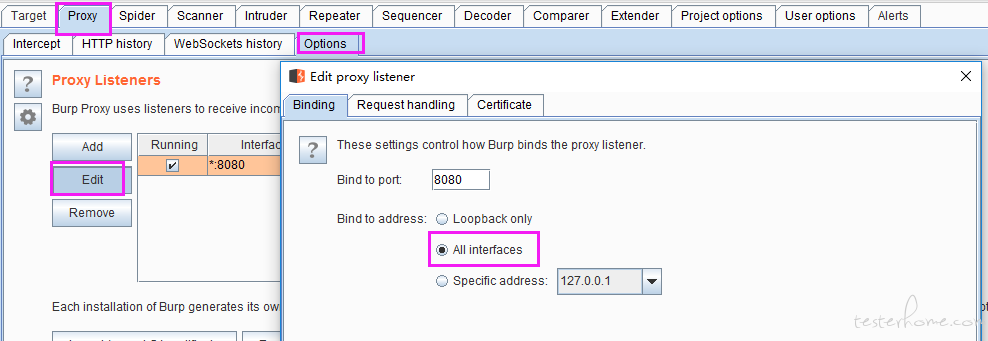

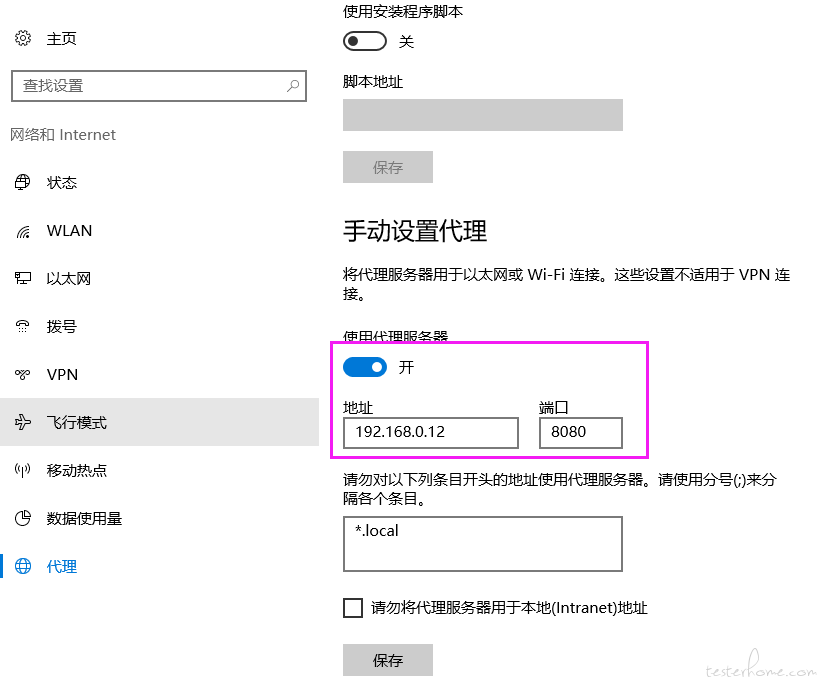

2、设置 Burpsuite 代理

Targer-Scope:范围,即作用域

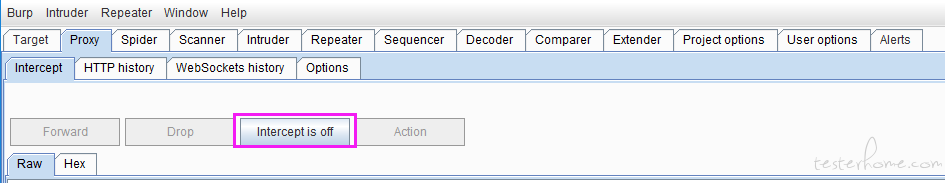

Proxy-Intercept:拦截,默认拦截器是开着的(intercept is on),若被拦截了,需要点击 Forward 或 Drop;若不需要拦截,则点击 intercept is on 则为 off 状态。拦截不是必须得,但要求数据包能过到这。

为了获取站点地图,需先将协议拦截关闭了;所有的爬虫,入侵,漏扫,都需要以代理为基础,必须要有代理,数据包得过这才可以。(爬虫功能一定要关闭拦截)

Burpsuiter 自己不能直接访问,需要通过代理去访问网站。Proxy-Option:默认本机可以使用代理

表示所有主机可以使用代理

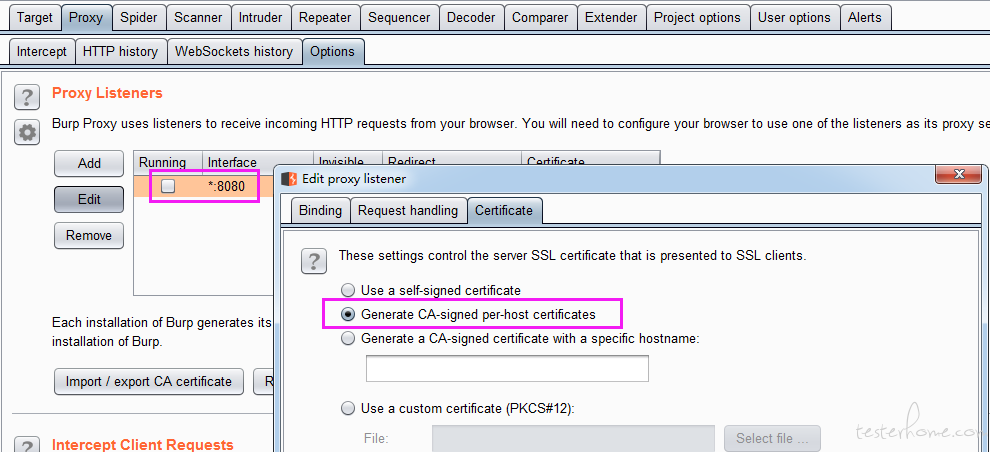

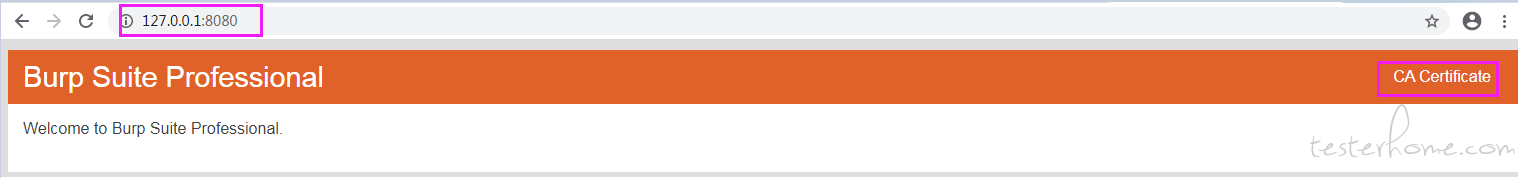

下载安装证书

下载证书

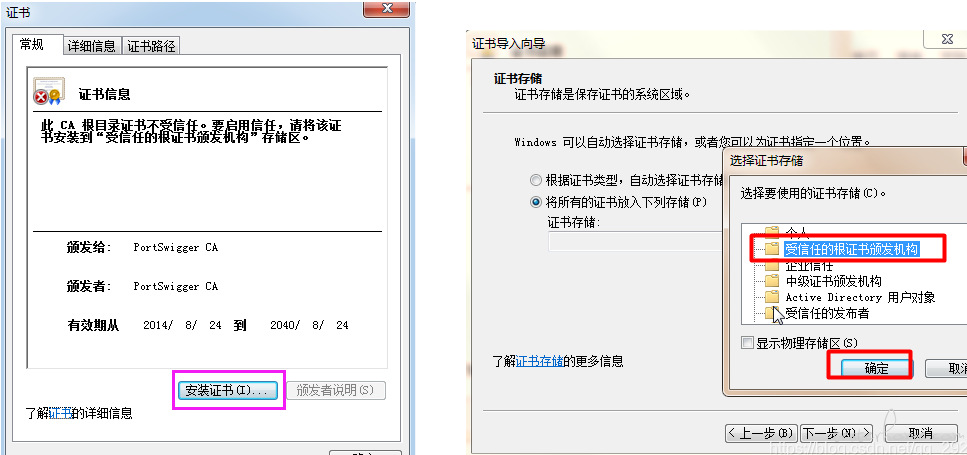

安装证书

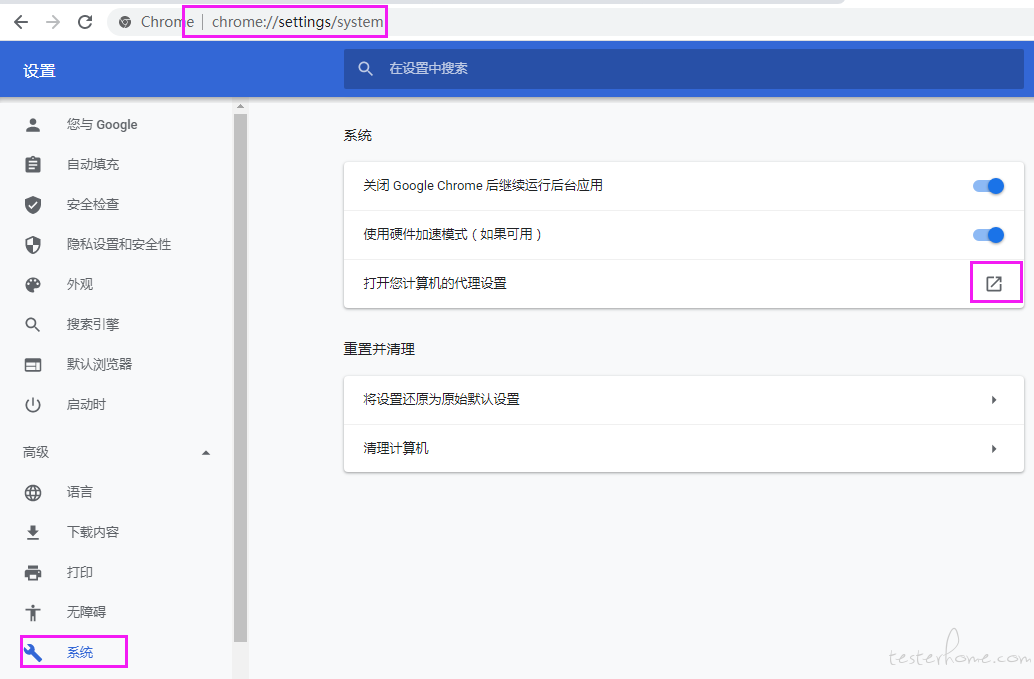

3、设置浏览器代理

4、获取站点地图

打开目标网址,可自动获取站点地图。站点地图中,有的链接是灰色的,有的是黑色的,说明 Scanner 已经在帮你做一部分的被动扫描,灰色的说明那些网页还并没有访问。

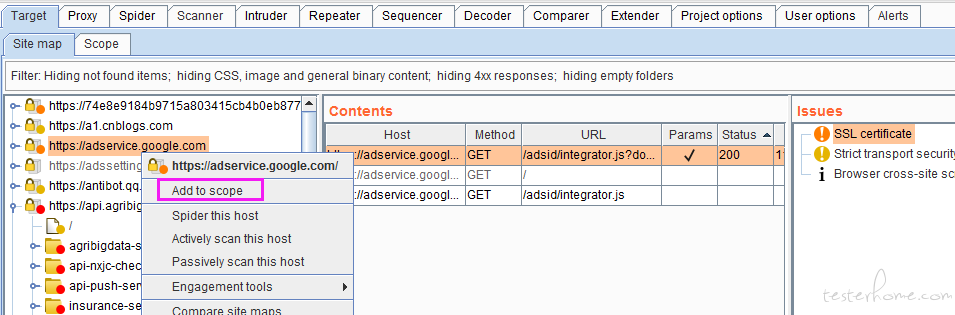

把想要的站点添加到 Scope 中

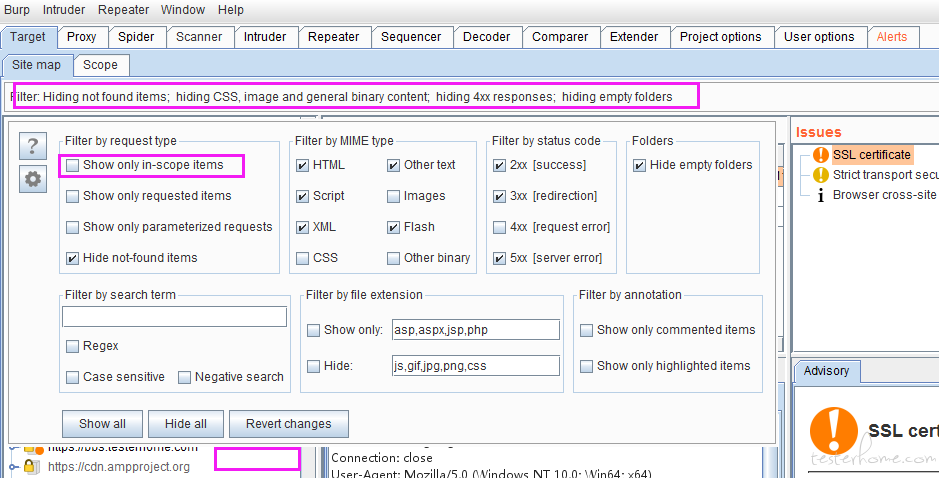

5、只显示 Scope 域内的站点,设置好后,点击站点空白处即可

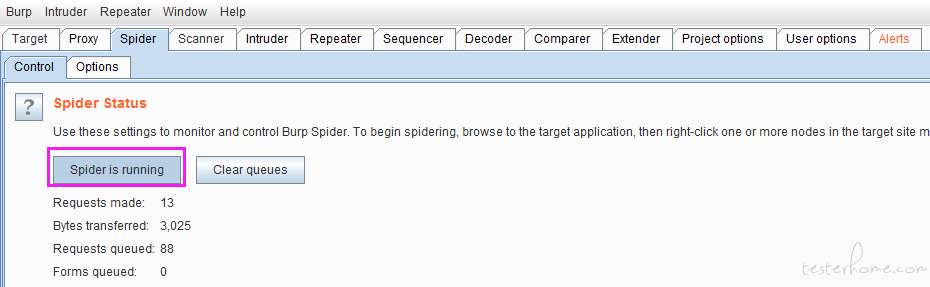

6、开启爬虫

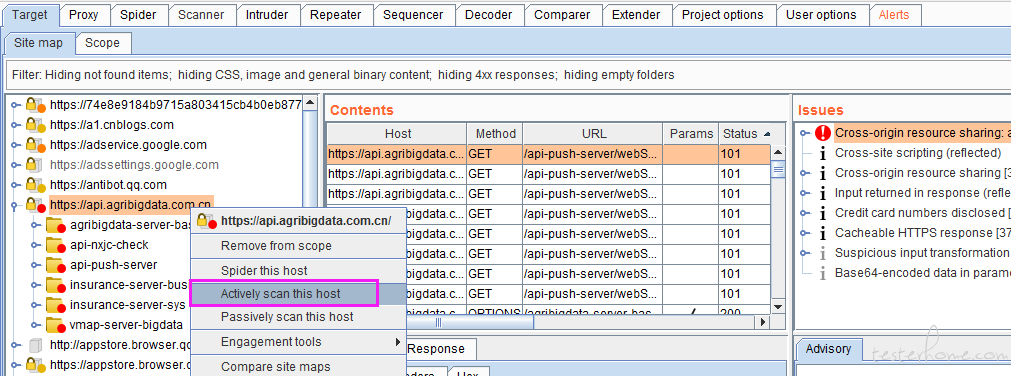

7、开启扫描

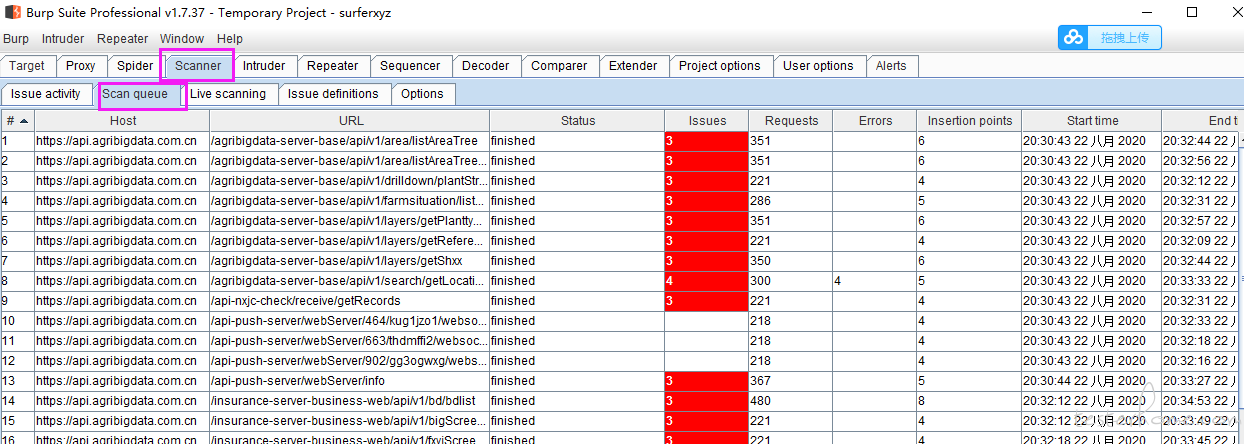

8、查看漏扫队列

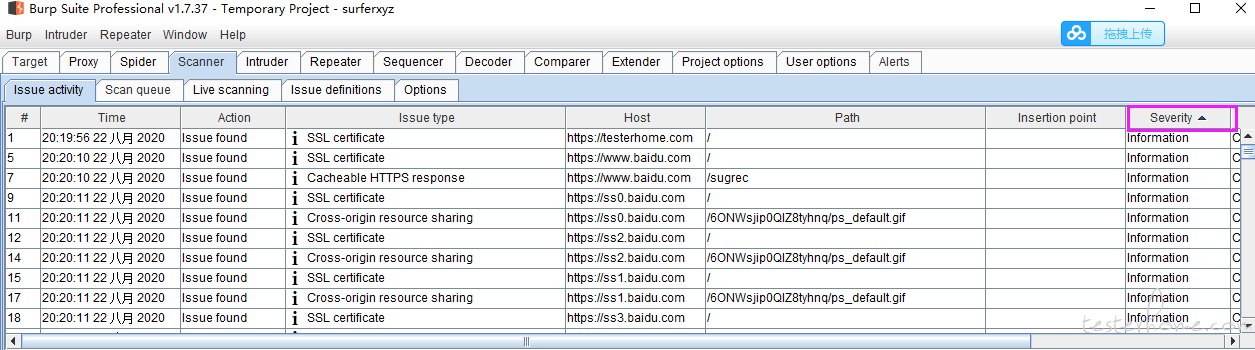

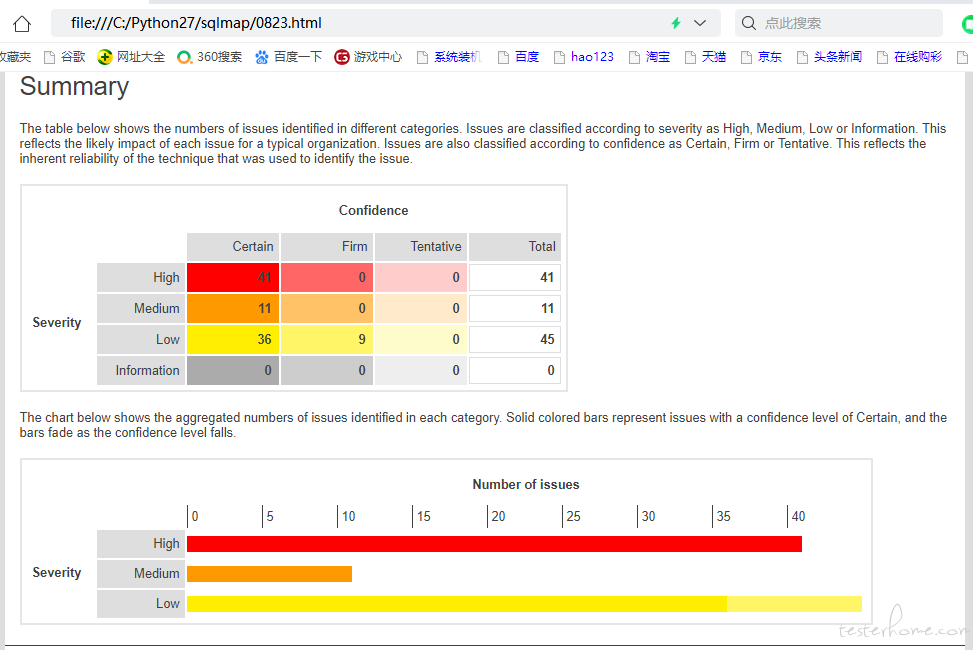

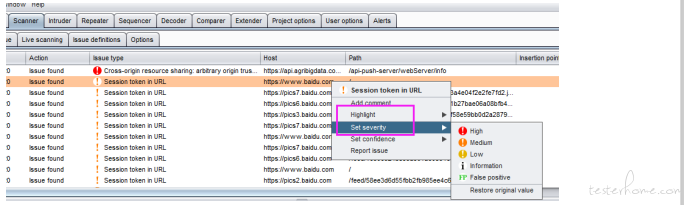

9、漏洞问题排序

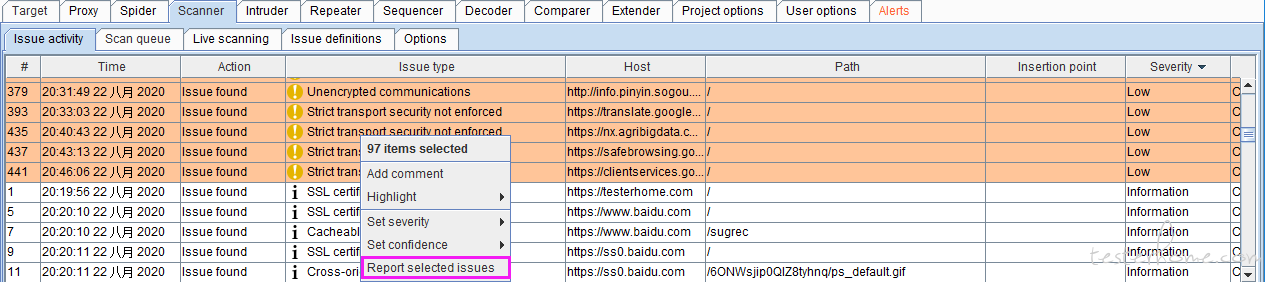

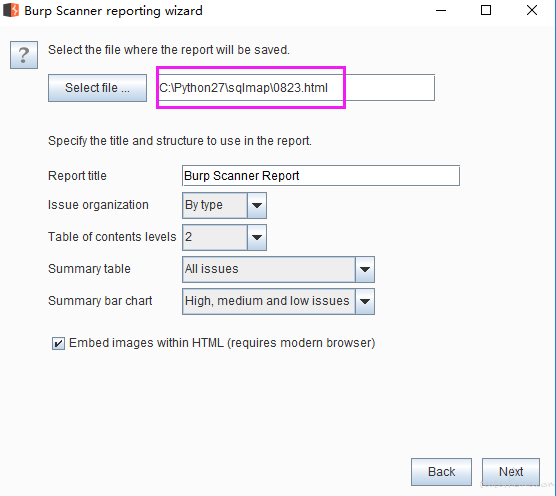

10、选择高中低问题,并导出生成报告

导出为 html 格式

注意文件名必须是 html 后缀

robots.txt 爬虫协议,一般网站禁止爬取;notfound,non-text,没有必要爬取。

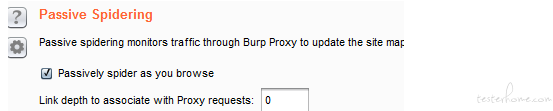

被动爬取:被动爬虫功能基于手工爬虫来更新站点地图,而不需要重新发送新的请求。

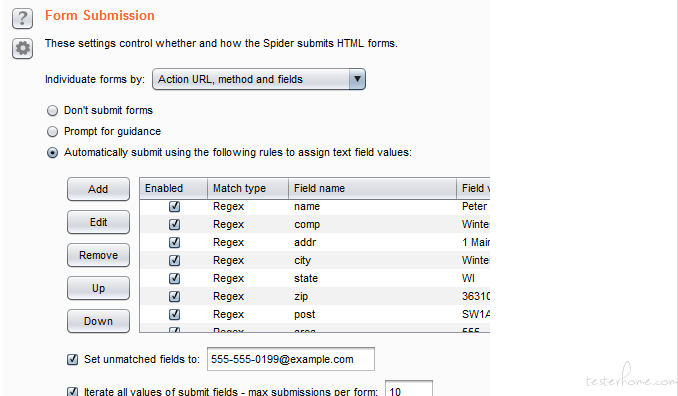

表单提交:prompt for guidance 提交时弹框并手工设置。 第三个是正则匹配并采用默认值填写。

用于场景:有些页面需要输入参数提交

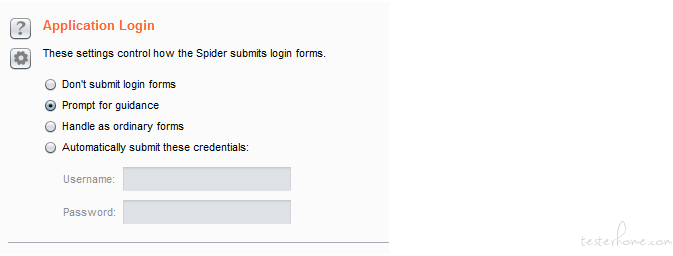

登录表单可以弹框设置,或者设置好登录用户名和密码(推荐)

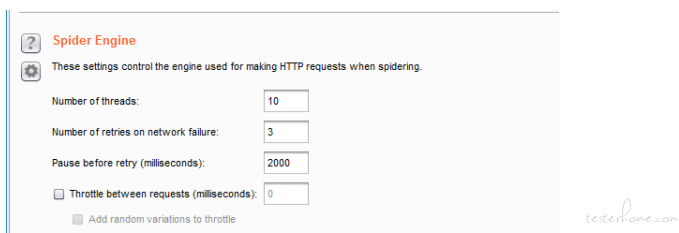

爬虫引擎,设置线程数,重试次数,重试间隔

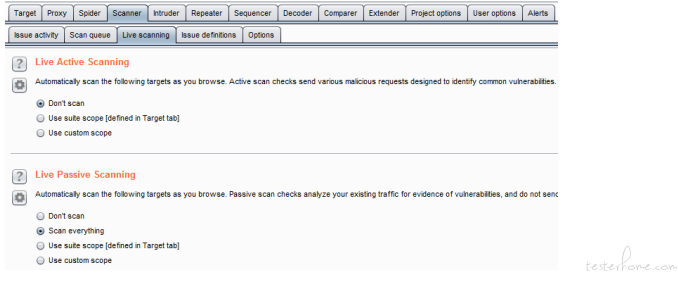

默认被动扫描,因为主动扫描时会主动发送大量探测请求,会对目标系统造成压力。而被动扫描,是基于原有网页数据进行探测,不再发送请求,压力较小,但被动请求精准度较低。

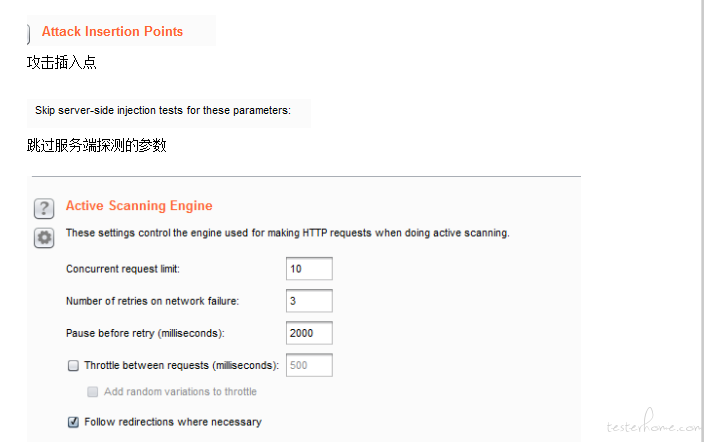

主动扫描引擎,扫描线程,重试次数,重试时间,设置时间间隔(必然防火墙和 ids 入侵检测),追踪重定向页面

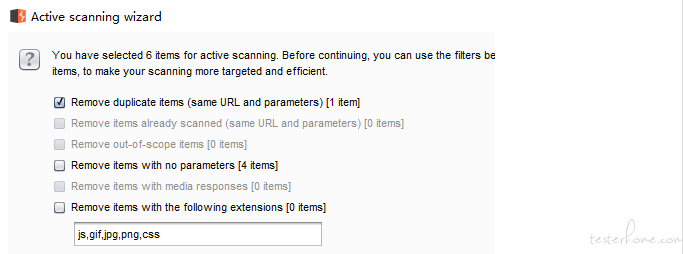

重复的项移除,一些静态资源不用扫描

高亮,设置高亮后,可以作用于报告的显示

设置等级:若默认的等级不合适,可以手动更改等级,比如有些漏洞属于误报的。