前言

对于想要在本地或自托管环境中运行 LLM 的用户而言,Ollama 提供了一个无需 GPU、在 CPU 环境也可高效完成推理的轻量化 “本地推理” 方案。而要让 Ollama 真正 “接地气”,往往需要与其他开源项目进行配合——例如将文档、数据源或应用前端与 Ollama 打通,这便衍生出许多解决方案。

Ollama 简介

在进入对比之前,先简单回顾一下 Ollama 的定位和特性:

本地推理:

- CPU 即可运行:适合 Mac 或 Linux 环境。

- 若无 GPU 的情况下,也能让开源模型(如 LLaMA、GPT-Neo、Mistral 等)跑起来。

轻量易用:

- 安装方式简洁,一键下载二进制文件或通过 Homebrew、pkg 安装。

- 只需一个命令行工具就能加载模型并进行对话、推理。

量化优化:

- 支持对常见大语言模型做 4-bit 或 8-bit 等量化,进一步降低资源占用。

发展活跃:

- 在 GitHub 上有不错的社区支持和更新节奏,适合初中级开发者快速上手。

安装 Ollama 客户端

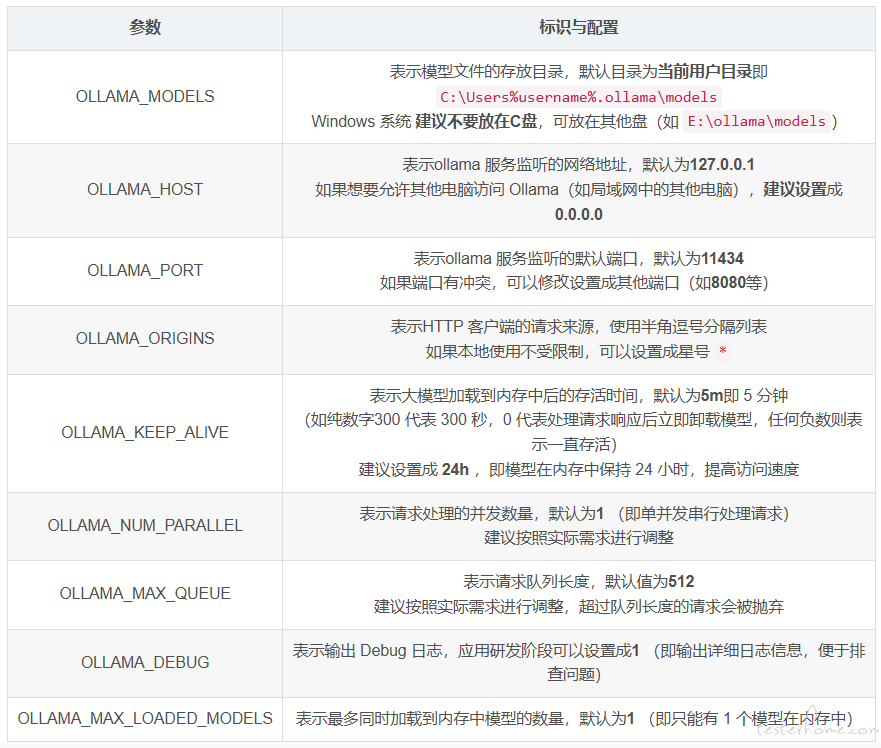

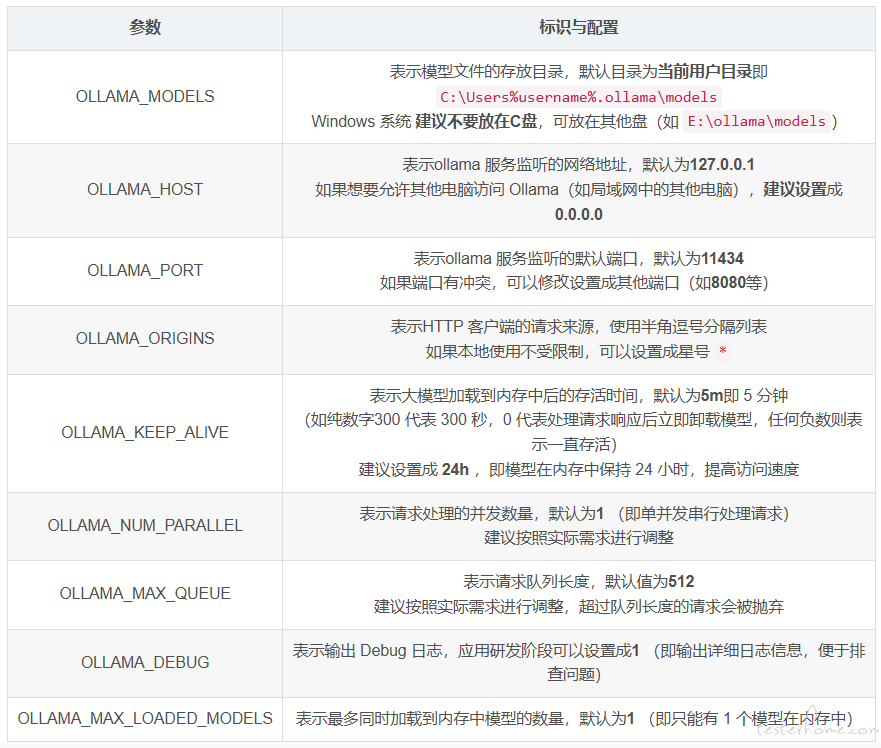

配置环境变量

Ollma可以像其他软件一样在电脑上完成一键安装,不同的是,建议按照实际需求配置下系统环境变量参数。

默认的模型保存路径在C盘,我们把路径更改到有更多可用空间的分区或目录,可以更好地管理存储空间。

- 添加 OLLAMA_MODELS 环境变量改变模型存储的位置。例如 E:\ollama\models

- 设置完成后重启 ollama 或 PowerShell,即可完成更改。

用 Ollama 下载模型

首先我们需要安装 Ollama(https://ollama.com/),它可以在本地运行和管理大模型。

直接下载速度太慢,使用加速,GitHub Proxy 代理加速(https://ghfast.top/)【实测速度超快】:

https://mirror.ghproxy.com/https://github.com/ollama/ollama/releases/download/v0.5.7/OllamaSetup.exe

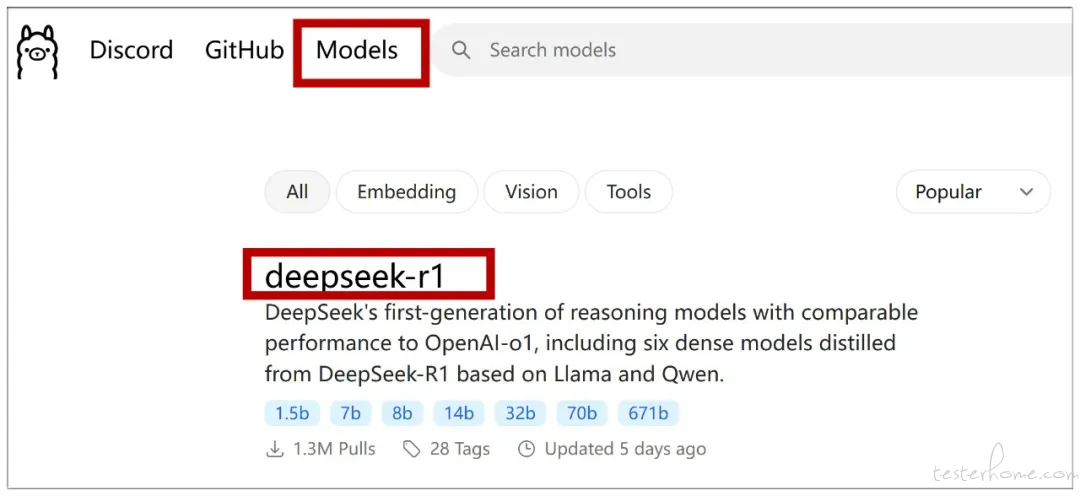

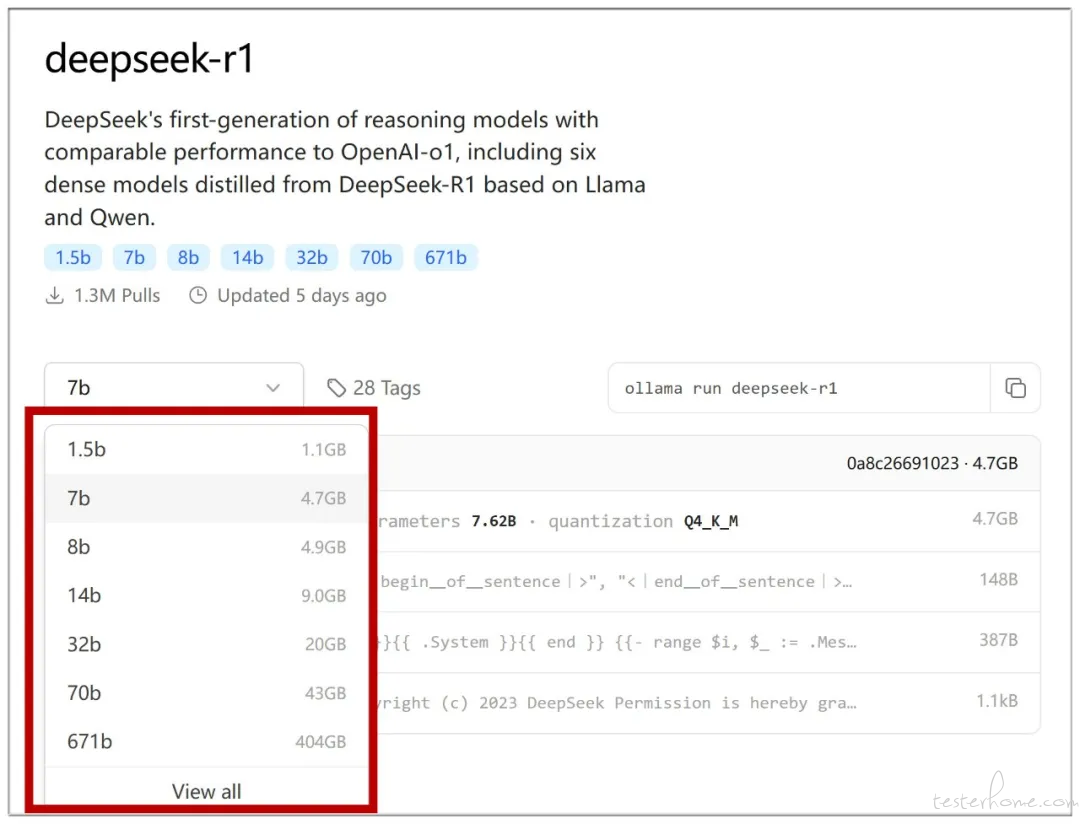

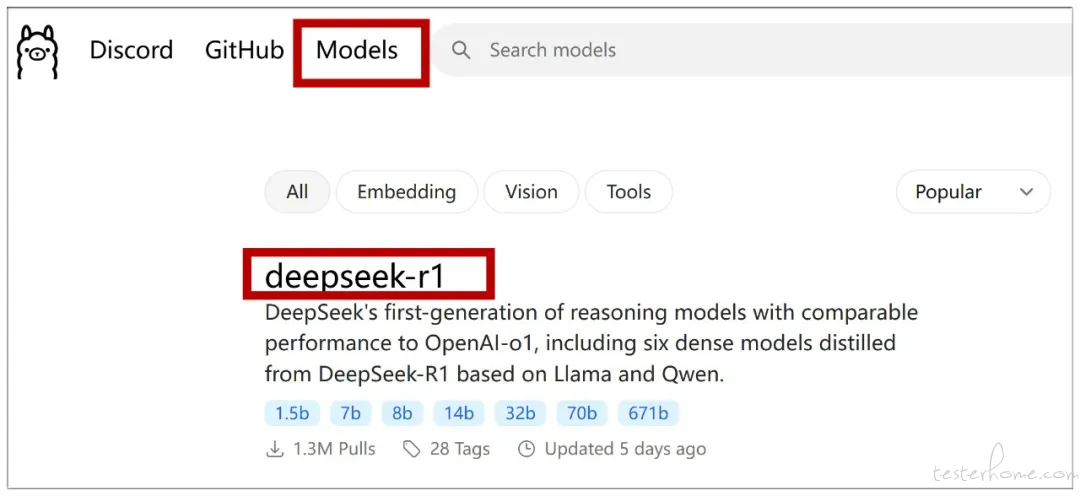

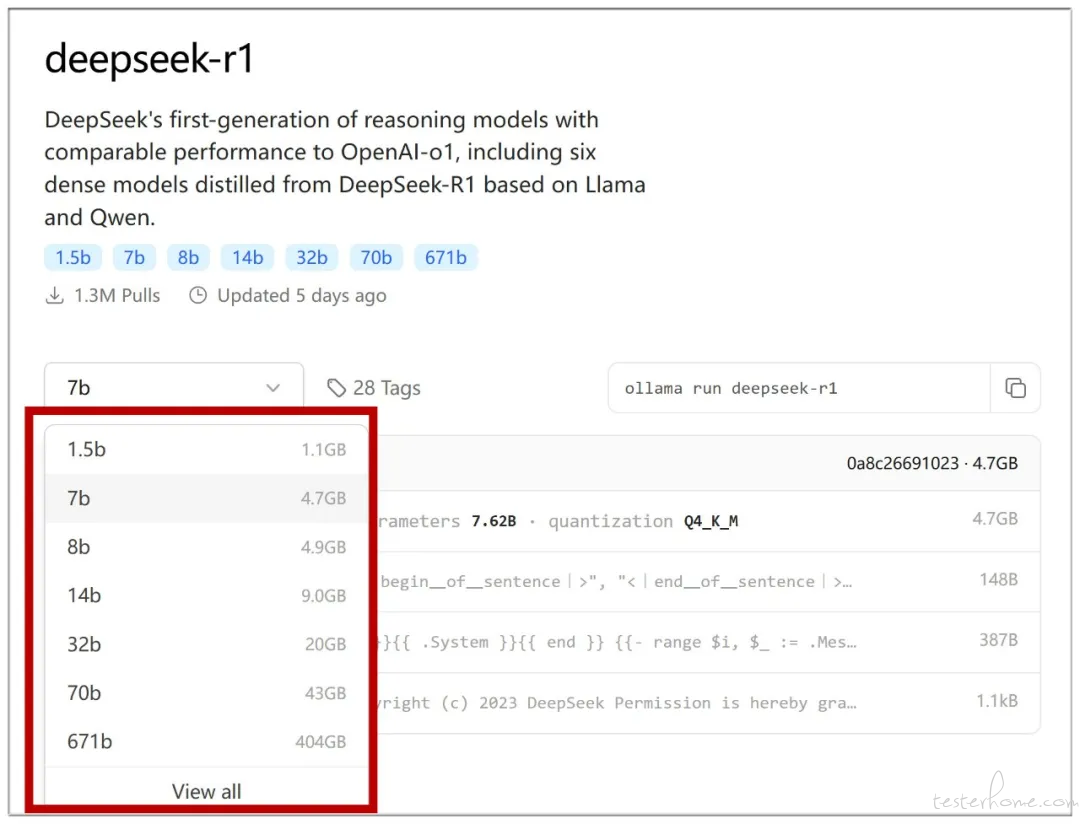

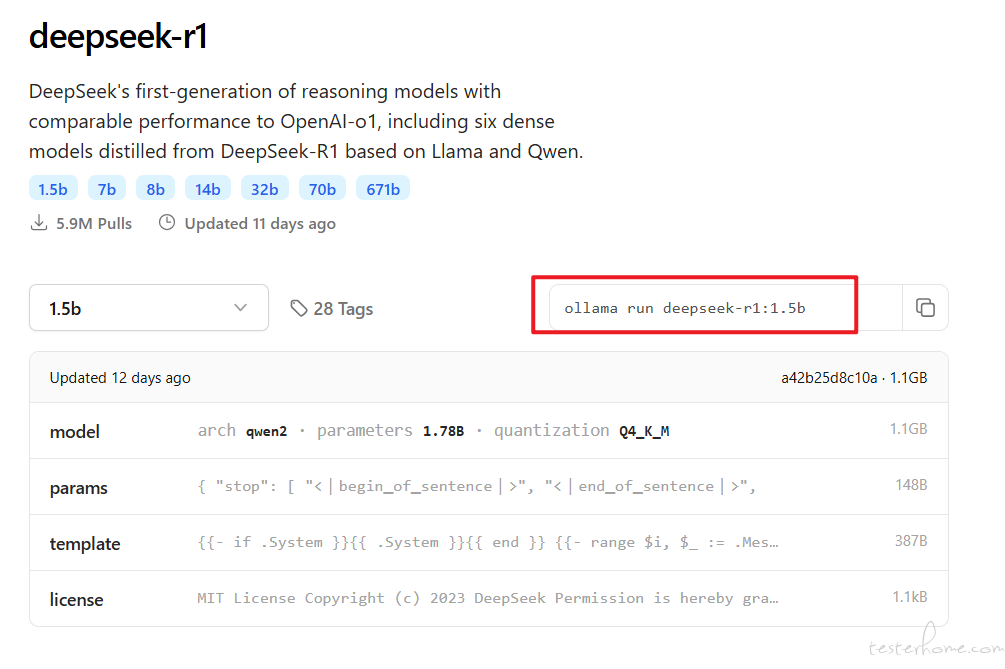

接下来点击 Ollama 官网左上方的 “Models” 按钮,会列出支持的各种模型,目前最火的 DeepSeek-R1 排在显眼位置,点击进入主题页面:

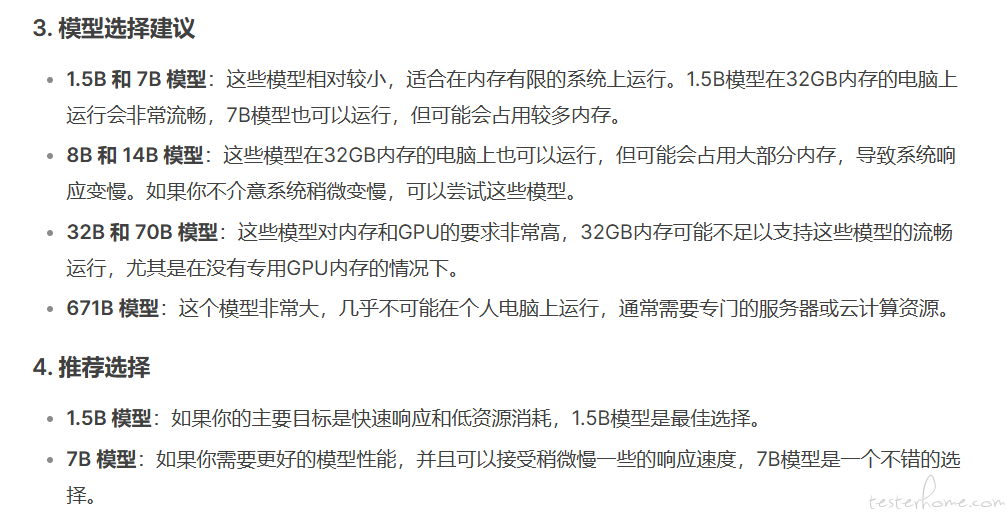

点击进去后,查看各个模型,不同模型执行的命令不同,最后部分看你选择的参数模型。

7b命令:ollama run deepseek-r1:7b

1.5b命令:ollama run deepseek-r1:1.5b

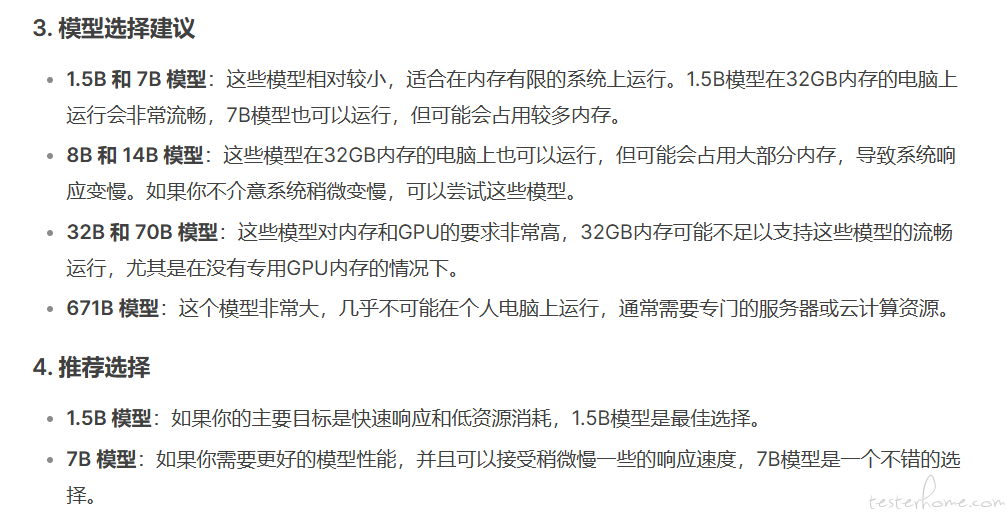

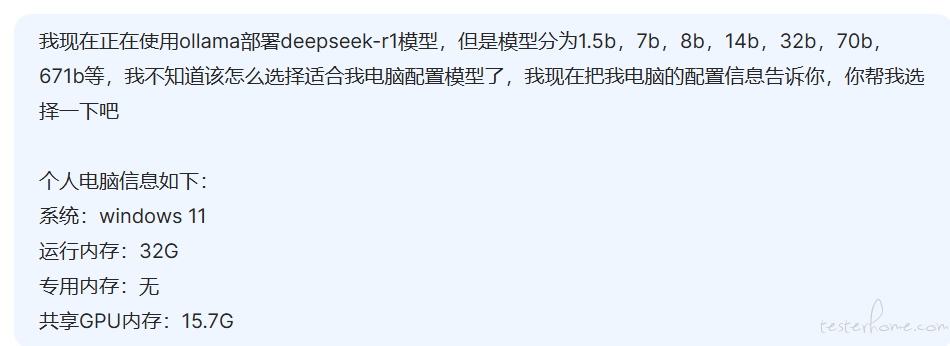

DeepSeek R1 提供多个版本,参数量越大,模型通常越强大,但也需要更多的计算资源,比如 1.5B 代表有 15 亿个参数。

具体选择哪一个看你硬件设备了。

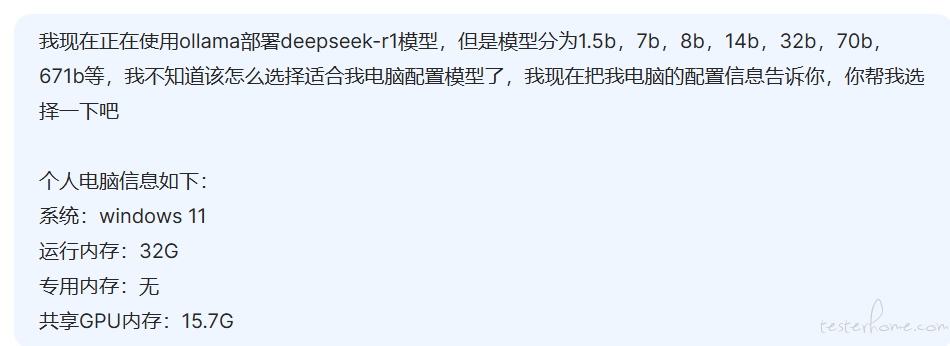

将本机的电脑配置发给 deepseek,看看它的推荐是哪个模型

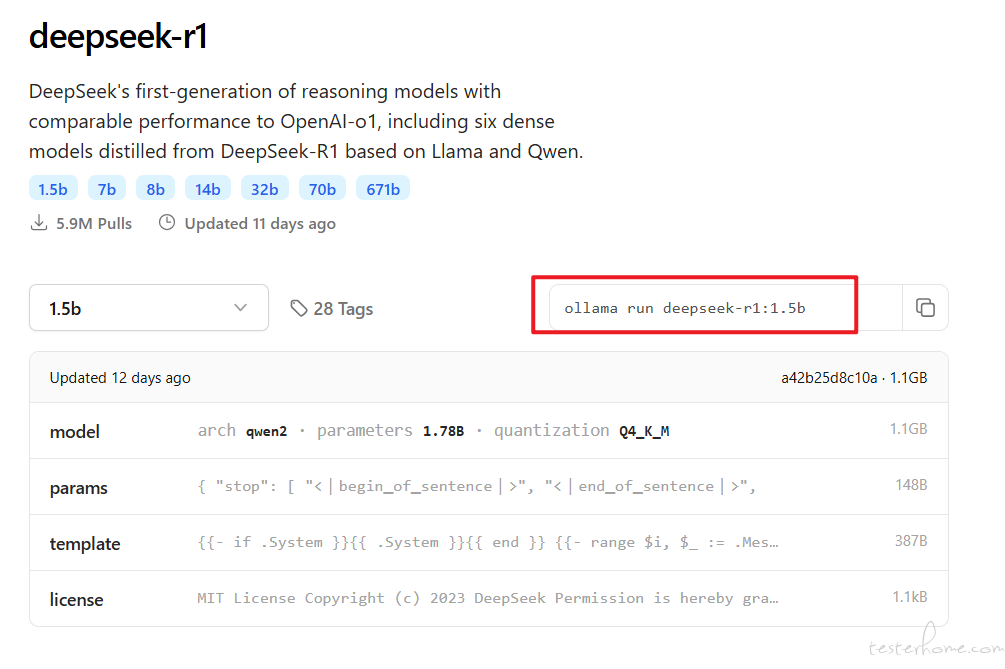

选择好模型之后,点击右侧这个按钮,复制指令,这里是:ollama run deepseek-r1:1.5b

在 Windows 搜索栏输入 “cmd” 回车,唤出命令行窗口:

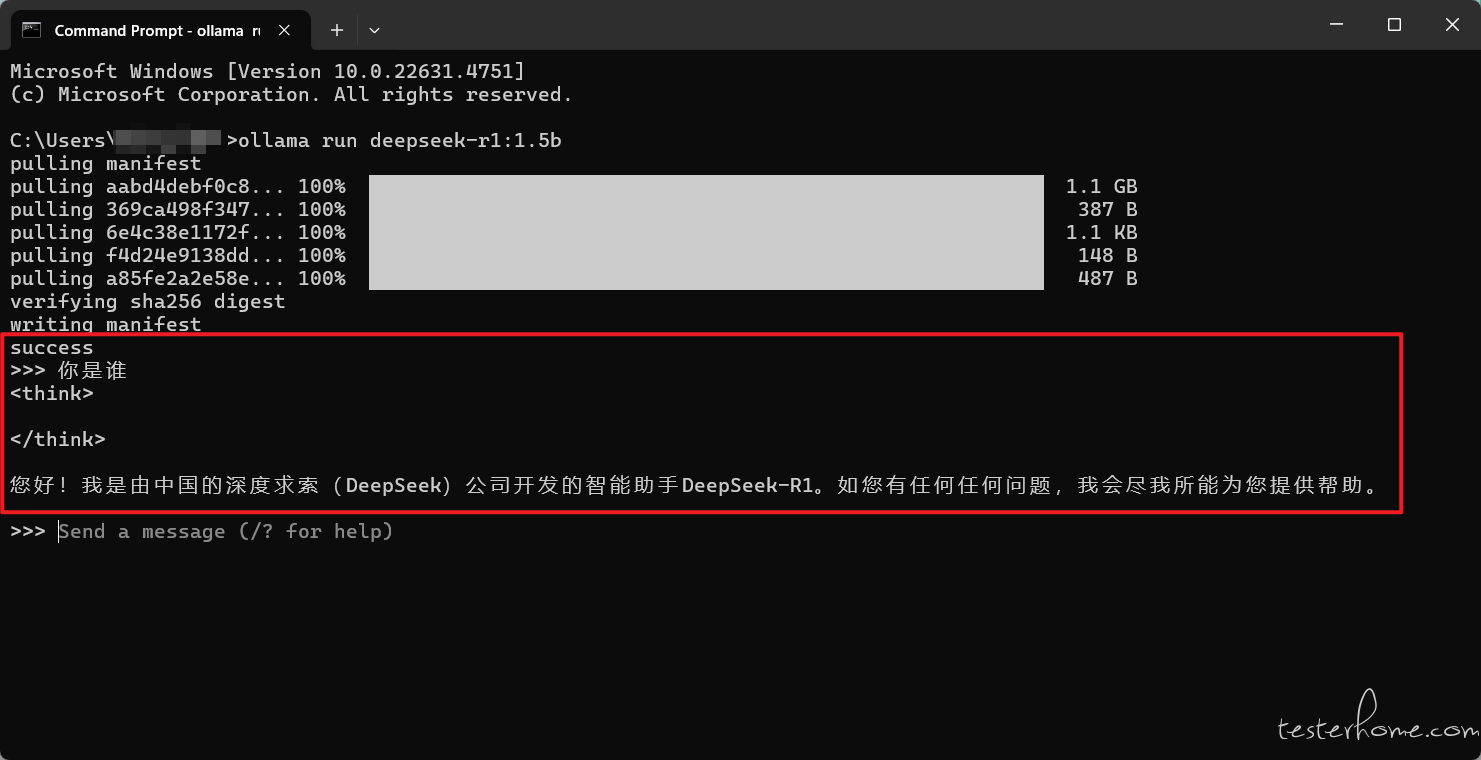

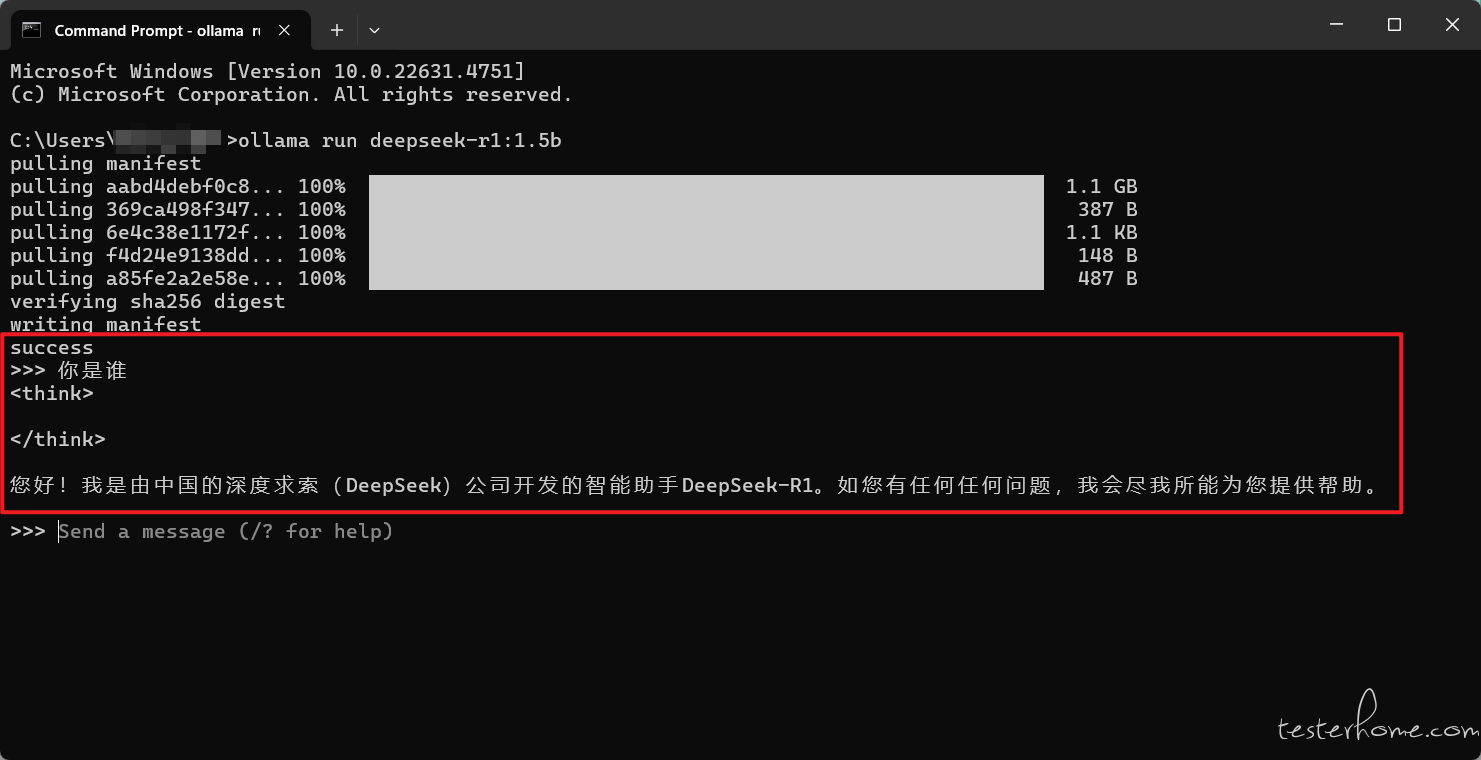

黏贴运行刚才复制的命令,开始下载,1.5b 模型容量大约 1.1GB,请保持网络畅通:

当界面出现 success 显示安装成功。输入 “你是谁”,看到 deepseek 的回答。

AnythingLLM、Dify、Open-WebUI 简介

AnythingLLM

- 定位:将本地文档或数据源整合进一个可检索、可对话的知识库,让 AI 助手 “懂你” 的资料。

主要功能:

- 文档管理:将 PDF、Markdown、Word 等多格式文件索引进系统。

- 智能检索:可基于向量数据库搜索相关文档片段,并在聊天时自动引用。

- 界面 +API:既提供用户友好的前端管理界面,也能通过 API 与其他系统集成。

对接 Ollama 思路:

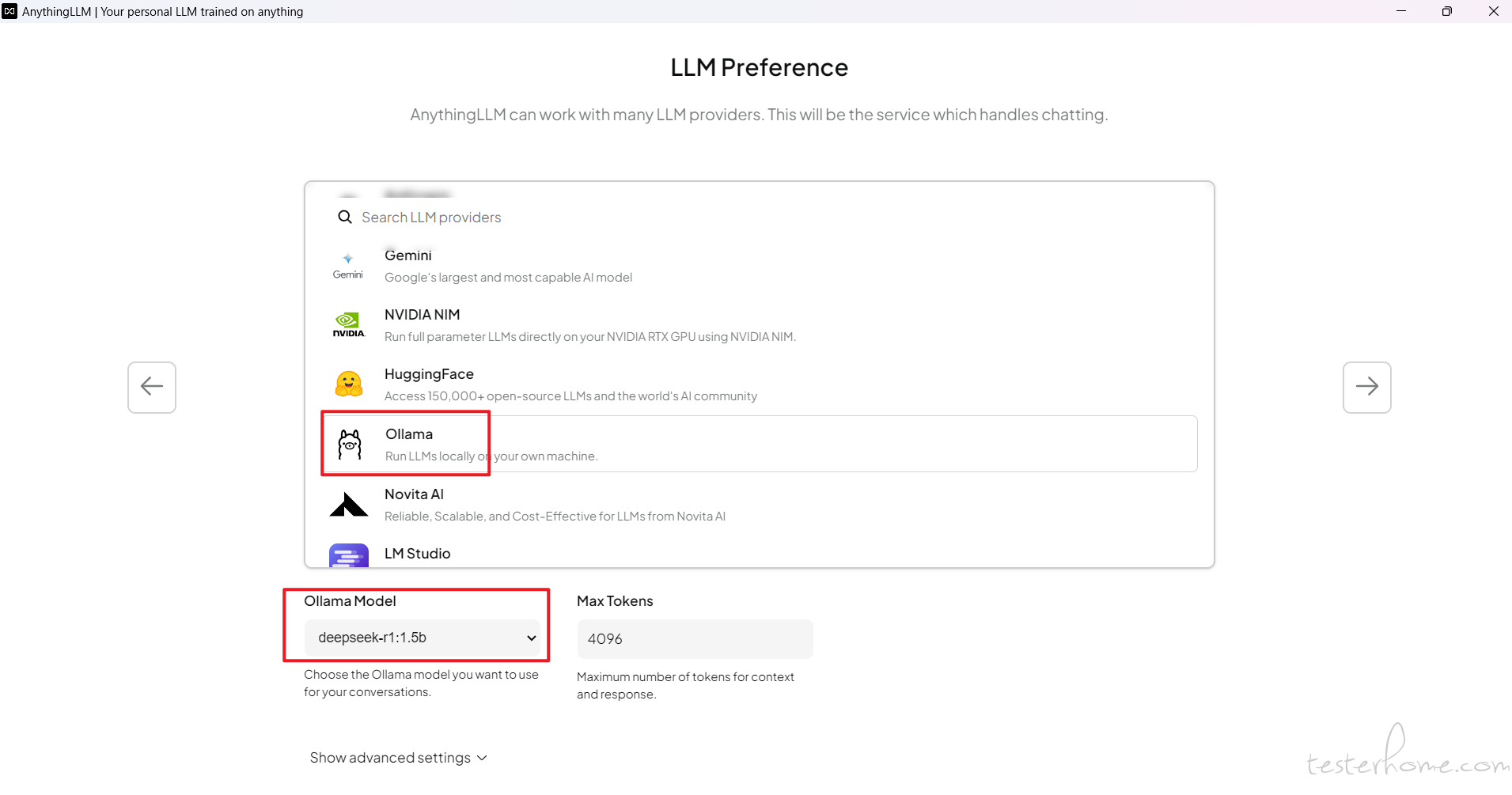

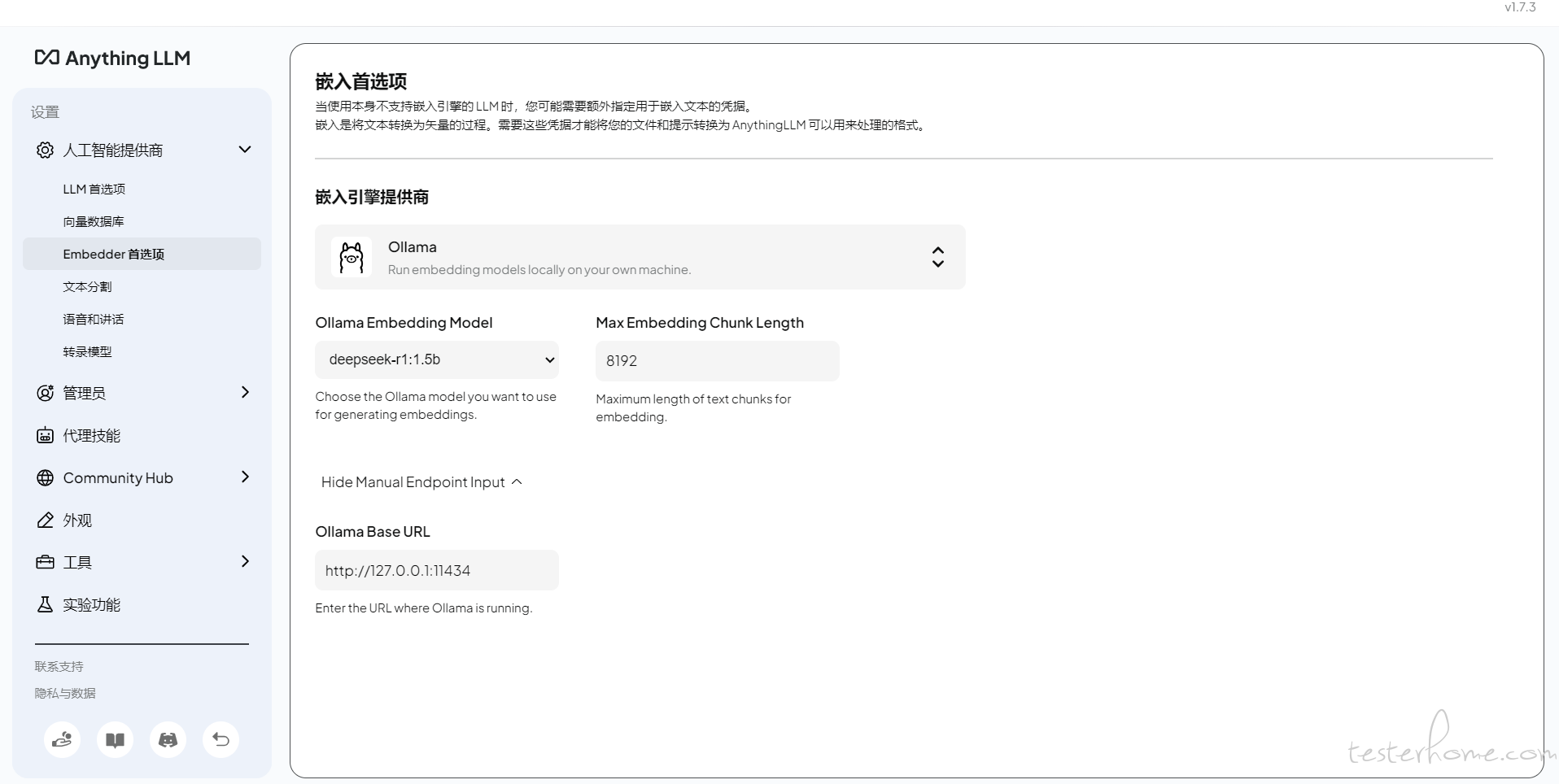

- 在配置文件或启动脚本中,将 “语言模型推理” 后端地址指定为 Ollama 的本地服务。

- 当用户发起提问时,AnythingLLM 会先做知识检索,再将检索到的上下文发送给 Ollama 做语言生成。

适用场景:

- 企业内部文档问答、个人知识管理、高度依赖文本内容的问答场景。

Dify

- 定位:多功能的 AI 应用构建平台,支持多种大语言模型,方便开发者快速搭建 ChatGPT-like 服务或插件化应用。

主要功能:

- 对话管理:可自定义对话流或应用场景,为不同场景配置不同模型或工作流。

- 插件扩展:支持将其他第三方服务或插件加入对话流程中,提高可用性。

- 多模型兼容:除 Ollama 外,也兼容 OpenAI API、ChatGLM 等其他模型。

对接 Ollama 思路:

- 在 “模型管理” 或 “模型配置” 界面/文件中,添加对 Ollama 的引用,可能需要指定本地运行地址 (如 localhost:port)。

- 使用 Dify 的对话页面或 API 时,后台调用 Ollama 进行推理,再将结果返回前端。

适用场景:

- 多模型切换、多功能插件集成;需要可视化对话配置或工作流管理的团队与开发者。

Open-WebUI

- 定位:社区驱动的网页版用户界面,针对多种本地模型提供可视化使用入口,类似一个 “本地 ChatGPT 面板”。

主要功能:

- 浏览器聊天界面:在局域网或本机通过网页即可与模型交互。

- 支持多后端:LLaMA、GPT-NeoX 等,以及 CPU/GPU 等不同推理环境。

- 插件/扩展机制:在社区里可找到各式各样的扩展功能(如多语言 UI、模型切换、对话模板等)。

对接 Ollama 思路:

- 通常可在 Open-WebUI 的后台配置或启动脚本中,指定 Ollama 作为推理后端;

- 或使用适配 Ollama 协议的插件,让 Open-WebUI 调用 Ollama 进行对话。

适用场景:

- 需要 “纯聊天 + 模型管理” 界面的普通用户或开发者;想要单纯体验各种本地模型的人群。

接入 Ollama 的异同

在了解了三款工具的基本定位后,再来看看它们在接入 Ollama 时,有哪些不同之处,以及各自的优势与局限性。

从上表不难看出:

-

AnythingLLM: 更专注于文档知识库与问答场景,自带向量检索管理,可 “多文档整合”,接入 Ollama 后实现本地化问答。

-

Dify: 适合对话流管理、插件化扩展、团队协同等复杂需求。只要能在其后台正确配置 Ollama 地址,即可灵活调用。

-

Open-WebUI: 走纯粹聊天界面路线,你可以把它当做一个能 “轻松切换模型、马上对话” 的 Web 面板,如果只是想单纯体验 Ollama 的生成效果,Open-WebUI 也许是最方便的。

选择 Anything LLM

- AnythingLLM 是由 Mintplex Labs Inc.开发的一个全栈应用程序,是一款高效、可定制、开源的企业级文档聊天机器人解决方案。它能够将任何文档、资源或内容片段转化为大语言模型在聊天中可以利用的相关上下文。

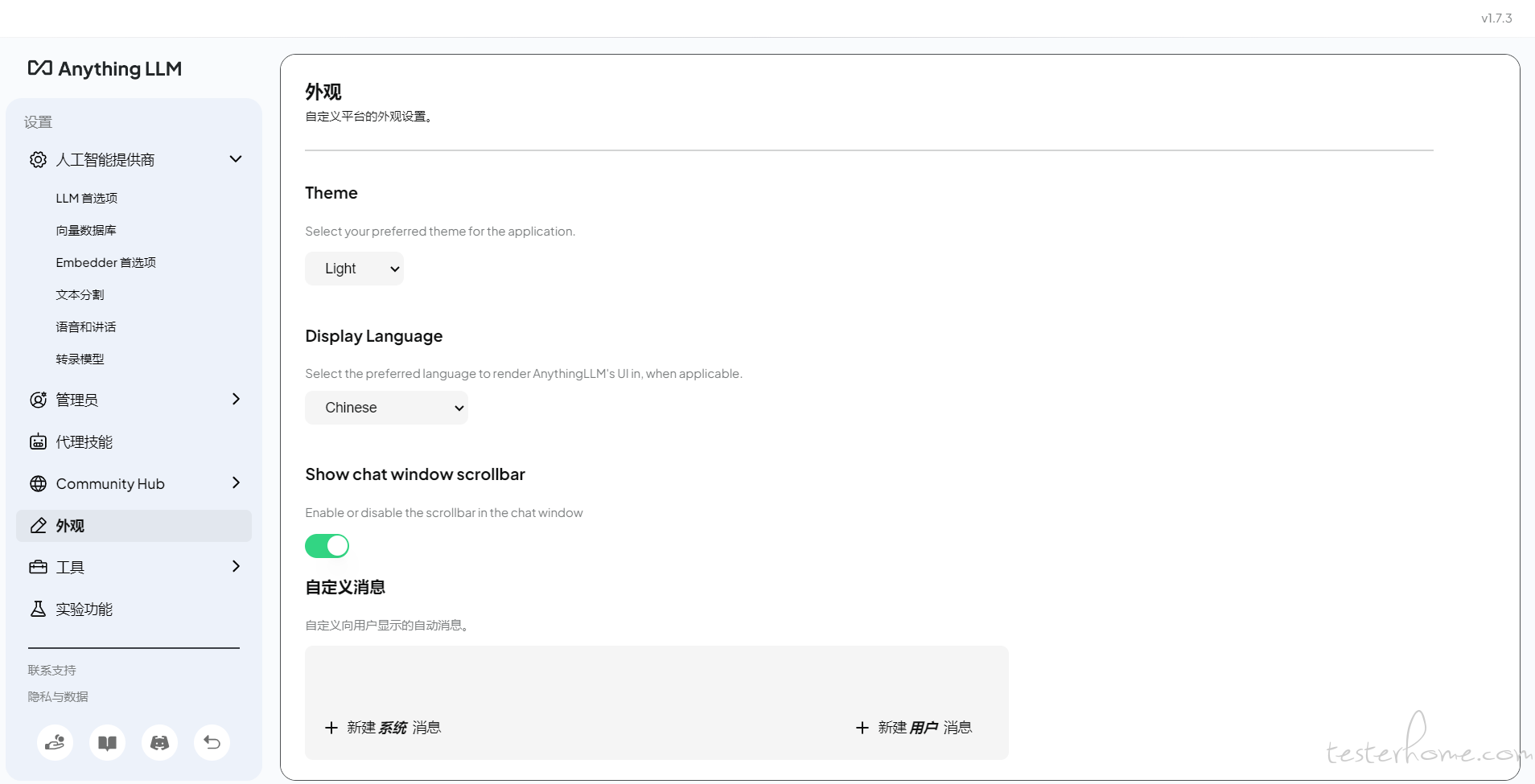

- AnythingLLM 支持几乎所有的主流大模型和多种文档类型,可定制化,而且安装和设置简单。目前适用于 MacOS、Linux 和 Windows 操作系统,也可以使用 Docker 安装。官方已经做好了各个版本的应用,直接下载对应版本,像正常软件一样安装启动即可。

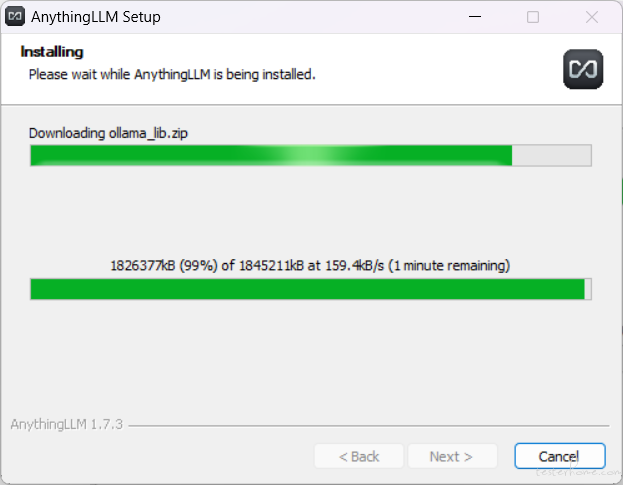

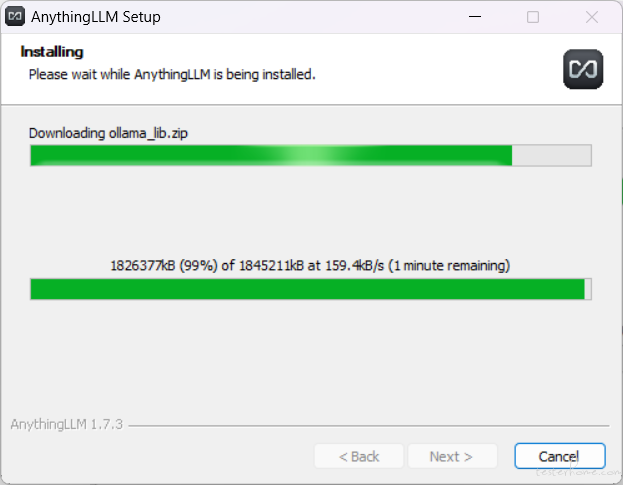

安装 Anything LLM

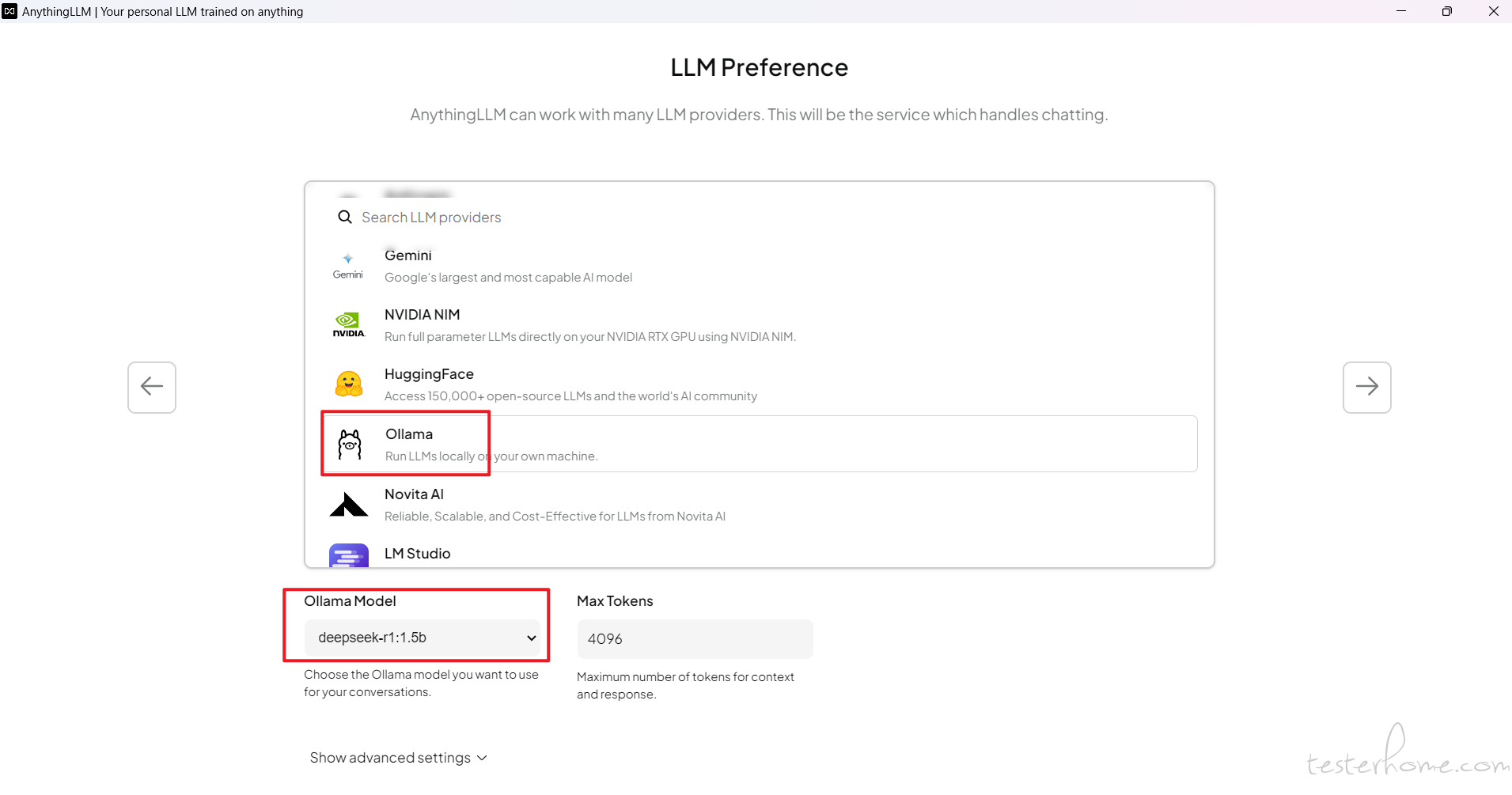

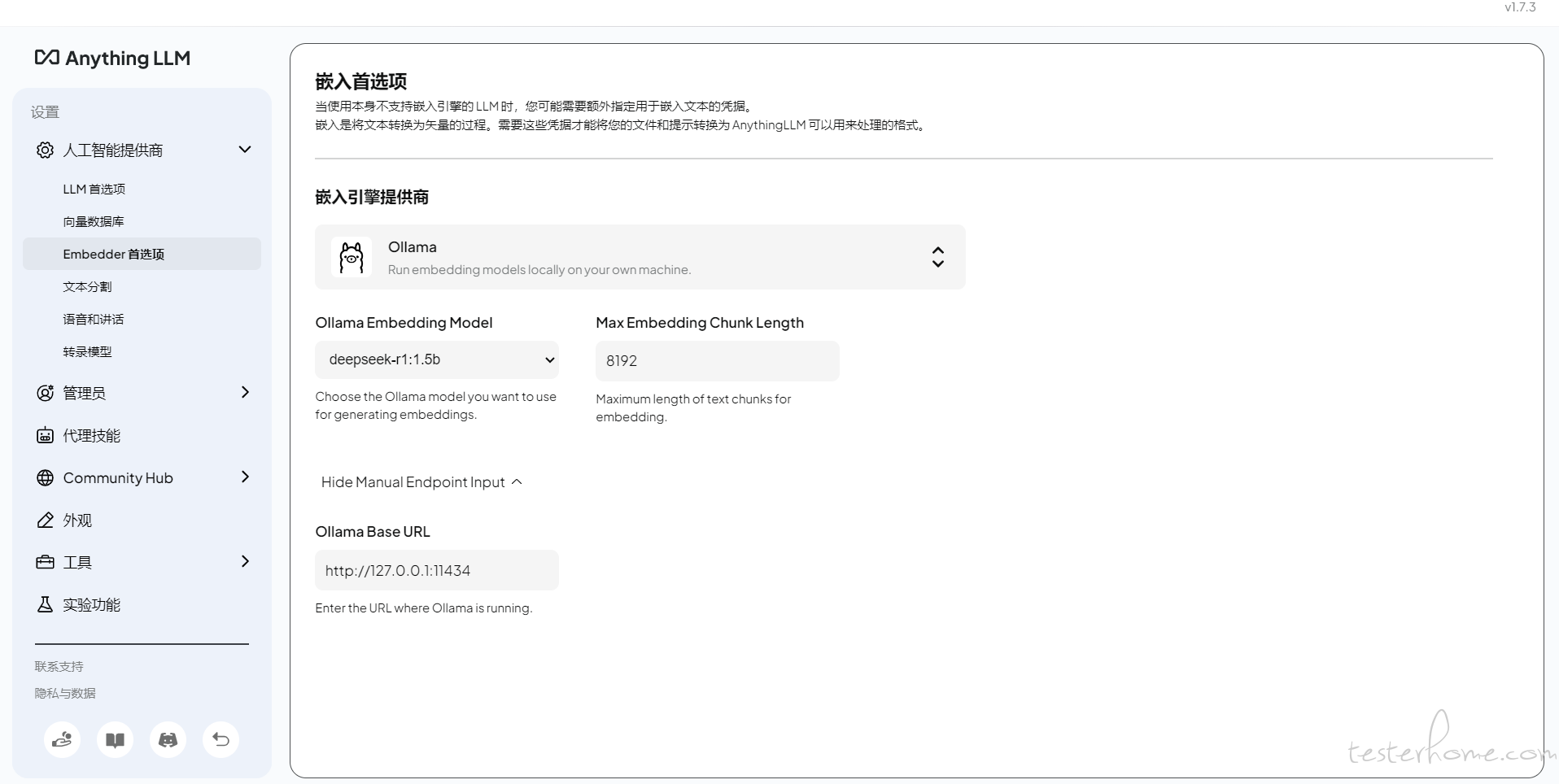

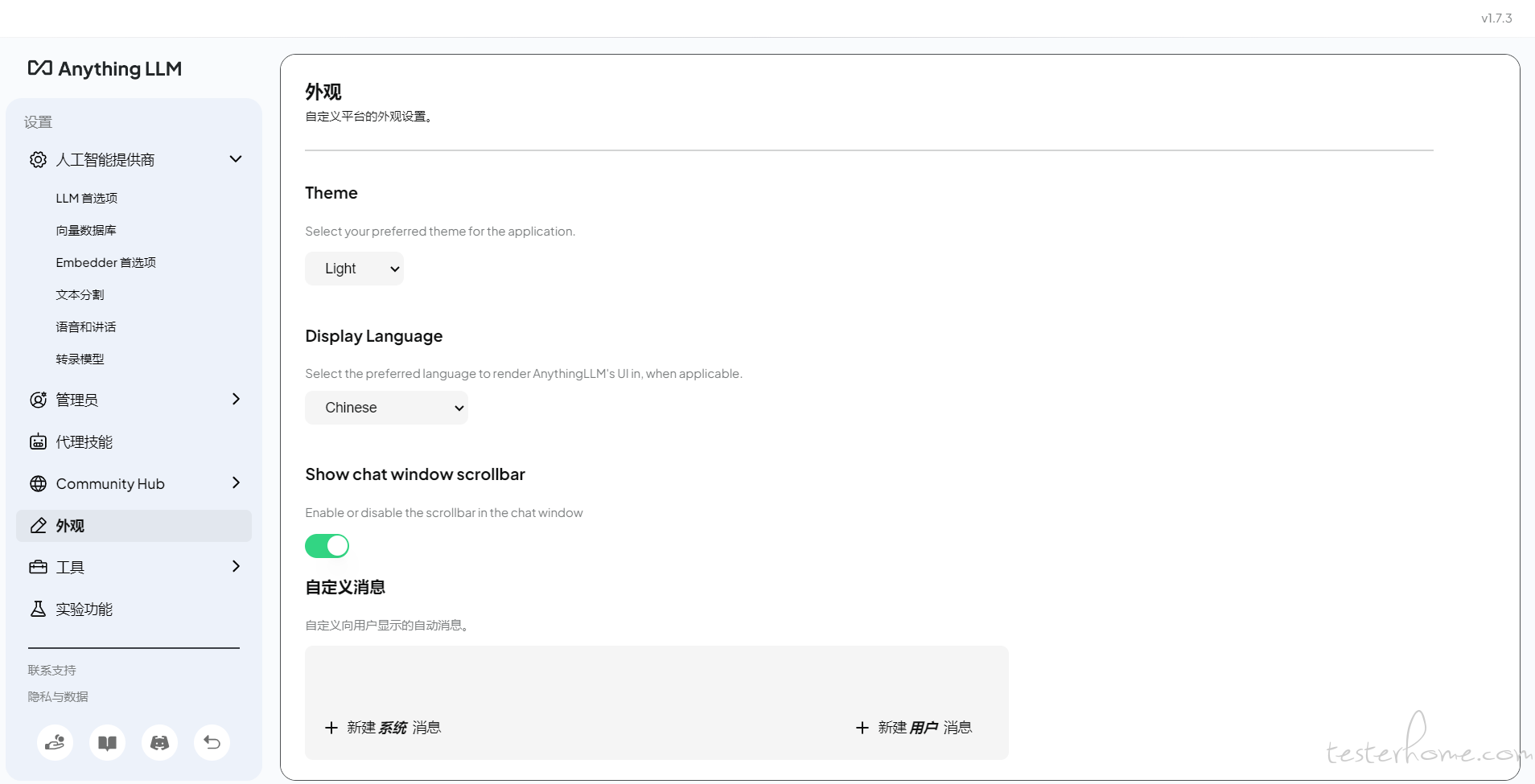

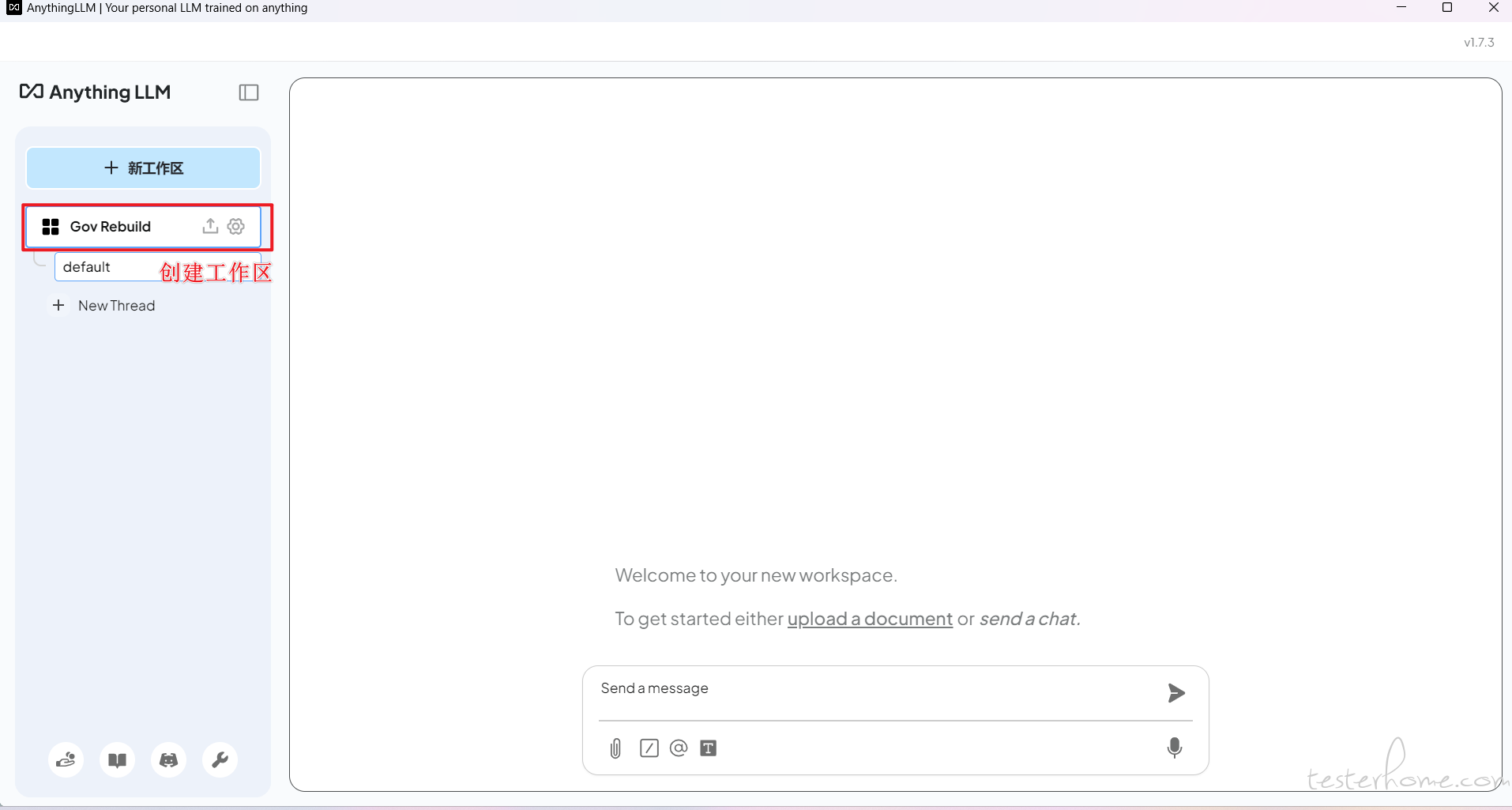

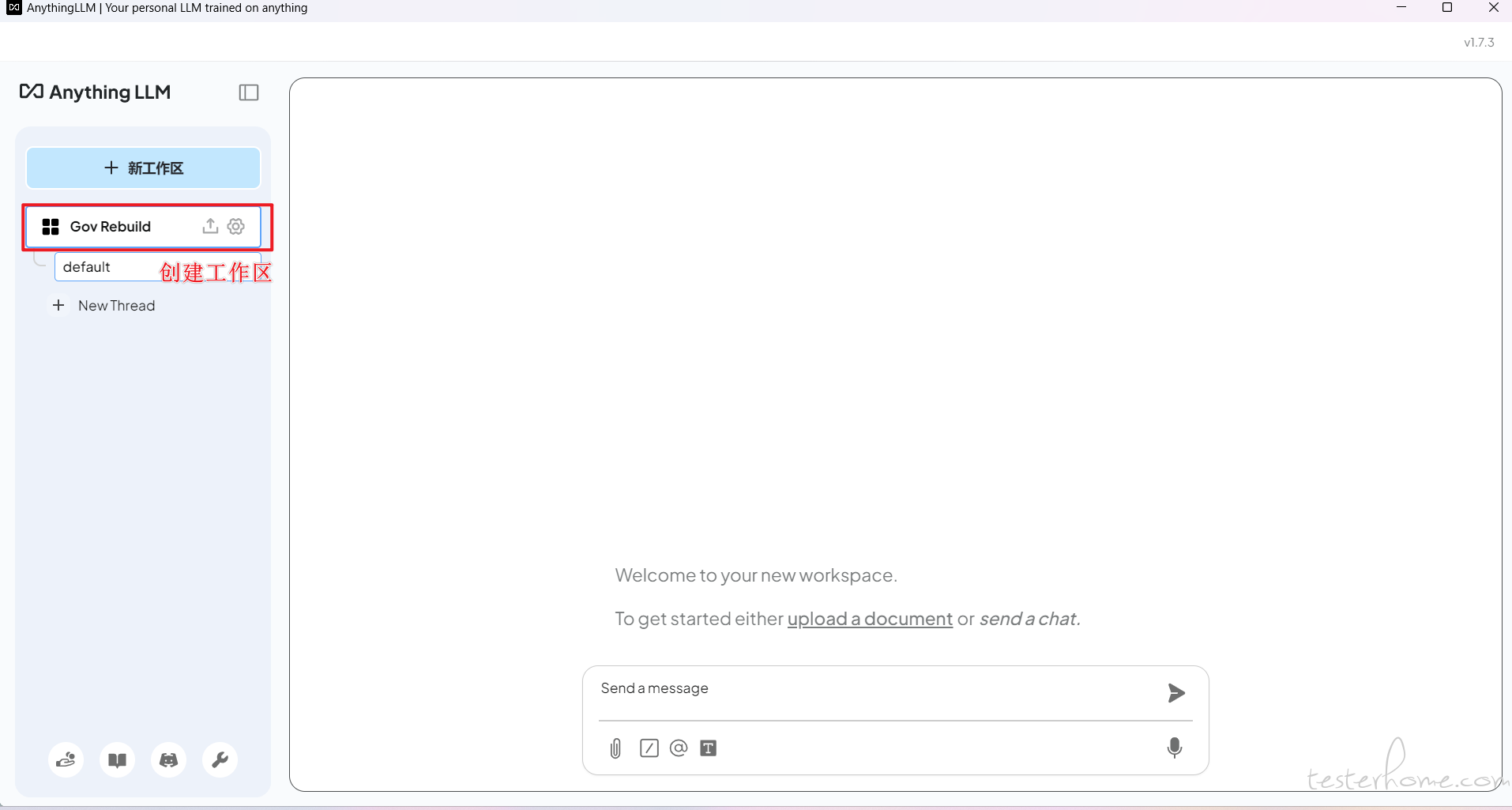

AnythingLLM 配置

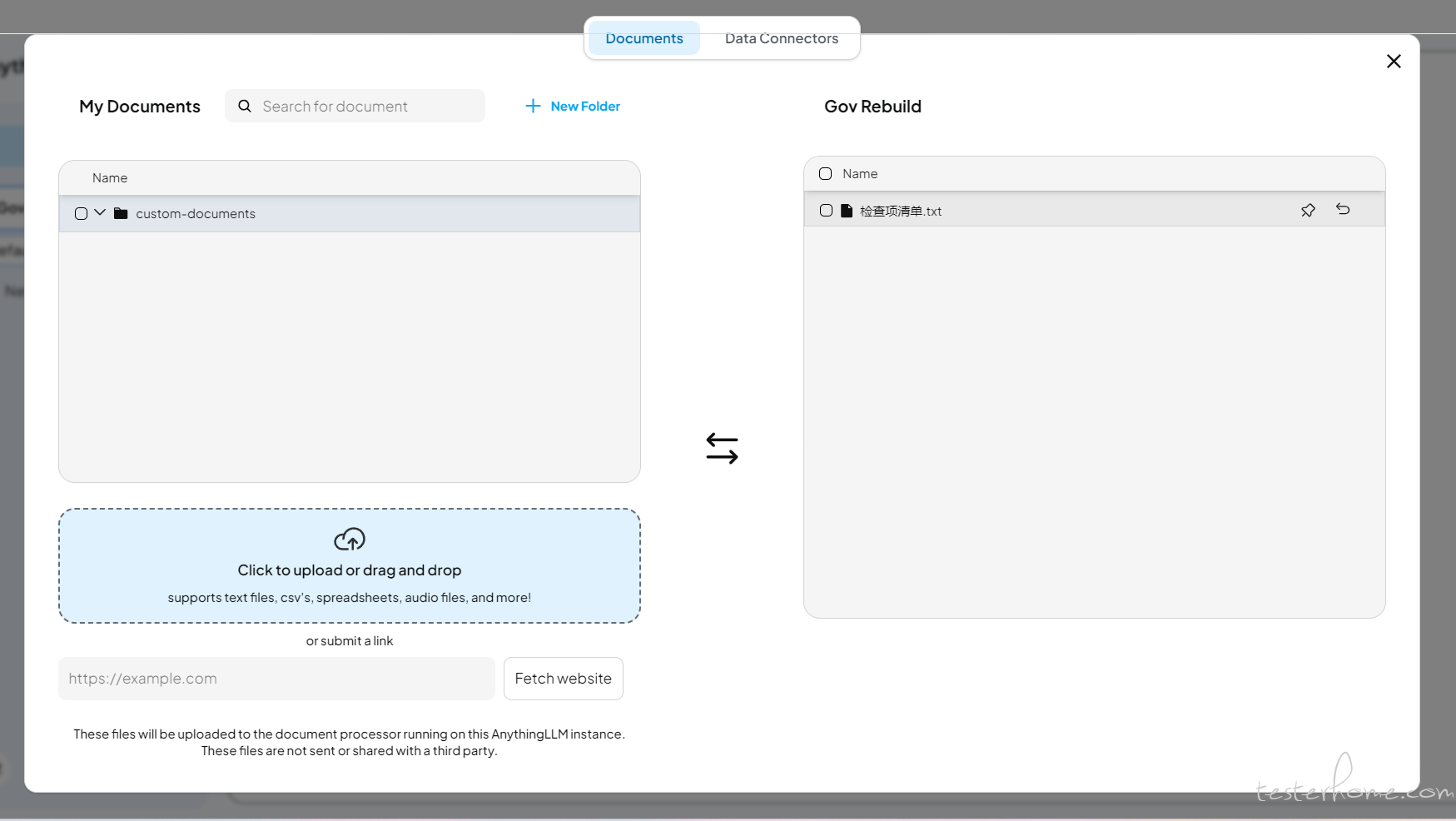

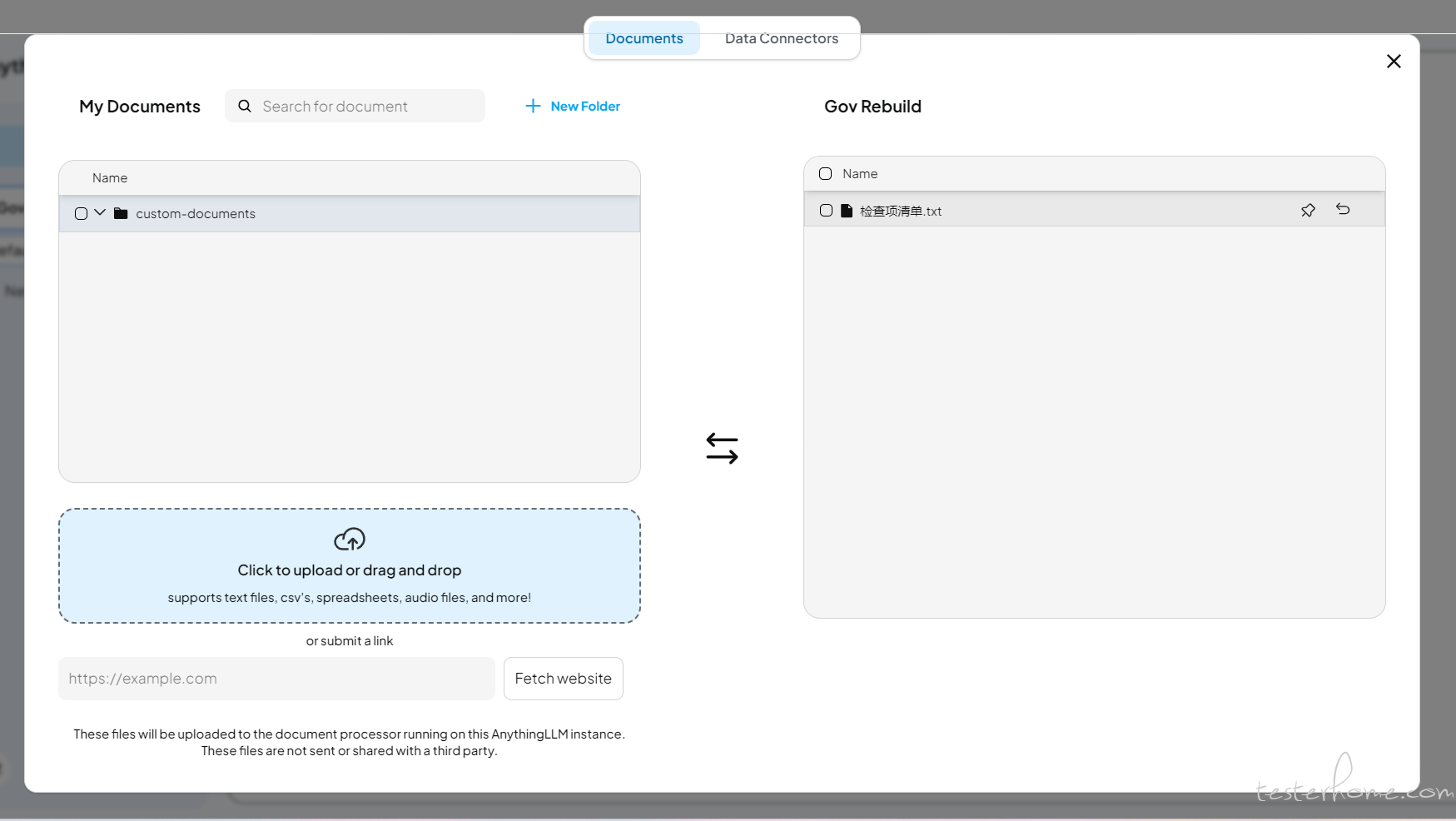

上传文件

点击按钮开始添加文档,并将文档 Move to Workspace,然后点击 Save and Embed,出现 Workspace updated successfully 就表示配置已经完成。

验证效果

参考资料

https://mp.weixin.qq.com/s/9CqtqRZba3M4R74RkDJwCA

https://mp.weixin.qq.com/s/JUe73lGnnXv-13B8oME_Rg

https://blog.csdn.net/weixin_40280870/article/details/145275600

https://blog.csdn.net/yunfanleo/article/details/144332548

https://mp.weixin.qq.com/s/NuoeidtJKMx6rm0mwKz54w

https://ghproxy.link/

↙↙↙阅读原文可查看相关链接,并与作者交流